【初心者向け】データ分析をこれから身につけたい人へ、どのツールから学べばいいのか

"これから業務でデータ分析ができるようになりたいのですがおすすめのツールなどありますか?"

最近、社内向けにデータ活用の勉強会を開いている中でよくこの質問をいただきます。

結論から告げると、

・今の環境で使えるツールから学び出すのがオススメ

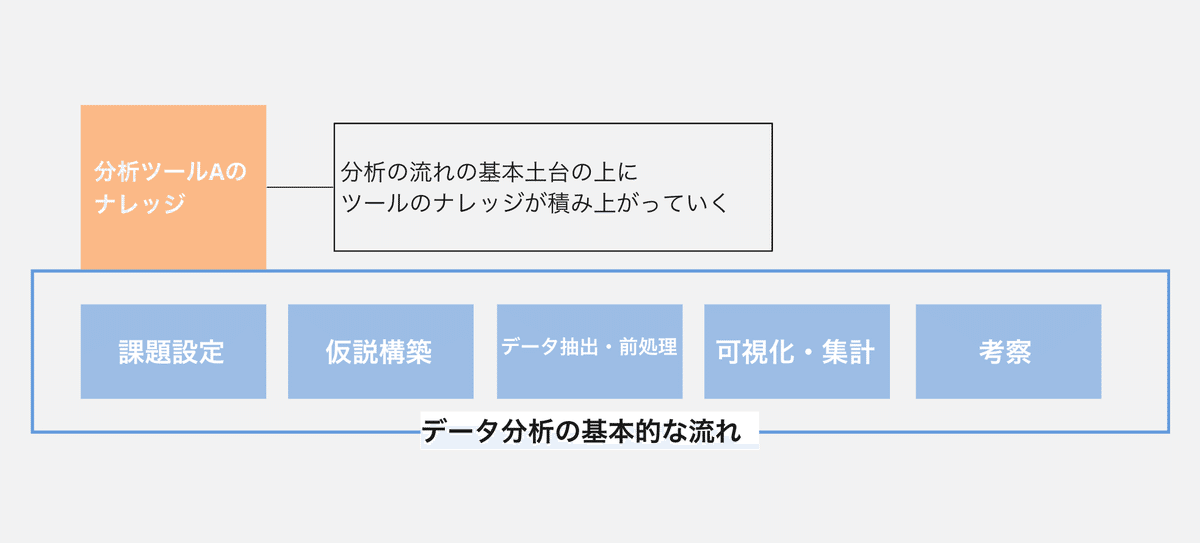

・まずは課題設定〜分析・考察の基本的なデータ分析の流れを1つのツールでマスターしよう

ということを話すのですが、振り返ってみれば自分も初めの頃はいろんなデータ分析用のツールがある中で同じ疑問を持ったことがありました。

同じような疑問を抱く方も多いのではないかと思い、以下の内容で記事をまとめてみようと思います。

・どんな種類のデータ分析ツールがあるのか

・目的や環境によって使えるツールは変わるが、分析の型は変わらない

また、筆者はビジネス寄りのデータアナリストとして5年くらい活動しているので開発者やデータサイエンティスト向けというよりはアドホックな分析をされる方向けに書いています。

加えて、詳細な個別製品紹介はしません(キリがなくなるので)。

個人的な主観が混ざったり、視点が足りない部分もあるかと思いますがご愛嬌ください><

ターゲット

・これからデータ分析を身につけたいがどんなツールから学べばいいのかの概要が知りたい方

・初心者向けのデータ分析教材のおすすめが知りたい方(個人的なものです)

この記事でわかること

・データ分析ツールの種類

・今の環境で使えるツールから学び出すのがオススメ

・まずは課題設定〜分析・考察の基本的なデータ分析の流れを1つのツールでマスターしよう

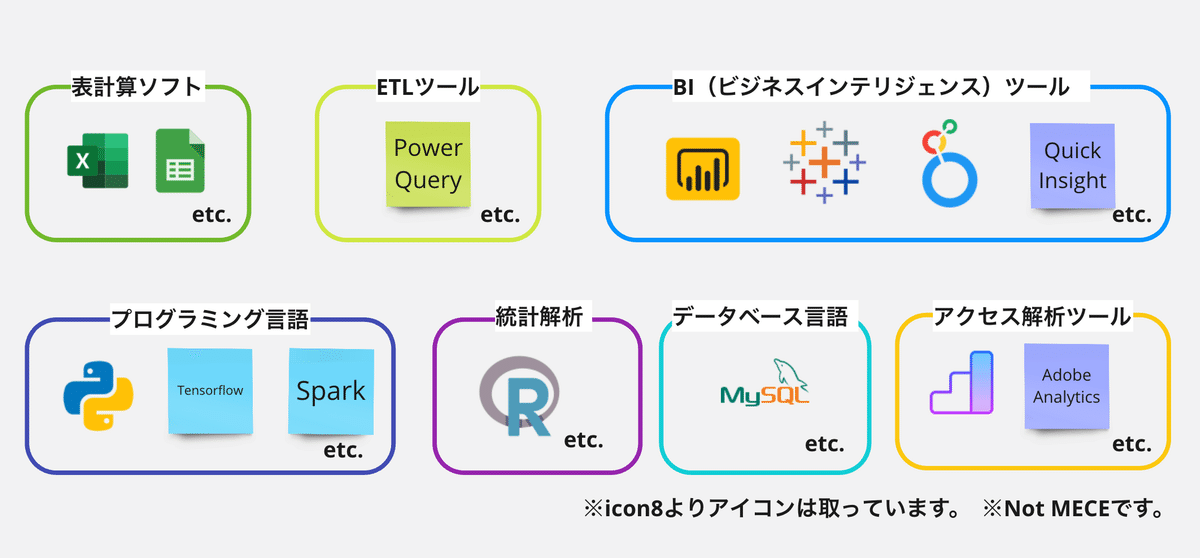

世の中に無数にあるデータ分析ツール

データ分析ツールと一括りにしても市場には多くのツールが存在します。

Excelのように広く普及しているものもあれば、

Pythonのようにプログラミングの習得が必要なもの、

Tableauなどのようにコードを書かずともアプリ内で色々と設定することでグラフを可視化できるものまでさまざまです。

とはいえここからの記事を書くために代表的な用語は紹介していけたらと思います。

表計算ソフト

まずはExcelなどでお馴染みの表計算ソフトです。

Excelはマイクロソフト社が提供していて広くビジネスで使われていますね。

関数を使って集計を行ったり、簡単なグラフ作成や統計解析もできる便利なアプリです。

ただ、大規模なデータを扱ったり、マクロを組みすぎたり、グラフを作りすぎるとだんだんと挙動がおかしくなるのがたまに罪な部分ではあります。

ローカル環境で扱えることもあり、手軽なデータ分析に適しています。

BI(ビジネスインテリジェンス)ツール

BI(ビジネスインテリジェンス)ツールはデータソースをもとにグラフや指標を可視化したり、幾つもの変数を掛け合わせることで単純な集計では見えづらい傾向を分析することができます。

具体的なイメージは以下のサイトも参照してみてください(Youtubeとかでもイメージ掴んでみるといいかもしれません)。

代表的な製品としてはマイクロソフト社のPowerBIやSalesforce社のTableau、GoogleのLooker、AWSのQuick Insightなどさまざまな企業からサービスが提供されています。

Excelよりも多いデータ量を扱っても壊れにくく、かつ複雑な可視化などで

深いインサイトを得れるためスポットでのデータ分析でも使う方は多いです。

またKPIなどの指標のモニタリングにおいてもダッシュボードを構築して使えるため、会社単位で導入してレポート作成を自動化する企業も増えてきました。

また、TabelauやPowerBIでは一部コミュニティ活動が盛んで、

イベントでユーザー同士がつながったり、ドキュメントやナレッジも多いのでわからないことがあっても調べやすいのがメリットですね

プログラミング言語・データベース言語

Pythonなどのプログラミング言語を使ってデータ分析をすることもできます。Python形式のファイルを作成して分析もできますし、

Jupyter NotebookやGoogle ColabのようなPythonなどのコードを書いて、手軽に計算処理するための分析アプリもあったりします。

扱えるようになるにはプログラミングの知識が必要だったりするため、

他のツールと比較すると学習ハードルは高いですが、使えるようになってくると、BIツールではまだやりづらいAIのモデルの活用や高度な統計解析、

また、システム開発で書いたコードをエンジニアに組み込んでもらうこともできます。

データベースに格納されているデータを参照したりしたい場合はSQLというデータベース言語があります。

こちらも使えるようになると会社でいちいちデータファイルの抽出を依頼せずとも自分でSQLを書いて抽出したり、データを加工したりすることができるようになります(とはいえ、会社での分析環境やルールは確認してくださいね)。

SQLの概要はこちらの記事も参照ください。

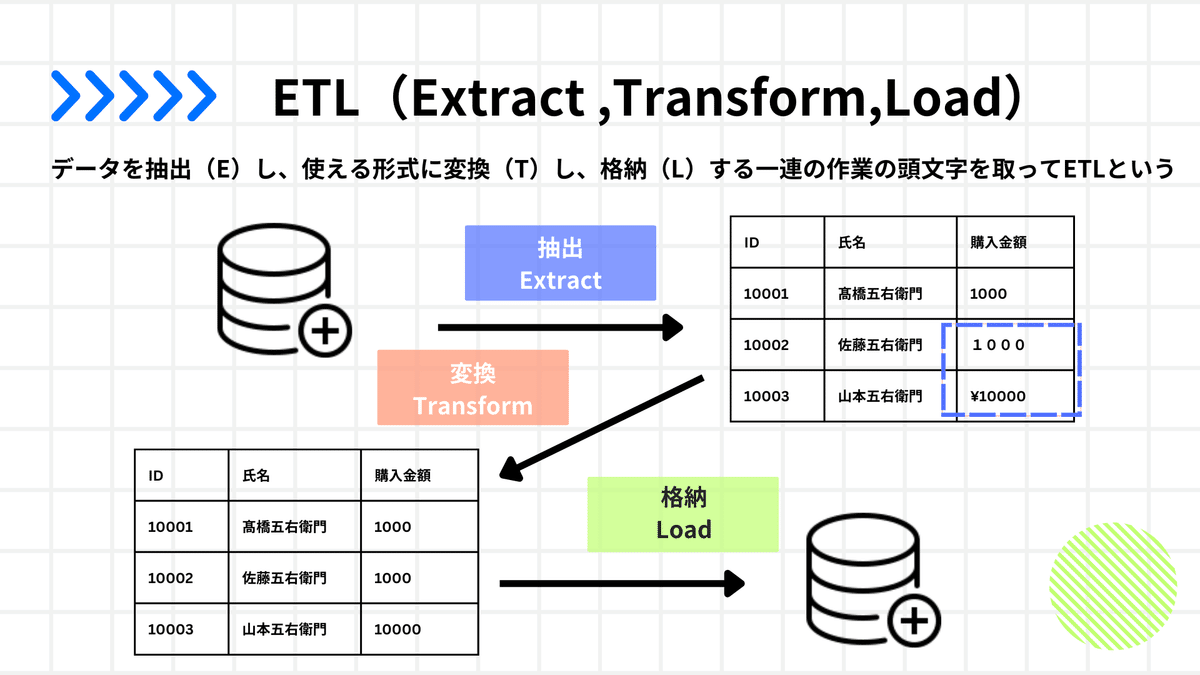

ETL(Extract ,Transform,Load)

データソースからデータを抽出(Extract)し、データを分析などに使える形に変換(Transform)し、格納(Load)する一連の操作を各英語の頭文字を取ってETLと呼んだりします。

マイクロソフトのExcelやPowerBIにはPowerQueryという機能がこれを担ってくれたり、TableauではTableau PrepなどのアプリでこのETLの処理を実施することができます。

サイトなどへのユーザーの流入量やページビュー数などを分析した場合には

アクセス解析ツールなどがあります。

Google AnalyticsやAdobe Analyticsなどが有名どころとしてあります。

サイトにタグを仕込めばログデータをわざわざ抽出せずともツール上で

グラフで可視化されているのが便利なところですね。

とはいえ、扱うにはWebサイトの知識などが必要だったりします。

これら以外にもVertexAIや統計解析に使うRなどさまざまなツールがあるのでご自身の興味に合わせて調べてみてください!

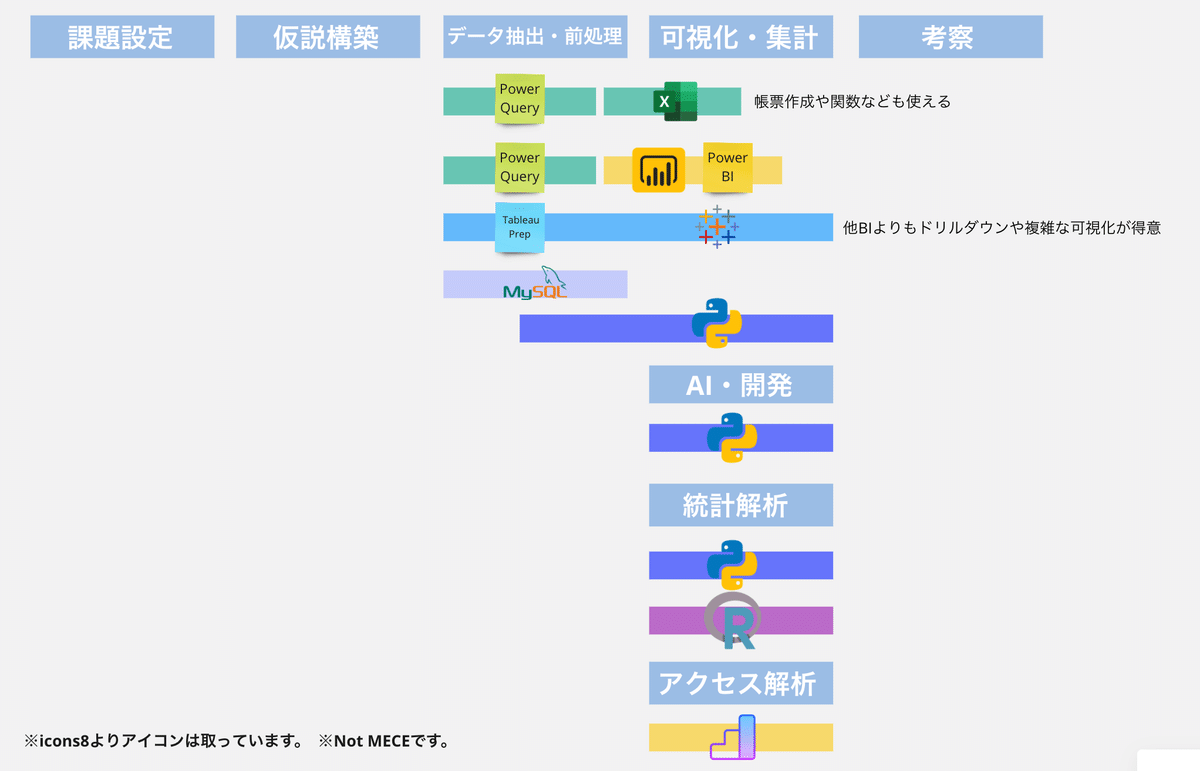

利用場面に合わせてマッピングしてみる

さて、さまざまなツールがあることを見てきましたが、

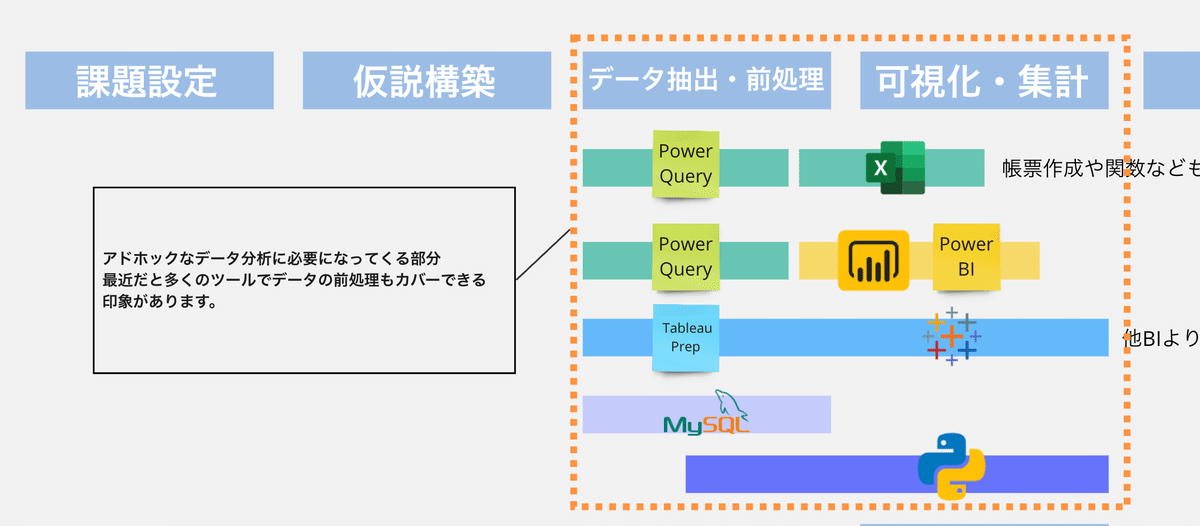

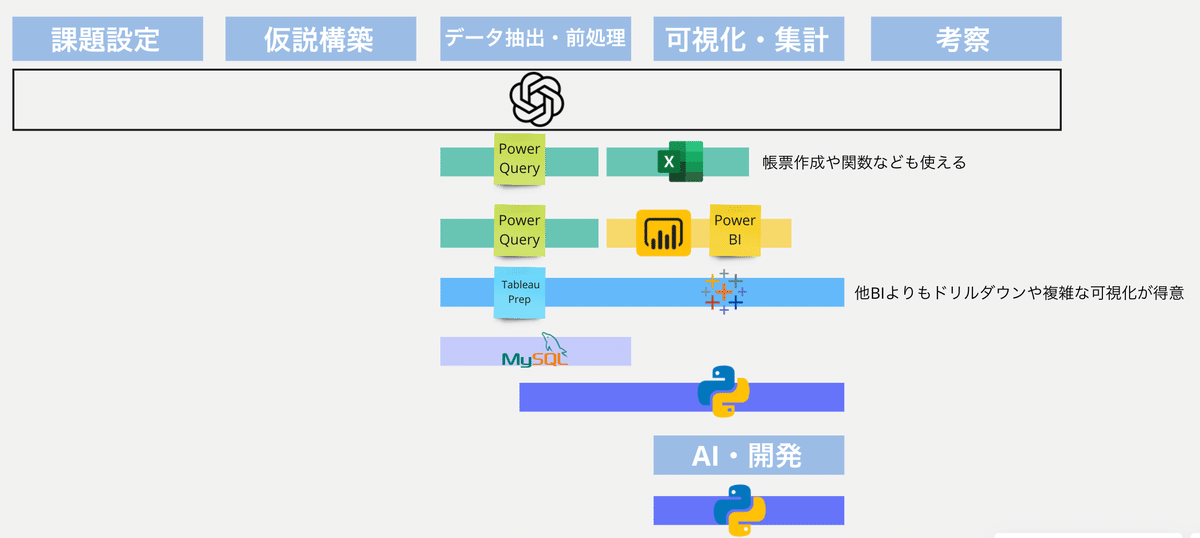

これらをデータ分析の流れに合わせて以下にマッピングしてみました。

※マッピングは若干無理やり感もありますのでご了承ください。

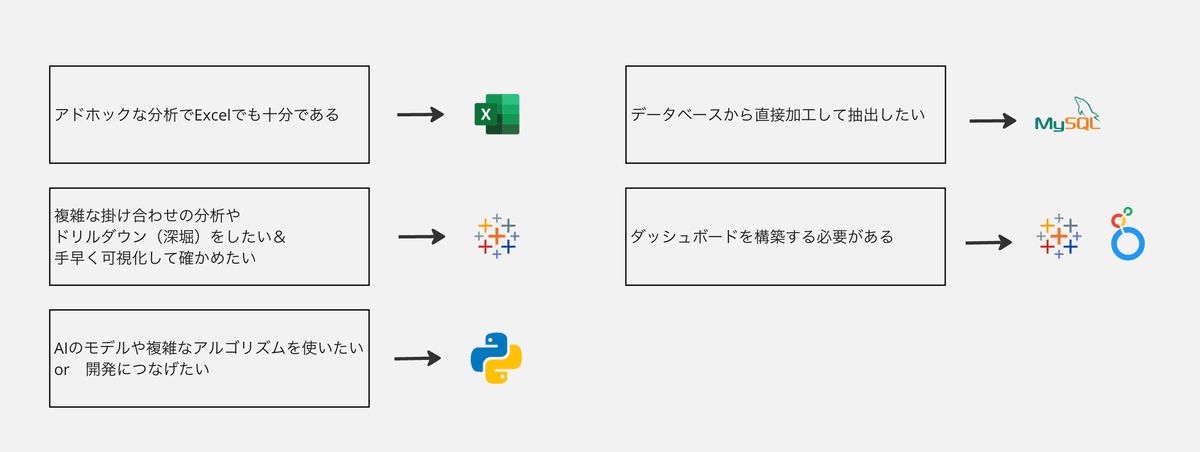

この中でアドホックなデータ分析で必要なデータ抽出・データ前処理、可視化・集計の部分を見てみると以下の写真のようになります。

※アドホック分析とは、特定の課題や発生した問題に対処するためにスポットでデータを調査・解析することを今回は指しています。

段々と便利な分析機能の登場もあって、代表どころの製品であればデータ抽出やデータ前処理の機能があり、可視化のためのツールと組み合わせることで、データ抽出〜可視化や分析の深堀は一定できます。

ExcelやPowerBIであればPowerQueryとの組み合わせ、TableauであればPrepとの組み合わせ、PythonもSQLでデータベースから抽出してそこからPythonでデータの前処理や可視化ができます。

こうしてみるとアドホックな分析を中心に業務に活かしていきたい方であれば一定どのツールでもやりたいことのある程度は満たせますね。

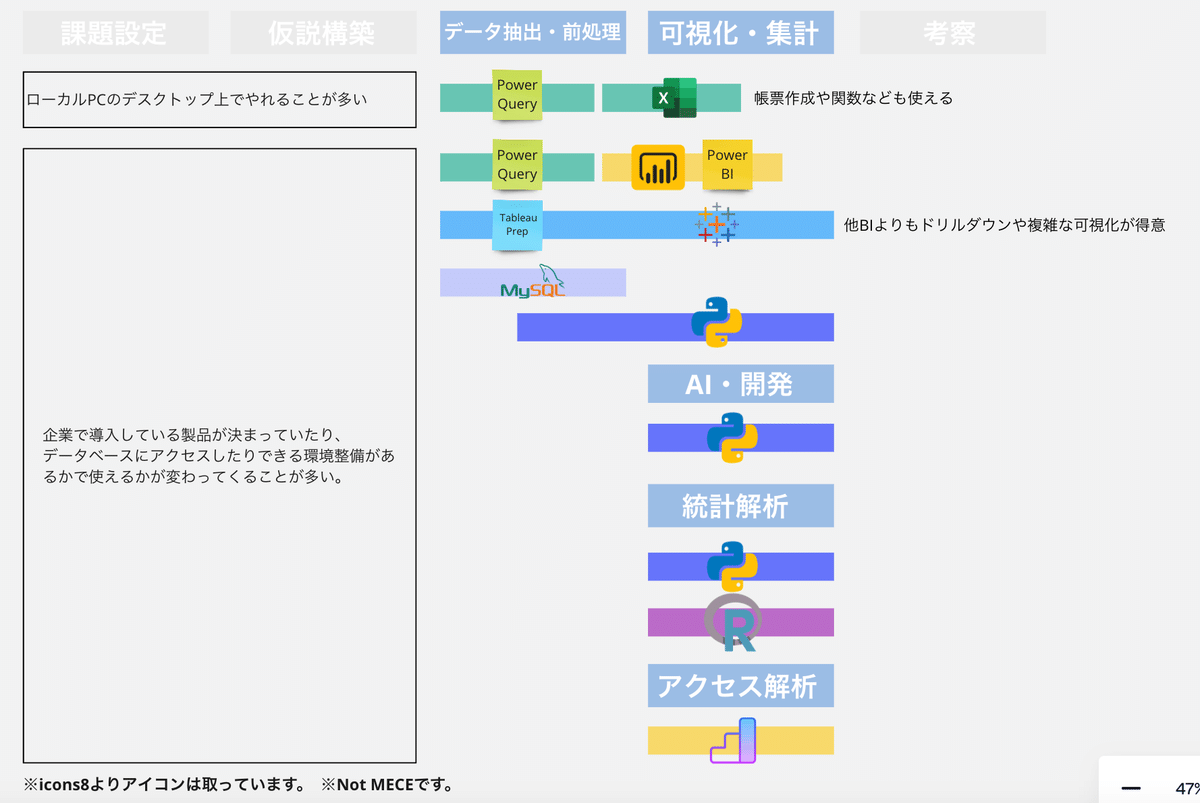

ただ、以下の写真のように企業でデータ分析を行う際には環境面での制約が出てきます。

Excelなどは比較的導入している企業も多く、ローカルPCのデスクトップ上で分析もやりやすいため割とどんな人でも始めやすい印象はあります。

一方で、BIやアクセス解析ツールなどは企業によって導入しているツールがバラバラなので、所属している組織でどのツールが使えるかを確認する必要があります。

また、PythonやSQLなども分析専用の環境での実施を取り決めている企業もあるため人によっては利用権限の取得などで使うまでにハードルがある方もいるのではないかと思います。

何社も渡り歩いている訳ではなく、他社の方と話した時の情報をもとに書いていたり、個人的な主観も混ざっていますが意外と分析ツール1つを取っても企業によって使えるものの状況は変わる印象です。

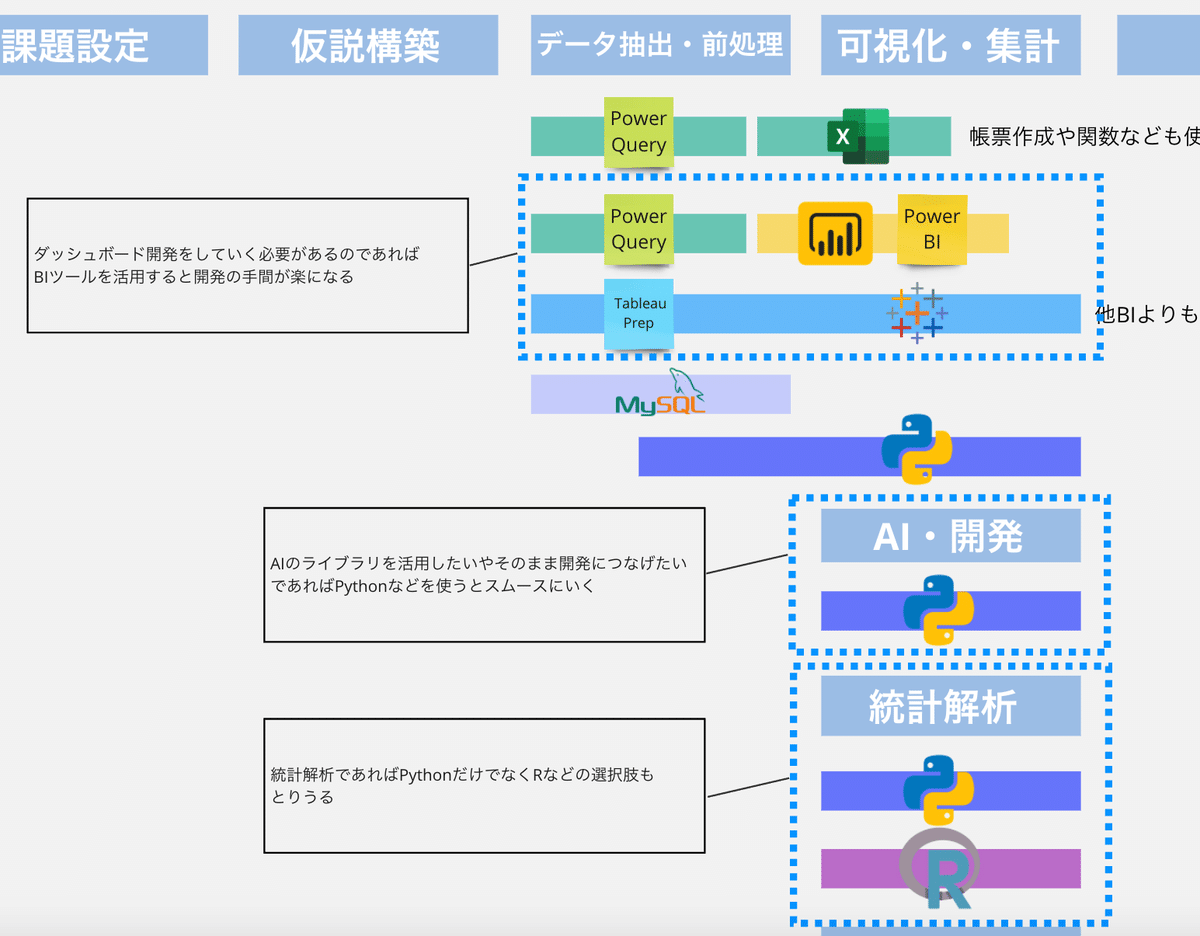

また、ダッシュボードを開発したいケースや、AIモデルを活用したいケースであれば以下の写真のように選択するツールが変わります。

アドホックな分析まででよければ企業でどんなツールを導入しているかにもよりますが、ある程度選択の幅は広いですし、開発が要件に発生するとダッシュボードであればBI、AIであればPythonなどのプログラミング言語のほうが便利だったりします。

これらのことがあり、講座の受講生から聞かれた時は、まず必要な分析要件や組織で使えるツールの状況を踏まえた上で学び始めるツールは選んだほうがいいと伝えているといった感じです。

アドホックな分析ではツール以外の部分も重要

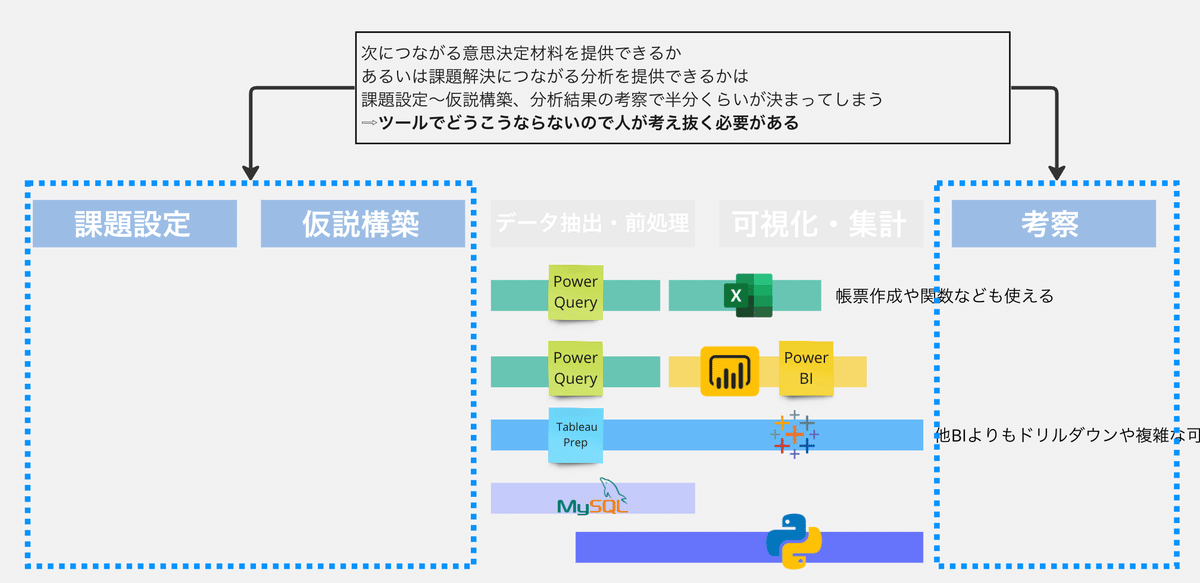

ここまで分析のデータ抽出&前処理〜可視化の部分でのツールのカバー範囲を見てきました。

ツールを使ってデータ分析できるようになることでさまざまな角度からの情報を手に入れることができるのでどんどん実践で試しながら腕を上げていただけたらなと思います。

ただ、実際にデータ分析のプロジェクトを始めると気づくのが、

データ分析を通して相手に次のアクションにつながる意思決定を提供できるかは以下の写真の囲んだ部分で半分決まってしまう感覚があります。

実際、課題解決につながる分析をしていかなければ課題は解決しないですし、次のアクションにつながるような分析仮説を立てて分析しないと、

分析してみたはいいけれど結局よくわからなかったという状態に陥ることは意外とあります。

必要に応じて探索的に分析するケースはありますが、できるかぎり分析に入る前に解くべき課題を特定して、適切な分析手法を選択することがこれまでの経験上オススメです。

課題設定や仮説検証については過去に以下の記事で紹介しているので興味ある方は読んでみてください。

ツールを1つマスターしながら分析の基本の流れを身につける

ここまでをみていくと

・アドホックな分析であれば一定度のツールでもやりたいことはできる

・いい分析をするには課題設定や仮説構築、分析結果の考察が重要である

ということを書いてきました。

これらのことから、これからデータ分析を身につけたい方に個人的におすすめしています。

身近で使用できる分析ツールを1つマスターしつつ、分析の課題設定〜考察の基本の流れを身につける

データ分析のスキルやナレッジの積み方は上記のイラストのようなイメージです。

まずは、1つのツール(あるいはExcelとPowerQueryのように1組あわせ)の使い方を覚えながら分析の課題設定〜分析結果の考察を経験し、基本的な流れをできるようになることが重要です。

ツールが何も使えないとデータ分析はできませんが、ツールの使い方だけを身につけても、課題設定や仮説がずれてしまうと、結局何も情報を提供できないで終わります。

初めからあらゆるツールを使いこなせなければデータ分析はできない訳ではないので、ますは身近で使えるものを選んでもらい、使い方を習得しつつ、データ分析の一連の流れをこなせるようになる。これが重要だと個人的には考えています。

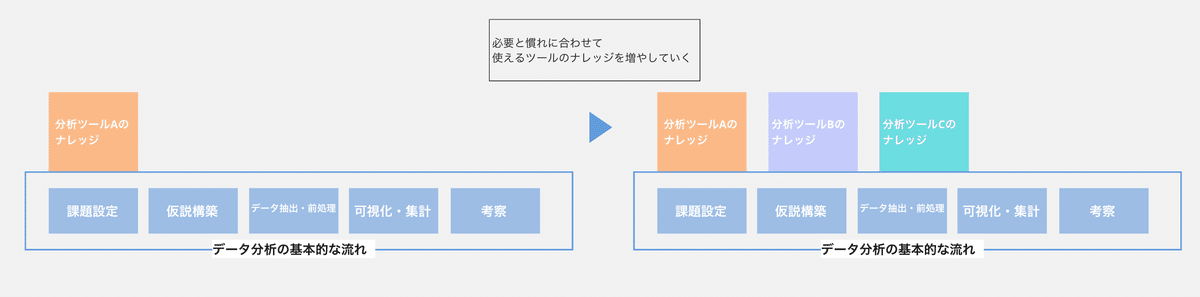

逆に、データ分析の基礎の土台が出来上がり、ある程度何をすればいいのかがわかってくれば、他のツールを使うとなったとしてもツールの習得が早くなっていきます。

”新しいツールでテーブルを結合するときはどうすればいいんだっけ、あぁ、これを使えばいいのね”といった感じで初めて覚える時よりもだいぶ楽になります。

実際、私はExcel(大学研究時代)→Python&SQL(社会人から)→Tableau→Adobe Analytics→VertexAI→Lookerの順で引き出しを増やしていってました。

メインはPython&SQLとTableauで、その他のツールは開発やプロジェクトの都合上覚えないとまずかったため研修なども活用して1個ずつ覚えていったという感じでした。

どうしてPythonやTableauから学んだのかと聞かれれば、会社の分析環境の都合上、使えるものがこれらだったためといった感じです。

ですので皆さんもご自身の環境にあったツールから学び始めてもらえたらいいかなと個人的には思います。

また、データ分析の一連の流れを身につけるためのいい教材ないですかという方は以下の書籍がオススメです。

大阪ガスのデータ分析組織が自組織の経験をもとにデータ分析だけでなく仮説構築〜考察までの一連の流れを体験でいるように書籍を書いてくれていてこれからデータ分析を学びたい方にはオススメです。

データ分析ツールの使い分け個人事例

こうしてデータ分析の引き出しを増やしていくと、ケースに応じて適切なツールを使い分けられるようにもなってきます。

個人としては以下用にざっくりとツールを使い分けています。

ケースに合わせて選択はしており、例えばSQLで加工するほうが楽であればSQLで加工してtableauで可視化や分析をしてしまうなど併用することもザラにあります。

引き出しが増えるとやれることの幅や処理を楽にすることもできるのでこれからスキルを身につけたい方は色々挑戦してみてください。

生成AIとかは現時点でデータ分析に使えるのか?

最近ではChatGPTにデータ分析機能が搭載され、データを添付すれば分析だけでなく結果からの考察や、Pythonコードまで書いてくれるようになりました(個人的にも感動しました)。

生成AIがあるのであればデータ分析は任せてしまえばいいじゃないかという声も実際に増えてますね。

そして、個人的にある程度同意します。先ほどのマッピングに追記すると課題設定〜分析の考察まで幅広く生成AIはカバーしてくれます。

ただ、生成AIを頼り切って全て任せるというよりは現段階ではアシスタントとして使うにとどめたほうがいいとは考えます(視点を増やしてくれるや分析のたたきを作成してもらう、データの加工をしてもらうなど)。

というのは、例えば課題設定であれば、生成AIは現場の情報を学習はしていないので課題の本質に辿り着くような情報収集は人が行う必要があります。

また、データ分析においてもPythonコードが間違って生成された時に、ある程度プログラミングの経験とかがないとどのように結局対処すればいいのかがわからなかったりすることがあるからです。

ただ、これまで時間がかかってしまっていた部分は全然任せられるのでどんどん活用してより効率的に作業していきましょう!

これからデータ分析を学びたい人への教材

最後にこれからデータ分析を学んでいきたい方にどんな教材があるのかだけ実体験をもとにいくつか紹介できればと思います。参考にしてください。

Udemy

まずは有名なUdemyです。

PythonやTableauなどデータ分析の未経験向けの動画教材が豊富でおすすめしています。

Pythonであれば

少し難しめだと

あたりが実際に受講してよかったです。

Tableauであれば

が基本に忠実でオススメです。

※ただ、バージョンアップも早い世界なのでPythonやTableauのバージョンが古いケースもあります。ここは気をつけてください。

コミュニティ

Tableauだとコミュニティの活動が盛んで以下のようにデータを揃えてくれて課題を解けるようなサイトもあります(PowerBI課題もあります)。

ただ、英語で書かれているのと、結構難しいのである程度基礎を身につけてさらに自己研鑽したい人向けです(Tableau Publicが必要です)。

書籍

5年前くらいと比べて今やデータ分析の書籍もたくさん増えましたね。

個人的には始めた時は本当に少なかったのですごく学びやすくなったなと感じます。

正直、自信が読みやすいものを選んでもらえたらいいのですが、書籍で学びたい方は個人的には以下の書籍で初めはスタートしました。

■データサイエンス(PythonやSQLは後で出てくるProgateで学びました。)

上記は機械学習モデルのPythonでのコーディングが中心なので理論を学びたい方は別の書籍を合わせてください。

■データ分析の基本の流れ

途中紹介した大阪ガスのデータ分析研修本は全体の流れを書いてくれているのでオススメです。Python使わないよという方であればこちらですかね。

また今やネットで無料教材(東京大学などが提供してたりします)もたくさんあったり、YouTubeでもわかりやすい講座もあるのでオススメですね。

プログラミング有料サービス(Progate)

PythonやSQLはProgateというサイトで学びました。

なぜこれなんだと聞かれると、その当時UIが可愛く優しそうに見えたからです!実際分かりやすく始めからつまづくのは防げた気がします。

こうしてみるといろんな教材がありますね。

ネットで検索するとこの辺りのおすすめ本や教材はたくさん情報が出てくるのでご自身にあったところからスタートしてもらえればと思います!

まとめ

今回はデータ分析を始めるにあたって何を意識すればいいかのついて記事をまとめました。これからデータ分析ができるようになりたい方にとって参考になれば幸いです。

prompt4plannerでは引き続きこれからの企画職・マーケティング職が仕事をする上で便利な情報をお届けしていくので気に入った方は職場の方や友人にぜひシェアしてみてください!

いいねやフォローもお待ちしてます!

いいなと思ったら応援しよう!