記事一覧

生成AI近況分析:変わりつつあるITハードウェアベンダのビジネス戦略

さて生成AIに関係するようになってから、一年が経過した。表向きはGoogleやMicrosoftのようにGAFAMと呼ばれる5社とOracleがNVIDIA GPUを買いまくって話題になっているけど、その裏でHPEやDellは随分と様変わりしてきた。

一年前は「我々も大規模システムを次々と受注できるかもしれない」という夢が膨らんだけれども、結局のところはマッキンゼーなどのコンサルティング企業や

生成AI侮るべからず:佐賀の織田病院の事例

「サルも木から落ちる」ということわざがある。どうも佐賀の織田病院の事例が軽く見られているようだ。

今回は「餅は餅屋」というか、実は佐賀の織田病院の生成AI事例は業界人から見ると大したことなので、関係者ではないけれども紹介させて頂くことにしたい。

間違いではない(正解でもない) 今回の発端は、このX(Twitter)ツイートだ。これを見て、「病院は個人情報を保護することを最優先にするのか…」と思

人工知能(LLM)はダジャレを言えるか試してみた:生成AIの学習能力?

けっこう真面目な話。

実は生成AIというのは大量の言葉の繋がるパターンを学習し、人間がプロンプトで入力した内容から出力を作成する。逆に言うとパターン化した出力になる。コンサルティングでアイディア(特定の条件を付けて適当なフレーズを拾ってくる)を求めるとか長文要約は得意だけれども、駄洒落のように非定型パターン&単語決め打ちのように数学計算に近いような処理能力は気になるところだ。

東大の入試問題

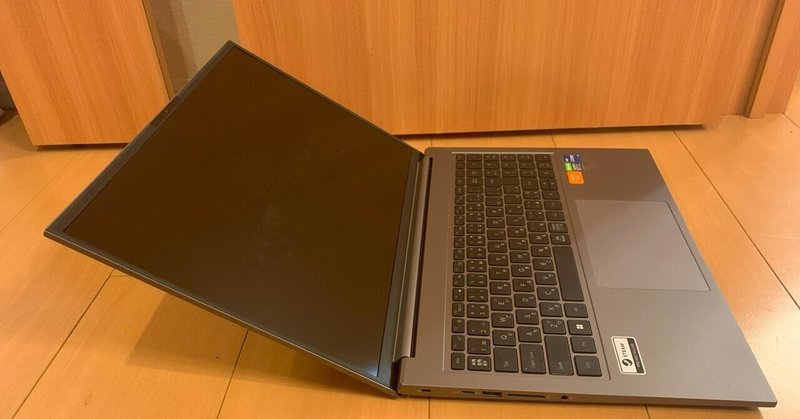

[オタク機器日記] 我が家で稼働中の人工知能(LLM)はフリーザ様のデスビームを知っていた件

最近はクラウドの向こうにある超大規模GPUクラスタに頼らずとも、社内とか自宅に設置されたマシンでローカル生成AI(LLM)が使い物になりつつある。大きくは数百Bパラメータ版の汎用型と数Bパラメータ版の目的特化型の二系統に分かれているが、我が家で稼働しているCommand R Plus 104B版の場合は、何も教えなくてもフリーザ様のデスビームを知っていることが判明した。

今回は「なんでそんなこ

生成AI導入を阻害する壁があると説明する人々に2パターンがあるという個人的感想

SNSで何回も流れて来て、ちょっと何だなあと感じたので自分的感想を掲載しておくことにする。

えっ、こんな記事を書いている暇があったら、さっさとIntel Arc GPU関連の検証結果をレポートしたり小説を書けって? 全くその通りだと思う。

放置しておけば良いじゃないか 大体この手の記事を書く人の半分くらいは、生成AIコンサルタントを名乗る方々だったりする。だから「あ、そうですか」で加齢に、い