記事一覧

Llama-3-ELYZA-JP-8Bを雑に触る

Llama-3-ELYZA-JP-8Bについては下記参照。

0. 環境

1. RAGに使用するDBの準備

下記で作成したDBを流用します。

DBの内容は、Google Patentsで「(semiconductor) country:US after:priority:20230101 language:ENGLISH」でヒットした857件の特許のうち、下記記事でFinFETに分類されたもの

[UI]Chainlitで専門家AI_Local-LLM+Langchain+ChromaDB

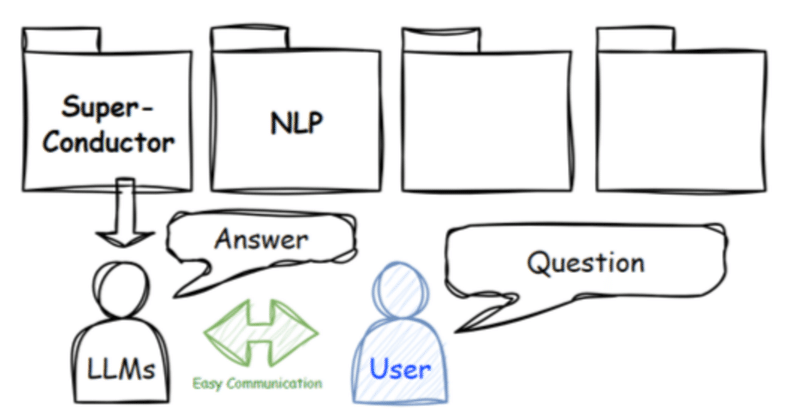

LLMのUIにはtext-generation-webuiをはじめ様々なものがありますが、今回はChainlit(GitHub)に下記の記事で作成したDB(Langchain+ChromaDB)を使ってLocal-LLM(Starling-LM-7B-alpha)に回答してもらうChat-UIを作成します。

ほかのユーザーに使用してもらう際に、UIはユーザーの認知容易性の面でメリットがあります。

[活用例]Local-LLM+Topic model+Langchain+ChromaDB

今回は集めた特許データをTopic modelで分類し、分類したtopicごとにChromaDBでデータベースを作成、Langchainを使ってRAGを設定し、Local-LLMに回答してもらうフローを整理しました。

フローは上のイメージ図の通り、下記の手順で進めます。

1. 特許からコンセプトを抽出

2. 抽出したコンセプトを分類

3. トピック毎にデータベースを作成

4. RAGの設定

Starling-RM-7B-alphaとZephyr-7B-betaを簡単に比較

今更ですが、Starling-RM-7B-alphaを試してみました。本モデルの詳細は下記でまとめらています。

ベンチマーク

MT Bench, AlpacaEval, MMLUのいずれでもZephyr-7B-betaを上回ります。私個人としてはAlpacaEvalのscoreが高い方が使い勝手が良いように感じています。

0. 環境

1. arXivから論文取得

"super resol

[UI]Chainlitで専門家AIと会話する_Local-LLM+Document Summary Index

LLMのUIにはtext-generation-webuiをはじめ様々なものがありますが、今回はChainlit(GitHub)に下記の記事と同じ方法で作成したindexを使ってLocal-LLMに回答してもらうChat-UIを作成します。

クラウドや高性能PCで作成したindexをそれほど高性能でない別のPC内で活用することができます。ほかのユーザーに使用してもらう際にUIはユーザーの認知容易

Local PCに専門家を作る_Local-LLM+Document Summary Index

下記の通常のRAGに対し、LlamaindexのDocument Summary Indexを用いた事例です。

検索に要約文を用い、検索速度をあげつつ、要約文に質問例を追加することでembeddingでの検索の精度をあげることができます。

今回も前回同様に、専門知識が論文や特許になっているような、所謂「研究者」のような専門家チャットAIの実装を試みます。

0. 環境

1. 知識の収集・格納

Local-LLM+LongLLMLingua, RAG series 3/n

RAGシリーズ3回目。

今回はLlamaindexでLongLLMLinguaを用いたRAGです。

通常のRAGではpromptが長くなりがちで、計算コストが嵩む(ChatGPTなどを使用する場合は費用が嵩む)、性能が低下する(ex.:“Lost in the middle”)、などの課題が生じます。それらの課題を、適切にpromptを圧縮するLLMLinguaとRerankingなどを組み合わ

いつでも手軽に呼び出せる専門家_Local-LLM+RAG活用事例

下記で紹介したLlamaindexのRecursive Retriever + Node Referencesを用いたRAG活用事例です。

専門知識を気軽に活用したくても、大抵、専門知識を持った人材(以下、専門家)は高価で気軽に使えず、課題も多いと思います。

具体的には下記などがあります。

希少で活用頻度が低い

高価で予算が必要

レスポンスが悪い(コミュニケーションに時間を要す)

コミュ

Local-LLM+Knowledge Graph+RAG, RAG series 2/n

RAG(検索拡張生成) システムシリーズ2回目。

今回はLlamaindexでKnowledge Graph(KG)を用いたRAGです。

KGは似た用語でKnowledge Base(KB), Concept Graph(CG)などがありますが、ざっくりと知識をグラフにしたものです。その利点はデータの管理が楽で、新しい知識を追加し続けることができ、情報のソース等のメタデータも取り込むことが可能で

Local-LLM+RAG, 1/n

特定の情報を基にLLMに応答させる手法として、言わずとも知れたRAG(検索拡張生成) システムですが、関連のテクニックが溢れて大変なので、メモがてら残していきます。

今回はLlamaIndexで子chunksを使ったRecursive Retriever + Node Referencesと検索でhitしたtextの前後のtextも参照するNode Sentence Windowです。

RAG

Local-LLMで特許文献整理

Bertopicで特許文献の整理をしてみました。

分類するため、要約にZephyr-7B-βを、要約文のembeddingにbge-large-en-v1.5を使用しました。

対象は、最近また騒がしい半導体を勉強がてら使用しました。

0. 環境

OS:Windows

CPU:Intel(R) Core i9-13900KF

RAM:128GB

GPU:RTX 4090

1. 特許情報取得

Zephyr-7B-βを試した

Zephyr-7B-βをαと比較しました。

0. 環境

OS:Windows

CPU:Intel(R) Core i9-13900KF

RAM:128GB

GPU:RTX 4090

1. Arxivの"NLP"論文のabstractを要約

Arxivの"NLP"最新論文の情報を収集

import arxivarxiv_query = "NLP"search = arxiv.Search(

![[UI]Chainlitで専門家AI_Local-LLM+Langchain+ChromaDB](https://assets.st-note.com/production/uploads/images/125446245/rectangle_large_type_2_b77f8f7b5a346ba31706d146ae516ec1.png?width=800)

![[活用例]Local-LLM+Topic model+Langchain+ChromaDB](https://assets.st-note.com/production/uploads/images/125226437/rectangle_large_type_2_ffdcc0de4669aecf99c1fb4f9af87c37.png?width=800)

![[UI]Chainlitで専門家AIと会話する_Local-LLM+Document Summary Index](https://assets.st-note.com/production/uploads/images/124129570/rectangle_large_type_2_a21db0a60e2b5715afe4c05687b9b779.png?width=800)