アルツハイマーを予測するマルチモーダルなAI

つい先日、ChatGPTの大型アップデートの話をしました。

メニューをすっきりして認識能力を向上させただけでなく、プログラマーでなくても自分専用のGPTアプリを作れる機能が登場し、まさに「誰でもAI」の時代が到来しつつあります。

が、だからといって従来の専門的なAIが色あせるわけでもなく、つい最近も素敵な研究発表がありました。

ようは、

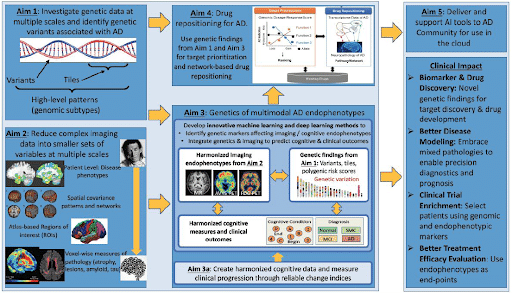

脳画像・ゲノム情報を組み合わせてAIに読み取らせることで、アルツハイマー予測能力が向上した、

という話です。

アルツハイマーの基本的な原理と対処については、過去にも触れたので興味ある方はそちらへ。(タイトルが示す通りまだ仮説の検証中)

アルツハイマーの研究は何十年も蓄積があり、途中でMRIの登場によって脳画像データも蓄積されてきました。

どうも記事によると、初期のアルツハイマーは見極めが相当難しいらしく(症状が確認困難。物忘れなら確かに日常的に起こりがち・・・)、それを大量の脳画像とゲノム情報を組み合わせることで予測精度を上げたようです。

まだ、追検証は必要ですが、ある研究では脳画像だけで9割の正確性を実現したようです。

このAIは機械学習型ですが、アルゴリズムは(GPTとか既存パッケージでなく)独自で構築したようです。

とはいえ既存の大量データを訓練させているとのことで、LLM(大規模言語モデル)に近いモデルを作ったのだろうと推察されます。

その組織(所属組織を横断したコンソーシアム型)の公式サイトを共有しておきます。

他の組織による研究も2つほど紹介されています。

極力人間のバイアス(偏見)をなくすために、脳画像からAI自体がモデルを改良する仕組みを作り上げました。

深層学習が画期的な成果をあげたのも大量データだけでなく、アルゴリズムがモデルを自己改善出来る(何が特徴かをマシンが見出す)可能性で切り拓かれました。

そしてもう1つの別の切り口が「マルチモーダル」です。格好いい横文字を使いましたが、別の種類のデータを掛け合わせるアプローチです。

例えば、我々が人と向かい合ったときには、単に顔の表情だけでなく話し方も影響しているはずです。

アルツハイマー予測に対しても、脳画像と遺伝子情報だけでなく、血液データも取り込もうというアプローチです。

まだこれからですが、当事者たちによれば「指数関数的に」能力が向上できると期待しているようです。

AIも上記でふれた人を判断するだけでなく、マルチモーダル化は1つのトピックです。

ChatGPTはすでに画像とテキストの組み合わせは対応できるようになりましたが、スマホアプリでは音声聞き取り(Whisper)も組み込んでおり、さらに冒頭ふれたとおり各自が独自アプリを作れる時代です。

技術というよりはあとはアイデアと実証を積み重ねることで、我々一人ひとりにとっての最高のパートナーが出来上がるかもしれません。

この記事が気に入ったらサポートをしてみませんか?