#AI

Google AI Studio で つくよみちゃんの会話テキストデータセット による Gemini の チューニングを試す

「Google AI Studio」で「つくよみちゃんの会話テキストデータセット」による「Gemini」のチューニングを試したので、まとめました。

1. つくよみちゃん会話AI育成計画(会話テキストデータセット配布)今回は、「つくよみちゃん」の「会話テキストデータセット」を使わせてもらいました。「話しかけ」と、つくよみちゃんらしい「お返事」のペアのデータが470個ほど含まれています。

2. デ

相づちに特化した軽量なLLMを作ってみる #役に立たないLLM

会話するAIキャラクターを作ろうとすると、返答を生成する待ち時間が気になります。気になるはずです。GPT-4はサーバーが重いときはおよそ会話として成立しないほど待つこともあります。

そこで、軽量なローカルLLMにとりあえず相づちだけ打たせて、その間に、性能の良いLLMにちゃんとした返答を生成させれば良いのでは、なんてことを考えてみました。

データセットとして、以下のRosebleuデータセット

LLMの事前学習で利用されるmC4のデータを確認

はじめにLLMの事前学習で広く使われるデータセットmC4の中身が気になったので確認し記事にしてみました!

ダウンロード方法から一部データの確認までします。

mC4とは?mC4は100以上の言語を含む大規模な言語データセットで、インターネットから収取された膨大なテキストデータセット「Common Crawl」を基にしています。Common Crawlから不要なノイズを取り除く処理はされているものの

mC4データを文章量でアノテーションしました

はじめにLLM(Large Language Models)の事前学習において、広く使われているデータセット「mC4」には、残念ながら多くの「ゴミデータ」が含まれています。実際のデータを手軽にチェックしてみたい方は、私が別の記事で取り上げているので、そちらもぜひご覧ください!

実際にデータを確認してみたところ、前処理を頑張ってもゴミデータを取り除くのは困難だと感じました。そこで、mC4データをア

社長(AI)に頼んで1万件(10K)の商用利用可能(llama2ライセンス)な日本語マルチターン会話データセットを作ってもらった

注意:llama2の派生モデルであるllama2Pro8Bで生成しているので商用利用可能な範囲に制限があります。詳しくはllama2ライセンスを確認してください

https://ai.meta.com/resources/models-and-libraries/llama-downloads/

「社長、ただいま出張から戻りました!」

「・・・」

「お願いしていた稟議の件、どうなりましたで

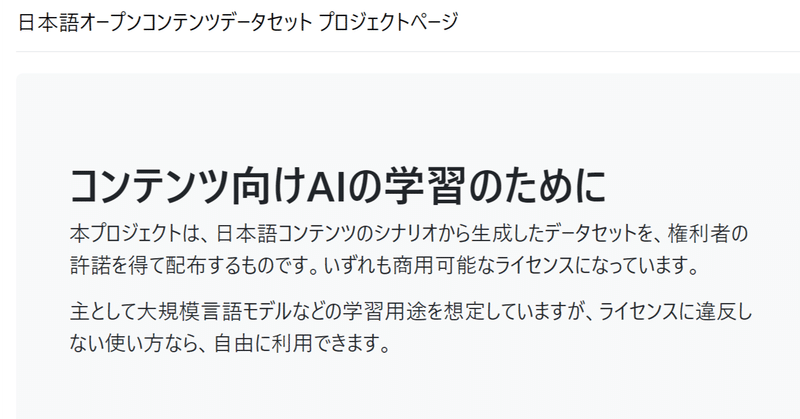

ゲームシナリオから作成した、学習用データセット公開プロジェクト

日本語オープンコンテンツデータセット プロジェクトというプロジェクトを始めました。

https://open_contents_datasets.gitlab.io/project_home/

LLM(大規模言語モデル)の学習をする上で、日本語のデータセットがまだまだ多くありません。特に、プロが作ったエンターテイメント作品のシナリオを、個人開発者や研究者が利用出来る場面は限られています。

そ