AIがセラピストになる日が来る?

生成AIは多様なシーンで活用が進んでいます。

先月に公開された研究発表で、AIが精神科医の部分活動ができないかを試す野心的な論文がありました。

ようは、

生成AI(LLM:大規模言語モデル)で、認知の度合いを測ることができる、

という話です。

論文内でまずびっくりしたのが背景(研究動機とも)です。

2022年時点で精神的な問題を抱えている人が8人に1人いるそうです。

残念ながら、その数に対処できる専門家が不足しており、それが今回のAIによる支援研究につながっています。

そして第一歩が今回の成果で、まずは認知の歪み度合いを検出するAIを実験で試しています。

使ったLLMはGPT(&ChatGPT)で、学習データは過去の診断履歴を注意深く選んだようです。

全てAIに委ねたわけでなく、3段階の方法論で分類して出力(認知度合い)を出力する方針で、それは

「主観性評価(事実と思考の区別)」

「対比推論(思考を支持または反対する推論プロセスの抽出)」

「スキーマ分析(認知スキーマの要約)」

のホップステップジャンプ方式です。

下記の図が全体的なフレームワークとして本文中にまとめています。

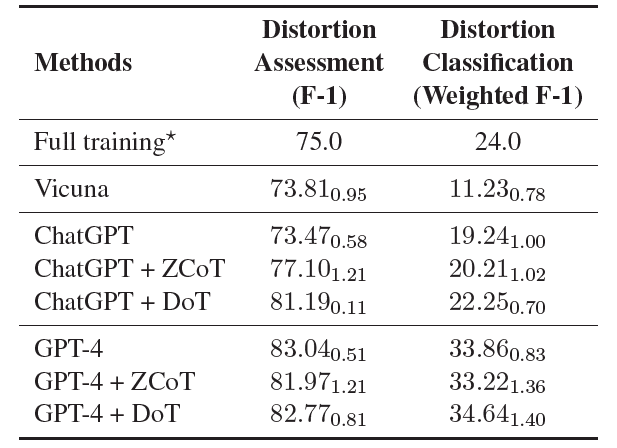

そして、結果(今回は専門家診断との比較)については下記のようになりました。

表内にあるVicunaとは、AIチャットボットの一種で、ZCoTやDoTという用語はプロンプトの書き方技法です。(ステップ方式で聞くとか)

他の成果を見ると、その技法によって結構差があるのでなかなか奥が深そうです。

これらの結果をして満点と言っていいかは分かりませんが、論文内では今後もこの分野の開拓を進めたい、との意思がありそれなりの手ごたえはあったのだろうと思います。(勿論倫理面や安全面への配慮も添えています)

実は、AIを精神療法で使えないか、という視点はAI黎明期にもありました。その先駆けは、1960年代(!)に開発されたELIZA(イライザ)です。

何となく名前はきいたことがあるのではないでしょうか? AppleのAIアシスタントSiriが出たときに、先祖的な扱いとして一時期話題になりました。

当時社会現象となるぐらいELIZA人気はすごかったようで、患者の中にはAIと信じなかった人も出たそうです。

ただ、皮肉なことに開発者のワイゼンバウムは、簡単なプログラム(数百行のソースコード)にもかかわらず反響があまりにも大きかったことから、逆にAI(または人間?)不信に陥り、アンチAI論者に鞍替えしてしまいます。

今回のLLMと独自フレームワークによる入念なアプローチと比較するべくもないですが、ぜひ21世紀のELIZAには社会課題にまい進してほしいと思います。

この記事が気に入ったらサポートをしてみませんか?