#AI

【Wilma】Linux Mint 22にアップグレードした話【Ubuntu 24.04ベース】

※ 実はLinux mint 21からの自動アップグレード(mintupgrade)は失敗したので、クリンインストール+手作業移行です。

いつもLinux Mintで驚かされる事は、大型アップデートなのに、見た目は何も変わっていない事です。内部はかなり変更されているのですが、ユーザーインターフェースや操作方法が全く変わっていません。

昨今のソフトウェアはアップデート・アップグレードという名目

AI特異点(シンギュラリティ)は来るのか?

上記の定義とはちょっと異なりますが、物理数学では、簡単な組み合わせによる(簡単に)予測できるものが、あるポイントから突然複雑で予測不可能な振る舞いになる現象がよくあります。

たとえば、三体重力や、有名なロジスティック写像です。※ AIにお願いするとささっとコードを書いてくれます。

import numpy as npimport matplotlib.pyplot as plt# ロジスティッ

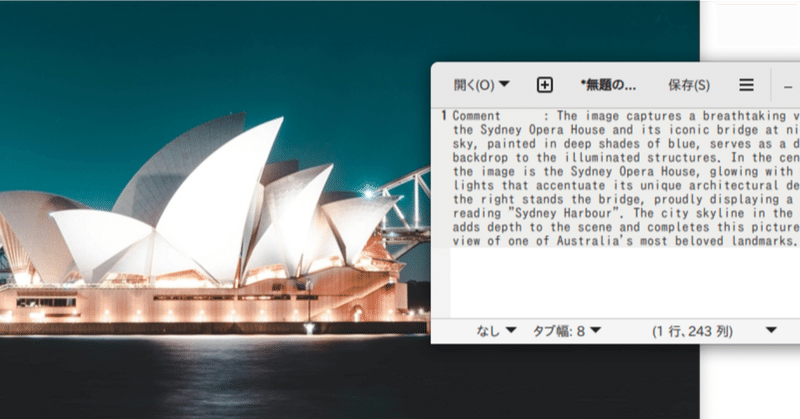

【ローカルLLM】Mistral-NeMo(12B)を使ってみた話

ローカルLLMとは、ChatGPTのような大規模言語モデルを、ローカルのパソコンで動かす小さなモデルの事です。ゲーミングPC程度の性能があれば、多くの言語モデルを動作させる事ができます。※ 筆者環境はRTX3060(12G)です

NVIDIA一押しのMistral社の多言語対応最新LLMモデルMistral-NeMoをOllamaで利用してみました。

ollama(Windows版)をインスト

【ラフ画AI生成】Kritaでステーキを描く【練習】

はじめにKrita-ai-diffusionというKritaプラグインを利用すると、KritaでStable DiffusionによるAI画像生成を利用する事ができます。この記事はステーキ画像を練習として生成した過程の記録です。

Krita-ai-diffusion など筆者が利用するAIツールの導入方法はまとめてこちらで説明しています。

初期プロンプトとラフ画あまりステーキに詳しくなく一般

【ずんだもん】ローカルLLMにずんだもんの声で応答させる【LLM】

はじめにローカルLLMを実行できる ollama Open WebUI にずんだもんの声で応答させる「工夫」の紹介をします。各ソフトウェアのインストールさえできれば簡単に実現できます。

※ Open WebUI にはwebAPIのTTS読み上げ機能はありますが、VOICEVOX を直接操作する方法がないので、クリップボード経由での工夫です。Windowsでの説明を行います。

前提① VOICE

【ローカルLLM】Ollama Open WebUI 完全解説【初級向け】

【追記:2024年8月31日】Apache Tikaの導入方法を追記しました。日本語PDFのRAG利用に強くなります。

はじめに本記事は、ローカルパソコン環境でLLM(Large Language Model)を利用できるGUIフロントエンド (Ollama) Open WebUI のインストール方法や使い方を、LLMローカル利用が初めての方を想定して丁寧に解説します。

※ 画像生成AIと同じ

【AI活用】動画キャプチャ画像をAIアップスケーラで高画質化【ローカル】

はじめにネットで利用できる拡散モデルの高性能アップスケーラは有料かつ高価である事が多い(例:Magnifiy AI・5900円/月)のですが、やはりその理由は、それに見合った価値があるからではないでしょうか。

たとえば、(一般的に高画質でない)動画のキャプチャ画像をトリミングしたものをアップスケールすれば、任意のショットを高精細な静止画の素材として利用する事もできます。一気に素材の利用範囲が広が

【中級】ローカルのみでの写真超解像化術【無料ソフトウェア】

想定する読者ローカル環境のみを利用して高性能な画像アップスケール技術を利用したい人

ローカルへ Stable Diffusion webUI (forge)、ComfyUI が導入済み

Stable Diffusion 等の基本的な操作ができる人

はじめにこの記事はローカルでアップスケール(写真高画質化目的)を行うノウハウの紹介をします。

ネット上の便利な写真の高画質化サービスはありますが