AIがAIを教育する世界は近い

2024年もAIが加速化するのはほぼ間違いありません。

丁度今、CES(Consumer Technology Association)という消費者向けの電子機器(自動車も含むスマート製品)展覧会がラスベガスで開催中で、速報が現地より上がってきています。

1つだけその日本語記事を紹介します。

まだ全てのイベントが終わったわけではありませんが、各社ともにAIをいかに組み込むか、がテーマになっているようです。

ちなみに、上記記事のタイトル画像は以前紹介したロボットです。興味ある方のために載せておきます。

CESについては、終了後に改めて取り上げてみたいと思います。

さて、今年も顔になりそうなAIですが、もっといえばLLMをベースとした生成AIが話題のフロントランナーです。

LLM自体の性能評価も重要ですが、OpenAIがリリースしたChatGPTが工夫したのは、その後工程にあたるファインチューニングです。

要は人間が作ったデータで回答を微調整するわけです。LLMだけだと回答が不安定なので人がならしてあげる、って感じでしょうか。

ただ、その人的作業は結構負担が大きそうです。

という背景をもとに、LLMをLLMでファインチューニング(と定義してよいかわかりませんが)する研究もおこなわれています。

査読前ですがUploadされた論文を共有します。

AIがAIと競い合って高めていく、この手法は過去にもありました。

今でこそ、LLMベースでの生成AIがブームですが、それまで話題だった画像生成AIで、GAN(Generative Adversarial Networks)と呼びます。

名前のとおり敵となるAIもつくって競わせる手法です。

ディープフェークの文脈で今でも登場します。参考までに、過去の記事を載せておきます。

他にも、囲碁の世界チャンピオンを破ったAlphaGoの後継版AlphaZeroも、AI同士で鍛錬することで、一気にAlphaGoより強くなりました。

今回の研究も、LLMの評価を自律的に行わせるテクニックが主なテーマです。

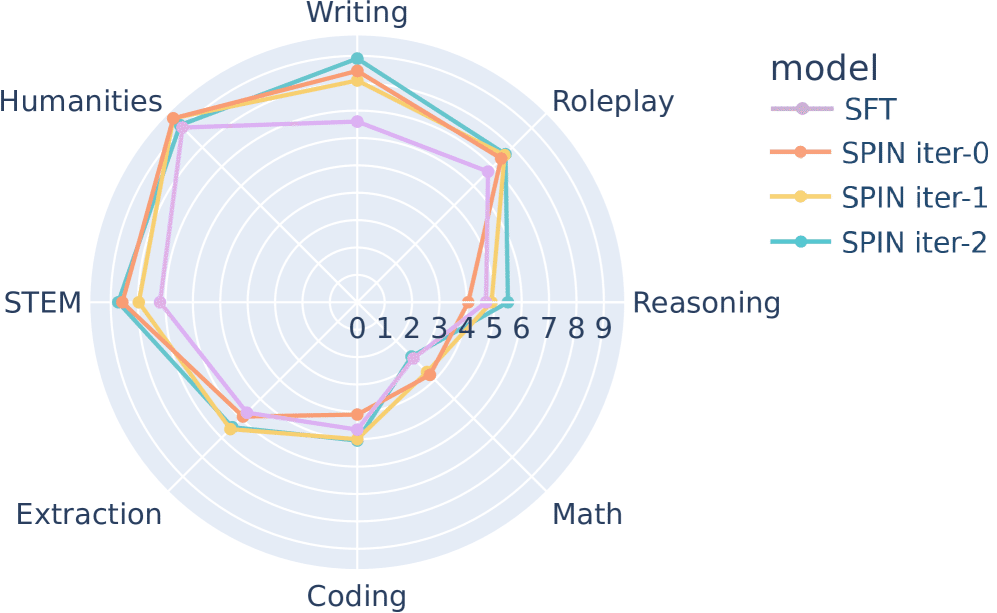

従来の人的な追加作業をSFT(Supervised Fine-Tuning)と呼ぶのに対して、今回考案した技法をSPIN(Self-Play fIne-tuNing)と名付けています。

検証材料にいくつかの著名なLLMを使っており、うちHuggingFaceを使った性能評価を上記サイトから載せておきます。

反復(iter)することでさらに正確性があがっていますね。

ただ、これだけと相対評価できないので、既存のSFTと比較した性能評価レーダーチャートも載せておきます。

若干ですが、既存よりもほぼすべてのケースで高い性能を出しているのが分かります。

こういった研究が広がると、近い将来AIがAIを賢くする自律的なAIエコシステムが実用レベルで誕生しそうですね。

他にも、AIが自身との対話で賢くなる可能性にふれた記事(こちら)もみかけました。

確かに、人間でも心の中で言語化したり他人に話すことで頭が整理されることはあり、人工知能の原理が我々の知能と似ているのであれば、直感的にはうなづけます。

とはいえ自律化がエスカレートすると漠然とした不安もあるので、国際的なAI開発競争はある程度透明性をもって臨んでほしいものです。

この記事が気に入ったらサポートをしてみませんか?