記事一覧

WSL2でlocal-gemmaを試してみる

27Bモデルのgemma 2がRTX 4090(24GB)でもロードできる?と噂のlocal-gemmaを試してみます。

使用するPCはドスパラさんの「GALLERIA UL9C-R49」。スペックは

・CPU: Intel® Core™ i9-13900HX Processor

・Mem: 64 GB

・GPU: NVIDIA® GeForce RTX™ 4090 Laptop GPU(16G

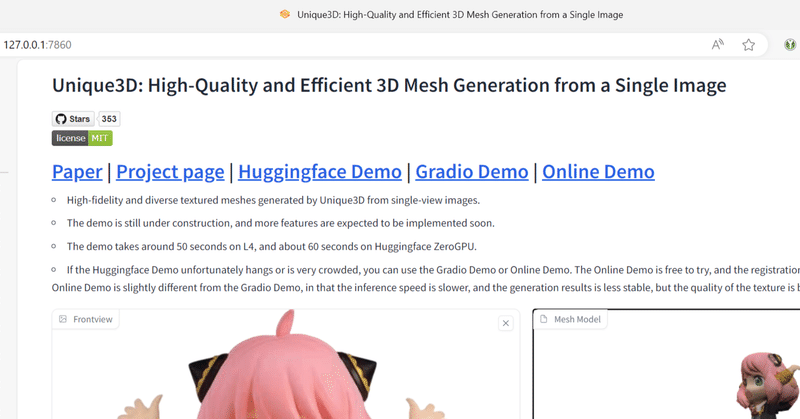

WSL2でEra3Dを試してみる

「一枚の画像から高解像度の多視点画像を生成する新しい多視点拡散方式」らしいEra3Dを試してみます。

使用するPCはドスパラさんの「GALLERIA UL9C-R49」。スペックは

・CPU: Intel® Core™ i9-13900HX Processor

・Mem: 64 GB

・GPU: NVIDIA® GeForce RTX™ 4090 Laptop GPU(16GB)

・GPU: N

WSL2でCF-3DGSを試してみる

「写真のようにリアルな新しいビュー画像を効率的に合成することに成功し、COLMAP 処理への依存を排除しながら、トレーニング時間の短縮とリアルタイム レンダリング機能を提供」してくれるらしいNVlabsのCF-3DGSを試してみます。

使用するPCはドスパラさんの「GALLERIA UL9C-R49」。スペックは

・CPU: Intel® Core™ i9-13900HX Processor

WSL2でMatMul-Free LMを試してみる

「LLM 1Bパラメータで行列計算を完全に排除できた。メモリ消費量を学習時10倍、推論時61%Max削減」らしいMatMul-Free LMを試してみます。

使用するPCはドスパラさんの「GALLERIA UL9C-R49」。スペックは

・CPU: Intel® Core™ i9-13900HX Processor

・Mem: 64 GB

・GPU: NVIDIA® GeForce RTX™ 4

WSL2でStable Diffusion 3を試してみる

Stable Diffusion 3を素で試してみます。

使用するPCはドスパラさんの「GALLERIA UL9C-R49」。スペックは

・CPU: Intel® Core™ i9-13900HX Processor

・Mem: 64 GB

・GPU: NVIDIA® GeForce RTX™ 4090 Laptop GPU(16GB)

・GPU: NVIDIA® GeForce RTX™ 40

UbuntuでMusePoseを試してみる

「仮想人間生成のためのポーズ駆動型イメージ-to-ビデオ フレームワーク」であるらしいMusePoseを試してみます。

1. 準備環境構築

python3 -m venv museposecd $_source bin/activate

リポジトリをクローンして、パッケージをインストールします。

# clonegit clone https://github.com/TMElyralab/

WSL2でID-Animatorを試してみる

「ゼロショット ID を保持したヒューマン ビデオ生成フレームワーク。 1枚のID画像を参照するだけで、高品質なID固有の人物動画を生成できる」らしいID-Animatorを試してみます。

使用するPCはドスパラさんの「GALLERIA UL9C-R49」。スペックは

・CPU: Intel® Core™ i9-13900HX Processor

・Mem: 64 GB

・GPU: NVIDIA

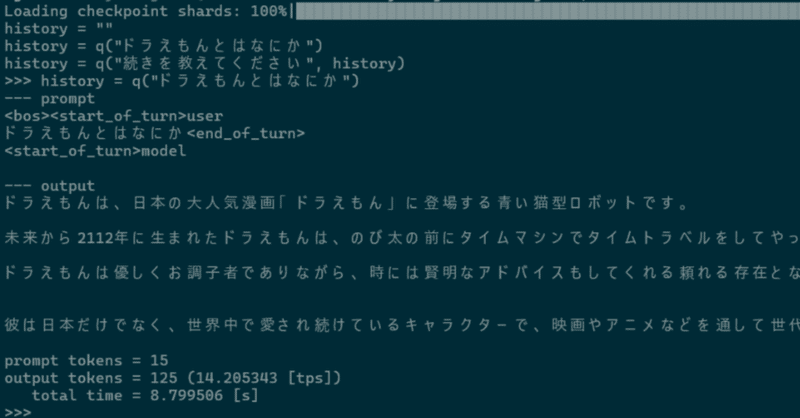

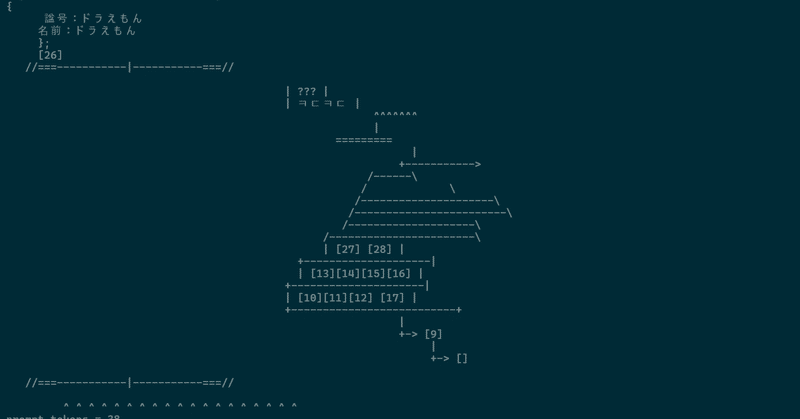

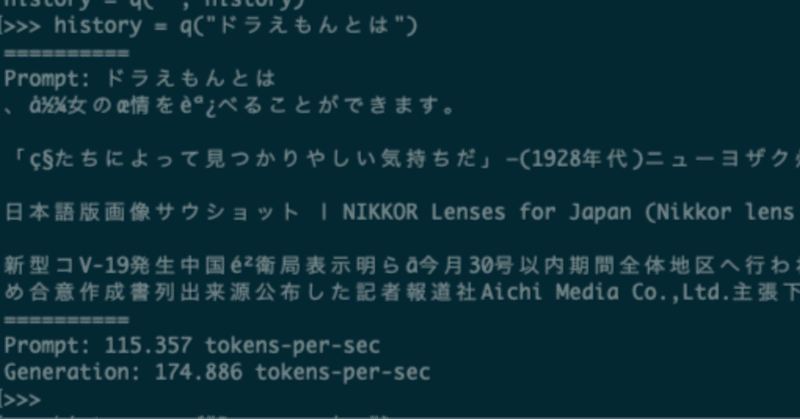

WSL2でFugaku-LLM-13B-instruct-ggufを試してみる

理化学研究所のスーパーコンピュータ「富岳」を用いて学習した、日本語能力に優れた大規模言語モデルFugaku-LLM。今回はそのうちのひとつであるFugaku-LLM-13B-instruct-ggufを試してみます。

使用するPCはドスパラさんの「GALLERIA UL9C-R49」。スペックは

・CPU: Intel® Core™ i9-13900HX Processor

・Mem: 64 G

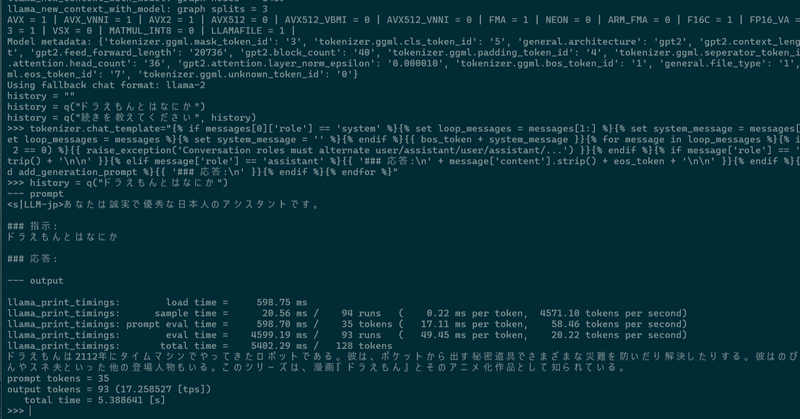

WSL2でFugaku-LLM-13B-instructを試してみる

理化学研究所のスーパーコンピュータ「富岳」を用いて学習した、日本語能力に優れた大規模言語モデルFugaku-LLMを試してみます。

※別記事でggufを試してしまったので、明確にするためにタイトルを「Fugaku-LLM」から「Fugaku-LLM-13B-instruct」に修正しています。

現在3つのモデルが公開されています。

Fugaku-LLM-13B

Fugaku-LLM-13B

MacBook ProでOpenELMを試してみる

Appleが公開した「オープンソースの効率的言語モデルのファミリー」らしいOpenELM。

mlx-lmを使用して、OpenELM-270M-Instructモデルを試してみます。

試したマシンは、MacBook Pro M3 Proチップ、メモリ18GBです。

1. 準備venv構築

python3 -m venv openelmcd $_source bin/activate

パッケー