#ローカルLLM

Llama-3-ELYZA-JP-8Bを雑に触る

Llama-3-ELYZA-JP-8Bについては下記参照。

0. 環境

1. RAGに使用するDBの準備

下記で作成したDBを流用します。

DBの内容は、Google Patentsで「(semiconductor) country:US after:priority:20230101 language:ENGLISH」でヒットした857件の特許のうち、下記記事でFinFETに分類されたもの

[活用例]Local-LLM+Topic model+Langchain+ChromaDB

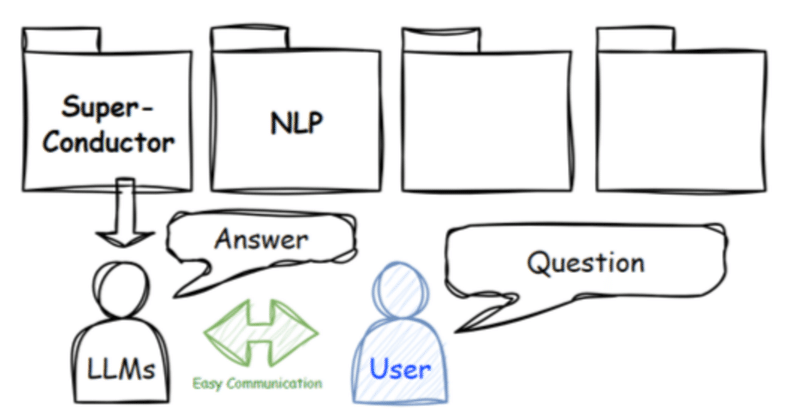

今回は集めた特許データをTopic modelで分類し、分類したtopicごとにChromaDBでデータベースを作成、Langchainを使ってRAGを設定し、Local-LLMに回答してもらうフローを整理しました。

フローは上のイメージ図の通り、下記の手順で進めます。

1. 特許からコンセプトを抽出

2. 抽出したコンセプトを分類

3. トピック毎にデータベースを作成

4. RAGの設定

Starling-RM-7B-alphaとZephyr-7B-betaを簡単に比較

今更ですが、Starling-RM-7B-alphaを試してみました。本モデルの詳細は下記でまとめらています。

ベンチマーク

MT Bench, AlpacaEval, MMLUのいずれでもZephyr-7B-betaを上回ります。私個人としてはAlpacaEvalのscoreが高い方が使い勝手が良いように感じています。

0. 環境

1. arXivから論文取得

"super resol

いつでも手軽に呼び出せる専門家_Local-LLM+RAG活用事例

下記で紹介したLlamaindexのRecursive Retriever + Node Referencesを用いたRAG活用事例です。

専門知識を気軽に活用したくても、大抵、専門知識を持った人材(以下、専門家)は高価で気軽に使えず、課題も多いと思います。

具体的には下記などがあります。

希少で活用頻度が低い

高価で予算が必要

レスポンスが悪い(コミュニケーションに時間を要す)

コミュ

![[活用例]Local-LLM+Topic model+Langchain+ChromaDB](https://assets.st-note.com/production/uploads/images/125226437/rectangle_large_type_2_ffdcc0de4669aecf99c1fb4f9af87c37.png?width=800)