AIの透明性に関する考察・提案とChatGPT

ChatGPTなど生成AIの勃興もあり、AIのガバナンスや倫理的・法的な問題が盛んに議論されています。そのような中で、昨年度、東京大学公共政策大学院の社会人プログラムにおいて、AIの透明性に関する議論を整理し、一つの提案をまとめることができました。今回は、その概要を整理し、ChatGPTに関しても考察を加えてみます。

(論考の日本語本文はこちら・英語はこちら)

3行まとめ

「AIアルゴリズムの透明性」について、体系的整理を行いながら、各国の規制とも平仄の合う開示項目のリストを整理しました

開示項目のリストといっても、裁量的かつ柔軟な運用が可能なように、事業者が使いやすいツールキット型で提案してみました

先行研究が示すところでは、ケース・バイ・ケースで最適な「透明性」のあり方は異なりそうです(特に面白いのは、透明性を高めたからといって信頼度が必ずしも高まるわけではないという示唆があること)

課題意識

課題意識としては、①目的と手段の再確認、②体系的な議論の必要性、③裁量的な透明性の可能性の3点が挙げられます。

①目的と手段の再確認

多くの国がAI開発や利用に関する原則・指針・ガイドラインを発表しており、総務省の資料によれば、「透明性・説明可能性」が9割以上のガイドラインで取り上げられています。

しかし、「AIの透明性」があまりにも強調される結果、それが規制やガバナンスの「目的」と化してしまい、その目的を達成する「手段」にのみ焦点が当たっているような気がしてなりません。「AIの透明性」は「手段」であって、民主主義的価値の優先(人間による意思決定の尊重)、AIとの共存のための信頼構築、利用者の満足度(稚拙なように聞こえて、市場原理ではこれが最も重要な場合がある)など高次の「目的」を達成するための手段として議論すべきではないでしょうか。

②体系的な議論の必要性

AIの発展のスピードと規模は著しく、イシューベースや事件ベースの議論が避けられない状況になっています。

たとえば、有名な食べログ事件(詳細は別の拙稿を参照)では、プラットフォームによるAIアルゴリズムの利用の公正性が問題になりました。この事件を始め、多くのケースでは、AIアルゴリズムの主要なパラメータの開示に主眼が置かれることが多い状況です(EUのP2B規則などの規制もここに大きなフォーカスを置いています)。もちろん、それは重要なファクターですが、AIの透明性の議論がそこにだけフォーカスされると、目的を達成できないケースもあります。

変化の激しい状況でこそ、体系的・俯瞰的な議論に挑戦すべきです。

③裁量的な透明性の可能性

複雑多岐にわたる世界での「透明性」は、常に「ケース・バイ・ケース」です。全ての事象にあてはまる一律の「透明性」は存在せず、手段としての透明性の実現方法に裁量を認めることで、AIによるイノベーションが生み出す正のインパクトを最大化する最適なガバナンスを生み出したいと考えます。

論考の概要

システム全体の透明性

各国の規制や先行研究などを参照しながら、最終的にたどり着いたのは、AIの開発から提供に至るまでのプロセス全体に関する透明性が求められるという点です。

上図はAIの開発プロセスを簡単に図示したものです。

まず、AIのモデルを開発するために、学習データ(Training Data)が必要となります。これをもとにAIはモデルを構築し、そのモデルが実運用に耐えうるかをテストデータで確認を行います。そして実運用にあたっては、実際に当該モデルに入力するインプットとしてのデータ(Operating Data)が入力され、それに基づいて当該モデルが出力(Output)を生み出します。この全ての過程に人間による関与(Human)が含まれます。これらの各要素を横断する思想やデザインを本稿では全体のシステム設計(System)と呼んでいます。

AIと一口に言っても、社会で活用されるAIは、これらの要素が有機的に連携することで成立しているものであり、これらそれぞれの要素について、透明性が実現されるべきと考えます。

ツールキットの提供

上で見た5つの要素それぞれについて、さらに詳細に項目を分類し、「AIの透明性ツールキット」としました。詳細な説明は本文に譲るので、ここでは簡単に内容を説明します。

Data(データ)については、学習データやテストデータの概要の他、公開可能な場合はそのレポジトリの所在、データの入手方法・経路、学習データが社会の多様性を担保するためのポリシー(DEIBポリシーと呼んでいます)などを開示項目としました。最近では、全てのデータセットを公開できずとも、サンプルデータを一定数開示する試みなども目にするところです。

Model(モデル)については、パラメータ(特徴量)や重み付けだけではなく、利用者区分ごとの異なる取り扱いがある場合はその内容(課金により優遇される等を含む)、学習手法、説明可能性、当該モデルの利用フェーズ(研究段階か実運用段階か等)などを開示項目としました。

Output(アウトプット)については、AIが出力する結果の有意確率、誤謬率、偽陰性・偽陽性など、パフォーマンスの制度や限界を開示項目としました。

System(システム)については、AIを利用することによって得られる便益(ベネフィット)や影響(インパクト)のアセスメント、AIが担う役割(生成AIの場合は、当該コンテンツがAIによって生成されたか否か)、全体のリスクに対する管理方法、人間による監査体制やフィードバック方法、教育体制、オプトアウト方法などを開示項目としました。

最後にHuman(人間)の関与について、開発チームの多様性やアウトプットのモニタリング方法などを開示項目としました。

ただし、これらの全ての項目について、全ての事業者が開示することを求めるわけではありません。必要十分な程度の事業者ごとに「裁量的な透明性」の可能性について、以下の視点をもとに検討を加えています。

視点:AIが孕むリスク/ステークホルダー/粒度

AIが組み込まれたシステムやプロダクトに対するガバナンスのあり方は、そのAI利用が孕むリスク、AIをめぐるステークホルダーによって様々です。さらに「透明性」という観点で言えば、説明の「粒度・程度」の視点が重要であることを先行研究が示しています。

一つの参考に過ぎませんが、たとえば、EUのAI規則の4分類に示唆を得ながら、AIについてリスクベースで上記のような分類をした場合に、Tier 1ほど高度な透明性が求められるといえます。

AIを用いる主体によっても、求められる透明性は高まります。特に、公的機関がその業務でAIを用いる場合、影響を受けるのは行政サービスの対象としての市民であり、当該AIの利用については高度な情報の透明性が求められます。また、ある市場において支配的な地位を有する巨大なプラットフォーム事業者についても、その取引の公正性を担保するために高い透明性が求められるといえるでしょう。

さらに、開示された結果を確認する読み手の観点も重要です。上図はステークホルダー別に透明性の理解や必要性、用途は全く異なることを示唆する先行研究を示しており、読み手に応じた説明方法が個別に選択されるべきことを示唆します。

最後の視点として、透明性の「粒度・程度」が挙げられます。研究者の中には、透明性を高めること自体に意義がない、あるいは有害でさえあるという批判も存在しますが、その強い根拠の一つは開示事項に対する利用者の理解に限界があることです。曖昧すぎる記載やあえて詳細をはぐらかしたような説明は、透明性が目指す信頼獲得や理解の向上には全く資しません。一方、詳細に開示したからこれらが実現するかといえば利用者の理解に限界がある以上、これも首肯できません。しかし、AIアルゴリズムの透明性の粒度・程度に関する複数の先行研究を整理した上図の表には、現実的な可能性への示唆が存在します。

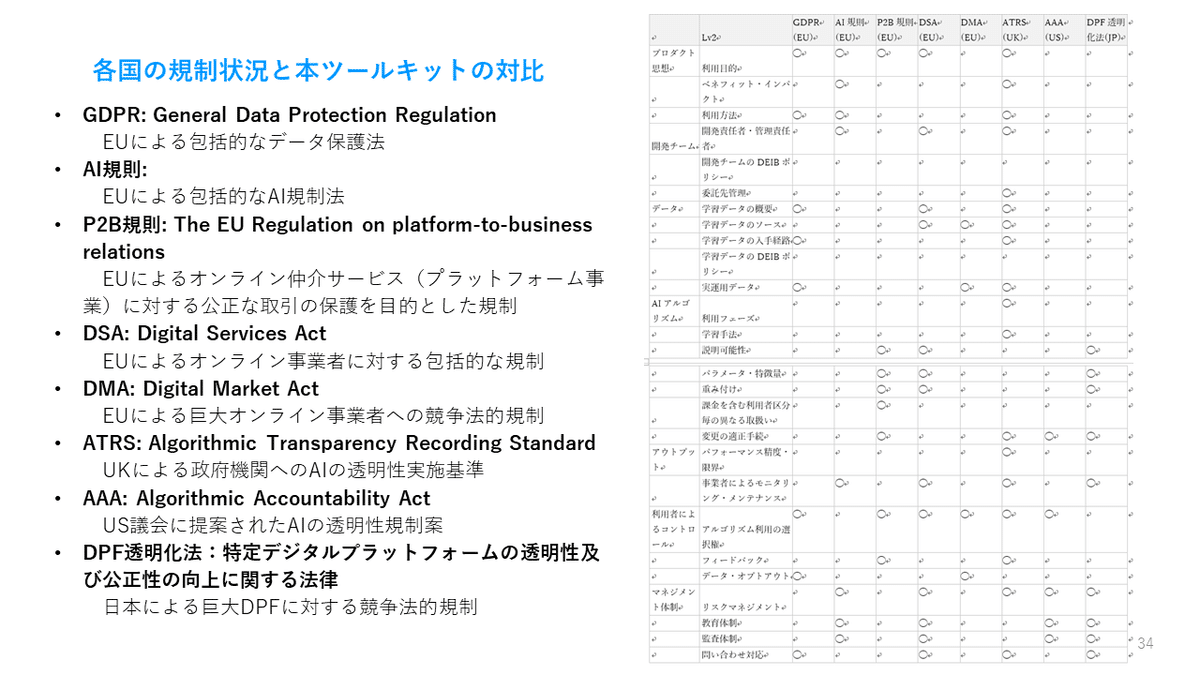

各国の規制との整合性

AIアルゴリズムをめぐる各国の規制は、特にGDPR、P2B規則、AI規則、DSA、DMAといった規則等でEUが先んじて議論や導入を進めています。AIと人間社会の共存を図る上で、EUがいかに人権や民主主義といった価値観を重要視しているかが見て取れます。

それぞれの規制について本稿でその詳細な説明は避けますが、各国の規制状況と本ツールキットの対比表を上図のように作成してみました。もちろん法令毎に規制の対象も異なれば規制の内容も様々であるため、対比表は個別の法律・法案の解釈を説明するものではなく、大雑把にそれぞれの法律・法案がどういった項目について関心を有するかを示したに過ぎない点にご留意ください。

開示例(架空事例とChatGPTの事例)

架空事例:政府が補助金審査業務にAIを用いる場合

架空事例ではありますが、たとえば政府が大量の補助金審査業務(新型コロナウイルス蔓延による事業者や個人への給付金の審査などが典型である)の処理にAIを用いるとしてみましょう。このユースケースでは、AIアルゴリズムの透明性を実現するにあたって、以下のような点が考慮要素となり、開示の項目、方法、程度はそれらに鑑みた対応でなければなりません。

(1)主体:

政府機関であり、透明性が強く求められる。

(2)AIの利用によるリスク・影響:

利用者に経済的影響(補助金申請の可否)を及ぼす。

(3)情報の受け手:

広く国民一般であり、そのリテラシーには幅広い差異がある。

このようなケースでは、高い透明性が求められるため開示事項は多岐にわたる一方、影響を受ける国民広く一般が理解可能な粒度に情報の開示方法を工夫する必要があります。簡単に、以下に開示例を記載してみました。(決して理想的な事例を記載しているわけではなく、説明の便宜のためあえて注意が必要な記載をしている箇所もある点に留意が必要です。)

ChatGPT(OpenAI)の透明性

話題のChatGPTの透明性の取り組みについても参考までに見ておきましょう。

データの収集方法及び学習手法の明示:ChatGPTのモデルは強化学習を用いて訓練されていることとそのための学習データの収集方法がWebサイト上で説明されています。また参照すべき論文へのリファレンスも存在します。

アウトプットの精度・限界に関する言及:ChatGPTの出力に対する限界についてその理由とともに言及されています。

モデレーション手法とその限界:ChatGPTの出力に対するモデレーション方法とその限界が説明されています。モデレーションAPIのための評価データセットも公開されています。

フィードバックの手法:ユーザによるフィードバックの方法が案内されています。

全体的な安全性設計:Developing safe & responsible AIやProduct safety standardsの項目において会社全体の安全管理措置の内容が開示されています。

こう見ると、いくつかの項目については詳細な記載もあり、意外にも開示項目は広く、開示方法も丁寧なものが少なくありません。一方、何が足りないのかを考える際には、上記のツールキットは体系的な理解の手助けになると考えます。たとえば、学習データの適法な収集方法やデータからのオプトアウト方法についてはより明示的な情報があってもよいのではないでしょうか。またアウトプットの精度については、ユーザのリテラシーに応じて、誤謬率や限界の明確な説明を加えても良いかもしれません。

懸念されるのは、OpenAIの提供するモデルやChatGPTを組み込む別のサービスが、その透明性を維持できるかという点です。ユーザからすれば、インターフェースとして利用するプロダクトにおいて、一定の透明性が担保されておく必要があります。その観点からも市場の動向を見守ってみたいと考えています。

まとめ

(論考本文から抜粋)

本稿は、AIアルゴリズムの透明性という最も議論が盛んなガバナンスの手法について、俯瞰的、体系的な整理に挑戦し、実務に耐えうるツールキットを提案しました。イノベーティブなAIが不完全なコミュニケーションに起因する誤解によって社会実装を阻害される不幸は回避されるべきであり、そのために透明性が果たすことのできる役割は小さくありません。ただし、体系的な整理がない中で、イノベーションが種々の問題を引き起こす度に規制や規範が形成されることは、設計図のない建物の増築が繰り返されるようなものであり、予見可能性を欠くとともに、本来の目的を離れた形式だけの「透明性」が自己目的化していきかねません。そのような状況では、イノベーションは阻害されていくでしょう。このような状況を避けるためには、アルゴリズムの透明性に関するルールについて、統一的な考え方のもとに体系的に整理されていることと、事業者が実運用しやすい汎用性、明瞭さ、裁量の余地がある柔軟性が追求されなければなりません。

本稿では、各国当局による規制案のみならず、様々なAIによって生じる新たなリスク事象を幅広く考慮し、さらにはAIアルゴリズムに関する先行研究を踏まえながら、体系的な開示事項・事例集としてのツールキットを構築しました。また、事業者が透明性の程度を工夫することで、社会における信頼性のみならず満足度など異なる指標にも良い影響が与えられる観点を取り込んでいます。加えて、開示事項をリスト形式にし、それをAIアルゴリズムの提供者、利用者、リスクなどの観点から裁量的な選択性とするなど、自主・共同規制に対応する事業者にとって利便性の高いツールキットとなることを目指しました。事業者が、利用者や社会、当局、専門家らとのコミュニケーションのツールとして、あるいは社内のリスクマネジメントツールとして、本ツールキットを利用していただくことができれば、これほど嬉しいことはありません。それがAIによるイノベーションのインパクト最大化に繋がる最適なアジャイル・ガバナンスの一つだと信じています。

図書館が無料であるように、自分の記事は無料で全ての方に開放したいと考えています(一部クラウドファンディングのリターン等を除きます)。しかし、価値のある記事だと感じてくださった方が任意でサポートをしてくださることがあり、そのような言論空間があることに頭が上がりません。