よりよいビジネス、社会、未来を作る人間参加型(Human-in-the-loop)AI

本記事は、人間参加型(Human-in-the-loop) AIについての記事です。

人間参加型(Human-in-the-loop)AI

今年2月、イベント「Future of AI ~最先端AIが拓くビジネスの未来~」にて、株式会社シナモン 執行役員会長 加治慶光氏、株式会社ソニーコンピュータサイエンス研究所 代表取締役社長 北野宏明氏、株式会社シナモン 代表取締役社長 平野未来氏と一緒に、AIと人間の共存・協調、さらなる可能性について議論をさせていただきました。

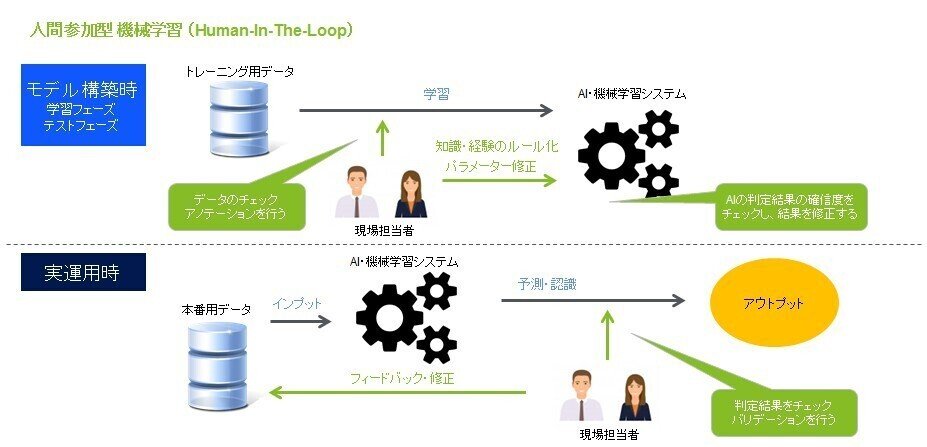

そこで、取り上げた重要な概念の一つが「Human-in-the-loop」です。Human-in-the-loop または HITLとは、機械学習モデルを作成するための人工知能の一分野です。日本語では、人間参加型AIとも呼ばれます。

HITLを取り入れた機械学習とは、人間による洞察と機械学習による学習を組み合わせて、効果的な機械学習モデルを生成することです。つまり、人間の知性とAIを融合し、認識、分類、予測等のアプリケーションにおいて、人間だけ、AIだけというどちらか一方だけのパフォーマンスよりも優れた結果を得る方法とも言えます。伝統的なHITLのアプローチでは、エキスパートを機械学習のモデル構築のプロセスに積極的に関与させ、モデルをトレーニングし、検証し、テストするという各ステップをより効果的に行います。パフォーマンスという言葉を使いましたが、パフォーマンスが何を意味するかは、アプリケーションに何をやらせたいかによって異なります。パフォーマンスは、時には正確さ、時には安定性、時にはバイアスの除去を意味します。どのパフォーマンスを改善したいかによって、様々なアプローチがあります。

HITLのステップ

基本的なHITL のステップは以下のようにシンプルに考えることができます。

まず、人間がデータに注釈(アノテーション)やラベルをつけます。(場合によっては、データオーグメンテーションのテクニックを使ってもいいでしょう。) これにより、モデルを高品質の、そして大量の学習データを使って学習することを目指します。機械学習アルゴリズムは、これら整備されたデータから学習して、正確な認識・分類・予測を行うようになります。

次に、人間がモデルを、必要となる本番環境においてパフォーマンスが適切に発揮出るように考慮して調整をしていきます。これにはいくつかの方法がありますが、一般的には過学習へとつながりうるデータを除去したり、重み付けを変更してサイド学習したり、境界領域の判定を識別して、モデルが認識したり、分類したりするカテゴリを修正したりします。

最後に、特にモデルがその認識・分類・予測に確信を持っていない場合や、不正確な判断に過度に自信を持っている場合に、その出力の確信度をスコアリングし、人間による確認を行います。そうすることで、モデルを別の角度からテストし、検証することができます。人間の判断もあわせて入れていくことで、モデルをより高い精度を得るようチューニングしていくことができるわけです。

一見、以前記事に書きました集合学習(ensemble learning)のやり方と似ているように見えます。集合学習と比較した場合の違いは、HITLでは、ドメイン知識を積極的に使っていくことが多いということです。

その意味で、HITLのアプローチは、アルゴリズムが最も効率的な方法でデータを扱えるようになるまでデータのサンプリングを繰り返す半教師あり学習によく似ています。

HITL の目標は、機械学習アルゴリズムが、訓練データセットに含まれていなかった、新しいデータが現れたときにも、適切な判断が下せるようになることです。つまり、モデルの頑健性(ロバストネス)を高めるということでもあります。

人のメインの役割について

HITLにおける人間のメインの役割は、学習フェーズの後の「テストフェーズ」で、モデルが導き出した誤った結果を修正することです。ここでは、人間は機械学習アルゴリズムが判断に自信をもっていない結果を修正することにフォーカスします。確信度の低いデータを人間がハンドルしていき、アルゴリズムにフィードバックするプロセスは、特に能動学習(Active Learning)と呼ばれることがあります。(言い換えると、HITL は、アノテーション・ラベリング・データオーグメンテーションに、能動学習が組み合わさったものと言うこともできます。)

AIが誤った結果にあまりにも高い確信を持っている場合も修正が必要です。確信度と結果のバランスを意識しながら、テストフェーズにおいては、より良い判断ができるようにAIに学習させ、人間が介入しなくても正しい結果が得られるように導いていきます。

学習フェーズやテストフェーズだけではなく、実運用フェーズにおいての役割もあります。AIモデルに全てを自動的に処理させてしまうのではなく、人間がチェックし、バリデーションを行うというものです。これは、AIによる自動意思決定にリスクが認められる場合において重要な人間の役割になります。

活用例

HILTを使い始めている企業もあります。日本のC2Cコマース大手のメルカリは、不正出品の検知にHITLの枠組みを実装しています。

一般的に、HITLは以下のような場合に適しています。

・自然言語処理、コンピュータビジョン、センチメント分析等のモデリングで多くのデータにアノテーションを付ける必要がある場合

・利用可能なデータが少ないため、データセットを作成する必要がある場合

・大量のデータを処理する必要がある中、その一部のデータにクオリティの高いラベル付きデータが存在する場合

・既存のAIモデルを特殊な要件に合わせてチューニングする必要がある場合

・モデルによる誤判断のコストが高く、エラーを最小限に抑えたい場合

・膨大なデータの中から特定の対象を見つける必要がある場合

現在利用可能なデータが不足している場合、人間は一般的にAIよりも優れた意思決定を行います。ある程度のトレーニングとテストデータが利用可能になった後は、AIは人間よりも優れた判断をするようになるので、HITLはその状態を目指すために用います。

モデルによる誤判断のコストが高いときとは、例えば、AIによる診療、検査の必要性の判断、治療方針の予測、治療判断、等です。検査も侵襲性の高い検査が要する判断であれば、エラーの影響は看過できないものになります。ですが、AI による画僧認識が、人間の医者が見過ごしてしまう症状を発見することも確かです。そこで、AI モデルの精度改善にHITLを用いていくことが大切になります。

AIと人間のコラボレーションは大きな可能性を秘めています。膨大な数の画像の中から特定の犬の画像を探すような、非常に多様なデータの中から特定の対象を探す場合に非常に役立ちます。そのような状況でも、AIは、そもそも犬ではない、犬であってもあきらかに探している対象の犬ではない画像を素早く確信度高く除外することができます。そのように膨大な画像の中から対象を絞り込むことで、多くの時間とコストを節約することができるわけです。そして最終的には、似たような犬の画像の中から目的の犬を選択するタスクを人間が行うことで、迅速に目標に到達します。

人のリーダーシップで、AIを導く

コラボレーションは重要です。しかし、それ以上に重要なのは、AIを導く人間のリーダーシップです。AIはあらゆる産業の本質を変えようとしていますが、特に訓練データを生成して機械学習アルゴリズムに送り込む初期段階では、人間の価値を反映させた人間によるガイドが必要なことに変わりはありません。このことについては、需要予測の記事で書いたことがあります。

また、人とAIが共に成長するビジネスモデルの説明のときにも、同様のことを述べました。

複雑に変化するビジネス環境の中で、AIモデルが適切な精度を維持し続けるかどうかは非常に重要であり、そのパフォーマンスは人間によって評価されます。一般的に、開発したAIがビジネスプロセス(需要計画など)を支援する場合、特に企業内のコアバリューやコンプライアンスを考慮する必要があるAIの開発においては、人間の洞察力の反映は不可欠といえます。

AIの発展とその影響範囲の拡大により、我々が持っている価値観は近年再定義が必要になっています。そのような要請に伴う、社会における人権の考え方や倫理観の変化、企業におけるコンプライアンス強化の動向やポリシーの変更によるコンセプト・ドリフトに対応するためには、人間の洞察をいかにAIに継続的に反映させていくかの仕組みづくりも不可欠になってきています。そのためには、HITLを実装し、MLOpsの採用も含め、開発プロセスに様々な専門家を積極的に関与させていくことが大切です。

HITLは、単にAIのパフォーマンスを高めていくという観点をこえて、今後のよりよい社会を目指す方法に関するヒントとなります。実際、社会全体のAIシステムの在り方について、HITLの概念を拡張させた、Society-in-the-loop についても議論されています。人間の洞察力をもって、AI にリーダーシップを発揮し、その適切な活用を導いていくこの手法は、よりよい未来を計画し、作り上げていくことを目指します。ビジネスにおいても、社会においても、今後長くに渡って重要な潮流となるでしょう。

この記事が気に入ったらサポートをしてみませんか?