Canonの最新VRレンズを遊び倒す!アイデアノート Vol.1【Dentsu Lab Tokyo】

こんにちは。Dentsu Lab Tokyo クリエーティブテクノロジストの九鬼です。

日々テクノロジーを使った企画を立てたり、そのプロトタイピングや実装をしたりしています。

今回のnoteは興味のあることをテーマに、ということで最近試しているVR実写動画の撮影と編集について書いてみました。

![]()

2021年末にCanonより8K・3D・180°VR映像が撮影できるレンズが発売されました。ミラーレス一眼カメラ EOS R5の交換レンズ RF5.2mm F2.8 L DUAL FISHEYEです。2つの魚眼レンズによって人間が両目で物を見るときとのような視差を再現し、立体視を実現します。

Dentsu Lab Tokyoでもこちらのレンズを購入し、一月ほど有志メンバーで様々な使い方を試していました。

この記事は、その過程で制作したVR映像演出のプロトタイプの紹介第一弾です。また、記事の最後にVR動画の書き出し手順について記載しています。

1. 3D VR動画って?

「VR動画」と一般的に呼ばれている動画には大きく二種類あります。

・360º動画:周囲360度を見渡すことができる動画。

・3D 180ºVR動画:前方180度が見渡せ、かつ立体的に見える動画。

それぞれの動画を見比べてみましょう。

記事中の動画の多くは3D VR動画ですので、ヘッドマウントディスプレイ(HMD)での視聴をおすすめします。こちらのプレイリストに記事中のすべての動画を格納しています。

※ Oculus Quest2で視聴する場合、アプリ版YouTubeからのみ3Dで視聴可能です。(ブラウザ版YouTubeでは正常に再生できません。)

こちらが360°動画。

こちらがこのレンズで撮れる3D VR動画です。

いかがでしょう。

360°動画が自分の周りのスクリーンに映像が投影されているように見えるのに対し、3D VR動画では自分が実際にそこにいるかのような臨場感を感じませんか。

このような高画質な3D VR映像が、ミラーレスの交換レンズで撮影できるようになったことは、大きな転換点だと思います。

RICOH THETAやinsta 360の登場によって360度動画がスポーツやレジャーの記録メディアとして広く普及したように、このレンズの登場が3D VR実写映像が一般に普及する幕開けになるかもしれません。(もちろん立体視を再生できるデバイスの普及も待たなければいけないのですが。)

1. レンズを使って撮影してみて

8K・3Dの180°VR動画がミラーレス一眼カメラ(EOS R5)で撮れてしまうことが、このレンズのすごいところです。それに加えて、使ってみて魅力的に感じるのが、VR映像として出力するワークフローが極めて簡潔なことです。

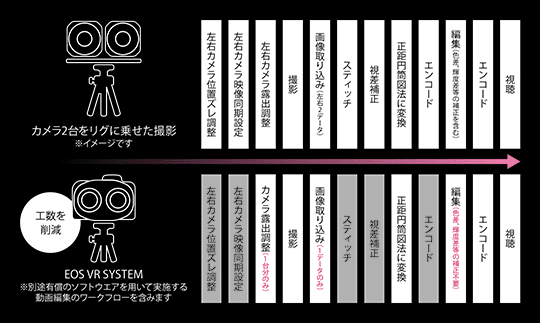

これまで高画質なVR撮影をするためには高額な専用機材を導入するか、カメラを2台使うかしかありませんでした。

カメラを2台使うと編集がそれはそれは面倒でした。左右で微妙にピントが合ってなかったり、正面方向がちょっとずれていたり、右と左のファイルの対応がぐちゃぐちゃになってしまったり...

EOS VR SYSTEMによって面倒な工程が大幅に削減され、ほぼ自動的にVR動画として書き出せるようになっています。ありがたい...

(公式ページより)

撮って、取り込んで、自動変換をかけるだけで、以下のような3D VR動画を制作することができます。

使ってみて、立体的に感じられる距離が意外と近いなと思いました。公式には50cm~2m程度とありますが、実際には1mくらいまでかなという印象です。50cm以下だと立体物としては認識しにくいですが、目の前にあるように感じられて迫力があります。2Dの360º動画では表現できない感覚ですね。

2. VR映像演出のプロトタイプ

手軽に撮影できるようになって、VR映像コンテンツが増えてくれば、今より凝ったコンテンツが作られていくでしょう。現状の3D VRコンテンツの多くはカットかフェード程度の編集しか施されていませんが、VR映像ならではの演出・エフェクトの形があると考えています。

2.1 2D映像演出の3D化

まず2Dの既存の演出を3Dに拡張してみました。手法としてはありふれたものでも、空間的な広がりを持つことで新しい見え方になりえます。

2.1.1 コマ撮り

立体物が勝手に動いているように見えてアニマシーを感じました。

2.1.2 タイムラプス

立体感を感じる上で近景の方が適している一方で、遠景でないと動きが早すぎるため、相性がいまいち悪い印象です。例えば、時計職人の手元で時計が組み上がっていく過程をタイムラプス撮影する、みたいなことの方が合うかもしれません。

2.2 実写合成

3D実写と3DCGを合成してみるテストです。

※酔いやすい映像になってしまいました。すみません。苦手な方はご注意ください。

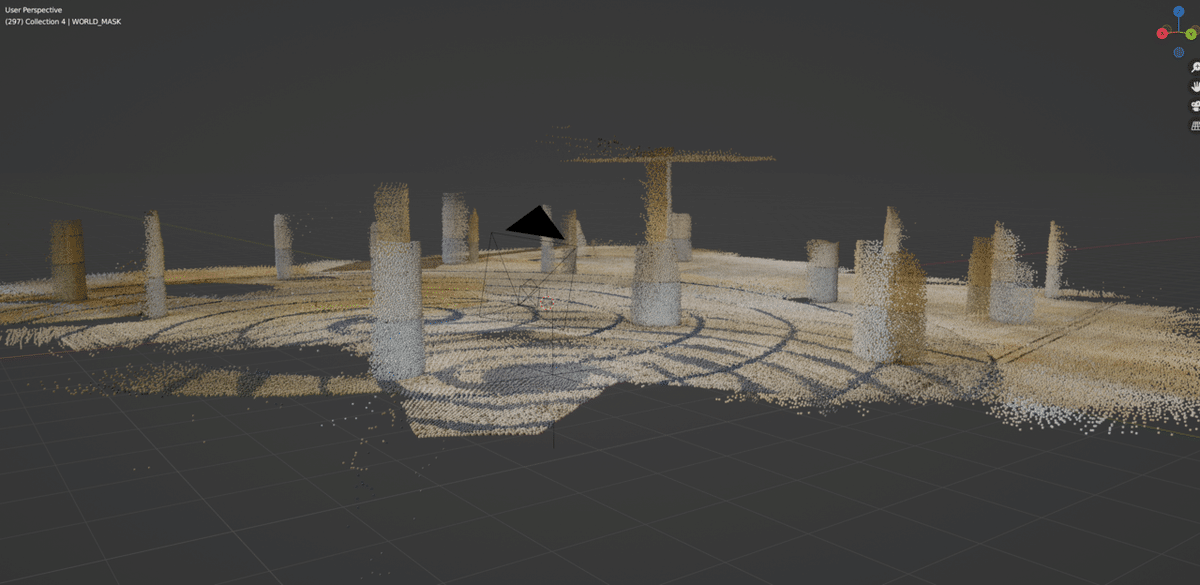

カメラトラッキングはiPhoneのCamTrackARで行い、BlenderでCGを作成しています。iPhoneの固定が甘くてトラッキングが揺れてますね...

撮影時の様子。いきものみたいでかわいい

撮影時の周囲の地形をスキャンしておきました。

3DVR動画に生っぽさ・臨場感がある分、CGの異物感がおもしろいなと思いました。電脳コイルの世界はこんな感じに見えているんでしょうか。

あまりCGが強すぎると実写の良さが薄れていくので、塩梅が大切かもしれません。

2.3 インタラクティブな視聴体験

Oculus Link を経由して、TouchDesignerでリアルタイムに生成した映像を鑑賞するテストです。

見ている方向に応じてエフェクトを変化させることで、映像に介入するインタラクティブな鑑賞体験を作れそうな予感がしています。

動画として書き出せないので、体験の様子のキャプチャを載せます。

注視領域のみ元の動画を、それ以外の部分では映像を線画に変換したテストです。空間にエフェクトがかかっているように感じられて、なかなか不思議な感覚です。

見る方向によって見えるものが変化し、ストーリーが分岐する短編動画、とか作れそうですね。

正確には、見ている対象物まで距離に応じて、左右の映像でエフェクトをかける座標を変化させる必要があります。

たとえば、近い場所を見ているならそれぞれ鼻側に中心に寄せる、遠い場所なら画面中央に寄せる、などです。それをしないと見ているものとエフェクトの焦点が合わず、酔いそうな映像になってしまいます。

が、今回はテストなので周りをぼかしてごまかしました。

![]()

まとめ

左右の目に破綻なく演出を乗せる必要があるので、2D動画に比べるとかなり制約が厳しいですが、それでも可能性はかなりありそうでした。左右の画像からデプスを推定し、それをもとにエフェクトをかける、みたいなことも今後試してみようと思っています。

また、編集方法についても高速化を図りたいところです。HMDを被らないと確認ができないうえに、8Kの高解像度での編集や書き出し処理に時間がかかるため、イテレーションを回しにくいと感じました。

UnityやTouchDesignerを使って高速に検証できるシステムを組みたいと思っています。理想はVR内でVR動画の編集ができるようになることですかね。

引き続き、3D VR動画の表現を探っていこうと思います。

Vol.2もお楽しみに!

![]()

以下、おまけのVR映像書き出し手順書です。

Appendix: VR映像書き出し手順書(RF5.2mm F2.8 L DUAL FISHEY)

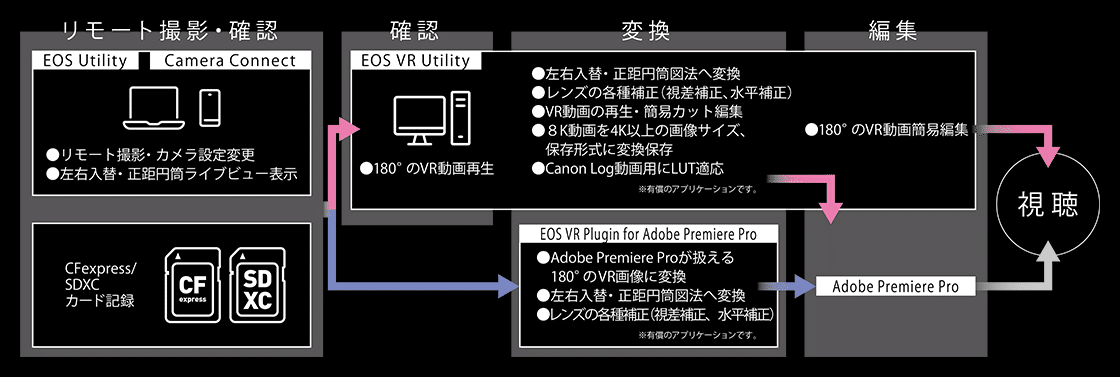

EOS VR SYSTEMによる撮影からVR動画書き出しまでの流れを説明します。

公式ページに載っている通りではあるのですが、まだレンズの使用に関する記事が少なく、個人的に詰まった部分もあったので記録として公開します。

(公式ページより)

0. 撮影の前に

EOS R5のファームウェアが最新状態(1.5.0~)であることを確認します。

ファームウェアが対応したバージョンでなくても撮影自体はできてしまうのですが、この後の工程でVR形式に変換することができません。

僕はこの確認を怠ったために半日無駄にしました。愚か。

※ちなみに、ファームウェアが対応していないと、レンズを取り付けた際にアラートが出ます。なぜ気が付かなかったのか。

1. 撮影する

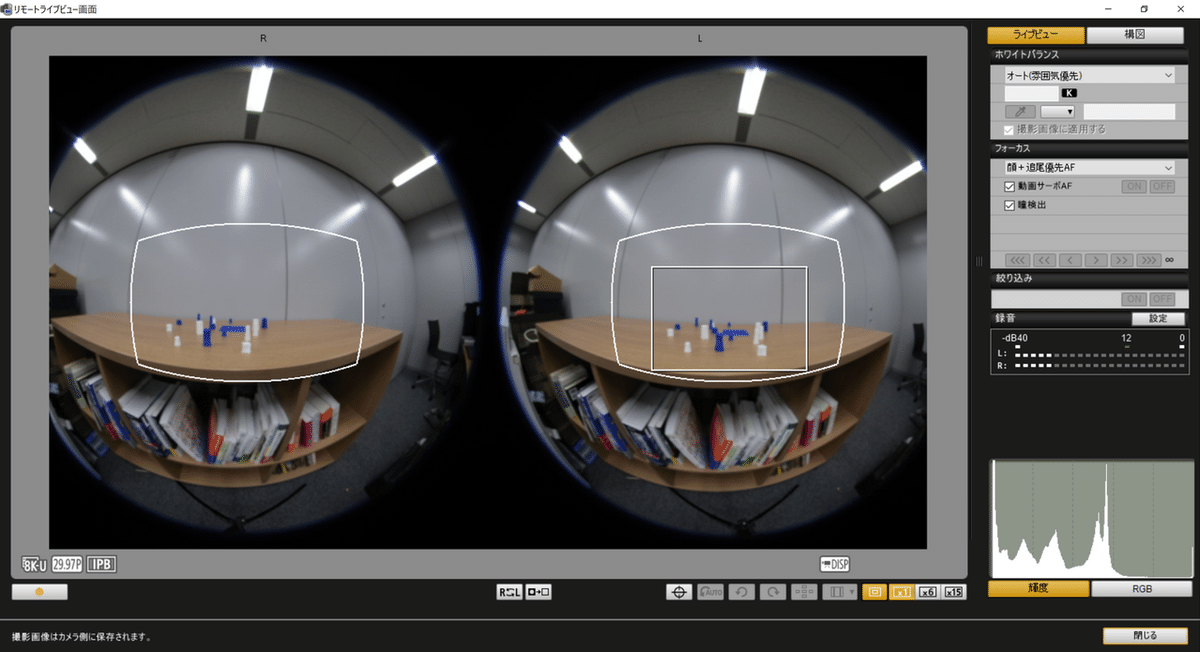

通常の撮影よりも被写体が小さく映るため、ピントが合っているか確認するのに気を使う必要があります。MFピーキングを有効にしたうえで拡大表示するとわかりやすいです。

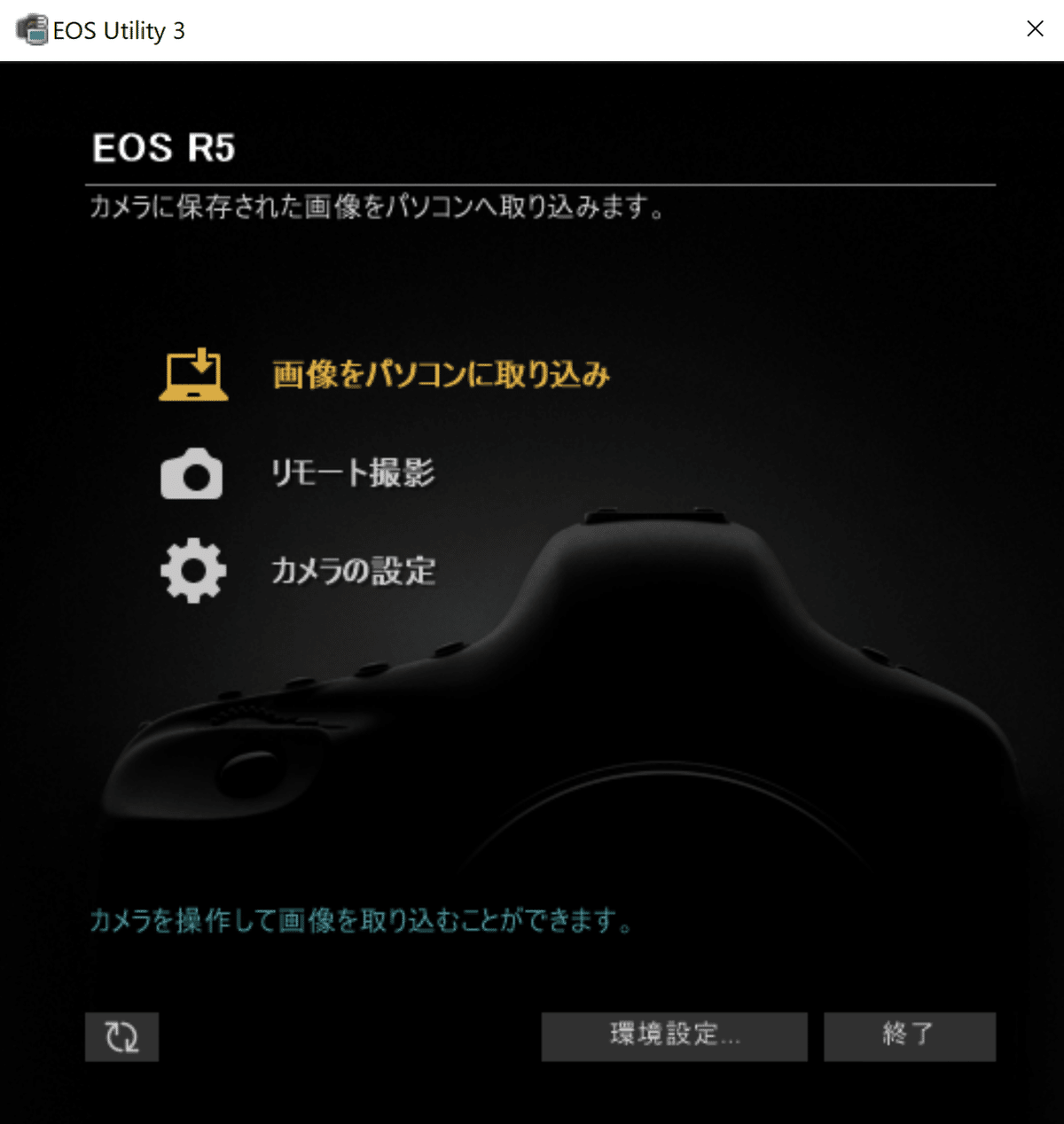

EOS Utilityを使えばPCのディスプレイで確認しながら撮影できます。

EOS Utilityの画面

拡大すると全然ピントが合っていない

2. データを取り込む

EOS Utilityで撮影データを取り込みます。

3. VR動画に変換する

EOS VR Utilityまたは、Adobe Premiereのプラグイン「EOS VR Plugin for Adobe Premiere Pro」で撮影データをVR動画に変換します。どちらも有償ですが、2分以内の動画であれば無償で変換できます。

以下はPremiereプラグインの説明です。

Premiereの場合、プラグインを導入した状態でプロジェクトに撮影ファイルを読み込んだ時点で自動的に変換がなされます。

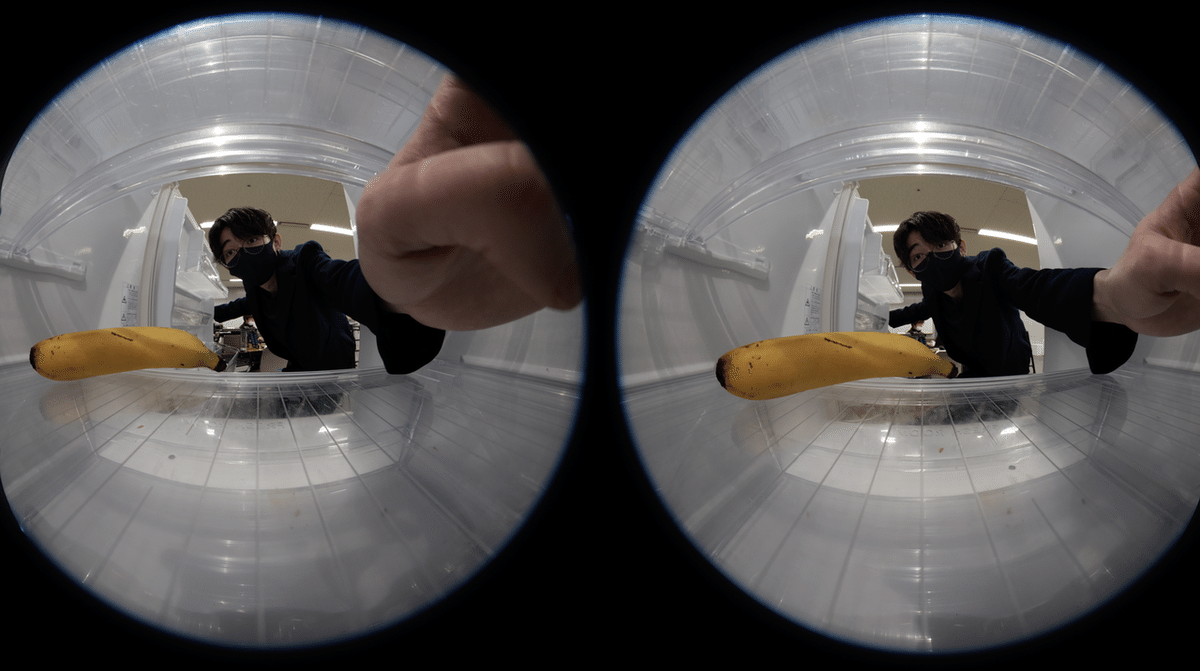

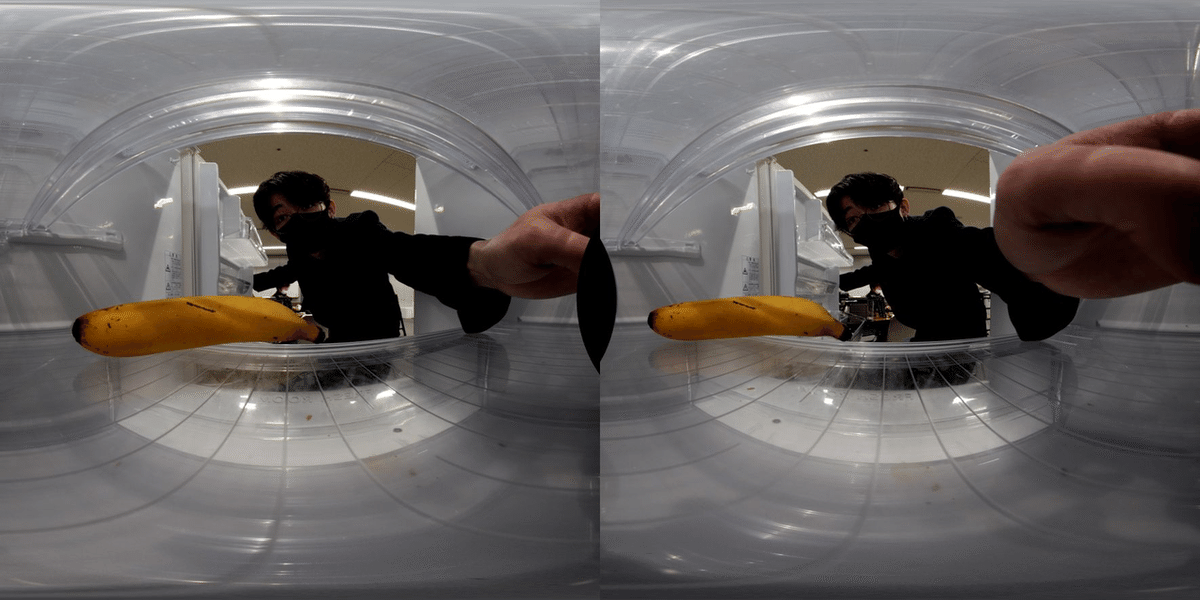

撮影素材

自動変換後:左右を入れ替えて、正距円筒図法に変換

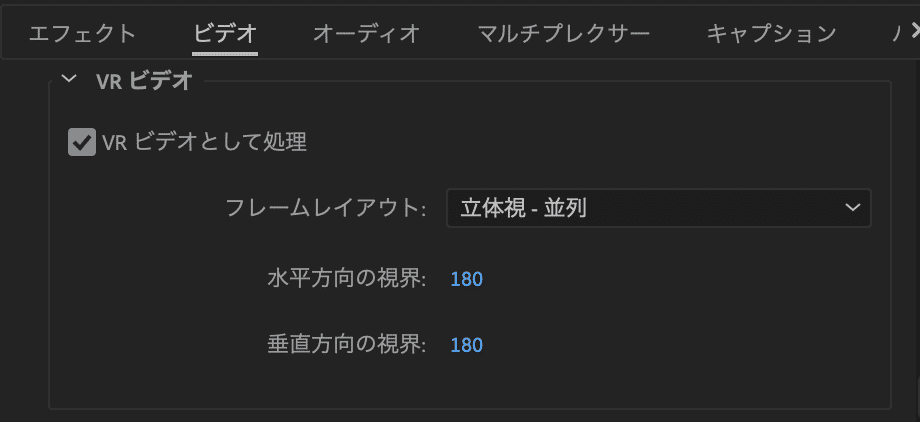

書き出す際には形式をH.264に設定し、VR形式を以下のように設定します。

これで書き出せば完了です。

YouTubeにアップロードすると自動的にVR動画として処理され、10分~1時間ほど待つと視聴できるようになります。ローカルで手早く確認したいときは、Quest2に直接動画データを入れてました。

![]()

以上、RF5.2mm F2.8 L DUAL FISHEYでVR動画を書き出す手順書でした。

九鬼 慧太 Keita Kuki

Creative Technologist

単純なルールから複雑な見た目を作り出すジェネラティブアートに惹かれプログラミングを始める。大学院ではHCI(ヒューマン・コンピュータ・インタラクション)を専攻。Unity, TouchDesignerによるリアルタイムCGの生成が得意。五感をハックした新感覚の体験を作りたい。

---------

Dentsu Lab Tokyoは、研究・企画・開発が一体となったクリエーティブのR&D組織です。メンバーはコピーライター、プランナー、アートディレクター、テクノロジスト、映像ディレクターなど、さまざまな職能をもった人たちです。日々自主開発からクライアントワークまで、幅広い領域のプロジェクトに取り組んでいます。是非サイトにもお越しいただき、私たちの活動に触れていただけると幸いです。

このnoteでは、Dentsu Lab Tokyoのメンバーのご紹介、制作の裏話、イベントのレポートなどをお届けできればと思っています。

今回は個性豊かなメンバーが、興味があることや好きなことを執筆する連載をお送りしています。多種多様な集団の頭の中を、ちょっと覗いてみてください!

この記事が気に入ったらサポートをしてみませんか?