生成AIによるJ-POPアイドルのミュージックビデオ制作〜プロンプトを書かないことで実現した[15]動画生成AIで自主映画制作は可能か? - Blog 2024/06/09

「動画生成AIで自主映画制作は可能か?」シリーズの第15回目です。

前回が3月5日ですから、3か月ぶりの投稿になります。

この3か月で動画生成AIの技術は大幅に進化しており、ワークフローも様変わりしています。

生成AIのサービスは仕様変更や機能追加、機能改善が頻繁に実施されるため、記事化するモチベーションを維持するのはかなり難しいですね(執筆中に情報が古くなることもあります)。しかも、常に上書きされていく技術なので、過去記事のアーカイブとしての価値も低く、時間をかけてドキュメントにする意味を見出せなかったのです。

情報発信はライブ配信で!

このような状況を考慮し、4月からは「ライブ配信」が情報発信の中心になっています。メインのCreative.Edge Liveはすでに18回配信しており、来週の火曜日(11日)の夜に第19回目のライブ配信を予定しています。

現在の情報発信:

noteの投稿ページにVimeoライブを埋め込んでいますので、配信時間になれば誰でも自由に視聴できます。Xなどでも同時配信していますが、アーカイブは残りません(賞味期限が短いので、混乱を招かないようにアーカイブは一般公開しない方針です)。

一期一会のライブ配信となっていますが、復習目的で再配信することがあります。

メインは「Creative.Edge Live」のライブ配信

ほぼ毎週配信/アーカイブなし生成AIとクリエイティブを扱う雑談系の「深夜ラジオ」のライブ配信

ほぼ毎週配信/アーカイブなし高校講座(現在は高校生向けAdobe Firefly)のライブ配信

隔週配信/アーカイブあり。高校生の復習用として各回のアーカイブはnoteのページで視聴可能

配信後に(期間限定で)誰でも自由にダウンロードできるようにしている

X (旧Twitter)に関しては、キーパーソンの方々があまり投稿しなくなり、結果的に私も利用頻度が低下しています(最新情報はライブ配信やnoteで発信しています)。

また、生成AIの情報収集は、Podcastや各々のDiscord、Slackグループが中心になっています。

この3か月で変わったこと

最も顕著なのは、画像生成・動画生成の方法。

簡潔に言うと「プロンプト入力を避ける」ということ。

ビジュアルイメージを言葉で表現するという曖昧かつ偶然性に依存したやり方を続けるかぎり、作品は完成しません。

考えてみれば当たり前のことですが、実際に大量のコンテンツ制作を実践することで「プロンプト入力による画像生成、動画生成は映画制作等には適さない」ということを実感しました。

LLMやイラスト生成とは異なり、脚本や絵コンテどおりに画像や動画を生成していくには「可能な限りプロンプト入力をしない」手法が求められます。

わかりやすい例は、(言葉ではなく画像で指示する)リファレンス機能です。

思いどおりのポーズを生成できるようになった

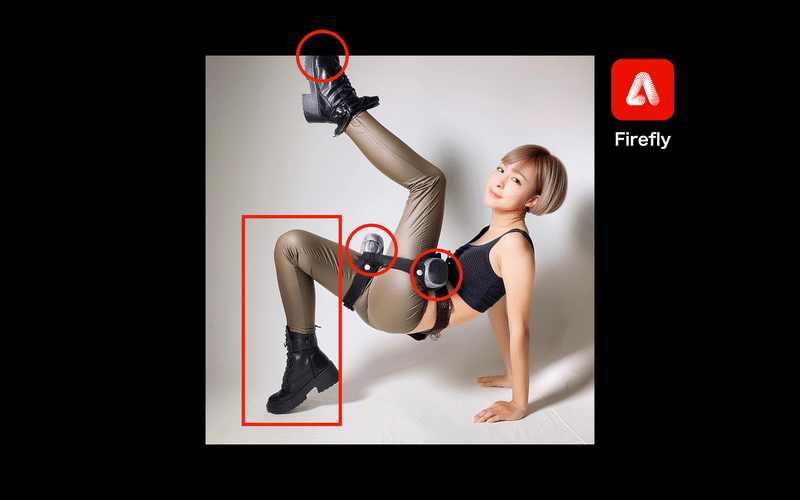

Adobe Firefly に実装された「Structure Reference(構成参照)」を使用すると、アップロードした画像の「構図」や「オブジェクトの位置、サイズ」などを参照して生成することができます。

キャラクターのスタイルやファッションなどは、Style Reference(スタイル参照)を使用すれば表現可能。

Structure Referenceを使用すれば生成できる

Structure Referenceを使用すれば生成できる

複雑なポーズも表現できる

ほぼ同一の人物を簡単に生成できるようになった

Midjourney V6の「Character Reference」を使用すれば、ほぼ同一の人物を生成できます。この機能の実装によって、過去のプロンプトテクニックは全て不要になりました。

過去のプロンプトテクニックは全て不要になってしまった

Adobe Firefly の「Structure Reference」とMidjourney V6の「Character Reference」が、同じシステムで利用可能になれば、今まで不可能だった人間の複雑なポージングや同じキャラクターの生成が容易になります。

現時点でのベストプラクティスについては、4月から「Creative.Edge Live」で詳細に解説してきました。

今後のアップデートもライブ配信で詳しく紹介していきます。

第19回のライブ配信は11日の夜に予定しています。

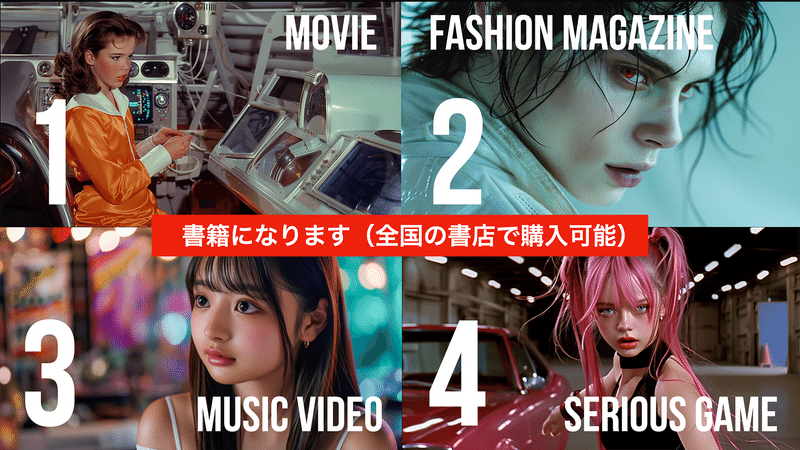

GenAI 実制作プロジェクト

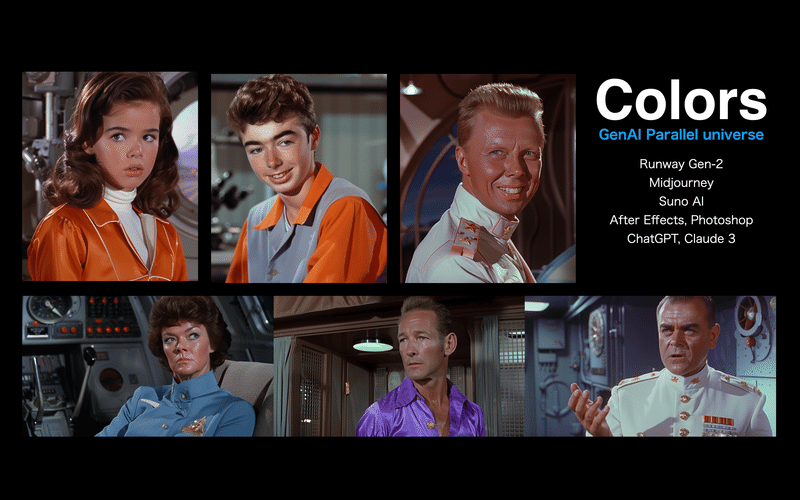

同時進行のプロトタイプは「映画」「ファッション雑誌」「ミュージックビデオ」「シリアスゲーム」の4ジャンルで、生成AIを駆使しながら試行錯誤を続けています。今月から、いよいよ仮説検証をベースにしたコンテンツ制作のフェーズに入り、実制作を本格的に進めています。

ファッション雑誌プロジェクトは、ヴァンパイアをテーマにしたアーティスティックなフォトグラフィ表現を追求。

生成画像のハルシネーションは、Photoshopの生成AI(Firefly)で修正。

(First GenerationはMidjourney v6)

映画プロジェクトは、最長2分20秒の1エピソード・パイロット版。動画生成AIはRunway Gen-2を使用し、After Effectsで修正およびビデオ編集。

現在のプロトタイプ:

再生時間:59秒

過去のプロトタイプ:

再生時間:38秒

シリアスゲームプロジェクトは、まだプロットの段階でゲームエンジンなどは決まっていません。ストーリーやコンセプトワークでは、GPT-4とClaude 3 Opusを活用しています。これらのLLMがないと「完成しない」と言っても過言ではありません。

以下は、イメージムービーです。

シリアスゲームのイメージムービー:

再生時間:1分16秒

ミュージックビデオは、過去さまざまな音楽ジャンルでプロトタイピングしてきましたが、最終的に日本のアイドルのMVに決定しました。

MVはリップシンクなど、高度な動画生成AI技術を駆使しているため、映画制作よりも面倒な作業になっています。

過去のプロトタイプ:

再生時間:48秒

再生時間:43秒

ミュージックビデオや映画制作では、大量の画像・動画を生成しますので豊富な計算資源を必要とします。要するに、GPU使用料(クレジット)を消費するため「お金がかかる」ということです。

例えば、画像生成AIのMidjourneyなら月額30ドル(※月払い)のStandard Plan以上の契約が必須となります。Relax Modeが利用できないプランは、サブスクの月額料金を支払っていても結果的に追加でクレジットを購入することになってしまうからです。

※Relax Modeは生成に時間がかかりますが生成は無制限です。

前述したAdobe Firefly の「Structure Reference」やMidjourney V6の「Character Reference」によって、プロンプトを書かなくても意図したイメージを生成できるようになってきたので、費用の負担は減っています。

映像制作のための画像生成および動画生成については、プロンプト入力に依存するほど「お金がかかる」ことを意識しておく必要があります。

プロンプトはできるだけ書かないようにして、リファレンスやコントローラーUIの機能を使用して画像生成することを強くお奨めします。

そもそも(偶然を待つようなガチャの)プロンプト入力では、絵コンテに沿った作業は不可能です。

プロンプト入力ではなく、リファレンス(画像参照)やコントローラーUIを駆使した手法によって、少ない試行錯誤で作業を効率化できるようになりました。

※どう考えてもモーションブラシで表情をつくるのは無理がある

Gen-2のモーションブラシによって、プロンプト入力では困難だった再現性の高い表情コントロールが可能になりましたが、この方法がベストではありません。もっとユーザビリティの高いUIが必要です。

まだ多くの課題を抱えていますが、技術進化が凄まじいので、動画生成の今後はポジティブなものだと考えています。

今まで不可能だった表現が、月単位で実現していくスピード感は驚くべきことですが、この技術が悪用されないか心配です。OpenAIのSoraがなかなか一般公開されませんが、彼らはフェイクやIP権利侵害の生成動画がSNSで流通することを恐れていますので、それなりの対策が完了するまではサービスを開始しないでしょう。

モデレーションシステムを強化するか(生成できる表現の幅を狭めるか)、一般ユーザーの用途を限定的なものにするか、RunwayのようにGPU使用料を高額にするか…

表現の自由度で言えば、自分のマシンで動かせるStable Diffusion一択になりますね…

Photoshopの生成AIを最大限に活用する

すでに紹介済みですが、Adobe Firefly に実装された「Structure Reference(構成参照)」はとても強力な機能です。

ただし、ハルシネーションは発生します。

関節がおかしい(人間の関節じゃない)、指が多い、足が短い/長い、笑顔の歯が不自然、光や陰影が嘘、意味不明のオブジェクトが付く、等々。

これは生成AIの仕組み上、避けられないことなので「後処理」に委ねるしかありません。

画像生成のハルシネーションは、Photoshopの生成AIおよび既存の画像処理機能で修正します。

※品質向上のプロセスでCreative Upscalerを使用

Style Reference(スタイル参照)やEffects(スタイル効果)を併用すると、簡単にイラスト化することができます。

本プロジェクトでは、イラスト表現は実行しませんが、リファレンスによってさまざまなスタイルに変換できる機能は積極的に活用しています。

Midjourney V6の「Character Reference」と同等の機能がFireflyに実装されたら、最強の画像生成AIツールになるのですが….

現在制作中のミュージックビデオは、1990年後半から2000年頃のJ-POPアイドルをモチーフにしています。

楽曲はSuno AIを使用していますが、生成された曲をそのまま使用できないため(有料アカウントは商用利用可能ですが著作権が発生しない可能性があるため)、Adobe Auditionを使用して複数の曲をマッシュアップするなど、生成音楽を「素材」として扱っています。

First Generationは「Midjourney v6」を使用、Second Generationは「Photoshop生成AI」

以下は、Runway Gen-2によるリップシンクのラフなテストバージョン。

4秒を超えると設定した人物から離れていきますが、最長20秒まで生成できるようになりました。しかも、表情などを制御した状態でリップシンクできます。

再生時間:30秒(10秒のループ)

顔が変わっておりムービーとしては失敗しているが、破綻なく10秒以上生成可能になったのは大きな前進と言える

動画生成の素材となる生成画像の品質を向上させたり、表情や背景の動きを設定することで臨場感のあるビデオが生成されます。

ただ、まだ設定の難易度は高く、誰でも簡単に実行できる機能にはなっていません。AIモデルの傾向などを把握しておく必要があるため、とても難しい操作です。

とはいえ、この短期間でここまで可能になるとは思っていなかったので、今後どこまで精度が向上するのか、期待しかありません。

画像生成・動画生成の活用方法の共有

Creative.Edge Liveのライブ配信はすでに16時間を超えているため、全ての解説内容を記事化することはできませんが、今後も定期的に抜粋して載せていきたいと思います。

第19回のライブ配信は11日の夜に予定しています。

このプロジェクトが書籍になります

ライブ配信や深夜ラジオでは、書籍のバックグラウンドについてお話していますが、詳細決まり次第、noteでお知らせします。

過去の記事:

[1] 動画生成AIで自主映画制作は可能か?(2023/11/17)

[2] 動画生成AIで自主映画制作は可能か?(2023/11/23)

[3] 動画生成AIで自主映画制作は可能か?(2023/11/28)

[4] 動画生成AIで自主映画制作は可能か?(2023/12/06)

[5] 動画生成AIで自主映画制作は可能か?(2023/12/08)

2週間後の東京の街並みを生成してみる -[6]動画生成AIで自主映画制作は可能か?(2023/12/10)

夢でみた記憶の映像をAIで生成してみる[7] 動画生成AIで自主映画制作は可能か?(2023/12/12)

プロンプト入力だけの画像生成はそろそろ終了...[8] 動画生成AIで自主映画制作は可能か?(2023/12/14)

映画制作の進捗報告[9] 動画生成AIで自主映画制作は可能か?(2023/12/21)

どうなる?2024年の生成AIと映像制作[10] 動画生成AIで自主映画制作は可能か?(2023/12/28)

詩を書くように映像をつくる[11] 動画生成AIで自主映画制作は可能か?(2024/01/18)

[生成テクニック]動画生成AIに適した画像生成のための実践メモを公開 -[12] 動画生成AIで自主映画制作は可能か?(2024/01/30)

動画生成AIを6か月間使ってわかったこと[13] 動画生成AIで自主映画制作は可能か?(2024/02/12)

コンセプトワークとストーリーボードのプロセスを紹介します[14] 動画生成AIで自主映画制作は可能か?(2024/03/05)

実制作プロジェクトの概要(2024年6月に更新):

生成AIが今後クリエイティブ業界に与える影響を検証する目的で実施

映画およびミュージックビデオ制作プロジェクトでは、最長2分20秒のビデオプロトタイプを制作する

ファッション雑誌プロジェクトは、デジタルブック(PDF)として完成させる

シリアスゲームプロジェクトでは、簡易プレイ可能な高忠実度のプロトタイプを制作する

コンセプトワーク、ストーリー構築からビジュアルデザイン、画像処理、映像制作(音楽を含む)まで全てのプロセスで生成AIを活用する

生成AIを最大限に活用して「1人」で制作する

後述する画像生成・動画生成ポリシーを遵守する

画像生成・動画生成ポリシー(2024年6月に更新/題目変更:2024年3月):

プロンプトに作家名や作品タイトルを入れない(映画監督の名前や映画タイトル、登場人物、俳優の名前等も同様)

プロンプトに著名人の名前やブランド名などを入れない

他人の著作物をリファレンスにしない

ネットで提供されてるフリー素材をリファレンスにしない

ハルシネーション(例:人物の関節や指の間違い、光や陰影などの嘘など)が発生するため生成画像を「写真」として扱わない

特定の歴史的、文化的に重要な作品に対する敬意を表し、その再現を控える(著作権の問題でなく作品がもつ文化的価値や影響を尊重するため)

Nijiモデル等のイラスト系の生成画像は自分の作品として公開しない

生成した画像はそのまま使用せず「作品の素材」として利用する

公開する場合はAIで生成したことを表記する

「動画生成AIの可能性」マガジンをフォローしておくと、最近記事・最新情報の通知が届きます。

更新日:2024年6月9日(日)/公開日:2024年6月9日(日)

この記事が気に入ったらサポートをしてみませんか?