生成AI時代に必須!水冷サーバーとは

皆さんこんにちは♪

本日はAI時代に必須の水冷サーバーについて解説します♪

AI技術の進展は、私たちの生活やビジネスのあり方に大きな変革をもたらしています。しかし、これらの技術の進化には裏側に大きな問題があります。それは、AI技術を支えるための膨大な電力消費です。特に、AIを動作させるためのコンピュータ、つまりサーバーの電力消費が急増しており、このことが大きな環境問題として取り上げられています。

データセンターは、これらのサーバーを収容し、運用するための施設です。データセンターの効率的な運用には、適切な冷却技術が不可欠です。冷却技術が不十分であると、サーバーの過熱が発生し、システムのパフォーマンス低下や故障を引き起こす可能性があります。また、冷却に多くの電力を必要とする場合、全体のエネルギー効率が低下し、さらなる電力消費とコスト増加を招きます。

本記事では、AIと電力消費の関係、データセンターの電力消費の現状、従来の冷却技術の課題、そして新たに注目されている水冷技術について詳しく解説します。また、水冷技術の実用化に向けた課題についても触れ、今後の展望を考察します♪

AIと電力消費

AI技術の進展に伴い、AI向けサーバーの電力消費量は劇的に増加しています。これは、より高度なAIアルゴリズムの計算を行うために必要なコンピューティングパワーが増大しているためです。以下に、AI向けサーバーの電力消費の増加について詳しく見ていきます。

電力消費量の増加

2010年頃には、サーバー1台あたりの消費電力はおおよそ250Wでした。しかし、2020年頃にはその消費電力が倍の500Wに増加しました。これは、サーバーの性能向上とともに電力消費も増加していることを示しています。

特に、AI向けのサーバーにおいてはその消費電力が飛躍的に大きくなっています。例えば、NVIDIAのAI向けサーバーGDX 100の消費電力は10.2KW(10,200W)にも達します。これは、従来のサーバーと比べて約20倍の消費電力を必要とすることになります。

従来型サーバーとの比較

従来型のサーバーとAI向けサーバーの電力消費量を具体的に比較すると、その差は一目瞭然です。AI向けサーバー1台で消費する電力は、一般家庭の2世帯から3世帯分に相当します。この消費電力の差は、AI技術の高度化とその計算需要の増加によるものです。

具体例:NVIDIAのAIサーバーGDX 100

NVIDIAのAIサーバーGDX 100は、その代表的な例です。このサーバーは10.2KWの電力を消費し、その性能を最大限に発揮するために大量のエネルギーを必要とします。この10.2KWという数値は、一般家庭の電力消費量と比較して非常に大きいことがわかります。例えば、一般的な家庭が1ヶ月に使用する電力が約300kWh(キロワットアワー)であるとすると、このサーバーは1時間でそれを超える電力を消費する計算になります。

このように、AI技術の進展に伴い、AI向けサーバーの電力消費は大幅に増加しています。次章では、データセンター全体の電力消費の現状について詳しく見ていきます。

データセンターの電力消費の現状

データセンターは、AI向けサーバーを含む多くのサーバーを収容し、運用するための施設です。これらのデータセンター全体の電力消費は、サーバー自体の消費電力と冷却システムの消費電力に大きく依存しています。ここでは、データセンターの電力消費の内訳とその現状について詳しく見ていきます。

電力消費の内訳

データセンターで消費される電力は、主にサーバーの動作とそれを冷却するためのシステムに分けられます。一般的なデータセンターでは、全体の電力消費の約50%がサーバー自体の動作に使われ、残りの50%が冷却システムに使用されます。このことから、冷却システムの効率化がデータセンター全体の電力消費を削減するために重要であることがわかります。

中規模データセンターの電力消費

中規模のデータセンターでは、消費電力はおおよそ5000KW(5MW)に達します。これは、一般家庭約1000から1500世帯分の電力消費に相当します。この規模のデータセンターでは、多くのサーバーが設置されており、それに伴う冷却システムも複雑化します。

大規模データセンターの電力消費

大規模なデータセンターでは、消費電力がさらに増加し、50MWに達することもあります。これは、一般家庭1万世帯から1万5000世帯分の電力消費に相当します。このような大規模データセンターでは、サーバーの数も膨大であり、それに伴う冷却システムの効率化が非常に重要です。

超大規模データセンターの予測

今後、AI技術の普及とともに、さらに大規模なデータセンターが必要となる可能性があります。超大規模データセンターでは、100MW以上の電力を消費することが予想されます。これは、一般家庭3万世帯以上の電力消費に相当し、都市全体の消費電力に匹敵する規模です。

このように、データセンター全体の電力消費は非常に大きく、その内訳はサーバーの動作と冷却システムに依存しています。次章では、従来の冷却技術とその課題について詳しく見ていきます。

従来の冷却技術とその課題

データセンターの運用において、冷却技術は非常に重要です。サーバーが発熱するため、その熱を効果的に取り除かないと、サーバーのパフォーマンスが低下し、最悪の場合、システム全体の停止や故障の原因となります。ここでは、従来の冷却技術の概要とその課題について詳しく解説します。

コンピュータルーム空調(CRAC)ユニット

CRACユニットは、従来のエアコンに似た仕組みで動作します。冷媒を使用して空気を冷却し、その空気をサーバールームに循環させます。CRACユニットは、小規模から中規模のデータセンターでよく使われ、以下のような特徴があります (Dataspan) (Data Canopy) (Data Center International)。

冷却媒:冷媒を使用し、圧縮機を介して冷却する。

構成部品:圧縮機、冷却コイル、空気フィルター、エバポレーターコイルなど。

冷却方法:サーバールーム内の暖かい空気を吸い込み、冷却コイルを通して冷却し、再び部屋に送り出す。

エネルギー効率:一般的にエネルギー効率は低め。

適用範囲:小規模から中規模のデータセンターに適している。

コンピュータルームエアハンドラー(CRAH)ユニット

CRAHユニットは、冷水を使用して空気を冷却するシステムです。これにより、より大規模なデータセンターで使用されることが多く、以下のような特徴があります (Data Canopy) (Dgtl Infra) (Green Data Center Guide)。

冷却媒:冷水を使用し、冷却コイルを介して空気を冷却する。

構成部品:ファン、冷却コイル、制御システムなど。

冷却方法:サーバールーム内の暖かい空気を吸い込み、冷水が流れる冷却コイルを通して冷却し、再び部屋に送り出す。

エネルギー効率:一般的にエネルギー効率は高め。

適用範囲:中規模から大規模のデータセンターに適している。

冷却システムの限界

サーバールーム内のスペース問題

従来のCRACおよびCRAHユニットでは、サーバールーム内に複数のユニットを設置する必要があります。例えば、1ラックあたりの消費電力が10KW以下の場合、サーバールーム内に4台程度のユニットを設置すれば十分に冷却可能です。しかし、AIサーバーなどの高性能サーバーが増加し、1ラックあたりの消費電力が40KWに達するような場合、ユニットの数を増やさなければならず、サーバールーム内のスペースが不足する問題が発生します (Data Canopy) (Data Center International)。

低消費電力ラック(10KW以下):4台のCRAC/CRAHユニットで冷却可能

高消費電力ラック(40KW):16台以上のCRAC/CRAHユニットが必要

冷却効率の低下

CRACおよびCRAHユニットによる冷却方式では、サーバールーム全体の空気を冷却するため、冷却効率が低下する傾向があります。特に、サーバーが高密度で配置されている場合、熱が集中し、冷却が不十分になることがあります。これにより、サーバーの過熱が発生し、システム全体の安定性に影響を与える可能性があります (Data Canopy) (Green Data Center Guide)。

大規模データセンターでの冷却効率の低下

大規模なデータセンターでは、サーバーの数が増加し、冷却システムの負荷も増大します。従来のCRACおよびCRAHユニットでは、これらの大規模データセンターでの冷却効率がさらに低下し、運用コストの増加とエネルギー消費の増大を招きます。

冷却システムのエネルギー消費

例えば、50MWの消費電力を持つ大規模データセンターでは、冷却システムだけで25MW(50%)の電力を消費することになります。これは、一般家庭約5000世帯分の電力消費に相当します (Data Canopy) (Dgtl Infra)。

冷却システムの設置コスト

さらに、CRACおよびCRAHユニットの設置には高額なコストがかかります。大規模データセンターでは、冷却システムの設置費用が数億円に達することも珍しくありません。また、運用コストも高く、ユニットのメンテナンスや電力消費に伴う費用が継続的に発生します (Dgtl Infra)。

設置費用:数億円

運用コスト:高額なメンテナンス費用と電力消費費用

従来の冷却技術には、このような課題が存在します。次章では、新たに注目されている水冷技術の導入とその種類について詳しく見ていきます。

水冷技術の導入とその種類

水冷技術は、従来の空冷技術に比べて高い冷却効率を持ち、大規模データセンターでの冷却課題を解決するために注目されています。ここでは、水冷技術の基本原理とその種類について詳しく説明します。

水冷技術の基本原理

水冷技術は、冷却水を使用してサーバーの発熱を直接取り除く方法です。冷却水はサーバー内や周囲の冷却コイルを通じて熱を吸収し、その後、外部の冷却装置で再冷却され、再び循環されます。これにより、冷却効率が向上し、全体のエネルギー消費を削減することができます (Datacenters) (HackerNoon)。

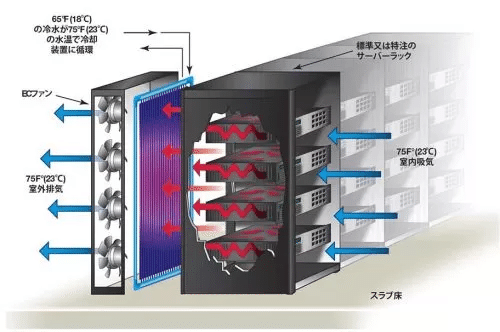

ラック内冷却とリアドア冷却

ラック内冷却とリアドア冷却は、水冷技術の中でも比較的簡単な方法です。これらの方法では、サーバーラックの近くに冷却装置を配置し、冷却水を通して熱を取り除きます (Dgtl Infra)。

ラック内冷却:冷却装置をラックの内部に設置し、サーバーの近くで冷却を行います。これにより、冷却効率が向上し、サーバーのパフォーマンスを最適化できます。

リアドア冷却:ラックの後部に冷却装置を設置し、排気熱を効率的に除去します。この方法は、既存のラック構成を大きく変更せずに導入できる利点があります。

直接液体冷却(DLC)の仕組み

直接液体冷却(DLC)は、冷却水を直接サーバーの発熱部品に供給する高度な冷却方法です。この方法では、冷却水がサーバー内部のコールドプレートを通過し、CPUやGPUなどの発熱部品を効率的に冷却します (Datacenters) (Dgtl Infra)。

コールドプレート:サーバー内部の発熱部品に取り付けられる金属板。冷却水がこのプレートを通過することで、発熱部品を効果的に冷却します。

循環システム:冷却水はサーバー内で熱を吸収した後、外部の冷却装置で再冷却され、再びサーバーに供給されます。

液浸冷却のメリットとデメリット

液浸冷却は、サーバー全体を冷却液に浸す方法です。この方法は冷却効率が非常に高いですが、いくつかの課題もあります (Datacenters) (HackerNoon)。

メリット:

高い冷却効率:冷却液がサーバー全体に直接触れるため、熱を効率的に取り除けます。

静音性:ファンを使用しないため、運用中の騒音が低減されます。

デメリット:

メンテナンスの難しさ:冷却液に浸ったサーバーのメンテナンスが難しく、部品交換時に手間がかかります。

コスト:特殊な冷却液や専用設備が必要なため、初期導入コストが高くなる傾向があります。

これらの水冷技術は、それぞれ異なる利点と課題を持っていますが、冷却効率の向上とエネルギー消費の削減に大きく貢献します。次章では、水冷技術の実用化に向けた課題について詳しく見ていきます。

水冷技術の実用化に向けた課題

水冷技術は、冷却効率の向上とエネルギー消費の削減に大きく貢献する一方で、その実用化にはいくつかの課題が存在します。ここでは、水冷技術の実用化に向けた具体的な課題と、それらを克服するための対策について詳しく見ていきます。

スパコンとデータセンターでの違い

スパコン(スーパーコンピュータ)では、建物やコンピュータ、冷却システムが特別に設計されることが多いため、水冷技術の導入が比較的容易です。例えば、日本の「Kコンピュータ」や「富岳」などのスパコンは、水冷技術を採用しています。しかし、データセンターでは、一般化された設備や複数のメーカーの機器が使用されるため、水冷技術の導入にはさらに多くの課題が存在します (Datacenters) (HackerNoon)。

水冷技術の一般化に向けた障壁

水冷技術の一般化には、以下のような障壁があります:

規格の統一

現在、水冷技術に関する規格が統一されておらず、メーカーごとに仕様が異なるため、互換性の問題が発生します。これにより、複数のメーカーの機器を統一的に冷却することが難しくなります (Dgtl Infra) (Data Canopy)。例えば、サーバーと冷却システムを接続するコネクタの形状や冷却水の供給温度の標準化が必要です。

初期導入コスト

水冷システムの初期導入コストは高く、冷却装置や配管システムの設置費用がかかります。特に、大規模データセンターでは、これらのコストが数億円に達することもあります (Datacenters) (Green Data Center Guide)。

メンテナンスの複雑さ

水冷システムのメンテナンスは、空冷システムに比べて複雑であり、専門的な知識やスキルが必要です。また、冷却液の漏れや劣化などのリスクもあります (Dgtl Infra)。例えば、冷却水の循環システムにおける配管の劣化や詰まりが発生することがあります。

規格統一の必要性

水冷技術の一般化を進めるためには、以下のような規格統一が必要です:

コネクタの標準化

サーバーと冷却システムを接続するコネクタの形状や規格を統一することで、互換性を向上させることができます。これにより、複数のメーカーの機器を同一の冷却システムで効率的に冷却することが可能になります (Datacenters) (Dgtl Infra)。

冷却水の温度管理

供給する冷却水の温度や流量の標準を確立し、各メーカーがこれに対応することが求められます。例えば、冷却水の温度は通常18〜22度に設定され、流量は1分間に10リットル程度が一般的です (Dgtl Infra)。

メンテナンス手順の標準化

冷却システムのメンテナンス手順やトラブルシューティングのガイドラインを統一し、運用効率を向上させることが必要です。これにより、データセンターの運用中に発生する問題を迅速かつ効率的に解決することが可能になります (Data Canopy) (Green Data Center Guide)。

規格統一に向けた取り組み

水冷技術の普及と実用化を進めるためには、業界全体での規格統一が不可欠です。これにより、複数のメーカーの機器間での互換性が向上し、効率的な冷却システムの導入が可能となります。以下では、規格統一に向けた具体的な取り組みと、その効果について詳しく説明します。

オープンコンピュートプロジェクト(OCP)

オープンコンピュートプロジェクト(OCP)は、データセンターの効率化と標準化を目指す業界団体であり、水冷技術の規格統一にも積極的に取り組んでいます。OCPは、ハードウェアとソフトウェアの両面でオープンソースの原則を導入し、データセンターの運用効率を高めることを目的としています (Datacenters) (Green Data Center Guide)。

OCPの具体的な取り組み

標準化されたコネクタ:OCPは、サーバーと冷却システムを接続するコネクタの形状や規格を統一する取り組みを進めています。これにより、異なるメーカーの機器を同一の冷却システムで使用することが可能になります。

冷却水の温度と流量:冷却水の供給温度や流量の標準化に関するガイドラインを策定し、各メーカーがこれに対応することで、冷却効率を最適化します。例えば、冷却水の温度を18〜22度に設定し、流量を1分間に10リットル程度とする基準を設けています。

メンテナンス手順:冷却システムのメンテナンス手順やトラブルシューティングのガイドラインを統一し、運用効率を向上させます。これにより、データセンターの運用中に発生する問題を迅速かつ効率的に解決することができます。

業界全体の協力

水冷技術の普及には、OCP以外の業界団体や企業も協力し、規格統一に向けた取り組みを進めています。例えば、次のような取り組みが行われています:

ASHRAEの役割

ASHRAE(アメリカ暖房冷凍空調学会)は、HVAC(暖房・換気・空調)システムに関する標準やガイドラインを提供する組織です。ASHRAEは、データセンターの冷却に関する標準やガイドラインを策定し、水冷技術の導入を支援しています (Dgtl Infra) (Data Center International)。

水冷システムのガイドライン:ASHRAEは、水冷システムの設計、運用、メンテナンスに関するガイドラインを提供し、業界全体でのベストプラクティスを共有しています。

エネルギー効率の向上:エネルギー効率の向上を目的としたガイドラインを提供し、水冷システムの導入による省エネ効果を最大化します。

グローバル規格の策定

国際標準化機構(ISO)や国際電気標準会議(IEC)などの国際機関も、水冷技術の規格統一に向けた取り組みを進めています。これにより、世界中のデータセンターで水冷技術の導入が促進されます (Datacenters) (Green Data Center Guide)。

ISO/IEC標準:ISO/IECは、データセンターの冷却に関する国際標準を策定し、各国のデータセンターが一貫した基準に基づいて水冷技術を導入できるようにします。

技術フォーラムの開催:業界関係者が集まり、最新の技術やベストプラクティスを共有するフォーラムを開催し、規格統一の推進を図ります。

規格統一の効果

規格統一が進むことで、水冷技術の導入が容易になり、以下のような効果が期待されます:

コスト削減:規格統一により、設計や導入のコストが削減され、データセンターの運用コストも低減します (Dgtl Infra) (Green Data Center Guide)。

エネルギー効率の向上:冷却効率が向上し、エネルギー消費が削減され、環境負荷が軽減されます。

運用の安定化:標準化されたメンテナンス手順により、データセンターの運用が安定し、ダウンタイムのリスクが低減します。

これらの取り組みを通じて、水冷技術の実用化が進み、データセンターの冷却効率が大幅に向上することが期待されます。次章では、AI技術の発展とその影響、データセンターの電力消費と冷却技術の重要性、そして水冷技術の現状と将来の展望についてまとめます。

まとめ

本記事では、AI技術の発展に伴う電力消費の増加と、それに対応するためのデータセンターの冷却技術について詳しく解説しました。特に、水冷技術の導入とその課題について深掘りし、従来の冷却技術との比較を通じて、その重要性を浮き彫りにしました。以下に、主要なポイントをまとめます。

AI技術の発展と電力消費の増加

AI技術の進展により、AI向けサーバーの電力消費量が急増しています。例えば、NVIDIAのAIサーバーGDX 100は10.2KWの電力を消費し、従来のサーバーと比べて約20倍の消費電力を必要とします。これにより、データセンター全体の電力消費が大幅に増加し、冷却システムの負荷も増大しています (Dataspan) (Data Canopy)。

データセンターの冷却技術

従来の冷却技術としては、主にCRAC(Computer Room Air Conditioner)ユニットとCRAH(Computer Room Air Handler)ユニットが使用されています。これらのシステムは、それぞれ冷媒と冷水を使用して空気を冷却し、サーバールーム内の温度と湿度を調整します。しかし、エネルギー効率の低さやスペースの問題、初期導入コストの高さなどの課題が存在します (Data Center International) (Dgtl Infra)。

水冷技術の導入

水冷技術は、従来の空冷技術に比べて高い冷却効率を持ち、大規模データセンターでの冷却課題を解決するために注目されています。特に、直接液体冷却(DLC)や液浸冷却などの方法があり、それぞれのメリットとデメリットを考慮して適用されています。水冷技術の導入により、冷却効率の向上とエネルギー消費の削減が期待されます (Datacenters) (HackerNoon) (Green Data Center Guide)。

水冷技術の実用化に向けた課題

水冷技術の実用化には、規格の統一や初期導入コストの削減、メンテナンスの複雑さなどの課題があります。これらの課題を克服するために、オープンコンピュートプロジェクト(OCP)やASHRAE(アメリカ暖房冷凍空調学会)、ISO(国際標準化機構)などの業界団体が協力し、規格統一に向けた取り組みを進めています。これにより、異なるメーカーの機器間での互換性が向上し、効率的な冷却システムの導入が可能になります (Datacenters) (Dgtl Infra) (Data Center International)。

将来の展望

今後、AI技術のさらなる発展に伴い、データセンターの電力消費はますます増加することが予想されます。このため、冷却技術の進化と効率化がますます重要となります。水冷技術の導入とその規格統一が進むことで、データセンターの冷却効率が向上し、エネルギー消費の削減と環境負荷の軽減が期待されます。

この記事が気に入ったらサポートをしてみませんか?