GPT-3(Generative Pre-trained Transformer 3)とは

GPT-3とは

GPT-3(Generative Pretrained Transformer)はOpenAIが開発している1750億個のパラメータを使用した『文章生成言語モデル』です。

(*言語モデルとは入力されたテキストを元にその続きを予測するモデル)

GPT-3は一部の方が現在利用できる状態で制限されていますが、1つ前のバージョンであるGPT-2はオープンソースで公開されていますので試して利用する事が可能です。

GPTの歴史

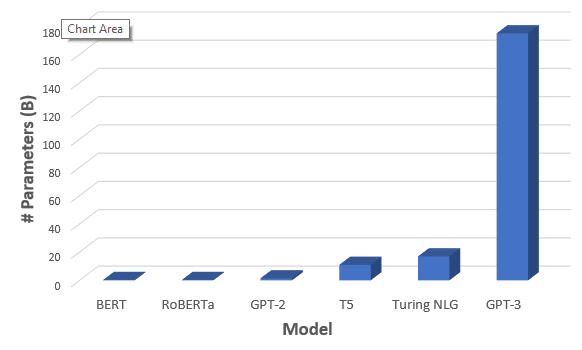

GPT-3はGPTの3番目のバージョンで、これまでGPT→GPT-2→GPT-3とバージョンアップしています。

2020年8月8日現在バージョンは3です。

OpenAIが作ったGPTの初代バージョンである、GPTは2018/6/11日に1.1億パラメータを使用しており、バージョンが上がるごとにパラメータ数が増えています。

(GPT-2(2019/2/14)では15億パラメータ、GPT-3(2020/5/28)1,750億パラメータ)

出典)https://towardsdatascience.com/gpt-3-the-new-mighty-language-model-from-openai-a74ff35346fc

また、この記事によると、GPT-3のトレーニングには、、市場で最も低価格のGPUクラウドを使った場合、355年と460万ドルが必要になるとのことです。(日本円で約4億9000万円)

GPT-3でできること

GPT-3ではどのような事が出来るのでしょうか。

下記のようなものになります。

ソースコードの自動生成

Here's a sentence describing what Google's home page should look and here's GPT-3 generating the code for it nearly perfectly. pic.twitter.com/m49hoKiEpR

— Sharif Shameem (@sharifshameem) July 15, 2020

上記は自然言語からソースオードを自動生成しています。

デザインの生成

This changes everything. 🤯

— Jordan Singer (@jsngr) July 18, 2020

With GPT-3, I built a Figma plugin to design for you.

I call it "Designer" pic.twitter.com/OzW1sKNLEC

ToDOアプリのコード(React)を自動生成

I just built a *functioning* React app by describing what I wanted to GPT-3.

— Sharif Shameem (@sharifshameem) July 17, 2020

I'm still in awe. pic.twitter.com/UUKSYz2NJO

コードから使用を英語で説明するツール

Reading code is hard! Don't you wish you could just ask the code what it does? To describe its functions, its types.

— Amjad Masad (@amasad) July 22, 2020

And maybe... how can it be improved?

Introducing: @Replit code oracle 🧙♀️

It's crazy, just got access to @OpenAI API and I already have a working product! pic.twitter.com/HX4MyH9yjm

データセットと必要な出力を記述するとKerasのモデルのコードを生成

AI INCEPTION!

— Matt Shumer (@mattshumer_) July 25, 2020

I just used GPT-3 to generate code for a machine learning model, just by describing the dataset and required output.

This is the start of no-code AI. pic.twitter.com/AWX5mZB6SK

文章の自動生成

下記の記事の前半部分はGPT-3によって生成された記事。

上記で紹介した以外にも、画像や音楽の自動生成や、レポートの自動生成、チャットの自動応答など様々な事が出来るようになっています。

今回のdemoにはありませんでしたが、GPT-3のような言語AIモデルAIによって書かれた小論文や業務報告書、SNSなどから得られた高精度なボットなどが出てくるかもしれません。

他にもGPT-3を利用したアプリケーションをまとめたウェブサイトもあるので確認してみてください。

GPT-3の仕組み

GPT-3の構造はGoogleによる言語モデルである「Transformer」を基本としています。内部の仕組みに関しては既に詳細に解説している記事がありますので下記などをご参考にしてみてください。

GPT-3のできないところや問題点

このようにGPT-3ではこれまで以上に文章を生成する事が出来るようになっていますが、「空はなぜ青いのか?」のような複雑な質問にはうまく答えられないようです。

他にも、GPTは意味を理解せず、喜びや怒りなどの感情や、常識も備えていません。

また、機械学習アルゴリズムの開発に置いてデータセットに含まれる偏見や差別は大きな問題です。(AI倫理分野の課題)

・下記記事参考

また今回のnoteを書くにあたりネット上の様々な記事を拝見しましたが、下記の記事なども参考になりますのでGPT-3に関して興味を持った方は一度目を通しておくと良いかもしれません。

GPT-3の衝撃

超高精度な言語モデル「GPT-3」は本当に「人間そのもの」な会話ができるのか実験した結果は?

AIの「自然言語処理」技術がここへきて劇的な進化を遂げている

まとめ

このnoteではGPTの最新版であるGPT-3に関して簡単に紹介しました。

GPT-3は巨大なデータで学習したモデルですが、今後もこのような巨大なモデルが出現しそうです。

このnoteを書いた人

サイバーブレイン株式会社

代表取締役CEO 谷 一徳

フォローお待ちしております!

Twitter

短期オンラインAIブートキャンプを運営&代表講師

この記事が気に入ったらサポートをしてみませんか?