自動運転がやがて直面する道徳の「壁」〜モラルマシン〜

はじめに

AIいわゆる人工知能が人間の社会に浸透するにつれて、このAIにも人間界における規範、ルールを守ってもらう必要が出てくると思います。

一口にルールと言っても、目に見えるもの、見えないもの、人間界におけるルールは様々です。もちろんその一部は、法律として明文化されています。しかし真に厄介なのは、明文化されていない暗黙の了解のようなものではないでしょうか?特に人の命に関わるものは重大です。

SF小説家であり優れたサイエンスライターであったアイザック・アシモフは、1950年のSF小説「われはロボット」の中でロボットのための法律とも言うべきロボット三原則を提唱しました。

第1条:ロボットは、人間に危害を加えてはならない。また、人間に危害が及ぶのを見過ごしてはならない。

第2条:第1条に抵触しない限りにおいて、ロボットは人間の命令に服従しなければならない。

第3条:ロボットは自身の身を守らなければならない。ただし、第1条、第2条に反する場合は、この限りではない。

SF小説のみならず推理小説の名手でもあったアシモフはこれをネタにして、この三原則によってロボットがどのようなトラブルを引き起こすかを推理させるような小説を仕立て上げました。

「人間に危害を加えてはならない」、将来のAIには是非ともこの原則を守っていただきたいものですが、これがなかなかな厄介な問題を孕んでいることをこれから紹介したいと思います。

「トロッコ問題」をご存知ですか?

ハーバード大学のサンデル教授の「これからの「正義」の話をしよう」の中でも取り上げられ、すでに多くの方がご存知かもしれない「トロッコ問題」を紹介します。

暴走中のトロッコの線路の先には追突が避けられない5人の作業員がいます。線路の傍らにいる男性はそれを避けるために、1人しかいない路線へとポイントを切り替えることで、軌道を変えることができます。路線変更すれば、5人は助かりますが、1人は犠牲になります。

この道徳的”ジレンマ”は、1967年に倫理学者のフィリッパ・フットによって提示されました。フィリッパは女性で中絶の問題を考える論文(「中絶の問題と二重結果論」、オックスフォード・レビュー)でこの思考実験を行いました。なぜ「中絶」なのか?

カトリック教では、中絶は認められておらず、ではどういう場合に認められるかということがずっと議論されてきました(二重結果論)。例えば、母体に危険が及ぶなどの場合がそれに相当します。つまりここでは、母体を助けるか、胎児を助けるかの選択を迫られることになります。

「トロッコ問題」、このあまりにありそうにもない状況設定とやや不謹慎な(つまり人の命を弄んでいるようにも見える)問いかけのため、この問題に対する批判もあります。ただ、我々人間は、これと似たような状況に遭遇することはないとは言えないのです。まさにこれが今後、私たちの生活の中に入ってくることが確実になりつつある「自動運転」で議論が必要な問題となっています。

自動運転で起きる「トロッコ問題」

自動運転で走行している自動車のブレーキが突然効かなくなりました。前方には横断歩道を渡っている5人の人がいます。そのまま、突っ込めば5人は死亡しますが、自動車の乗員は助かります。一方ハンドルを切ることで、自動車は壁に激突し乗員は亡くなりますが、5人の歩行者は助かります。

このような状況に陥った時、自動運転をしていると思われる人工知能(AI)はどう判断すべきなのでしょう?いや、私たちはどう判断して欲しいと願うのでしょうか?

2016年10月、メルセデス・ベンツの自動運転開発の担当者は、「絶対に助けることが可能な人を助ける」と宣言しました。これは、当然自動車の乗員を指しています。この発言は一部非難されましたが、でも自動車を売る側がまさか、いざという時は乗っている人を犠牲にするよ、とは言えないでしょう。この担当者は、この発言後「それでも歩行者を助けるための最大限の努力をする。」と付け加えています。

そして、2022年アウディは乗員を最優先で保護する、という方針を明確にしました。

この背景には、歩行者が突然飛び出してくる、などの場合もあるため、だと考えられます。

そしてモラルマシンへ

先にも述べたように、私たちはAIまたは自動運転車にどのような倫理的行動をとってほしいと望むでしょうか?

それを具体的に調査したのが、「モラルマシン」プロジェクトです。これはマサチューセッツ工科大学の研究チームによって2014年からはじめられ、4年間継続され世界中から車の運転に関するトロッコ問題の回答を集めました。

今となっては少し古いかもしれませんが、調査結果をまとめた論文を翻訳してまとめましたので紹介します。

本論文の最後にある通り、必ずしも国を代表するような調査結果ではありません。なぜなら一部の人しか回答していないからです。さらに、回答者は車のドライバーである可能性が高く、当時もそして恐らく今もドライバーは男性の方が多いと考えれれます。したがってバイアスの混入も避けられないことを知っていた方がいいと思います。

翻訳は、前回の記事では、Google翻訳を駆使しましたが、今回はDeepLを使ってみました。

はじめは無料のお試しでpdf資料を全て一気に翻訳させてみましたが、これだとやはり一部おかしな翻訳が出てくるようです。一段落ずつDeepLに翻訳させ、都度確認しながら訳すのが一番効率がいいように感じました。翻訳精度はいいですし、アプリをダウンロードして使えるのもいいと思いました。有料版はちょっと考えちゃいますね。これで十分な気もします。

モラルマシーンプロジェクトの報告書は公開されており、こちらになります。https://core.ac.uk/download/pdf/231922494.pdf

分析結果含めると長大なものですので、大事な本文だけ訳してあります。

The Moral Machine Experiment

Edmond Awad , Sohan Dsouza , Richard Kim1, Jonathan Schulz ,

Joseph Henrich, Azim Shariff, Jean-François Bonnefon, Iyad Rahwan

The Media Lab, Massachusetts Institute of Technology, Cambridge, MA 02139, USA Department of Human Evolutionary Biology, Harvard University, Cambridge, MA 02138, USA Department of Psychology, University of British Columbia, Vancouver, Canada Toulouse School of Economics (TSM-R), CNRS, Université Toulouse Capitole, Toulouse, France Institute for Data, Systems & Society, Massachusetts Institute of Technology, Cambridge, MA 02139, USA

モラルマシンの実験

アブストラクト

人工知能の急速な発達に伴い、機械がどのようにモラルを判断するのかという懸念と、機械の行動を導くべき倫理的原則に関する社会的な期待を定量化するという大きな課題があります。この課題に対処するために、我々はモラルマシンを開発しました。このプラットフォームは、自律走行車が直面するモラルジレンマを探るために設計されました。このプラットフォームは、何百万人もの人々から10カ国語で4,000万件の意思決定を集めました。

このプラットフォームは、233の国と地域の何百万人もの人々から10言語で4,000万件の意思決定を集めました。まずグローバルな道徳的嗜好を要約します。次に、回答者の属性に基づき、嗜好の個人差を記録します。嗜好の個人差について、回答者の属性に基づき説明します。第三に、文化間の倫理的差異を報告し、3つの主要な国のクラスターを明らかにします。第四に、これらの違いは近代的な制度や深い文化的特質と相関しています。我々は、これらの嗜好が機械倫理のためのグローバルで社会的に受け入れられる原則の開発にどのように貢献できるかを議論します。機械倫理のためのグローバルで社会的に受け入れ可能な原則の開発にどのように貢献できるかを議論します。この論文で使用したすべてのデータは、以下のサイトでアクセスおよびダウンロードが可能です。

本文

私たちは、機械が幸福を促進し、害を最小化することを任務とする時代に入りつつあります。機械が生み出す幸福と、排除できない害を分配することが求められる時代に突入しています。幸福と害を分配することは必然的にトレードオフを生み出し、その解決は道徳的領域に属します。

衝突しそうな自律走行車(AV)が、全員を救う軌道を見つけられずにいるとする。3人の高齢者を助けるために、1人の信号無視の若者に道を譲るべきでしょうか?被害が避けられないのではなく、起こりうるという一般的なケースであっても、AVは道路上のさまざまな利害関係者の間で被害のリスクをどのように分担するかを決める必要があります。道路上のさまざまな利害関係者の間で、危害を受けるリスクをどのように分担するかを決める必要があります。自動車メーカーや政策立案者は現在、こうした道徳的ジレンマに悩まされています。アシモフのロボット工学の法則4 のような単純な規範的倫理原則では解決できないからです。

アシモフの法則は、普遍的な機械倫理の問題を解決するために作られたものではなく、また、機械に害を分散させるために作られたものでもありません。数十行のコードで道徳的な機械を作ることがいかに難しいかを紹介し、良い物語を生み出すことを目的とした物語装置だったのです。

とはいえ、私たちには道徳的な機械を作ることをあきらめる余裕はありません。AVはまもなく私たちの道路を行き交うようになり、必然的に生命を脅かすジレンマが生じたときに適用すべき原則についての合意が必要となります。このようなジレンマがどの程度の頻度で発生するかは、人間のドライバーが同様の状況に陥る率を推定するのが極めて困難であるのと同様、推定することができません。事故死した人間のドライバーはジレンマに直面していたかどうかを報告できないし、事故から生還した人間のドライバーは自分がジレンマに陥っていたことに気づいていないかもしれないのです。しかし、ジレンマ状況下でのAVの選択に関する倫理的ガイドラインは、こうした状況の頻度には依存しないことに留意してください。このようなケースが稀であろうと、非常に稀であろうと、あるいは極めて稀であろうと、どのように解決すべきかをあらかじめ合意しておく必要があるのです。

キーワードは「私たち」です。この点については、バラク・オバマ前米国大統領が強調したように、コンセンサスの合意形成が重要になります。AVを導く倫理原則の判断は、技術者だけ、あるいは技術者以外技術者と倫理学者のどちらかだけに任せるわけにはいきません。消費者が従来の人間主導の自動車からAVに乗り換えるために、また消費者が従来の人間の運転する車からAVに乗り換えるために、また、より広い社会がAI駆動の車の普及を受け入れるために、両者は、その起源を理解する必要があります。つまり、仮に倫理学者がAVがどのようにモラルジレンマを解決すべきかについて合意したとしても、市民がその解決策に反対し、現状に代わってAVが約束する未来からオプトアウトしてしまえば、彼らの仕事は無駄になります。AI倫理を考案する試みは、少なくとも公序良俗を認識したものでなければありません。

したがって、AVがどのようにモラルジレンマを解決すべきかについて、社会的な期待を測る必要があります。しかし、この事業には課題がないわけではありません。第一の課題は、問題の高次元性から来るものです。典型的な調査では、人々が少数の命よりも多くの命を救うことを好むか、高齢者よりも若者を救うことを好むか、信号無視をする歩行者よりも合法的に横断する歩行者を救うことを好むか、あるいはその他の選好、あるいはこれらの選好の2つか3つを単純に組み合わせてテストすることができます。しかし、このような嗜好を十数個も組み合わせると、何百万ものシナリオが考えられるため、従来のデータ収集方法では不可能なサンプルサイズが必要となります。

機械倫理の普遍化に向けて前進するためには(あるいは、少なくともその障害を特定するためには)、個人や国によって倫理的嗜好がどのように異なるかをきめ細かく理解する必要があるのです。結果として、倫理的嗜好の人口統計学的・文化的修飾因子を評価するために、世界中でデータを収集する必要があります。

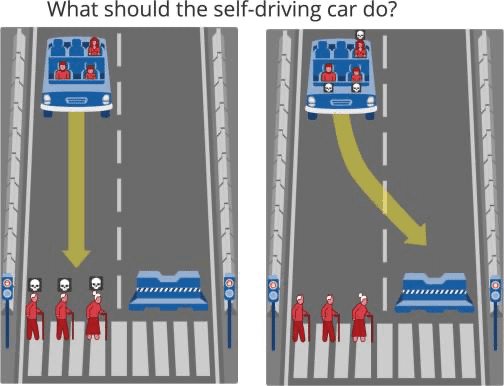

これらの課題への対応として、我々は、不可避な事故という文脈の中で、市民がAVにモラルジレンマを解決してほしいと思う方法に関する大規模データを収集するため、多言語対応のオンラインゲームであるモラルマシンを設計しました。モラルマシンは世界中で注目され、233の国・地域、3,961万件の意思決定を収集することができました(図1(a))。モラルマシンのメインインターフェースでは、避けられない事故のシナリオが表示され、AVが道をそれるか、そのまま進むかによって、2つの可能性があります(図1(b))。

AVが突然のブレーキ故障に見舞われる。そのまま走行すると、信号無視で横断中の高齢男性2名と高齢女性1名が死亡(左) ハンドルを切ると、成人男性、成人女性、少年の3人が死亡する(右)

そして、自分が好ましいと思う結果をクリックします。事故シナリオは、モラルマシンが、人間を助ける(対 ペット)、コースを維持する(対 ハンドル)、乗客を助ける(対 歩行者)、多くの命を助ける(対 少ない命)、男性を助ける(対 女性)、若者を助ける(対 高齢者)、合法的に渡る歩行者を助ける(対 信号無視)、健康な人を助ける(対 健康ではない)、高い社会的地位を持つ人を助ける(対 低い社会的地位)、という9要素に焦点を当てた探索戦略によって作成されています。また、シナリオによっては、これら9つの要素のいずれとも関連しない人物(犯罪者、妊婦、医者など)が登場します。

人間を助ける(対 ペット)とは「人間を助けるかペットを助けるか」ということ。以下同様で、コースを維持する(対 ハンドル)は「コースを維持するかハンドルをきるか」、、、と続きます。

これらのキャラクターは、主にユーザーにとってシナリオの繰り返しを少なくする役割を担っています。13回のセッションを終えた参加者は、性別、年齢、収入、教育などの人口統計学的情報、および宗教的・政治的態度を収集するアンケートに答えることができます。参加者の座標は、道徳的嗜好のベクトルが均質な国や地域のグループを識別するためのクラスタリング分析に使用できるように、地理的に配置されています。

ここでは、モラルマシンの実験結果を、4つの分析レベルに分けて報告しています。モラルマシンの結果がどのように普遍的な機械倫理への道をたどることができるかを、各レベルの分析について考察します。まず、私たちがプラットフォーム上で調査した9つのプリファレンスの相対的な重要性は何でしょうか。プラットフォームで調査した9つの嗜好の相対的な重要性はどのようなものでしょうか。第二に、各選好の強さは、回答者の個人的な特徴に依存するのでしょうか。回答者の個々の特徴に依存するのでしょうか?第三に、道徳的選好のベクトルが均質な国のクラスターを特定することは可能でしょうか?第3に、道徳的選好のベクトルが均質な国のクラスターを特定することができるのでしょうか?第四に、文化的・経済的な差異が、道徳的選好のベクトルの差異を予測させることになるでしょうか。道徳的選好のベクトルにばらつきがあるのでしょうか?

9つのプリファレンスとは先にあげたAVが遭遇するであろういわゆる「究極の選択」です。ぶっちゃけ、これだけでいいのかい?というツッコミはさておき(シナリオの限界があることは著者も認めている通り)、念の為整理すると、以下のようになります。

(1)人間を助けるvsペットを助ける

(2)コースを維持vsハンドルをきる

(3)乗客を助けるvs歩行者を助ける

(4)多くの命を助けるvs少数の命を助ける

(5)男性を助けるvs女性を助ける

(6)若者を助けるvs高齢者を助ける

(7)合法に渡る歩行者を助けるvs信号無視をして渡る歩行者を助ける

(8)健康な人を助けるvs非?健康な人を助ける

(9)高い社会的地位の人を助けるvs低い社会的地位の人を助ける

これについて以下を確認する、と言っています。

I.9つの選好(つまりどれを選ぶか)の相対的重要度は?

II.アンケート回答者の特性による選好に差はあるか?

III.みんな同じような選好を持つ国はあるのか?

IV.国の文化的・経済的差が選好に影響するのか?

結果

グローバルプリファレンス

モラルマシンが同時に探索する9つの嗜好の相対的重要性を検証するために、コンジョイント分析を用いて各属性(男性キャラクターと女性キャラクター、乗客と歩行者など)の平均限界成分効果(AMCE)を算出しました。F図2(a) はモラルマシンのデータから抽出した9つのAMCEの非バイアス推定値です。各行において、棒グラフは、右側の属性を持つキャラクターを免れる確率と、左側の属性を持つキャラクターを免れる確率の差を、他の全ての属性の結合分布に対して示しています。

上記は少し分かりづらい表現かもしれません。でもグラフの一番下で(1)ペットvs人間とあります。常識的にペットを助ける人は少数派だと思われますので、グラフの棒が高く出ているほど右側の人を助ける確率が高い、と言っていることがわかります。棒が高いものを見てみると、ペットより人間、少数より多数、高齢者より若者、信号守っていない人より守った人、社会的地位低い人より高い人を助ける確率が高いと言っています。

あなたの持つ倫理観とこれは一致した結果となっているでしょうか?

図2(a)に示すように、「動物より人間を」「より多くの命を」「若い命を」という選好が最も強いことがわかります。したがって、この3つの選好は機械倫理の基本構成要素であり、少なくとも政策立案者が検討すべき重要なテーマであると考えられます。実際、この3つの選好は、倫理学者の間で起こりそうな論争の度合いが大きく異なります。

事例として、ドイツの自動運転・コネクテッドドライブに関する倫理委員会が2017年に提案した倫理規定について考えてみましょう。この報告書は、AVの倫理的選択に関する公式ガイドラインを提供する最初の、そして唯一の試みです。そのため、この報告書は、我々の研究成果を解釈する上で、また、将来ドイツの事例に倣おうとする他の国々との関連性において、重要な文脈を提供するものです。ドイツの倫理規定第7条は、ジレンマに陥った場合、人命の保護が他の動物の保護よりも優先されるべきであると明確に述べています。このルールは、モラルマシンで評価された社会的期待と明確に一致しています。一方、ドイツ倫理規則第9条は、AVが少数者を犠牲にして多数者を救うようにプログラムされるべきかどうかについて明確な立場をとらず、その可能性を残しています。したがって、規制によって義務化されないとしても、そのようなプログラミングに強い社会的合意があることを知っておくことが重要です。

一方、ドイツの倫理規定第9条では、年齢などの個人的特徴に基づく区別を一切禁止しています。これは、モラルマシンによって評価される、子供などの若者を助けるという強い優先順位と明らかに対立しています。(図2(b)を参照のこと:赤ちゃん、女の子、男の子、妊婦の4つのキャラクター(人物特性)が最も惜しまれる人物ということになります。)

だからといって、政策立案者は世論に従って、AVが子供や、男性よりも女性、太った人よりもスポーツ選手、ホームレスよりも経営者を優先的に助けることを必ずしも認めるべきとはいえないでしょう--これらすべてについて、弱いながらも明確な影響が見られます。それは、そのような決定の根拠を説明するという課題と、AVがジレンマの中で子供を犠牲にしたときに必ず起こるであろう強い反発に対処するという課題です。

個人差

私たちは、年齢、学歴、性別、収入、政治的・宗教的見解に関する人口統計調査を任意で行ったモラルマシンユーザーのサブグループ(N = 492,921)の回答をさらに分析し、選好がこれら6つの特性によって変調されるかどうかを評価することによって個人差を評価しました。まず、6つの特性変数すべてを9つの属性それぞれの回帰ベースの推定値に含めたところ、個人差はどの属性にも大きな影響を与えないことがわかりました(すべて0.1未満)。 このうち、最も顕著な影響を与えるのは、回答者の性別と宗教性です。例えば、男性の回答者は女性を助ける傾向が0.06ポイント低く、回答者の宗教性の標準偏差が1増加すると、人間を助ける傾向が0.09ポイント高くなります。

さらに重要なことは、6つの特性のどれもが、その部分集団の効果を相反する方向に分裂させないということです。例えば、男性回答者と女性回答者の両方が「女性を惜しまない(Sparing Females)」を好むと答えましたが、後者の方がより強い選好を示しました。つまり、私たちが観測した個人差は、理論的には重要ですが、政策立案者にとって不可欠な情報ではありません。

これはわかりづらいか?男性と女性の集合で部分集合とは、「男性」と「女性」になります。6つの特性それぞれの中で、どちらか(この場合は「男性」か「女性」)を優先するような傾向は見られなかった、ということです(収入が多い人が女性を絶対助ける、なんて傾向はなかった、ということです。)。つまりこの6つの特性による個人差は考慮しなくても同じだよ、と言っています。

文化クラスター(訳注:文化的な背景はどうか?)

ジオロケーションにより、モラルマシン回答者の居住国を特定し、道徳的選好のベクトルが均質な国のクラスターを探しました。回答者が100人以上いる130カ国(N range = [101 - 448,125])を選び、各国の9つの対象AMCEを標準化し、ユークリッド距離とワード分散最小化アルゴリズムを用いて、この9つのスコアについて階層的クラスタリングを行いました 。この分析により、3つの明確な「モラルクラスター」が特定されました。これらは、図3(a)に示すように、イングルハート・ウェルゼル文化地図 2010-2014(訳注:政治学者のロナルド・イングルハートとクリスチャン・ウェルゼルが、世界価値観調査およびヨーロッパ価値観調査に基づいて作成した散布図です。)による地理的・文化的な近接性とほぼ一致しています。

最初のクラスター(西洋クラスターと呼ぶ)には、北米とヨーロッパのプロテスタント、カトリック、正教会の文化圏の国が多く含まれます。このクラスタの内部構造も、プロテスタント/スカンジナビア諸国を含むサブクラスタ、英連邦/英語圏を含むサブクラスタと、顕著な面的妥当性を示しています。

第二のクラスター(東方クラスターと呼ぶ)には、日本や台湾など儒教文化圏に属する極東の国や、インドネシア、パキスタン、サウジアラビアなどイスラム圏の国が多く含まれています。

第三のクラスター(広義の南方クラスター)は、中南米のラテンアメリカ諸国と、フランスの影響を一部受けている国(例:フランス首都圏、フランス海外領土、フランスの指導下にあった領土)からなります。ラテンアメリカの国々は、南方クラスター内の独自のサブクラスターとしてきれいに分離されています。

言語の影響を排除するために、ジレンマの説明文にアクセスせず、絵による表現にのみ依存した参加者に限定してクラスタリング解析を行ったところ、同じクラスタが出現することがわかりました。

このクラスタリングパターンは、地理的・文化的な近接性によって、機械倫理に関する共通の嗜好に収斂することができることを示唆しています。しかし、クラスタ間の差はより大きな問題を引き起こす可能性があります。図3(b)に示すように、クラスタは、いくつかの選好に与える重み付けに大きな違いがあります。例えば、年配の人物よりも若い人物を好む傾向は、東部クラスターではあまり顕著ではなく、南部クラスターでは非常に高くなっています。また、身分の高い人物を惜しむ傾向も同様です。同様に、南方クラスタでは、ペットよりも人間を優先する傾向が、他の2つのクラスタに比べてかなり弱いです。乗客より歩行者を優先する(弱い)嗜好と、不法者より合法者を優先する(中程度の)嗜好だけは、すべてのクラスターで同じ程度に共有されているようです。

(a)平均的な限界因果効果に基づく国の階層的クラスター

3つのクラスターを見ると、その分布は大きく異なることがわかる。例えば、クラスター2(東洋)は、イスラム文化圏や儒教文化圏の国が多い。一方、クラスター1(西洋)は、ヨーロッパのプロテスタント、カトリック、正教会の国々の割合が多い。

(b)3大クラスタ(西洋、東方、南方)ーのAMCE zスコアの平均値

3つのクラスターの AMCE z スコアの平均値をレーダープロットすると、9つの属性に沿ったクラスター間の顕著な差異パターンが明らかになる。例えば、南部クラスターに属する国は、他のクラスターに属する国に比べて、「女性を惜しむ」傾向が強いことがわかる。

国レベルでの予測因子

モラルマシンによって明らかにされた選好は、国による文化的・経済的な差異と高い相関があることがわかりました。これらの相関は、私たちのサンプルが自己選択的であるにもかかわらず、このプラットフォームの外部妥当性を支持するものです。これらの相関の背後にある究極の理由やメカニズムを突き止めようとはしませんが、国による違いや前節で特定したクラスターをより深く説明する可能性があるため、ここに記録することにします。

例として、モラルマシンから抽出された道徳的選好からみた米国と他国との距離(MM距離)を考えてみましょう。図4(c)は、このMM距離と世界価値観調査によるアメリカとの文化的距離の間に大きな相関(相関係数=0.49)があることを示しています。つまり、アメリカとの文化的な距離が近い国ほど、モラルマシーンの挙動も似ていることがわかります。

MM距離:モラルマシン距離、のことだと思われる。もちろん本論文のみの造語で一般的なものではない。

世界価値観調査:世界の異なる国の人々の社会文化的、道徳的、宗教的、政治的価値観を調査するため、社会科学者によって現在行われている国際プロジェクトである。調査の結果はインターネットによって閲覧できる。(wikipediaより)

次に、モラルマシン選好の文化的・経済的な予測因子として、4つの重要なものを挙げます。まず、個人主義的な文化と集団主義的な文化の間に系統的な違いが見られます 。個人を大切にする個人主義文化圏の参加者 は、より多くの人物を大切にすることを強く希望します(図4(a))。さらに、年長者への敬意を重視する集団主義文化圏の参加者は、「若い人物を惜しむ」傾向が弱くなります(図4(a))。このように、個人主義的な文化と集団主義的な文化の違いは、機械倫理の普遍化にとって重要な障害となる可能性があります。

政策立案者が考慮すべきもう一つの重要な(しかしあまり議論されていない)問題は、歩行者が法律を守っているのか違反しているのか、ということです。違法に道路を横断している人は、合法的に横断している歩行者と同じ保護の恩恵を受けるべきなのでしょうか。それとも、他の倫理的優先順位と比較して、彼らの保護の優先順位をいくらか下げるべきでしょうか。その結果、豊かさ(一人当たりGDP)とルールや制度の質(法の支配)は、違法横断する歩行者に対するより高い選好と相関することがわかりました(図4(b))。つまり、貧しく制度が脆弱な国の参加者は、違法横断する歩行者に対してより寛容です。これは、ルール遵守率が低く、ルール逸脱に対する罰が弱いことを経験しているためと思われます。ここからわかることは、例えば、"モビリティリスクの発生に関与する当事者は、非関与者を犠牲にしてはならない "という最近のドイツの倫理ガイドラインの一般化可能性を制限するものです。

最後に、今回のデータから、人口統計学的な理由で特定の人物が好まれる嗜好のセットが明らかになリました。まず、国レベルの経済格差(ジニ係数)が高いほど、異なる社会的地位のキャラクターが不公平に扱われることが観見られます。富裕層と貧困層の経済的平等性が低い国の出身者は、モラルマシンでも富裕層と貧困層をより平等に扱っている。この関係は、不平等が人々の道徳的選好にしみ込んでいるためか、あるいは、より広範な平等主義規範が、その国が社会レベルでどの程度の不平等を許容しているか、そして参加者がモラルマシーンの判断でどの程度の不平等を支持しているかの両方に影響しているためだと思われます。第二に、モラルマシンにおける男女の扱いの違いは、国レベルの健康と生存の男女差(得点が高いほど、女性の平均寿命と出生時の性比が高いことを示す合成指標で、女性の幼児虐殺や女性の性選択的堕胎の指標)と対応します。ほぼすべての国で、参加者は女性の人物を好むが、女性の健康状態や生存率が高い国ほど、その傾向は強いです。つまり、健康状態や出産時の女性の命が軽んじられていないところでは、モラルマシンの意思決定において、男性はより消耗品とみなされるのです(図4(e))。

ディスカッション

人類の歴史において、リアルタイムの監視下以外で、誰が生きるべきか、誰が死ぬべきかを一瞬のうちに機械が自律的に決定することを許したことは一度もありません。私たちは今にもその橋を渡ろうとしています。それは、遠く離れた軍事作戦の舞台で起こるのではなく、私たちの生活の最もありふれた側面である日常の交通手段で起こるのです。自動車に倫理的な判断をさせる前に、私たちは世界規模で会話をし、道徳的なアルゴリズムを設計する企業や、それを規制する政策立案者に、私たちの好みを伝える必要があるのです。

モラルマシンは、このような会話を始めるために導入され、世界中から何百万人もの人々が意見を寄せました。回答者は、自分たちが従うべき倫理の枠組みについて、望めばいくらでも簡略化することができましたし、徹底することもできました。モラルマシンで使用されている9つの変数すべてに複雑な重み付けをすることも、「車は常に前進させる」といったシンプルなルールを採用することも可能でした。私たちのデータは、たとえ最終的に政策立案者によって支持されなかったとしても、ユニバーサルマシン倫理の議論の構成要素となりうる3つの強い選好、すなわち「人の命を惜しむ選好」「より多くの命を惜しむ選好」「若い命を惜しむ選好」を明らかにするのに役立ちました。性別や社会的地位に基づく選好は国によってかなり異なり、平等主義に対する社会レベルの選好を反映しているように見えます。

モラルマシン・プロジェクトは、多くの点でこれまでにないものでした。それは、その目的と野心においてこれまでにないものでした。200カ国以上において、9次元の実験デザインを用いて道徳的選好を測定しようとした研究は、これまでありませんでした。この珍しい目的を達成するために、私たちはバイラルオンラインプラットフォームを展開するという珍しい方法を採用し、膨大な数の参加者にアプローチすることを望んだのです。これにより、全世界の数百万人からデータを収集することができました。これは、通常の学術的な調査手法ではほぼ不可能であり、コストもかかることでしょう。例えば、何百もの国で全国を代表する参加者のサンプルを集めることは既に非常に困難ですが、これらのサンプルそれぞれで9要因デザインをテストすることは不可能に近いことです。私たちのアプローチは、これらの困難を回避することができましたが、その欠点は、サンプルが自己選択され、各国の社会人口統計と正確に一致することが保証されていないことです。我々が観測した社会横断的な変動が、以前に確立された文化的クラスターと一致すること、また、マクロ経済変数がモラルマシンの反応を予測するという事実は、我々のデータの信頼性について良いシグナルとなります。しかし、私たちのサンプルが代表的であることを保証するものではないという事実は、政策立案者が我々のデータを社会的・文化的・経済的な側面に関する最終見解として受け入れるべきではないことを意味しています。たとえ私たちのサンプルが、インターネットに接続され、技術に精通し、無人運転技術に興味を持ち、初期導入に参加する可能性が高い人々に間違いなく近いとしてもです。

私たちのようにサンプル数が多い場合でも、AVのジレンマの複雑さをすべて正当に評価することはできませんでした。例えば、私たちは登場人物の運命に関する不確実性を導入しなかったし、これらの登場人物の分類に関する不確実性も導入しませんでした。シナリオでは、登場人物は100%の確率で大人、子供などと認識され、生死の結果も100%の確率で予測されています。これは技術的には非現実的な仮定ですが、プロジェクトを扱いやすくするために必要なことでした。同様に、回答者と登場人物の間の仮想的な関係(親族、配偶者など)も操作していません。我々の以前の研究では、この変数が道徳的選好に強い影響を与えることは発見されていません。

実際、私たちは機械倫理の課題を、私たちが正しいと信じるもの、あるいは間違っていると信じるものをコミュニティとして決定し、機械が人間とは異なり、これらの道徳的選好に間違いなく従うようにするまたとない機会として取り入れることができるのです。モラルマシンで示された最も強い好みでさえ、文化的にかなりの差異があり、私たちのプロジェクトは、倫理的判断の文化的差異を調査する長い伝統の上に成り立っています 。しかし、世界の幅広い地域で相対的な合意が見られたという事実は、合意による機械倫理への旅が最初から絶望的なものではないことを示唆しています。アシロマAI原則(訳注:2017年、人工知能研究の将来を討議した会議において発表されたガイドライン。 人工知能が人類全体の利益となるよう、倫理的問題、安全管理対策、研究の透明性などについて23の原則としてまとめたもの。 アシロマは米国カリフォルニア州の地名)など、知的機械のための広範な倫理規範を制定しようとする試みは、しばしば機械倫理を人間の価値観と一致させるべきであると勧告しています。しかし、これらの規範では、人間が道徳的な領域で内面的な葛藤や対人関係の不一致、文化的な異質さを経験していることをほとんど認識していません。ここでは、このような葛藤、意見の相違、異質性が、重要であるにもかかわらず、致命的でない可能性があることを示しました。

この記事が気に入ったらサポートをしてみませんか?