社会問題にもなったAIのバイアスはなぜ起きる? リサーチャーが解説

人間の勘や経験値に頼っていたことを、AIに任せる動きが広がっています。一方、アルゴリズムによるバイアス(偏り)のせいで、人種、性差別などにつながる事態も起きています。

人間社会のバイアスが、なぜAIにも反映されてしまうのか。

「機械学習は集められたデータセットが『世界』のすべて。集めやすい、すなわちマジョリティのデータが優先されやすい構造になっているのが一因」

AIの研究開発に携わるリサーチャー・白川達也はそう言います。詳しく解説してもらいました。

AIのバイアスがもたらした数々の社会問題

白川)AIを研究開発し、サービスに実装する企業が増えるにつれて、バイアスが原因で社会問題を引き起こす事例も増えてきました。最も有名な事例のひとつは「Tay(テイ)事件」でしょう。マイクロソフト製のAIチャットボットの「Tay」が悪意のあるユーザーによって差別表現などを学習し、Twitterでヘイト発言を繰り返し炎上。リリースからわずか約16時間後にサービス停止になりました。

ほかにも、Google Photoが黒人をゴリラと誤認識したり、Amazonが開発していた履歴書をチェックをするAIが、女性に不利な評価をしたりしていたことなどが判明し、開発中止になりました。さらに「Gender Shades」という研究プロジェクトでは、既存の顔認識サービスはバイアスを持っており、黒人女性に対する認識精度が極端に低くなってしまうことも報告されています。

このように、推論の精度はターゲットによって変わりうるし、その裏には社会的問題につながるようなバイアスが潜んでいると考えられます。

バイアスはどこで生じるのか

こうしたバイアスはAIの機械学習を行う際に生じると考えられます。なぜ、どうやってバイアスが生じるのか、について解説します。

機械学習とは、与えられたデータの中から隠れた構造やパターン、有用なルールや知識表現を自動的に獲得する技術です。ディープラーニングも機械学習のひとつ。今、「AI」ともてはやされているものは、ほぼ「機械学習」のことを指しています。

機械学習の手法として最も典型的なのが「教師あり学習」というフレームワークです。

たとえば犬と猫を判別するモデルを作るとします。まず犬や猫が写った画像を集める。次に、それぞれの画像に「犬」と「猫」という正しい答えをつけていく作業(アノテーション)をします。そしてコンピュータにそれを学習させ、画像に映っているのが猫なのか犬なのかを推測するモデルを作ります。あとは正しい結果が得られるようにパラメータをひたすらチューニングします。同じような作業を経ていくつかモデルを作り、それらを最終的に評価して、最も使えるモデルが実際に運用されます。

AIは学んだデータが「世界」のすべて

この「教師あり学習」で作られるモデルが、鉄腕アトムやドラえもんのような賢いものだと想像している人も多いのですが、そういうものではありません。

機械学習を例えるなら、生まれたばかりの赤ちゃんを暗室の中に閉じ込めて動かないようにさせ、犬のラベルと猫のラベルがついた画像をひたすら見せて学習させているようなものです。よって、人間の知能とは趣がまったく異なるのです。

モデルにとって「世界」とは、学習に使ったデータだけがすべてです。それ以外は、学習していないので推測もできません。よって、機械学習のモデルにとってはかなり単純で原初的な世界が広がっているわけです。

データの収集、アノテーション、学習、評価とすべての段階でバイアスが入る可能性がありますが、中でもモデルに最も大きな影響を及ぼし、のちに社会問題になりやすいのは、収集・選択されたデータ自体に存在するバイアス(データセレクションバイアス)だと考られています。赤ちゃんにとっての「世界」そのものを作るフェーズだからです。

データセレクションバイアスでよくやり玉に上げられるのが、「顔画像処理モデル」です。

この研究(上図左側)で使われている顔画像は、基本的には西洋人のデータです。ゆえに、それ以外の黒人や東南アジア人などの人種の顔認識の精度は低くなりがちです。顔画像を元にした年齢推定の場合も、20~40代のデータが多いので、モデルは世界には20~40代しかいないという認識になります。データが特定の年齢に偏っているせいで、それ以外の世代、子どもや高齢者の年齢推定の精度が低くなってしまうのです。

研究者の間でもこの問題は注目されています。画像処理系の主要国際学会のひとつ、CVPR(Computer Vision and Pattern Recognition)でも、顔画像解析でのバイアス問題について真剣に考えていこうというワークショップが開かれました。今後も、バイアス問題の技術的な解決に向け、活発に議論されていくでしょう。

集めやすいデータ=多数のデータ。バイアスの一因?

これまで話してきたとおり、モデルは最初に集められたデータセットが「世界」のすべてです。そのデータセットは集めやすい、つまり、マジョリティのデータが優先されやすい構造になっている。これがバイアスの一因になっています。

「マイノリティのデータセットをもっと集めて学習させればいい」という意見も当然出てくるでしょう。ただ、その存在に気づくのが難しいからこそマイノリティであるわけです。また、集めようとしてもプライバシー保護の問題が立ちはだかるなど、マイノリティだからこそデータセットを集めるのが難しい面もあります。

機械学習とバイアスの問題はかなり相反する要素がある。残念ながら、解決は非常に難しいのが現状です。

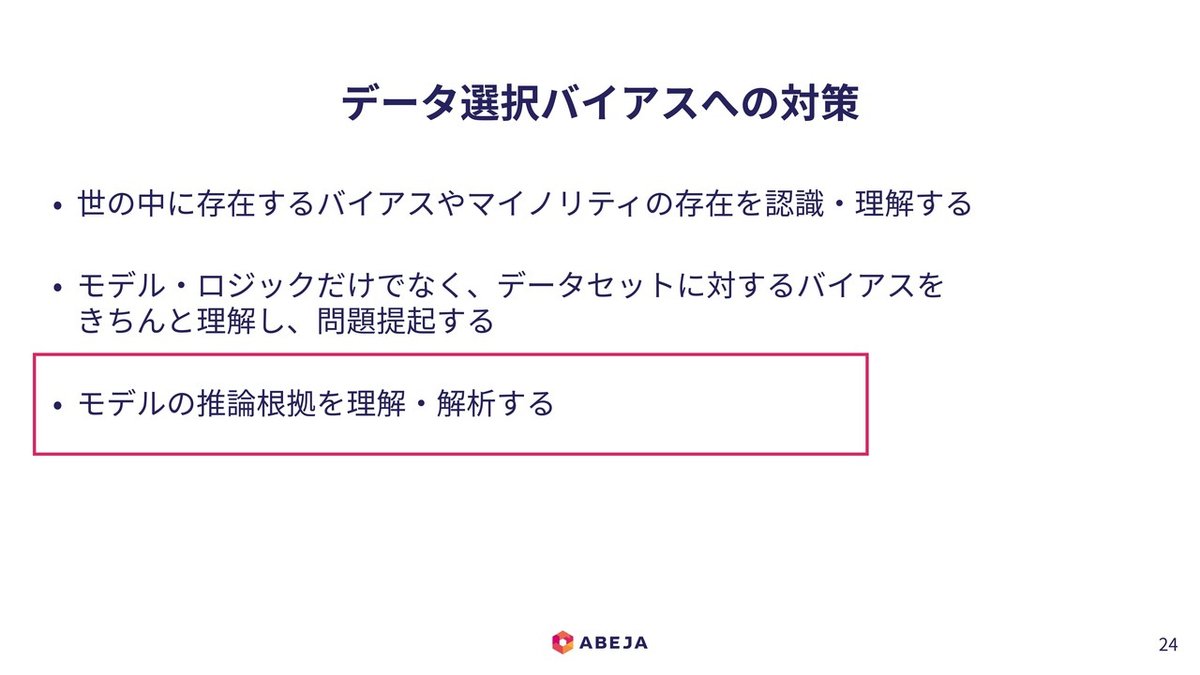

対策の一つは人間社会のバイアスを認識すること

とはいえ、いくつか有効策はあります。

1つ目は、世の中にはどんなバイアスやマイノリティが存在しているのかを正しく認識、理解すること。バイアスは、もともと人間社会の中にあるからです。その上でマイノリティに不利益を被らせないようなデータセットを作ることです。

2つ目は、データセットに存在するバイアスをきちんと理解し、問題提起すること。残念ながら、モデルやロジックがやり玉に上げられて炎上するパターンが多いのですが、その元には必ずデータセットが存在します。それがどのように作られているのかに焦点をあてて議論すべきでしょう。

3つ目はモデルが変な推論結果を出したときに、その根拠を考え、理解・解析すること。いくつか研究があるので紹介します。

機械学習モデルの判断根拠の難しさ

機械学習でのバイアス問題は、まず膨大なデータの中にバイアスが含まれているかどうかを把握するのが難しいという点があります。とはいえ、バイアスがまったくないデータを用意するのも現実問題として難しい。このためモデルがどう動くのかをつぶさに観察しようということになります。

ただ、昨今のディープニューラルネットワークのようなモデルはとても複雑にできているので、ブラックボックスに近い。なぜ、そのような推論をしたのか理由が説明できなかったり、説明できたとしても、人間が期待するような推論プロセスを踏んでいないこともあります。

困難ながらも、ディープニューラルネットワークの推論プロセスの可視化と解釈を目指している研究がいくつかあります。

具体的には象のどこに注目しているかという点や、テキスト(文字情報)のどの単語が効いているかという点を分析し、赤や青で色をつけて判断根拠を表示します。これが現状の判断根拠のレベルです(下図)。

ディープラーニングのような大量のデータから学習する手法では、モデルの複雑さと推論結果の精度、納得できる判断根拠を示せるかどうかという「解釈可能性」は、トレードオフの関係にあります。つまり、モデルがシンプルになれば推論プロセスもシンプルになり、判断根拠がわかりやすくなるかわりに、推論精度は低くなります。それでは実装に耐えられないので、推論精度を高めるために、解釈可能性を犠牲にしている面があるのです。

もうひとつの難しさは、解釈できたつもりでも実際は表面的、推測的すぎることがある、という点です。ディープニューラルネットワークなどの複雑なモデルでは、判断根拠が示されていったんは納得したとしても、再度疑って詳細に解析すると、モデルが想定外のプロセスで推論していたことが分かるケースもあるのです。

その具体例を紹介します(上図)。先ほど説明した通り、基本的には推論根拠はモデルが注目している部分がヒートマップで示されます。スライドの上の列の画像では猫の部分にフォーカスが当たっていて、下の列の画像も犬の部分がフォーカスされているのがわかります。これを見て「ちゃんと猫や犬に対してフォーカスが当たっているな」と理解するのですが、納得しない研究者がいました。

スライド(上図)で説明すると、一番左が象のテクスチャ(肌の質感)の画像。真ん中が猫の画像。一番右の写真が猫の形でテクスチャを象に変えたものです。一番右の写真を見て人間はだいたい「猫」と答えますが、我々がよく使う画像認識データセット「ImageNet」で学習されたモデルは「象」と答えたのです。

ImageNetで学習されたディープニューラル・ネットワークのモデルが見ているポイントを詳細に解析したところ、オブジェクトの形ではなくテクスチャを見ていた。猫の部分にフォーカスが当たっているかいないかはひとつの判断根拠にはなっているのですが、実は人間とはまったく違うロジックで動いていることがわかってきたのです。

ディープニューラルネットワークはなんとなく人間の認知に近づいてきたなと思っていたところ、裏を見てみるとそうではなかった。まったく人間らしくないプロセスで学習されているので、人間の直感とは似ても似つかないような規則で推論しているエイリアンのようなものだったのです。

このように、一概にモデルの解釈可能性の明示といっても難しいのが現状ですが、個人的には興味深く感じている点でもあります。いろいろな研究成果も出始めているので、もう少し深堀りしていきたいと考えています。

白川達也(しらかわ・たつや)ABEJA Labs リサーチャー。京都大学理学部卒業、同大学院理学研究科数理解析専攻中退。機械学習、ディープラーニングを中心にシーズ技術の開拓や研究開発を行っている。最近は機械学習を通じた現象理解に興味があり、とくに人のこころを機械学習的に描いてみることでどんな理解ができるか模索中。

ABEJAはこの春から「ABEJAコロキアム」を始めました。識者や実務家を講師に招き、記者や編集者たちが社会とテクノロジーの交差点にあるテーマを議論する「学びの場」です。第2回(2019年7月30日)のテーマは「AIのバイアス、その在り処」。本記事はその模様を編集しています。

取材・文・写真:山下 久猛

Torus(トーラス)は、AIのスタートアップ、株式会社ABEJAのメディアです。テクノロジーに深くかかわりながら「人らしさとは何か」という問いを立て、さまざまな「物語」を紡いでいきます。

Twitter Facebook

【Torusの人気記事】

未来食堂・小林せかいさんが向き合う 「正しさ」への葛藤

「貧困の壁を越えたイノベーション」。湯浅誠がこども食堂にかかわる理由

「当事者のエゴが時代を変える」。吉藤オリィが参院選で見たある風景

人気ブックデザイナーが考える 「いい装丁」とは?

イタリア人医師が考える、日本に引きこもりが多い理由

「僕は楽しいからそうする」。大学の外で研究する「在野研究者」たち

「性欲は、なぜある?」が揺るがす常識の壁

この記事が気に入ったらサポートをしてみませんか?