エントロピー超概要メモ

自分の理解の整理のためのメモです、初学者の方のご参考になれば幸いです、文末の参考書籍は本格的に知りたい方にオススメです。

エントロピーはいろんな分野で使われていますが、当文書では情報理論で使われるエントロピーの説明を試みています。

情報量とエントロピー

情報を数値で表現するために使われるのが情報量とエントロピーです。

情報量 : 特定の事象を観測した時に得る情報量を表します

エントロピー : 確率分布に従い発生する事象を観測した際に得る情報量の期待値

情報量

情報量は下記の性質を持っています。

1.情報量は事象の発生確率によって決まる

情報量の算出には事象の発生確率が必要です。

サイコロを例に説明すると

1の目が出る確率 : 1/6

奇数の目が出る確率 : 1/2

2.発生確率の低い事象の情報量は大きい

珍しい事象の方が情報として価値が大きいという考え方です。

この考え方に従うと発生確率の逆数を入力として使うのが妥当です。

サイコロを例に説明すると

1の目が出る 確率の逆数 6

奇数の目が出る 確率の逆数 2

3.情報量の加算が可能

最終的に得る情報が同じなら、観察の経過によらず情報量の和は等しい。

対数を使うと、この条件が満たせます。

サイコロを例に説明すると

a. 一括観測

出た目が1と確認 log 6

b. 段階観測

(1) 出た目が奇数と確認 log 2 (2: 奇数の確率1/2の逆数)

(2) 出た目が1と確認 log 3 (3:3つの奇数の1つの確率1/3の逆数)

aの情報量とbの(1),(2)の加算結果が等しい事を確認

log 6 = log 2 + log 3

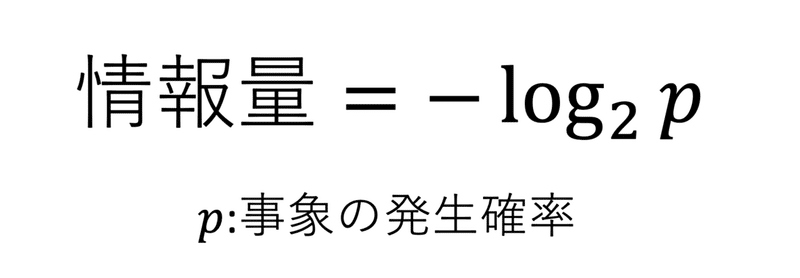

情報量の数式

こちらが情報量の数式です

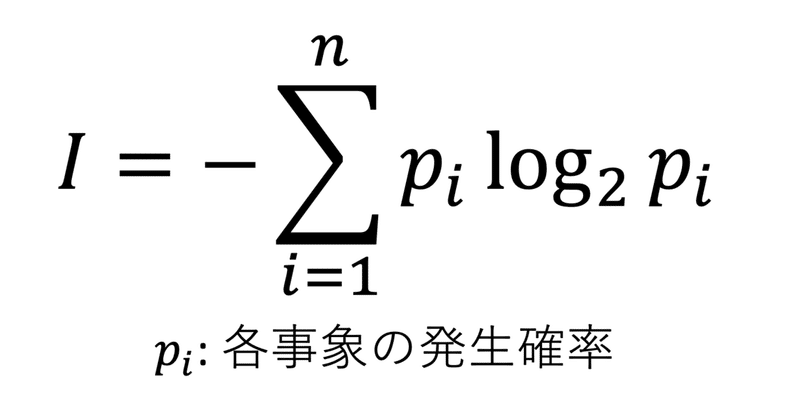

エントロピー

ある確率分布に従う複数の事象候の、どれが発生したかを教えてもらう際に得る情報量の期待値がエントロピーです。

こちらがエントロピーの数式です。

対数の底を2にするとエントロピーは情報の転送に必要な平均ビット数になります。

以下、いくつか例を見てみましょう。

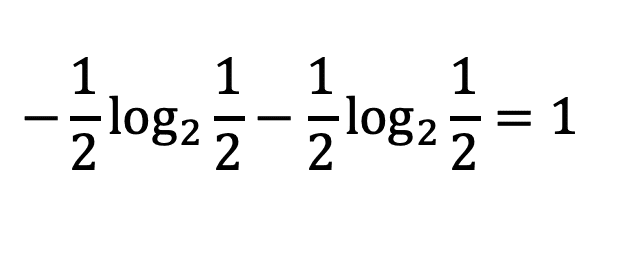

2つの等確率の確率事象のエントロピー

0,1を送るのに必要なビット数は 1

0,1

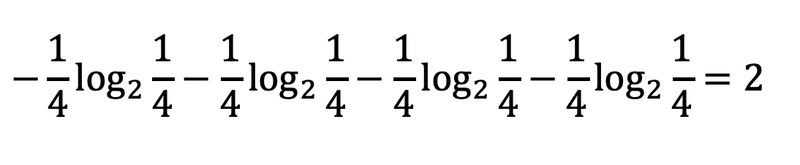

4つの等確率の確率事象のエントロピー

4つの等確率の確率変数の状態を送るのに必要なビット数は 2

00,01,10,11

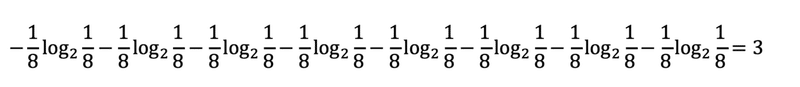

8つの等確率の確率事象のエントロピー

8つの等確率の確率変数の状態を送るのに必要なビット数は 3

000,001,010,011, 100, 101, 110, 111

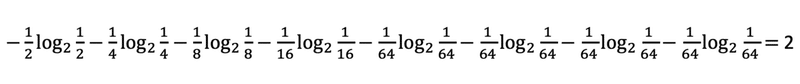

8つの異なる確率の確率事象のエントロピー

事象の発生確率を変えるとエントロピーも変わります。すべての事象が等確率の場合にエントロピーは最大になります。

参考書籍

微積分、指数対数、確率に関する基礎知識をお持ちの方であれば、この本の第1章を読めば情報量とエントロピーの概要が掴めます。

異なる確率の確率事象のエントロピーはこちらの本の p49 の例を使わせていただきました。

Photo by Jon Toney on Unsplash

この記事が気に入ったらサポートをしてみませんか?