Googleの新スマートフォンPixel 3の「夜景モード」が問いかけるもの(あるいはAIとはなんなのかという実感について)

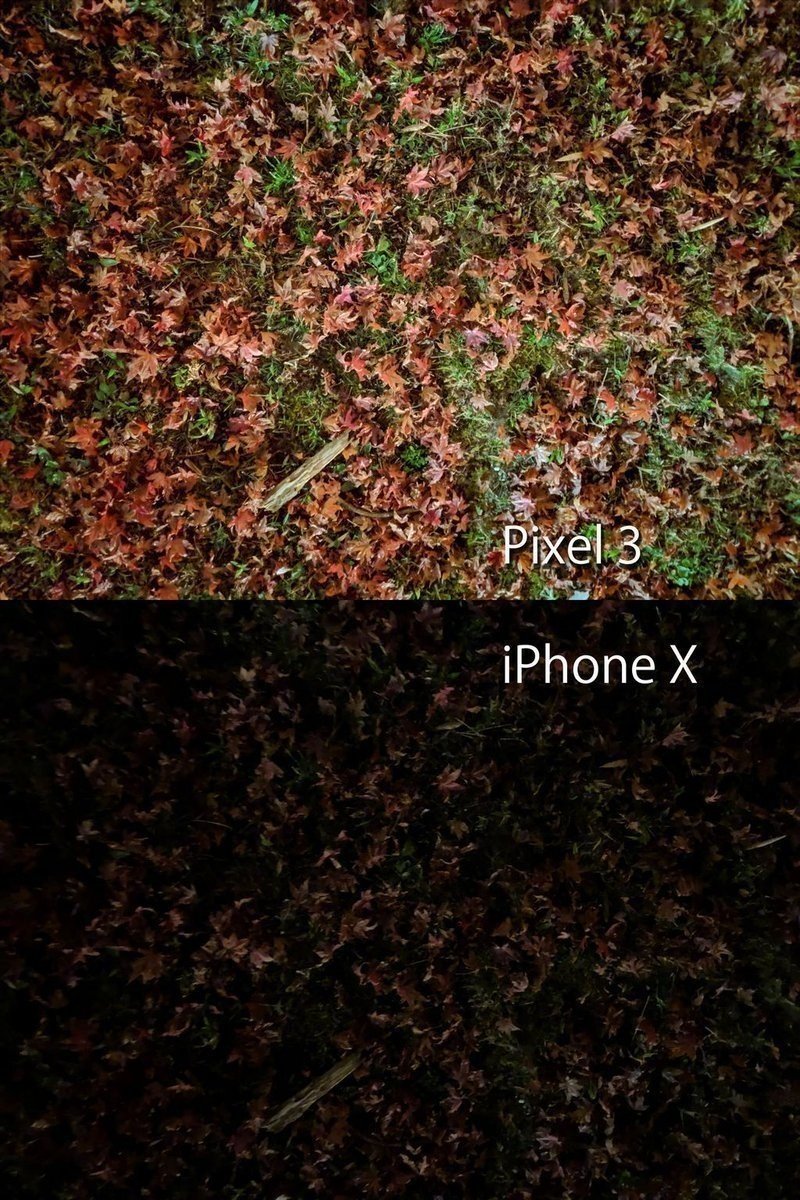

たまにはカメラのレビューなんていう、フォトグラファーっぽいこともしてみますね。といっても、普段はカメラの記事を書くときって、大体カメラ会社が作ったボディやレンズに関する記事を書くことが多いのですが、今回は話題のスマホPixel 3のカメラ、しかも鳴り物入りで搭載された「夜景モード」だけに限定した超ニッチな記事です。でも、このニッチに思える画像技術は、これから先の写真の方向性をもしかしたらすごく変えちゃうかもしれない。そう思うほどに、今回のPixelが搭載した「夜景モード」は、衝撃的な機能でした。まず、その違いを是非画像でご確認ください。Twitterにもアップしましたが、iPhone Xとまったく同じ時間、同じ場所で撮影した写真を並べたものです。

撮影場所は比叡山の途中にある駐車場で撮影したものです。すっかり日も暮れてあたりは真っ暗な中、少し離れたところから僅かな光が足元に届く程度。手元はもう見えないくらいの輝度です。その中で撮った二枚の写真。現実に近いのはiPhoneの方です。光の少ないところで写真を撮ると普通は暗い写真しか撮れない。でもPixelの方は、まるでそこだけ光を当てたような明るさです。もちろん、光なんて当てていません。PixelとiPhoneを並べて、「せーの!」で同時にシャッターを押した結果がこれなんです。これがPixelの夜景モードの驚愕の性能です。

Twitterの方でも一連の内容をささっと書いたのですが、おそらくPixelがやっていることは、これまでフォトグラファーが時間をかけてやっていたプロセスそのもののようです(詳しくはTHE GUILDのGo Andoさんの一連のツイートが参考になります!)。三脚を立てて、違う露出の写真を何枚か(何十枚か)ブラケットで撮影し、それをPhotoshop上でならべてレイヤー化し、レイヤーマスクをそれぞれの不要な部分にかけながら、露出の美味しいところだけを合成するという、あの一連の露出合成の流れです。それは一眼レフとパソコンとPhotoshopでやれることそのものです。

「じゃあ一眼でできるじゃん?」

そのとおりです。

でも、あのでかい一眼レフで、でかい三脚に載せ、何十枚か撮影したデータをパソコンに取り込んで、それをPhotoshopで展開し、レイヤー合成をして一枚の写真に仕上げるのにかかる手間は、少なく見積もっても数時間。それが約3秒程度で終わります。同じ場所で撮影したもう一つの写真がこれ。

iPhoneが過剰にホワイトバランスを「ホワイト」にしようとする癖がある一方、Pixelのホワイトバランスは人間の記憶色に近づけようとする傾向がありますが、そういうカメラ・写真的なあれこれよりも、問題は後ろの夜景です。その部分だけ拡大してみました。

左がiPhone、右がPixelです。この差は凄い。もちろん、いまだ本質的な画質というのは一眼レフのフルサイズだとか中判といったセンサーサイズの大きなカメラには負けますが、それら本格的なプロ用カメラのセンサーサイズと「似たような」発色をPixelで撮った方の夜景が出しているんです。本来なら取り込めないはずの遠い遠い場所の光と色を、何十枚も撮影したデータの中から拾い集めて、最適な色を判断して構成し直しているのでしょう。このえぐさ、この極限の技術、おわかりになりますでしょうか。さすがソフトウェアの巨人、Googleです。

ここに人類史をおそらく書き換える21世紀のビッグワードである「AI」という言葉の持つ本質がよく現れていると思うんです。AIは、これまで人間がやってきたことを極めて効率よく、極めて高品質に、極めて高速にやれる、いわば人類の「上位互換」を目指して作られているわけです。シンギュラリティと呼ばれる技術的特異点を経由したあと、人類は「霊長」の座から引きずり降ろされることが想定されておりますが、そういう未来の話はさておき、AIは「我々人類の延長」であって、「今の所、まったく異なった発想や創造をする存在ではない」というのが、この写真からよくわかります。この夜景、何か違った色を加えたり、作ったりしている感じではないんです。だってこの故郷の夜景、僕が長年この場所から見ていたものだからです。この小さく潰れた、まだ画質的にはフルサイズに圧倒的に負けるはずのPixelが、夜の闇から構成した色は、僕が知っている大津市の夜景のカラーバランスを構成している。それが、今回一番、僕が畏怖を感じた瞬間でした。「ああ、これがAIなのか」と。

話をもとに戻しましょう。夜景モード。何気なく同じ場所でもう一枚、広めに撮ったんですよね。で、驚愕しました。Pixelの方の左上を見てください。

オリオン座写ってるし!左上の星ベテルギウスのほんのりオレンジ色まで再現してるし!!!

ここまで写ってしまうと、今後のカメラの新しい方向性が出てきたなあと感じます。つまり、物理限界をソフトウェア処理で打破していくという方向性。それはカメラや写真のあり方を根本的に変えていくことと思います。

これまでのカメラ会社が強かったのは、「物理」の部分、つまり光学的なレンズを作るノウハウや生産ラインを押さえているから強かったわけですが、今回Googleが示しちゃったのは、物理レンズがたいしたことなくても、あるいはセンサーが小さくても、何十枚も何百枚もその場で撮ったデータから一枚を仕上げるならば、そのデータを処理するソフトウェアの精度が上がっていけば、いずれはその処理の精度は物理限界を打ち破ってしまうかもしれないということです。だって今回のこの「夜景モード」、最新のPixel 3だけじゃなくて、過去のPixelでも使えるようになってるんですよね。メカが貧弱でも、データさえあればソフトウェアがそれを適切に補完しちゃえるということを意味しています。

しかも、外側向けに撮るレンズの方は今スマホのカメラで流行りの「二眼」でさえないんです。Googleの二眼は、インカメの方に向けられてる。セルフィー用なんです。それが何を意味するかわかりますか。Googleがものすごく人間のことを、世界のことを、カメラのことを研究しているということです。

人間の腕というのは短い。短い距離でセルフィを撮ると、せいぜい一人か二人しか撮れない。もっと広く写したいと思っても、人間の腕の長さは変えられない。それはつまり、インカメでは撮れる範囲が極端に限られて、撮れないものが出てくるということです。パーティーでセルフィやったら、端っこで入らない人出てきますよね。だからPixel3はインカメを二眼にして、より広い範囲を写すようにした。なぜか。「写らないものは、AIでもどうしようもない」から。外側のカメラは、距離さえあればいくらでも無限に世界を写すことができますが、セルフィはどんなに長い腕の人でも、せいぜい1メートル。背面カメラではなくインカメを二眼にして広角化するほうが、理屈にかなっています。

逆に言えば、写っちゃえばなんとかなるんですよ。今は無理でも、いつか(多分もう数年後)、手ブレ写真だろうとなんだろうと、キリッとしたノイズレスな写真がAIによって補正される世界が来る気がします。「画質はソフトウェアでなんとでも処理できる」からです。写っちゃえば、いずれ世界はすべて思い通りに再構成できる。Googleの不敵な自信を、インカメの二眼に見た気がしました。

というわけで、実は使えば使うほど、僕はワクワクしてきたし、また少しだけ畏怖も感じました。「遠い未来」と思っていた世界は、意外と結構近いところに来ているのだというのを、はじめて体感として感じたんです。他ならぬ「写真」と「カメラ」という、自分にとってとても親しい経験を通して。

昨日今日と、京都の有名なお寺に仕事帰りに寄りました。京都のお寺はほとんど三脚が使えないので、これまで一眼レフで撮るときは色々苦労があったんですが、Pixelならポケットから出してシャッターを一枚切るだけです。こんなにうってつけの被写体は他にないと思うほどの結果が下の二枚です。

感じるのは「こういう定番構図を撮るなら、もう一眼レフはいらないかも」という、危機感にも似た驚愕でした。ホワイトバランスは人間の記憶色に近く、「確かにこういう感じだった」と思わせる自然な仕上げです。これが、あと数年したら、多分全てのスマホの「標準」になります。数年どころか、1年半後くらいかな。Appleも手をこまねいてはいないはずですから。HuaweiやSamsungも追撃するでしょう。

なんとも驚愕の方向からゲームチェンジャーが出てきました。これからのカメラや写真の方向性や未来まで考えさせるPixelの進化、今後も注目です。