A/Bテストの落とし穴、アンチパターンを避けて成果を出そう

最近、LIFULLでは社内でA/Bテスト(ABテスト)の標準化に取り組んでいます。A/Bテストはデータドリブンな意思決定ができる強力な手法ですが、実施にあたっては注意すべき点が数多くあります。今回は私が過去にやらかしたA/Bテストの失敗事例を語り、これまでの経験を成仏させたいと思います。

社内の事例については、A/Bテスト標準化の管理基盤と、A/Bテストを正しく行う事前設計のフレームワークの各ブログをご覧ください。

A/Bテストのアンチパターン「その勝ち、負けの判断は正しい?」

まずA/Bテストで正しく意思決定する大前提として、A/Bテストが正しく行われている必要があります。私が過去にやらかした5つの事例をまとめました。

1.介入群の比率を少なくテストした

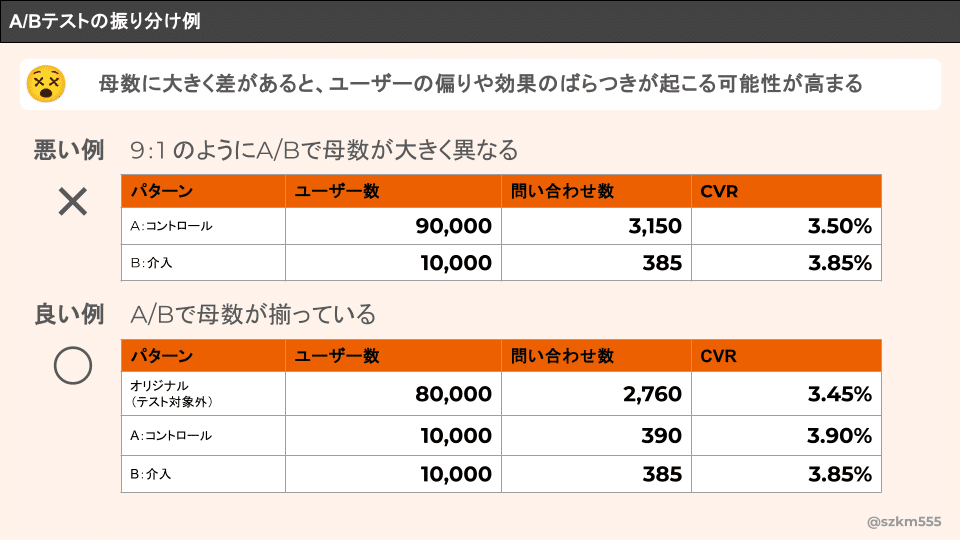

サイトの大幅リニューアルを行う際、リニューアルでどの程度数字が変化するかわからなかったため、既存:リニューアル=9:1の割合でA/Bテストをしたことがありました。

母数に大きな差があったため、ユーザーの偏りが生じたり、効果もばらつきがあり、結果の信頼性が低い状態でした。また集計のときに、ユーザー数を揃えて計算していたのも統計的に信頼できないやり方でした。

基本的には、コントロール群、介入群の比率を揃えてA/Bテストをする必要があります。

2.A/Bテストの振り分けが正しくできていなかった

50%でA/B振り分けを行っているはずが、計測でユーザーが50%にならない現象がありました。そのときは、サイト訪問時にA/Bにうまく振り分けできないユーザーの一部が影響していて、A/Bのユーザー比率が揃わない、新規ユーザーの割合がA/Bで偏るといったことが起きていました。

特に新しい開発環境や、新しいツールを利用したA/Bテストの場合は、振り分けが正しいか、計測が正しくできているかの検証やA/Aテストを並行して行うべきでした。

3.いろんな観点でデータ分析をした

経験が浅かったときは、A/Bテストでどの数字が変わるのか想定がうまくできず、A/Bテストで結果がでたあとにあれこれといろんな観点でデータ分析をしていました。念の為にサイトに訪問した全ユーザーの数字も見てみる、ユーザーのセグメントを有料集客、オーガニック、新規、既存といくつか分けて分析してみるといったことをやっていたことがありました。

仮説があって、その検証であれば問題ないですが、A/Bテストの判断であれこれ数字を用いることで都合がよい判断(チェリーピッキング)をしてしまうことにも繋がります。

A/Bテストをやると、わかりやすい数字が出るのでいろいろ見たい気持ちになります。けれど、正しい母集団で比較をしないとノイズが大きくなり、特に検証の影響を受けるユーザー群が少ない場合は、施策の効果が高かったとしても、結果に反映されません。

4.レート、率で計算できない指標を使った

A/BテストではCVRやCTRを指標にすることが多いと思いますが、事業リスクがどの程度あるのかを判断するために一人当たりのCV数や購入金額も検証に使ったことがありました。

CV数や金額はそのままでは比較ができないので、本来は難易度が高いものですが、そのときはむりやりレートにしたり数字を揃えて検証をしていました。結果は、平均のCV数が2,3回なのに対して、CV数が20回といった異常値のユーザーがA/Bで偏って発生していたためCVRでは差がないが、CV数も含めると差が大きくなりました。この結果が問題ないことの調査、ステークホルダーに対する説明にかなりの時間を使うことになりました。これは本題と少しずれますが、A/Bテストはわかりやすく数字がでてしまうため、担当者がステークホルダーにきちんと結果を説明できないと大変、、、というのもA/Bテストの弊害だなと思います。

回数を検証にいれる必要がある場合もありますが、難易度が高いです。自分たちが正しく検証できる指標を選ぶことが大切です。また、母集団に対して割合が少ない数字、ばらつきがある数字については検証することが難しいというのも理解しておく必要があります。

5.変更内容、変更箇所が多すぎる検証をした

変更箇所が多いA/Bテストは、リニューアルなどではまぁよくある話かもしれません。

コントロール群と介入群でレイアウトやステップなどのユーザー体験が大幅に変わり、検証して勝ち負けはわかったとしても、何がその要因なのかわからず。その後の改善に繋がらないことがあります。勝ったケースではさほど問題にはならないですが、負けたときのその後の動き方が難しく。コントロール群との差分を埋めていくような動きになりがちでした。

できれば、変更内容を絞って、段階的に学習をしていけるような検証が理想です。

📝まとめ、正しくA/Bテストを実施するために

ここまででご想像いただけるように、A/Bテストは簡単なようで奥が深いです。これらの点に配慮した上で実施をしましょう。

A/Bテストが正しくできるか、必要に応じてA/Aテストで検証を行う

コントロール群、介入群のユーザー数を揃える

仮説を立て、事前に検証する指標を定める

母集団に対して、割合が少ない数字や結果がばらつく数字で検証しない

過去のやらかしについては「A/Bテスト実践ガイド」に詳細な説明が書かれていました(読みやすい本ではないので専門的に勉強する方向けです)。また、A/Bテストをやってみたけれど、結果をどうやって判断したら困っているという方はExperiment Design Doc(EDD)を使うことで、その悩みは解決するので、こちらのブログをぜひ参考にご覧ください。