Turing Semiconductor/AI Day 潜入レポ

日本でテスラを追い抜いて完全自動運転を目指すTuring社の現在地を示す Turing Semiconductor/AI Dayが開催されたので潜入レポをお届けします。

イメージビデオからスタートしました。

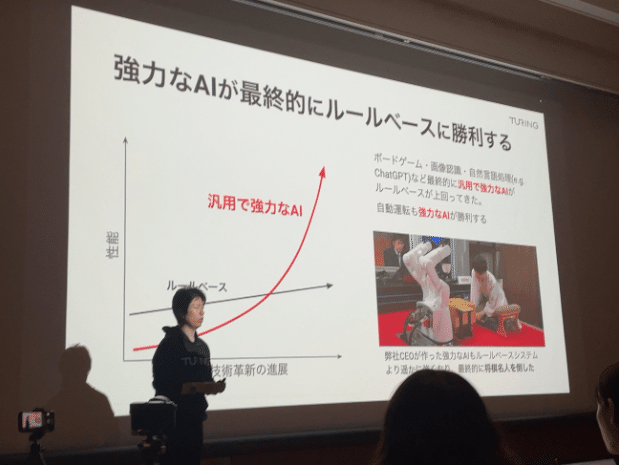

代表取締役の山本 一成さん登壇です。

いきなり、AIとカメラのみでハンドルかがないEVを作るとぶち上げました。

ルールベースではうまくいかない。

似たようなシチュエーションでも大分違う操作が必要。

車が世界を理解する必要がある。これをルールベースでやるのは大変。世界を理解するAIが必要。

マルチモーダルのHeronをリリースした。Heronは世界を大分理解している。

ルールベースではあり得ない状況に対応するのは難しい。Heronは予測できている。

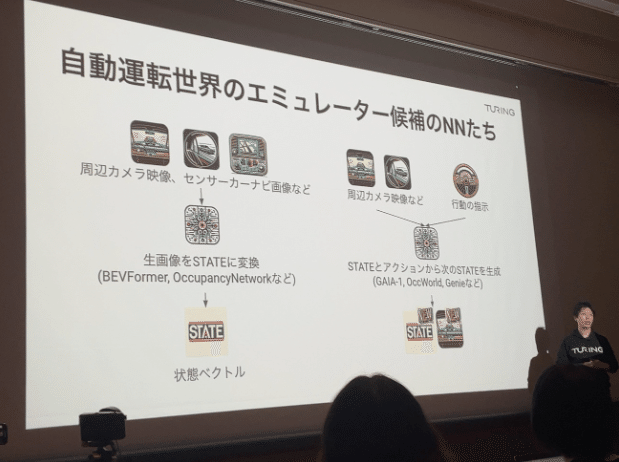

AIの歴史を少し。AlphaGoが何をしているか。画像から状態ベクトルというものを読み取る。

状態ベクトルをニューラルネット化する。ゲームの場合、エミュレーターとなる。

世界のエミュレーターを世界モデルという。世界モデルがあれば自動運転ができる。

自動運転世界のエミュレーターはカメラやカーナビ画像から予測する。

世界モデルを理解するAIで自動運転が可能となる。

来ている方で機械学習とかやっている人は力を貸して欲しい

生成AIで目指す完全自動運転

第3世代の自動運転タスク

LLMから完全自動運転へ : 山口 祐

自動運転に向けた学習戦略

政府のGENIACプロジェクトでGoogle CloudのH100×280を調達。

別に独自Gaggle ClusterでH100×96を調達

大規模AIを車に搭載する

自動運転AI: 開発の3軸

完全自動運転の「知能」を実現するマルチモーダル生成AIの開発: 井ノ上 雄一さん

Heron-X。画像だけでなく、動画、テキスト、音声、アクションなどのモーダルを扱えるようにする。

なぜマルチモーダル生成AIなのか

生成AIのコア技術Transformerの可能性

Transformerでできること。

GPT-4で車を動かすことができた。素晴らしいことだが応答時間、精度など課題がある。

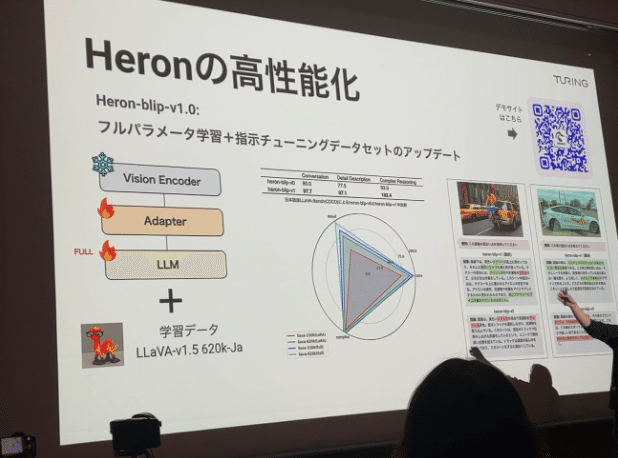

マルチモーダルAI Heron

独自データセット

Heronの高性能化

MoE-Heron

Mixture of Experts:パラメータサイズの小さい複数の専門家を配置することで推論コストを抑える。

What’s Next…

動画生成AIモデルもやります。

生成AIをエッジで実現するアクセラレーター開発: 柏屋 元史さん

Hummingbird : 生成AI用アクセラレーター半導体

なぜ半導体が必要なのか。完全自動運転を実現可能なエッジデバイスは存在しないので、ないなら作る。

データセンターとエッジの違い。電源、格納場所に制限がある。

パラメータの量子化&整数化

浮動小数点ではなく整数

量子化は 2〜8 bitの可変長で対応

モデル改良

バンド幅を削減するためにMoEを使ってモデル化する。更に多段化する。

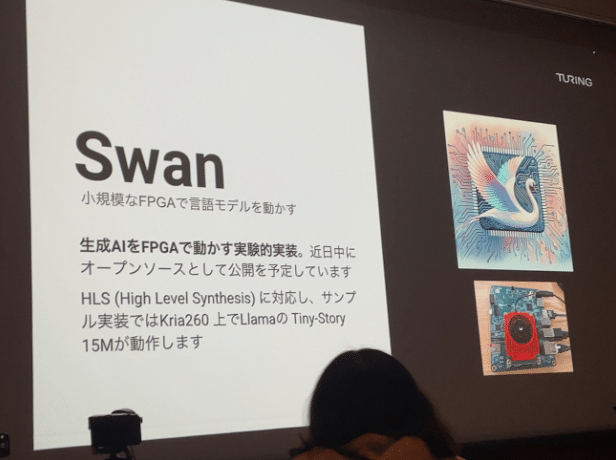

生成AI on FPGA

まずはFPGAで検証する。

Swan: 生成AIをFPGAで動かす実験的実装。オープンソースとして公開する予定。

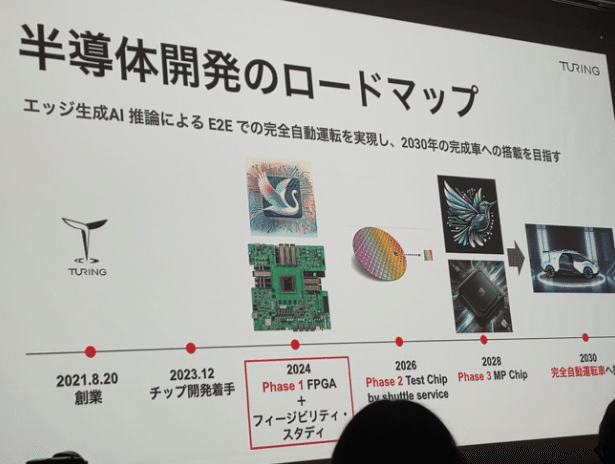

半導体開発のロードマップ

2024 Phase 1 FPGA

2026 Phase 2 Test Chip

2028 Phase 3 MP Chip

2030 完全自動運転車への搭載

End-to-Endな自動運転AIの実現 : 棚橋 耕太郎さん

Tokyo30 2025年までに、カメラとAIだけで東京エリアを30分以上、介入なしで走行し続ける自動運転モデルを開発するスローガン。

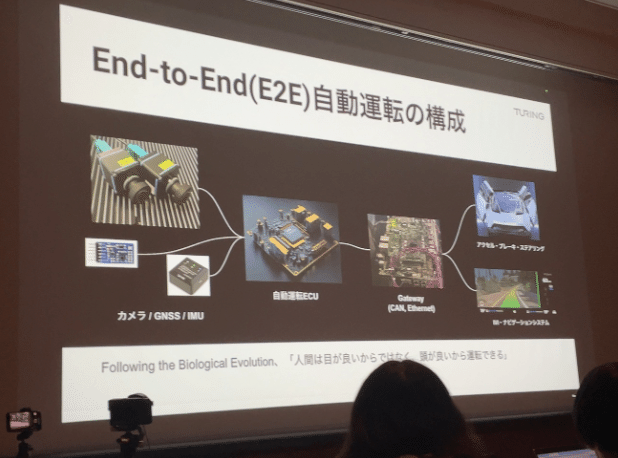

End-to-Endな自動運転の構成

End-to-Endな自動運転の構成を人に例えると

従来の自動運転システム

機能ごとに分かれたモジュールが独立して動いている。

LiDAR点群+HDマップ → Perception → Prediction → Planning → Control

End-to-Endな自動運転AI

画像から車の経路を直接出力する。

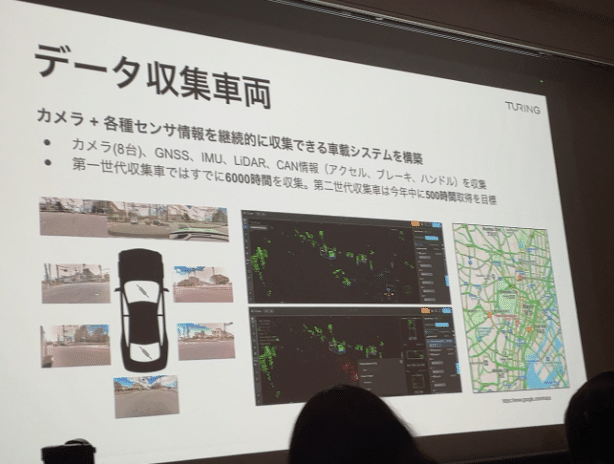

Data-Centric Approach

モデルだけでなくデータを改善することで全体の精度を高める。

良いデータを作ることで良いモデルを作る。

データ収集車両を使って、良いデータを集めている。

走行動画データ検索

走行データにラベリングした多様な学習データをベクトル検索する。

UIがあるが、実際はAPI

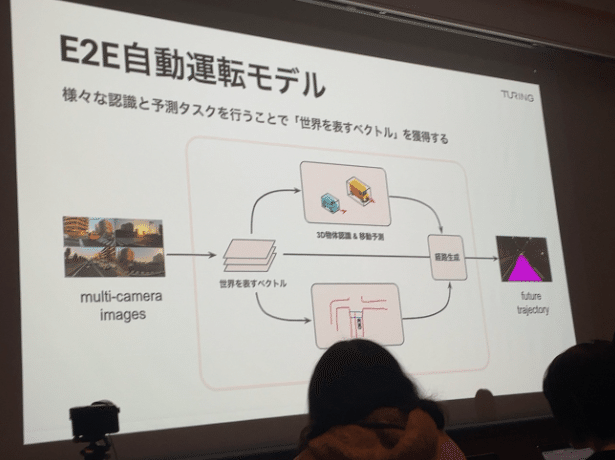

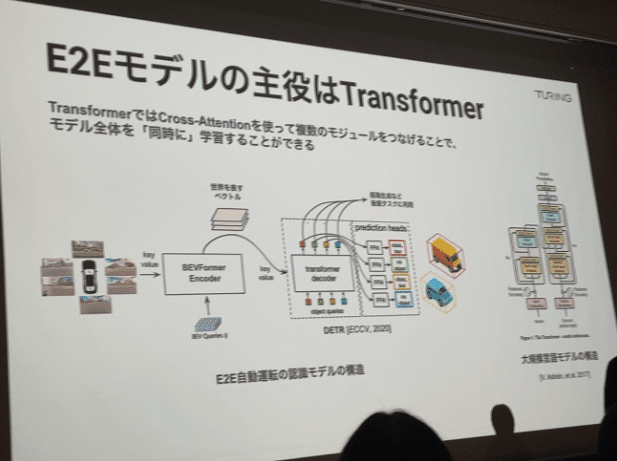

E2E自動運転モデル

世界を表すベクトルを獲得することで経路を生成する。

E2Eの主役はTransformer

モデル全体を同時に学習することができる。

ルートナビゲーション

人がカーナビを見て運転するようにカーナビの画像を入力にモデリングする。

Tokyo30タイムライン

Tokyo30 2025年までのスケジュール

Q&A

不正確です。大体こんな感じのやりとりと思って下さい。

Q: 動画生成AIのSoraとの比較して同じかどうか。

A: 基本的にTransformerを使うのは一緒。Soraは綺麗な映像を目標とするものなのでその点は異なる。

Q: Tokyo30でどこまで実現

A: End to Endで賢いことができる

Q: e2eで賢くと言うことだが、具体的に言語モデルをどう制御に結びつけるのか。

A: 具体的にはこれから。最終的にはCANの制御になる。

Q: Tokyo30ではハミングバードを使うか、それともサーバーか。

A: ハミングバードになる。

Q: 半導体の人員構成は?

A: 現在は人員は3人

Q: 計算資源はテスラと比べてどうなんだ

A: 生成AIでは同じラインに立っている。見た目ほどのビハインドではないと思ってる

Q: カメラだけでということだがジャイロセンサーなどは不要か

A: 必要であれば取り入れるが、不要と考えている。カメラにこだわっている理由は、推論できる特徴量が多い。モジュールを減らしたい。

Q: 半導体にFPGAから次の段階のコストは?

A: 5-6年後にどうなっているかはわからないがTransformerベースは変わらないと思うのでそこを見越している。

Q: シミュレーターを使っているか

A: 検証で使うスタンス

Q: 自動運転車に対するUIは

A: タクシーに乗った時の会話のように会話ベースのUIになる

Q: 自動運転が実現されたときに寡占化になるか。

A: ハンドルがない車を買う人がどれだけいるかわからないが、その時に何社が作れているか。Turingはその1社になる。

感想:どのセッションもLLMに力を入れていることを分かりやすく話してくれていて、方向性に関しては日本のどのメーカーよりも説得力があります。

また、Heronは自動運転にとどまらず広い応用範囲があると感じており、注目しています。

AI,半導体に特化した発表ということもあるかもしれませんが、実車や部品も見せて欲しかった。

山本 一成さんと記念撮影。

とても元気で気さくな人でした。手ブレすみません。

この記事が気に入ったらサポートをしてみませんか?