ARKit 3.5について情報収集

遅ればせながら明日LiDAR搭載のiPad Proが届く。世にはすでに多くの情報やデモや記事が流れているので雑多に貼っていく。

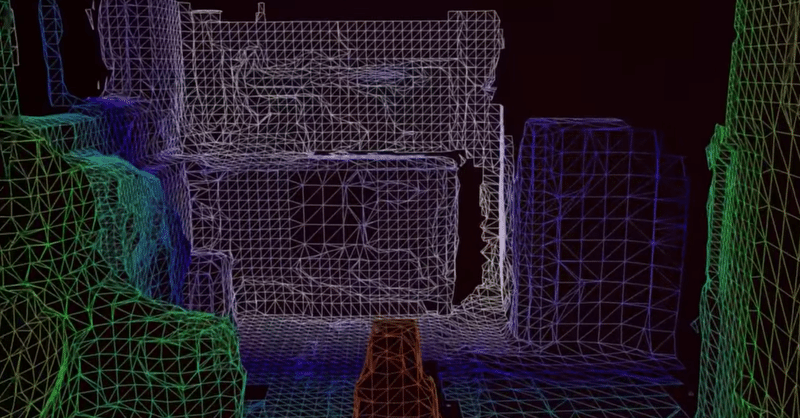

・メッシュの可視化(メッシュを描画してるだけじゃなく、デプスによって線の色を変えている。これはやりたい)

First look at the iPad Pro LiDAR Scanner pic.twitter.com/kwkl1YBy2n

— Tim Field (@nobbis) March 25, 2020

Preliminary 2020 #iPadPro teardown reveals smaller battery, LiDAR Scanner https://t.co/BhQkJBuw3f pic.twitter.com/l34zNCpNch

— AppleInsider (@appleinsider) March 26, 2020

・LiDARの光の可視化(infrared:赤外線)

Here is iPad Pro’s LiDAR under infrared. pic.twitter.com/IZkum3nwRx

— Faruk 🚀 ᴵᴾᴴᴼᴺᴱᴰᴼ (@iPhonedo) March 26, 2020

Quick tease of @primersupply working with the new iPad Pro’s LiDAR sensor.

— Adam Debreczeni (@heyadam) March 26, 2020

That debug mesh you see is dynamically constructed as you move the device around. pic.twitter.com/odKY4WwaOf

・検出した平面の可視化(面だけではなくClassificationも可視化しているのがいい)

Fast plane detection and classification with the new iPadPro and Lider sensors#ARKit3.5 #ARFoundation pic.twitter.com/YpbaXhSoWl

— Kitasenju Design (@kitasenjudesign) March 25, 2020

ARKit3.5で追記されているのは三つ

— Kohei Arai (@kokoheia) March 24, 2020

1.Scene Geometry

環境を読み取る時にオブジェクトのラベリング(床、壁、天井、窓、ドアなど)もしてくれる

2.Instant AR

iPad ProのLiDARを使って一瞬で平面検出

3.Improved Motion Capture

iPad ProのLiDAR使って精度が改善されたhttps://t.co/kR5cfjiHnr

・ARFrameのcapturedDepthDataは空っぽなのだろうか?ドキュメント見に行くといまでもFace Trackingのときしか(つまりフロントのTrueDepthカメラ利用時しか)ここにデプスデータは入ってこないっぽい感じなので、LiDARの生デプスが今のところ得られないというのはたぶん本当だろう。(というかまぁAppleの中の人が断言してるからそりゃそうか)

AppleによるとARKit経由だとiPad ProのLiDARセンサーから得た生の点群データ(デプスデータ)はXcodeからはアクセスできないらしい🤔

— Junichiro Horikawa (@jhorikawa_err) March 25, 2020

カメラのように独立したセンサー用APIが用意されるということなのか、それともずっとアクセスさせないつもりなのか気になるところ。https://t.co/8gzmvwva6h pic.twitter.com/EkU5LtAwqd

LiDARカメラ部分を指で隠したら動作しなかったので、LiDARで間違いなさそう。 https://t.co/lbwkuEA8Ip

— もやし (CV:種田梨沙) (@hIDDEN_xv) March 25, 2020

そしてiPhone XS Maxでも同じものを試してみた。アプリ起動したまま動かさずにいると、いつまで経ってもボックスは表示されず。少しカメラを振ると表示されるようになった。LiDARだと静止したままでもボックスが出てくるから、この差は大きいな。 https://t.co/lbwkuEA8Ip

— もやし (CV:種田梨沙) (@hIDDEN_xv) March 25, 2020

新型iPad ProのLiDARがやばい!!https://t.co/1X8ttW9cOz pic.twitter.com/FhN3HXbD0c

— おめがレイ@バーチャル双子YouTuber (@omesis_ray) March 26, 2020

新iPad ProのLiDARやばいな(動画前半)。起動後ARCoachingOverlayViewが表示すらされず、何なら5m先の壁すらあっという間に認識している。動画後半は同じコードの旧iPad Pro。 pic.twitter.com/tG7O9mEB2l

— Masayuki Iwai (@myb) March 25, 2020

・LiDARについての考察

今回iPad Proが採用したLiDARは、センサーの素性の詳細はわからないものの、「直接型」と呼ばれる形式であることが分かっている。

直接型とは、レーザーを直接物体に飛ばし、それが反射して戻ってくるまでの時間を計測するタイプのもの。シンプルで反応が速く、遠くまで計測するのに向いていることから、自動車向けなどはこちらの採用が多い。

しかし直接型LiDARは、あまりに光がすぐに戻ってくる範囲、すなわち近くで精度を出すのが難しい。そこを改善しようとすると、大型化しやすい。

そのため今のスマホ向けでは、「間接型」と呼ばれる仕組みが主流だ。これが先ほど「ToFセンサー」と表記したものだ。間接型は、何度か光を計測し、その位相差から距離を算出するもので、デジカメ用イメージセンサーの技術を応用して作れる。近くを高解像度でスキャンできるのが特徴だが、暗い場所や遠くの認識を狙うと消費電力が上がる、という欠点がある。

アップルはスピードや省電力化のために直接型LiDARを採用したのだろう。だが解像度も上げたい。そこで、いままでARKitで使ってきた画像処理での空間把握を組み合わせたのではないか。

## 実機で試す

最後まで読んでいただきありがとうございます!もし参考になる部分があれば、スキを押していただけると励みになります。 Twitterもフォローしていただけたら嬉しいです。 https://twitter.com/shu223/