shu223

フリーランスiOSエンジニア。エンジニアと人生コミュニティ運営。YouTube・Pod…

最近の記事

- 固定された記事

マガジン

記事

-

ロック画面からのカメラ起動における制約とデータ永続化の方法 - Locked Camera Capture Extension その2

WWDC24のセッション "Build a great Lock Screen camera capture experience" を見たメモ ロックを解除する必要すらなく、アクションボタン、コントロールセンター、ロック画面からカメラ(サードパーティーアプリの撮影機能)を起動できる、という熱い新機能についてのセッション。 前回記事ではLocked Camera Capture Extensionとそのライフサイクルについて書いた: 本記事では、Locked Camer

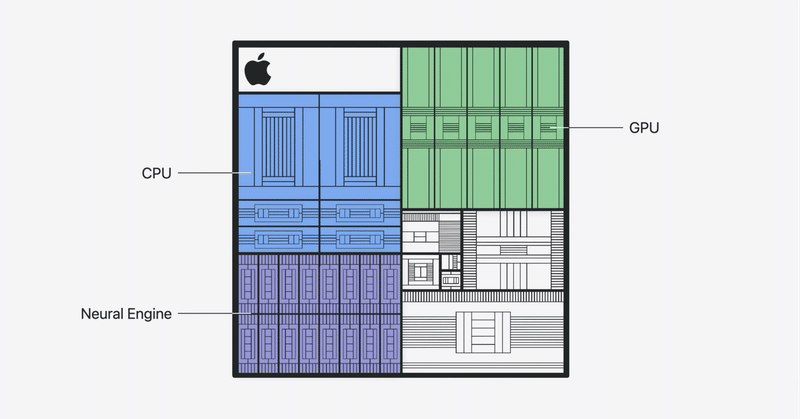

"Bring your machine learning and AI models to Apple silicon"セッション概要 #WWDC24

WWDC24のセッション "Bring your machine learning and AI models to Apple silicon" のセッションについて。 本セッションのスコープCore MLモデルをデプロイするワークフローにTrain(学習), Prepare, Integrate(アプリへの組み込み)があるとして、 本セッションでは "Prepare" 段階にフォーカスして、多くの最適化手法について解説する、とのこと。 TrainをiOSエンジニアで

-