WWDC 2024から見た、AppleのAI戦略

Off Topicでは、アメリカのインターネットカルチャーや最新テックニュースの解説をしているポッドキャストや、平日毎日1,000〜2,000文字のプチインサイトを書く有料メンバーシップクラブ「Off Topic Club」をやってます。よかったらチェックしてください!

はじめに

Appleが毎年行うWWDCで色んなことを発表したが、想定通り多くの時間はAppleが開発したAIシステム「Apple Intelligence」について話していた。動画を見ると全体の1時間43分のプレゼンのうちApple Intelligenceは39分と38%弱の時間について話された。全ての機能は以下動画を見ると分かるので全部解説する必要はないと思いますが、今回はその中で個人的に気になった点を解説します。

特にAppleが何故画面上を理解するようなAIシステムを作り、それを主に世界トップクラスのAI技術を開発しているOpenAIのAIモデルを使わずに自社モデルで徹底させたのか?それらを知るとAppleのAI戦略が見えてくると思います。

WWDC24でAppleが発表したまとめ動画:

コンテキスト認識のあるハードウェア・ソフトウェア

今回のWWDCは珍しく多くの発表した機能(特にAI機能)は将来的(大体年内)にリリースする予定のもの。Appleらしくないものの、その表現方法は上手かった気がする。特にGoogleやMicrosoftと比べて、より一般的なユーザーが使えそうなユースケースを想像させられる動画だった。今回のApple Intelligenceのスローガンは「AI for the rest of us」とマスが使えるAIと明確に宣言したのも良かった。やはり今回も直感的なインターフェイスデザインを期待出来そう。

その直感的なインターフェイスを作るためにAppleはOSレイヤーでAIを組み込むことにした。ユーザーのスマホ画面を理解し、アプリを跨いでタスクを行えるアシスタント機能を披露した。iMessage上で友達が引っ越した時に新しい住所を送れば、Siriにその友達のコンタクト先ページの情報をアップデートするように簡単にお願いできる。そしてアプリを跨ぐだけではなく、自分の個人アクションのコンテキストありきで動けるのは大事。Off Topicでも話した、コンテキスト認識のあるハードウェアとソフトウェアを開発している。

Agentic LLMs that's built into the OS, can do things while having my personal context, is really going to unlock how many people use AI 👏 with one device processing! #wwdc https://t.co/t1YQo3HOCq pic.twitter.com/Nw8oVsCEft

— Alex Volkov (Thursd/AI) (@altryne) June 10, 2024

オンデバイスの強調

当然ながら個人情報やアプリのタスクを行えるようになると、プライバシー問題の話が出てくる。特にChatGPTとの連携部分に関しては懸念される人もいた。中ではイーロン・マスクはAppleがOSレイヤーでOpenAIの技術を取り組んだ場合、イーロン・マスク配下の会社は全てAppleデバイスを禁止にするとまで発言した。この課題に関してはAppleも重々理解していたからこそ、今回の発表で個人的にかなり重要だと思ったのは、AppleはChatGPTと提携したものの、ほとんどのApple Intelligenceの機能は自社開発した、オンデバイス型のAIモデルであること。

まず、ChatGPTとの提携を発表したし、Sam Altmanも会場にいたかもしれないが、プレゼンのほとんどはChatGPTを触れなかった。確か「OpenAI」という言葉自体は一切使わず、「ChatGPT」も数回しか言わなかった。実態としてApple Intelligenceの39分間のプレゼン時間のうち、OpenAIにフォーカスしたのは約2分ぐらいしかなかった。AppleとしてはChatGPTはほんの一部の機能でしかないと明確に伝えたかったはず。しかもクラウド型のLLMを活用した時も、デバイス内のAIはどの情報が適切かを判断して、その部分しか送らないようにしている。同時にIPアドレスはバレないようにして、サーバーのローカルのストレージがないのでトラッキングされない。「ブロックチェーン風ではある」とAppleのソフトウェアエンジニアリング担当者のCraig Federighiが語った。

Appleはプライバシー重視する会社だからこそ、クラウド型のAIモデルを活用するよりもオンデバイスでほとんどのAI活用を行いたいと思っている。

— Tetsuro Miyatake (@tmiyatake1) June 11, 2024

去年のOff Topicポッドキャストでも話したが、これは後にAppleのヘルスケア領域の展開にかなり重要になってくる。 pic.twitter.com/wiDPUHaLas

このオンデバイス重視でChatGPTなど外部LLMと連携する戦略は実際のChatGPTの利用シーンで明確だった。特定のタスクを行うときにAppleがスマホ画面の上の部分にユーザーにChatGPTを活用しても良いのかの承認を取る通知が来るようになっている。そこには「ChatGPT」と明確に書かれているが、後々他社のAIモデルも取り込むことが想定されている。Craig Federighiさんも他の外部モデルへのアクセスを許可するようにすると発言していて、例としてGoogle Geminiをあげた。まずは業界トップクラスのGPT-4oから始めたかったと語る。

オンデバイスAIからヘルスケア展開へ

オンデバイスで主なタスクを行えるのはAppleのプライバシー重視の考え方にフィットするだけではなく、Appleの今後のサービス領域の展開にも繋がる。過去のOff Topicポッドキャストでも話したが、個人的にAppleの次の最も期待できる事業領域はヘルスケアであって、それを可能にするのがオンデバイスのAI。Appleの今までのヘルスケア領域の戦略はデータを収集するためのデバイスやソフトウェアレイヤーを作ることだったが、今後はそれを理解できるようなAIなどと連携させるかもしれない。

Appleのヘルスケア事業の展開について気になる方は以下エピソードをお聴きください!

ChatGPTの立ち位置とAppleの本当のAI戦略

Apple Intelligenceを作るためにAppleは多くの自社AI基盤モデルを開発して、色んなコンテンツプロバイダーとライセンス契約してモデルトレーニングを行ったと語る。OpenAIとの連携がより深いものだと期待していた人も多かったとは思うが、Appleはよほど困ってなければその方向性には行かない。Craig FederighiもOpenAIのGPT-4oモデルがトップクラスだと認めたが、同時にApple IntelligenceはAppleが開発したモデルをベースに提供されることを強調したのは重要なポイントな気がする。

自社AIモデルを開発してもOpenAIには追いつかないと言う人もいるかもしれないが、個人的にはそこがAppleの狙い目ではないと思っている。最終的にAppleは「ChatGPT」「Gemini」「Claude」などと提携するかもしれないが、AppleはどのAIモデルをどのタイミングでどのように使うかをコントロールするAI OSレイヤーをコントロールしようとしている。他社に自社の優位性であるクローズドなエコシステムにコントロール権を渡すのは絶対Appleとして許せないこと。そして今後は1つのモデルが全てのユースケースに使えるのではなく、色んなAIモデルがあることを考えると、そこのルーター的な存在が必要となる。そこにユーザーの好みやパーソナライズされたAIを組み合わせると本当のAIアシスタントが生まれる気がする。それがAppleとしての目的。AppleとしてはAIがプラットフォームではなく、プラットフォームをより連携させるもの。

TAC 2.0はどのように成立するのか?

今回のOpenAIとの提携で気になったのは、Appleユーザーにとって無料でGPT-4o機能を使えること。既にOpenAIは上限付きではあるが無料ユーザーに向けてGPT-4oも解放しているので、OpenAIからすると一気に世界中にある22億のAppleデバイスにリーチするためには無料で提供するのは大事だったが、今回の取り組みの契約内容は非常に気になる。

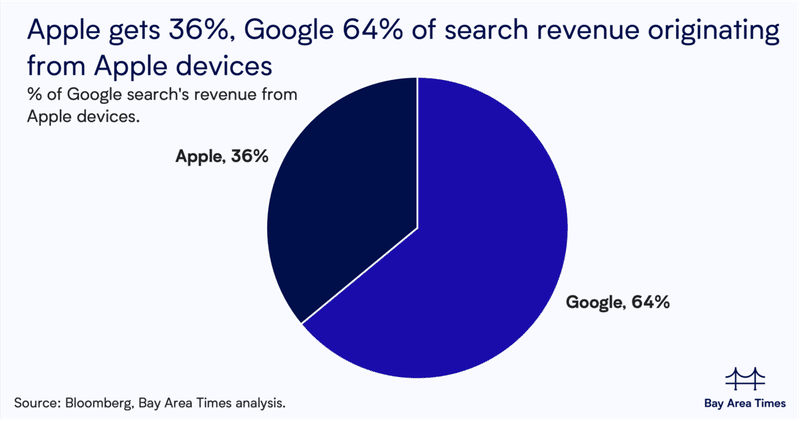

今まではAppleの膨大なリーチにアクセスできる代わりにデフォルト検索エンジンになるために年間$20B以上の額をGoogleが支払っていた(その金額をTAC、Traffic Acquisition Costと呼ぶ)。GoogleはAppleデバイス上で行われるGoogle検索で発生した広告売上のうち36%をAppleに支払うレベシェア契約を締結しているが、似たような契約をOpenAIもしているのかは気になる。まだOpenAIとしては広告などを出していないが、それを踏まえての契約を締結したと考えられる。ただ、Appleがお金をもらっているのではなく、OpenAIに安全性を保つためにAppleが資金提供もしているという説もあったりする。個人的には前者の今まで見たいなTACと近しい契約が締結されたと思っているが、実態としてどのようなエコノミクスになっているのかは知りたい。

提携内容を見ると、いかにAppleが第三者のAIモデルをOSレイヤーで組み込ませたくないかが分かる。そのため、今後はGoogleと同じように検索など特定のインターネットアクセスが必要な時などのユースケースで外部モデルを活用するはず。気になっているのは、今までみたいにデフォルトサービスプロバイダーを選定するのか、それとも色んなプレイヤーと契約してAppleのAIアシスタントにどのモデルを使うべきなのかをその場で判断させるのか。

Google検索エンジンのようにデフォルトAIモデルの道を選んだ場合、選定したサービス(恐らくChatGPT)はAppleに何かしらのレベシェアを支払わなければいけなくなる。ただ、個人的には最終的にAppleは複数モデルを対応して、AppleのAIモデルがその場面で適したAIモデルを選定する形をとるのではないかと思うので、そこで色んなプレイヤーとレベシェアの契約を締結する気がする。もしかしたら特定のユースケースではより高いレベシェアにするなど、Appleは色んなプライオリティを置く可能性がある。

今だと恐らくAI検索エンジン周りが最も需要があるように見えるが、まだどのぐらいLLMがこのように使われるのかはまだ見えてない。そしてどういう形で契約を行い、そこのエコノミクスは今まさに色々交渉されていて、それも次の数年間でどういうユースケースが流行るかによって進化していくはず。

ちなみにTAC 2.0の解説についてはこちらのOff Topicポッドキャストをお聴きください。

Appleのインターフェイス問題

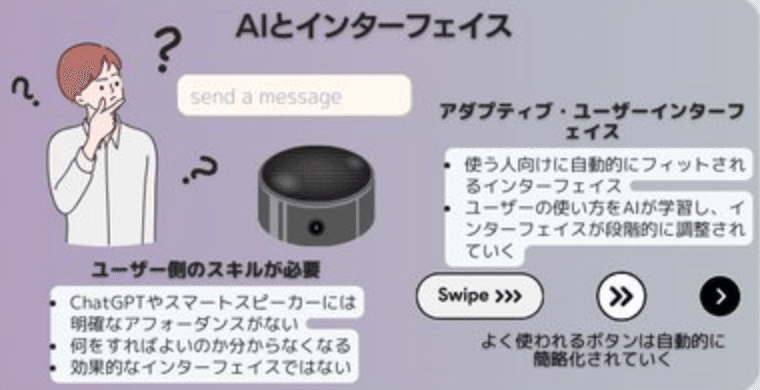

AppleのAIアシスタント機能は確かに便利そうではあるが、課題はまだまだありそう。メッセージでのやり取りで知り合いのコンタクト先情報をAIアシスタントにアップデートしてもらったり、特定の写真を表示する、その写真を編集させるなど色んな事例をAppleは見せた。一つ一つのユースケースは映像で見ると分かりやすいが、AIアシスタントの根本的な課題である、アンビエント型のインターフェイスの課題はまだそこまで解決してなさそうな気がする。これはAI音声アシスタントと似ていて、プロダクトの形から利用方法が読み取れない問題がある。

ChatGPTでも大きな課題は、どのように適切なプロンプトを入力するか。ただ、ChatGPTの一つ大きな強みは多くのインターネットユーザーはテキスト型のチャットに慣れていること。そこでの会話を想像しやすいのと、テキストに最初は限定したからこそある程度の使い方は誰もが分かった。それと比較してAlexaやGoogle HomeみたいなAI音声アシスタントは便利かもしれないが、何がそのデバイスで出来るのかがユーザーにとって分からなすぎて、最終的には天気予報、ポッドキャスト、そして音楽が最も使われるユースケースとなる。

フォームファクターによってインターフェイスが分かりやすくなる。めちゃくちゃ分かりやすいフォームファクターからのインターフェイスは手袋。手の形をしているから手を入れると分かり、さらに手袋の素材によって何かを洗うための物なのか、寒い時につけるための物なのか、バイク用のものなのかなどがなんとなく分かる。Apple IntelligenceとアップグレードされたSiriは一見パワフルなAIに見えるが、それをユーザーがどうやって理解して使いこなせるのかがAppleにとっての大きな課題となる。Siriを発動するアニメーションはめちゃくちゃカッコいいかもしれないが、それを見て何をすれば良いか分からなくなる課題はありそう。

実はAIウェアラブルやデバイスが普及する際にこのインターフェイス問題があることを去年のOff Topicポッドキャストでも話しています。

Appleは恐らく世界で最も直感的なデザインを作るのに長けているチーム。今までのGUIとマウス、クリックホイール、タッチ画面、そしてVision Proの指と目を使ったインターフェイス設計はすごい。個人的には今回のApple Intelligenceで同じような革命を期待していたが、それが発表されなくて少しがっかりしている。

もしかしたらその解決案は時間の問題なのかもしれない。見えないインターフェイスだからこそ、AIアシスタントをうまく活用するにはより提案型にしなければいけない気がする。ただ、Appleとしては提案しすぎるといっぱい通知を飛ばすと同じようにユーザーが嫌うので、そこの調整するデータが必要なのかもしれない。そもそもユーザーが画面上で何をしているのかを理解するデータがないと提案すら出来ないので、ユーザーが新iOS 18をダウンロードするとそのデータを集めて、どこかのタイミングでより積極的に提案するようになるのかもしれない。

Appleが何故Geminiを選ばなかったのか

Appleのインターフェイス問題を解決するためにユーザーの画面上で何をしているのかを理解するためのデータが必要と話したが、それがもしかしたらGoogle GeminiではなくOpenAIを選んだ理由なのかもしれない。あくまで推測でしかないが、GoogleはGeminiをよりAppleのOSレイヤーに組み込みたいとお願いした可能性がある。Googleとしてはより多額のレベシェアを引き換えにしてでも、iPhone上でのユーザーのスマホ利用のデータがあれば自社の真のムーンショットを開発できると考えているのかもしれない。GoogleをiOSレイヤーと組み込まなくても、AppleはもしかしたらGoogleのその真のムーンショットに取り掛かっていることに気づき、その理由でGeminiと最初から組まないと判断したのかっもしれない。

Great move by both OpenAI & Apple. ChatGPT gets a massive distribution boost, and Siri becomes the router for your AI interactions. We’re looking at day 1 of a new era of how we interact with computers. pic.twitter.com/zyo6dQFoyw

— Aaron Levie (@levie) June 10, 2024

もちろんこれは個人的な予想でしかないが、Geminiを初期AIパートナーとしてAppleは選ばなかったのはOpenAIの方が優れていたからでもあるかもしれないが、同時にGeminiと提携するリスクを考えていたからだと思っている。これは今月末に出す予定のOff Topicポッドキャストでも話すが、GoogleはもしかしたらAppleの今のポジションに挑む施策を行っているかもしれない。

Apple Intelligenceによって危機感を感じるサービス

よくOpenAIが何か新しい発表をすると色んなAIアプリが潰されると業界内では半分ジョーク、半分真剣に言われている。直近のGPT-4oの発表でも、よりリアルタイムの会話に注力していた多くのスタートアップ、AI翻訳系のスタートアップ、教育系のスタートアップなどが危機感を感じたはず。

Sam AltmanはThanosだったのかもしれないw。 pic.twitter.com/dpiq6Ve84F

— Tetsuro Miyatake (@tmiyatake1) May 14, 2024

今回のWWDC 2024でも似たような現象が行われたと言う人もいる。デバイス内でのAppleの自社AIモデルのパフォーマンスを見ると、今はGPT-3.5ぐらいのレベルになっている。

トップレベルのモデルにはなれないが、特定のユースケースなどに絞ればオンデバイス型のAIモデルでも十分なことが出来ると考えられる。画像生成であればMidjourney、スペルミスや文法をチェックしてくれるGrammarly、様々な計算機アプリや数学アプリ、パスワードアプリ、ミラーリングアプリ、そしてAIウェアラブルデバイスなどが今回のアップデートで需要が落ちるのではないかと言われている。

ポッドキャストとOff Topic Clubもおすすめです

Off Topicでは、米国を中心に最新テックニュースやスタートアップ、ビジネス情報をゆるーく深堀りしながらご紹介する番組です。

Spotifyからも聞くことができます。

ポッドキャストのアーリーアクセス権、記事版、そして毎日平日に最近のニュースやアメリカのテック業界などで起きているプチインサイトを紹介するDaily Memoを配信する有料メンバーシップ「Off Topic Club」もあるので、興味ある方は是非ジョインしてください!

この記事が気に入ったらサポートをしてみませんか?