M3 mlx でxwin-lm-70b-v0.1.Q4_0.gguf を試してみた

以下のツイートが流れてきたので、気になっていたmlx環境でのggufモデルの実行をさきほど頑張って試してみました。

MLXでXwin-70Bのggufが動くことを確認。

— 布留川英一 / Hidekazu Furukawa (@npaka123) January 27, 2024

Apple M3 Max pic.twitter.com/BbopeyziyX

postと同じようにコードをeditorに書いて、コピペしたmlx conda環境でのmlx-examples/llms/gguf_llm のdirectoryで動かしてみました。

質問文は変えています。

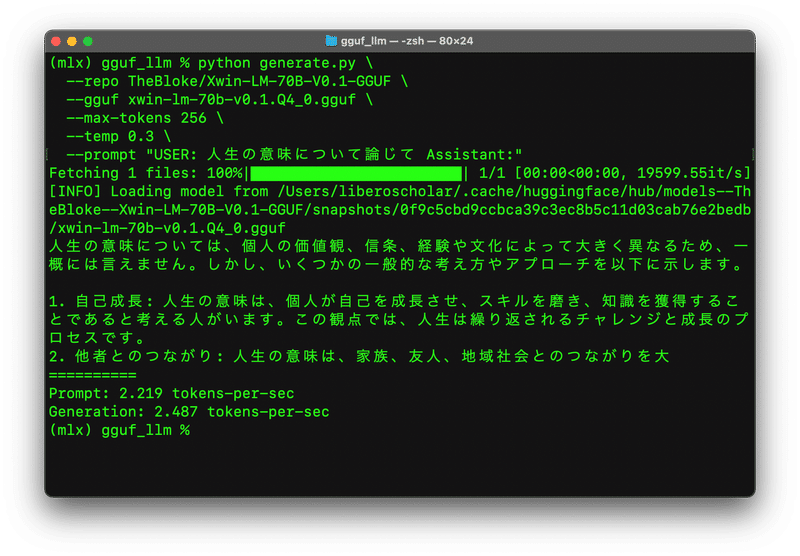

gguf_llm % python generate.py \

--repo TheBloke/Xwin-LM-70B-V0.1-GGUF \

--gguf xwin-lm-70b-v0.1.Q4_0.gguf \

--max-tokens 256 \

--temp 0.3 \

--prompt "USER: 人生の意味について論じて Assistant:"1回目の実行

このようなエラーが出ました。

そこで、こちらの記事に従って修正を加えていきました。

最初は、generate.pyの修正。

mlx-examples/llms/gguf_llm/models.py 228行目を記事通りに修正。

"rope_theta": 10000,

どうしてこの値を10000にするのかわかっていませんが、わからないままElyzaの上の記事と同じ値で直接指定しました。

2回目の実行

動きました!

ただし、npakaさんの記事にあるようにことだと思いますが、謎文字が偶数個連続ででているので、mlx-examples/llms/gguf_llm/generate.py 35行目 の箇所を記事通りに修正しました。

if '\ufffd' not in s[skip:]:

print(s[skip:], end="", flush=True)

skip = len(s)

3回目の実行

文字化けがなくなりました!

生成されて表示されるまでにかかる時間がとってもかかりますが、いったん生成され始めると、布留川英一さん(npakaさん)のポストの動画と同じぐらいのスピードで生成されました。

xwinについての日本語能力については、shi3zさんの以下の記事が参考になりますが、良さそうな感じですね。

#AI #AIとやってみた #やってみた #大規模自然言語モデル #LLM #ローカルLLM #mlx #macbookpro

この記事を最後までご覧いただき、ありがとうございます!もしも私の活動を応援していただけるなら、大変嬉しく思います。