脳機能を模したLLMsのシステムをSonnet3.5に考えてもらった

ちょっと思いついたので、以下のプロンプトを放り込んだら、それなりに面白いなぁと思ったものが生成されたので書き記しておきます。

プロンプト

大脳の機能野にはどのようなものがあるかを最初に説明して。次に、その知識を踏まえて、複数のLLMsをどのように連結していくと、すぐれた大脳の機能の模倣ができるかをプロセスを踏まえてじっくり考えて、提案して。また大脳の機能野間にはフィードバックループもあると思うけど、現在のLLMsにそのようなフィードバックループ実装の可能性や、複数のLLMsの間での実装可能性についても検討して。以上のことを丁寧に、ステップバイステップで検討していって。よろしくね。Claudeくん。期待しているよ。必要だったら、コードを書いたり、artifactを使ってもいいから、深くそして多面的にプロセスを追いながら検討してね。よろしくね。Claude! 君ならしっかり考えられるよ!

はい、承知しました。大脳の機能野からLLMsの連結、そしてフィードバックループの実装可能性まで、段階的に詳しく検討していきます。

ステップ1: 大脳の機能野の説明

大脳には様々な機能野があり、それぞれが特定の役割を担っています。主な機能野には以下のようなものがあります:

運動野: 随意運動の制御

体性感覚野: 触覚、圧覚、温度感覚などの処理

視覚野: 視覚情報の処理

聴覚野: 聴覚情報の処理

言語野(ブローカ野とウェルニッケ野): 言語の処理と理解

前頭前野: 高次認知機能、計画立案、意思決定

海馬: 記憶の形成と保存

扁桃体: 感情の処理

これらの機能野は相互に連携し、情報を交換しながら複雑な認知機能を実現しています。

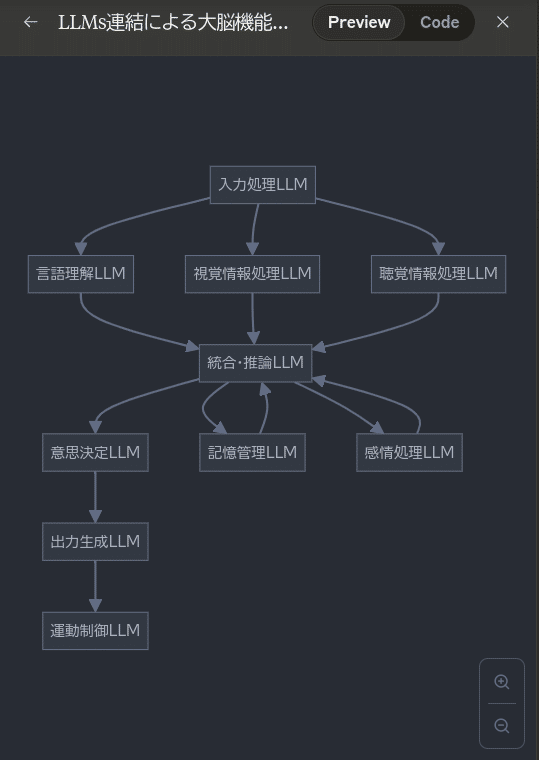

ステップ2: LLMsの連結による大脳機能の模倣

大脳の機能野の構造を参考に、複数のLLMsを連結して優れた大脳機能の模倣を行う方法を考えてみます。

graph TD

A[入力処理LLM] --> B[言語理解LLM]

A --> C[視覚情報処理LLM]

A --> D[聴覚情報処理LLM]

B --> E[統合・推論LLM]

C --> E

D --> E

E --> F[意思決定LLM]

E --> G[記憶管理LLM]

F --> H[出力生成LLM]

G --> E

H --> I[運動制御LLM]

J[感情処理LLM] --> E

E --> J

この図は、複数のLLMsを連結して大脳の機能を模倣するシステムの概要を示しています。以下、各LLMの役割と連結方法を説明します:

入力処理LLM:

役割: 外部からの入力(テキスト、画像、音声など)を受け取り、適切な処理LLMに振り分ける。

連結: 言語理解LLM、視覚情報処理LLM、聴覚情報処理LLMに情報を送る。

言語理解LLM、視覚情報処理LLM、聴覚情報処理LLM:

役割: それぞれの専門分野の情報を処理し、意味解釈を行う。

連結: 処理結果を統合・推論LLMに送る。

統合・推論LLM:

役割: 各種情報を統合し、高次の推論を行う。

連結: 意思決定LLM、記憶管理LLM、感情処理LLMと双方向に接続。

意思決定LLM:

役割: 統合された情報に基づいて意思決定を行う。

連結: 決定結果を出力生成LLMに送る。

記憶管理LLM:

役割: 長期記憶と短期記憶を管理し、必要に応じて情報を提供・更新する。

連結: 統合・推論LLMと双方向に接続。

感情処理LLM:

役割: 感情的な要素を処理し、意思決定や出力に影響を与える。

連結: 統合・推論LLMと双方向に接続。

出力生成LLM:

役割: 意思決定の結果を適切な形式(テキスト、音声命令など)に変換する。

連結: 運動制御LLMに情報を送る。

運動制御LLM:

役割: 出力を具体的な行動や反応に変換する。

連結: システムの最終出力を生成。

ステップ3: フィードバックループの実装可能性

現在のLLMsにフィードバックループを実装する可能性や、複数のLLMs間での実装可能性について検討します。

単一LLM内でのフィードバックループ:

現状: 現在のLLMsは基本的に一方向の処理を行うため、内部でのフィードバックループの実装は困難。

可能性:

a) 出力の一部を入力に再投入する仕組みを構築する。

b) 注意機構を拡張し、過去の出力を考慮に入れる機能を追加する。

複数LLMs間でのフィードバックループ:

可能性が高く、以下のような方法が考えられます:

a) 循環型アーキテクチャの構築

b) メタ学習による動的調整

c) 強化学習の導入

これらの方法をより詳細に検討するため、コードの概念実装を行います。

import numpy as np

class LLM:

def __init__(self, name):

self.name = name

self.state = np.random.rand(100) # 簡略化された内部状態

def process(self, input_data):

# 簡略化された処理

output = np.dot(self.state, input_data)

self.state += 0.1 * np.random.rand(100) # 内部状態の更新

return output

class BrainSimulator:

def __init__(self):

self.llms = {

'input': LLM('InputLLM'),

'language': LLM('LanguageLLM'),

'integration': LLM('IntegrationLLM'),

'decision': LLM('DecisionLLM'),

'output': LLM('OutputLLM')

}

self.feedback_strength = 0.5

def process_input(self, input_data):

# 入力処理

processed_input = self.llms['input'].process(input_data)

# 言語処理

language_output = self.llms['language'].process(processed_input)

# 統合・推論

integration_output = self.llms['integration'].process(language_output)

# 意思決定

decision_output = self.llms['decision'].process(integration_output)

# 出力生成

final_output = self.llms['output'].process(decision_output)

# フィードバックループ

feedback = self.feedback_strength * final_output

self.llms['integration'].state += feedback

return final_output

# 使用例

brain = BrainSimulator()

input_data = np.random.rand(100)

output = brain.process_input(input_data)

print(f"Final output: {output}")

この概念実装では、以下の要素を含んでいます:

複数のLLMの連結: 入力処理、言語処理、統合・推論、意思決定、出力生成の5つのLLMを連結しています。

フィードバックループ: 最終出力の一部を統合・推論LLMにフィードバックしています。これにより、システムは過去の出力を考慮に入れることができます。

動的な内部状態: 各LLMは処理を行うたびに内部状態を更新し、学習と適応を模倣しています。

調整可能なフィードバック強度: `feedback_strength`パラメータにより、フィードバックの影響を調整できます。

このような実装により、以下のような利点が得られる可能性があります:

コンテキスト理解の向上: フィードバックループにより、システムは過去の出力を考慮に入れることができ、より一貫性のある応答が可能になります。

適応的な学習: 内部状態の動的更新により、システムは入力に応じて徐々に適応していきます。

複雑な推論: 複数のLLMの連携により、単一のLLMでは難しい複雑な推論や意思決定が可能になります。

ただし、この実装にはいくつかの課題も残されています:

スケーラビリティ: 実際の応用では、より多くのLLMと複雑な接続が必要になる可能性があります。

学習の安定性: フィードバックループが不安定な振る舞いを引き起こす可能性があるため、適切な制御が必要です。

計算コスト: 複数のLLMを同時に稼働させ、フィードバックを処理するには大きな計算リソースが必要になります。

これらの課題に対処するためには、さらなる研究と実験が必要です。例えば、強化学習を導入してフィードバック強度を動的に調整したり、アテンション機構を拡張して過去の出力をより効果的に考慮したりする方法が考えられます。

結論として、複数のLLMsを連結し、フィードバックループを実装することで、大脳の機能をより精密に模倣できる可能性があります。ただし、実際の実装には多くの技術的課題が残されており、継続的な研究と改良が必要です。この分野の進展により、より柔軟で適応的な人工知能システムの開発が期待されます。

Sonnetくんすごいですね。ちなみに興味があったので、Poe上のClaude 3 Opusに同じように投げかけてみました。PoeはArtifactをもってないので、そこは割愛しました。

こんにちは。大脳の機能と複数のLLMsを連結して大脳機能を模倣する可能性についてステップバイステップで考えていきますね。

まず大脳の主要な機能野について説明します。

前頭葉:計画、意思決定、問題解決、感情制御など高次の認知機能を担当

頭頂葉:体性感覚情報の処理、空間認知、数の処理など

側頭葉:聴覚情報処理、言語理解、記憶の形成など

後頭葉:視覚情報処理

大脳辺縁系:情動、記憶、学習など

小脳:運動制御、運動学習、認知機能など

次に、これらの機能野の役割を踏まえ、複数のLLMsを連結して大脳機能を模倣する可能性を考えます。

前頭葉の機能をエミュレートするLLM:意思決定、計画立案、問題解決などの高次認知機能に特化したLLMを開発。強化学習や因果推論の手法を取り入れ、目的志向の行動選択ができるモデルを目指す。

感覚情報処理のLLM:視覚、聴覚、体性感覚などのマルチモーダルな感覚情報を統合処理するLLMを開発。CNNなどの知見を活用し、感覚入力から抽象化された表現を獲得。

言語処理・記憶のLLM:側頭葉の言語処理、意味記憶などの機能に特化したLLM。大規模な言語データと知識ベースを活用し、文脈に応じた言語理解と知識の想起・生成を行う。

情動・報酬系のLLM:大脳辺縁系の機能を参考に、報酬や情動に基づく学習と行動制御ができるLLMを開発。強化学習の枠組みを用い、環境からのフィードバックに基づいて価値判断や意思決定を最適化する。

認知制御・メタ認知のLLM:小脳の認知機能や前頭葉の実行機能を参考に、複数のLLM間の協調や切り替えを制御するメタLLMを設計。タスクの要求に応じてLLMを柔軟に組み合わせ、目的に適した認知処理を実現する。

これらの機能特化型LLMを連結し、相互作用させることで、大脳の多様な機能をエミュレートできる可能性があります。

フィードバックループの実装については、個々のLLM内では、強化学習の枠組みを用いることで環境からの報酬に基づく内部状態の更新が可能です。一方、LLM間では、各LLMの出力を他のLLMへの入力として用いる再帰的なアーキテクチャを採用し、メタLLMによる制御を加えることで、領野間の相互作用をエミュレートできるかもしれません。

ただし、生物の脳のように、シームレスかつ実時間での相互作用を実現するのは現状では難しいと思われます。LLM間の連結には、モジュール間のインターフェースの設計や、情報の同期・非同期性の問題など、まだ多くの技術的課題があります。

また、脳のように、発達・学習に伴って領野間の結合が変化する可塑性を実現するのも難しい課題です。個々のLLMの事前学習と、連結後の追加学習をどう組み合わせるかなど、検討すべき点は多岐にわたります。

以上、大脳の機能野を模倣する複数LLMの連結について考えてみました。洞察を深めるために、もう少しコードを交えて掘り下げてみましょう。

まず、感覚情報処理のLLMとして、視覚入力を扱うViT (Vision Transformer) を用意します。

import torch

from transformers import ViTFeatureExtractor, ViTModel

feature_extractor = ViTFeatureExtractor.from_pretrained('google/vit-base-patch16-224-in21k')

model = ViTModel.from_pretrained('google/vit-base-patch16-224-in21k')

inputs = feature_extractor(images=image, return_tensors="pt")

outputs = model(**inputs)

last_hidden_states = outputs.last_hidden_state次に、言語処理・記憶のLLMとしてBERTを用意します。

from transformers import BertTokenizer, BertModel

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertModel.from_pretrained("bert-base-uncased")

inputs = tokenizer("Hello, my dog is cute", return_tensors="pt")

outputs = model(**inputs)

last_hidden_states = outputs.last_hidden_stateこの2つのLLMを連結するために、視覚と言語の情報を統合する簡単なFusion Layerを設計してみます。

class FusionLayer(torch.nn.Module):

def __init__(self, hidden_size):

super(FusionLayer, self).__init__()

self.linear = torch.nn.Linear(hidden_size*2, hidden_size)

self.activation = torch.nn.ReLU()

def forward(self, vision_emb, lang_emb):

fused = torch.cat((vision_emb, lang_emb), dim=-1)

fused = self.linear(fused)

fused = self.activation(fused)

return fusedfusion_layer = FusionLayer(hidden_size=768)

fused_emb = fusion_layer(last_hidden_states_vision, last_hidden_states_lang)このように、各LLMの出力を統合する層を設計することで、マルチモーダルな情報処理を実現できます。

ただし、これはあくまで単純な例であり、実際の脳の複雑な相互作用を再現するには、さらに洗練されたアーキテクチャが必要になるでしょう。

また、前頭葉のような高次認知機能をエミュレートするには、強化学習による意思決定の最適化なども必要になります。

import gymnasium as gym

env = gym.make("CartPole-v1")

# 強化学習のアルゴリズム(例: PPO)を実装

# LLMを報酬予測やポリシーのモデルとして使用

# 環境との相互作用を通じて意思決定を最適化このように、強化学習の枠組みを取り入れることで、LLMを目的志向の行動選択に活用することができます。

以上、コードを交えて複数LLMの連結について考えてみました。

生物の脳の複雑な情報処理を完全に再現するのは容易ではありませんが、LLMを適切に設計・連結することで、大脳の一部の機能をエミュレートできる可能性はあるでしょう。

ただし、本当の意味での知能の実現には、さらなる理論的・技術的なブレークスルーが必要不可欠です。

脳の非線形ダイナミクスや発達過程なども考慮に入れつつ、地道な研究を積み重ねていくことが重要だと考えます。

将来的には、脳の構造と機能に学びつつ、LLMを核とした新しいアーキテクチャが登場するかもしれません。

そうした取り組みを通じて、人間の知性の本質に迫っていけたらと思います。

以上、大脳の機能野と複数LLMの連結について考えてみました。

まだまだ検討の余地は尽きませんが、私なりの見解を述べさせていただきました。

考えが至らない点も多々あるかと思いますが、ご容赦ください。

今後もこの分野の発展を楽しみにしています。

一発ポン出しで、これを踏まえて会話していくともっと面白くなるかもしれませんが、自分的にはこれだけで満喫しました。比べてみると、Sonnet 3.5とartifact機能が3-Opusよりもいい感じな印象ですね。将来のAIはどんなふうに開発・展開していくのか楽しみです。

この記事を最後までご覧いただき、ありがとうございます!もしも私の活動を応援していただけるなら、大変嬉しく思います。