【博士論文】インタラクティブシミュレーションのための3次元デジタルヒューマンモーションを活用したバーチャルセンサと実世界アプリケーション

はじめに

こんにちは、杉浦裕太研究室 渡辺です。こちらの記事で私の博士課程の研究を紹介していますが、今回は杉浦研 XIA君の研究内容を紹介します。XIA君は私と同じく今年の9月に博士課程を修了して、現在は特任研究員として研究に取り組んでいます。

研究内容

XIA君は「Virtual Sensors with 3D Digital Human Motion for Interactive Simulation and Their Real-world Applications(インタラクティブシミュレーションのための3次元デジタルヒューマンモーションを活用したバーチャルセンサと実世界アプリケーション)」という研究テーマに取り組みました。

RGBカメラや3次元スキャナといった高次元なデータを取得する実世界センサと比較して、加速度センサやジャイロセンサといった低次元なデータを取得するセンサがあります。このようなセンサを用いた人間動作(モーション)計測アプリケーションは日進月歩で、将来、生活の多種多様なシーンに溶け込み人々を支援することが期待されています。しかし、このアプリケーションはプロトタイプを重ねる度にシステムを実体化した上で、センサデータを計測し直して精度を検証する必要があるため手間がかかります。

そこでXIA君はバーチャル空間内に配置した複数のセンサ群からなる「バーチャルセンサ」を導入し、センサの配置とデータ収集をインタラクティブに実現することにより実世界センサと等価なデータを収集する手法を提案しています。これは、多くの人々がアクセスしやすいゲームエンジンである Unity 3D 上で動作をするという特徴もあります。さらにXIA君は、このバーチャルセンサを2 つの異なる実世界アプリケーションに応用し、有効性を検証しています。

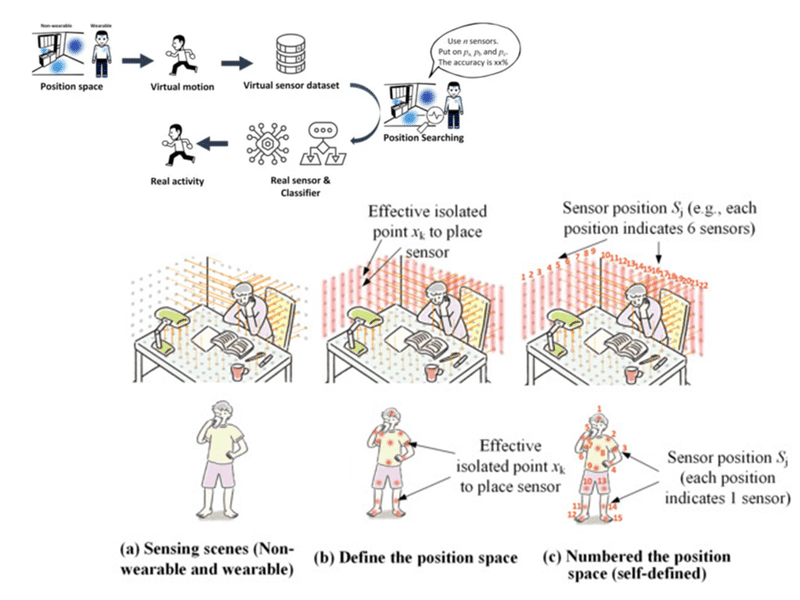

まずは効率的なモーション識別システムの開発手法ついての研究を実施しました。モーション識別のためには実空間や身体にセンサを取り付ける必要がありますが、センサを装着する場所や身体部位によってはモーションをうまく識別できない可能性があります。そこでXIA君はバーチャル空間内でセンサ配置を最適化するアルゴリズムを考案し[1]、これを組み込んだソフトウェア上で、3つの利用シーンにおいてモーション識別システムの設計をしました[2]。

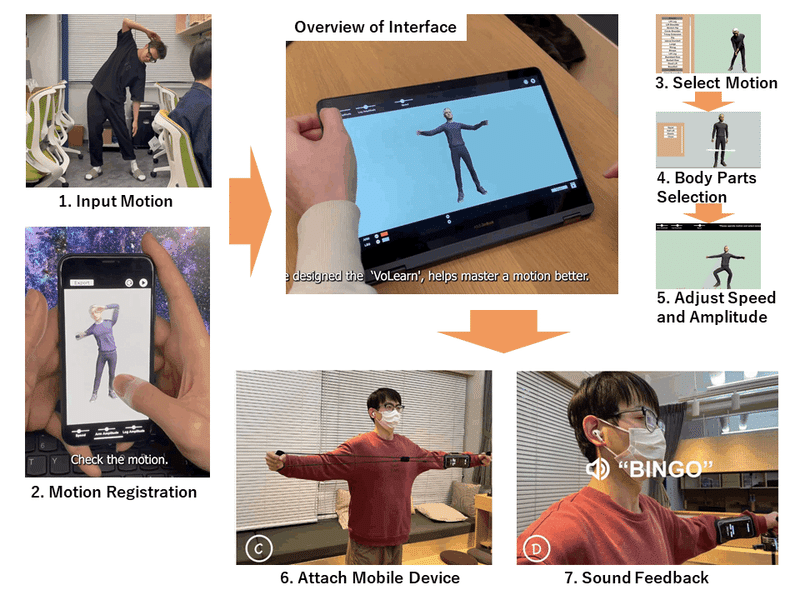

XIA君はバーチャルセンサを応用してモーション教示システム「VoLearn」を開発しました[3]。まずVoLearnにユーザに教示したいモーションを登録します。VoLearnにモーションを録画した動画を読み込まると3Dアニメーションが自動生成されます。次に読み込んだモーションデータをコンピュータ上で編集できます。さらに登録したモーションとユーザのモーションの一致具合を確認するためにスマートフォンを身体に装着します。スマートフォンに搭載されているセンサを用いてユーザのモーションを評価しますが、限られた個数のスマートフォンではその装着位置によって上手に動作を計測できない可能性があるのでバーチャル空間上で再構成されたバーチャルスマートフォンを利用して装着位置を最適化しました。またスマートフォンから出力される音を使用してユーザにモーションのフィードバックを行いました。今後はVoLearnを実用的なエクササイズシステムとして仕上げていきたいと考えているそうです。

[1] Chengshuo Xia, Yuta Sugiura. Optimizing Sensor Position with Virtual Sensors in Human Activity Recognition System Design. Sensors, 2021.

[2] Chengshuo Xia, Yuta Sugiura. Wearable Accelerometer Layout Optimization for Activity Recognition Based on Swarm Intelligence and User Preference. in IEEE Access, vol. 9, pp. 166906-166919, 2021.

[3] Chengshuo Xia, Xinrui Fang, Riku Arakawa, Yuta Sugiura. VoLearn: A Cross-Modal Operable Motion-Learning System Combined with Virtual Avatar and Auditory Feedback. Proc. ACM Interact. Mob. Wearable Ubiquitous Technol. 6, 2, Article 81 (July 2022), 26 pages, 2022.

この記事が気に入ったらサポートをしてみませんか?