アメリカの現実⑯「過去のデータから未来を予想するAIには、バイアスが存在する」

Alphabetに勤務していたAI研究の第1人者の解雇問題は、私に将来の社会への不安をもたらした

2020年12月、Alphabetに勤務していた「倫理的な人工知能(AI)研究の第1人者」のTimnit Gebru 博士が、退職した(彼女は解雇されたと明言している)。

By TechCrunch - https://commons.wikimedia.org/w/index.php?curid=97995768

解雇理由として、彼女は、自分の研究論文撤回を拒否したことと、女性社員昇進に関する彼女自身のフィードバックをAlphabetが無視したと同僚へのメールで批判したことを、挙げている。

その後CEOのSundar Pichaiは、文書で「博士の退社に対する反応は、はっきりと聞こえている。それは疑念を植え付け、われわれのコミュニティの一部がGoogleにおける立ち位置を自問するに至った」と指摘し、「非常に申し訳なく感じており、信頼回復に努める責任を受け入れたい」と述べている。

私は、今後の私たちの生活に与えるAIの影響力を考えると、この件を目にして、背筋が、ぞくっとしたことを思いだす。

Gebru事件は「経営者が職場で聞きたくない問題、差別が常に存在する」ことを示唆する

Gebru博士は、AI倫理研究分野のリーダー的存在であり、AI関連の黒人団体「Black in AI 」の共同設立者でもある。彼女は「顔認証が女性や有色人種の顔を認証する上での正確性は他より低く、顔認証の使用はこうした人への差別となりかねない」と指摘する、革新的な論文を共同執筆したことで有名な人物でもある。

彼女が解雇されてから、Alphabet社員2,500人以上と学術・産業・市民社会の支持者4,000人以上がGebru博士を支持する請願書に署名した。請願書は、「Gebru博士は、類まれな才能を持ち大きな功績を収めた貢献者としてグーグルから受け入れられるのではなく、保身的な対応や人種差別、Gaslighting(相手が自分の考えを疑うよう仕向ける心理的策略)、研究の検閲を受け、最後に報復として解雇された」と主張している。

2020年のLeadership IQによる5,778人の米国成人対象の調査「Many Leaders Don’t Want To Hear About Discrimination In The Workplace(多くのリーダーは、職場での差別の話を聞きたくない)」でも、職場で自分への問題を起こすことなく常に報告できると感じていた黒人社員はわずか13%だった。また、職場での差別に関する懸念を報告すれば、経営陣は常に解決のため意義のある行動を取ってくれると答えた女性はわずか23%だった。

多くの企業は「聞く姿勢」を見せるが、企業はその際に自己弁護や正当化を試みる。

経営者にとって、職場における差別問題や懸念を聞くことは容易ではなく、尚且つ時には不快な気分になる。これは「認知的不協和」、即ち心理的に相反する2つの考え(或いは態度や意見)を持つ時に生じる不快な緊張状態を創出してしまうからである。

私は、当初AlphabetのCEOのPichaiも非白人であるのに、なぜGebru博士の見解を理解出来ないのか?と一瞬考えたが、シリコンバレーにおけるアジア系非白人は、マイノリティとは言い難い点から考えれば、これは納得がいった。Gebru博士の場合は「黒人+女性」というマイノリティの比重は乗数となり、尚且つAIという今後社会において最も重要な影響力を及ぼす領域で、「女性と有色人種への差別にもつながる、顔認証の不正確さの指摘」は、Alphabetにとって、かなり耳が痛い話である。

Alphabet社員たちのGebru事件以降の急速な動き

2021年1月Alphabetでは、シリコンバレーでは非常に稀な動きであるが、労働組合が結成された。現在社員200名以上が「Alphabet Workers Union」に加入した(Alpabetの社員は13万2,000人以上)。Communications Workers of America Local 1400(米国通信労働組合の1400支部)と提携し、全社員及び契約・派遣社員を対象とする初の労組で、年間の基本給とボーナスの1%を組合費として、毎年支払う組合員によって支えられる。組合の目標は、団体交渉やAlphabetによる正式承認ではなく、「キャリアへの影響に直面することなく、社員が自社について発言できるようにすること」だという。

Alphabetは長年、社員の開かれた議論を促してきたが、一方では社員間の政治的な会話を抑制する狙いのルールも導入している。こうした状況下で、社員の不満は増加し、2018年には数千人の社員が、セクシャルハラスメントの加害者を昇進・保護する職場文化があると訴え、抗議運動に立ち上がった。組合員は、Alphabetが自社に批判的な社員に報復している、差別や嫌がらせの苦情にほとんど対応していないと指摘する。また今回の組合結成の大きな理由の1つとして、Gebru博士の解雇も挙げられており、積極的な行動に打って出ない限り、社内改革は行われないことを実感したという。

Gebru博士に続いて、またしてもAI倫理研究の女性が解雇される

2021年2月19日、Alphabetは、AIの倫理研究の共同責任者だったMargaret Mitchellを解雇した。Alphabetによると、解雇理由は「ビジネス上の極秘文書と他の社員の個人情報をひそかに流出」させたためであるという。但しこれは、彼女はGebru博士を不当に扱った証拠を探っていたために、解雇されたと、言い換えることが可能である。

Mitchellは「私は自分の立場を行使して、Googleに人種と男女の不平等に関する疑念を提起しようとした。こうして解雇されたことに呆然としている」と、Finantial Timesの記者に語っている。

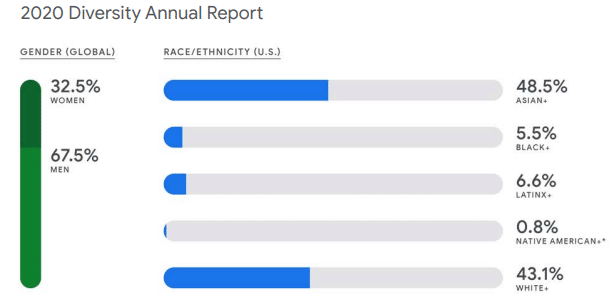

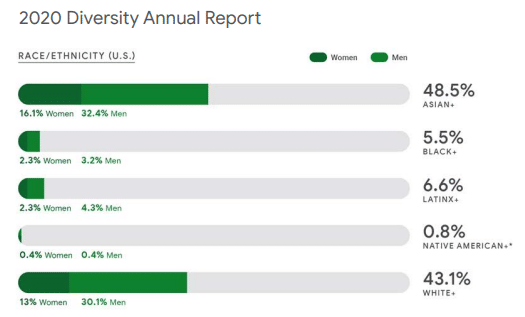

Alphabetの多様性に関する最新の報告によれば、社員のうち女性は3分の1以下で(2019年よりもわずかに減少)、米国の社員の黒人が占める割合は5.5%である(米国人口の黒人比率は13%)。

Alphabetに限らずハイテク企業の人種及びジェンダーの不均衡は常に指摘されている事柄である。但し今後は、労組結成に見られるように、株主以上に「モノ言う社員」の圧力は増大する可能性が高い。さらに、これは人種やジェンダー以外に、労働者の権利や企業の環境問題の取り組みなど、広範囲な課題が取り上げられる傾向にある。

AIに倫理的で公平な判断をさせるためには、多くの人間の力が必要

Gebru問題は、AIが持つバイアスの問題に、人々の注意を向けさせた。膨大な数の過去のテキストから学習するAIは、人種やジェンダーに関する過去のバイアスを取り込んでしまう。より公正な判断をするAIの開発には、時間と資金を犠牲にしてでも、人間のチェックを介在させる必要がある。

政治科学者Virginia Eubanksの2018年の著書『Automating Inequality: How High-Tech Tools Profile, Police, and Punish the Poor(自動化する不平等)』では、医療や給付金、治安関連の業務で用いられるAIシステムは、官民問わず、偏ったデータと人種的・ジェンダー的なバイアスに基づいて、不安定で有害な判断を下すという。また、AIシステムは判断に至るまでの思考回路がブラックボックス化されているため、たとえ判断結果が間違っていても、それを確認したり、異議を申し立てたりするのが難しいという。

AIは過去から未来を予想するため、バイアスが必ず存在する。この危険性を我々は認知すべきである

Gebru博士が論文で非難したツールは、Google検索システムで検索結果が表示されるまでの過程において、重要な部分を占める。このシステムは、我々の生活を効率的で便利なものにしてくれる。但し、AIは人間の活動や発言について莫大な量のデータを調べ上げて、そこからパターンや相関関係を見いだそうとする。いわば、過去の人間の動きから、未来を予想するという仕組みである。

これは誰もが思い当たるように、膨大な人種やジェンダーに関するステレオタイプ、偏見、差別が過去の我々の言動に存在する以上、それらのバイアスは当然AIに反映される。じゃあ、これを取り除くために、人間の介入や判断を取り込むとすると、どうなるか? 1つ目はその人間の倫理観念が本当に適性であるかどうかを誰が判断するのか? 2つ目は人間の介入によってデータ処理速度は低下してしまう、3つ目は費用がより大きくかかる、といったことが問題として、生じる。

この辺りを考え始めて、私はアタマを抱えてしまった。特に1つ目の「誰の倫理観念を適正と判断するのか?」が、重しのようにのしかかる。

2015年6月28日、NYのプログラマーがアプリGoogle Photoにアップロードしたガールフレンドとの写真(2人は黒人)が「ゴリラ」にタグ付けされた話は有名である。「ゴリラ」に限らず「イヌ」とタグ付けされた例もあり、その後、Googleは「ゴリラ」のタグの削除やキーワードでの検索停止などの対応策を表明したが、抜本的な解決は今もされていない。

コロナ禍の米国において、特にコロナ発生源として中国が、前大統領の言動で煽られて、最近はアジア人へのヘイト発言や行動も事件化するほど目に付く。AIのバイアス問題は、様々な課題を私たちに突き付けてくるが、少なくとも、このAIのバイアスを持ちやすいメカニズムを理解して、多く人達がより偏見や差別のない言動をしていくしかないと思う。そのためにも、あらゆる場所における『Diversity &Inclusivity』が重要となり、企業内ではこの問題にしっかり立ち向かう必要がある。

困難な問題であるけれども、早急に解決しなければならない、非常に切迫した問題でもある。未来のために、今手を打つしかない。

いいなと思ったら応援しよう!