iPadで視線トラッキング

本校でiPad Airを購入しました。

計画時に考えていたのは、

・AR

・3Dスキャン

・3Dトラッキング

・ドローンの操作

・動画編集(簡易)

・データーロガーのデータ分析(簡易)

・ブロック型プログラミング

等でした。

ところが、中学部の先生に、

「iOS18で視線トラッキングができるようになったから、視線入力ができる生徒が高等部に入学するときにiPad Airを買うという選択肢も出てくるのではないか。」

と言われました。

うちの県では、高等部の1人1台端末は保護者が用意することになっています。

保護者が一旦立て替えする必要がありますが、一定額(5万円程度)まで就学奨励費で戻ってくる仕組みになっています。

従来、視線入力と言えば高価な装置が必要になりますが、iPad Airで実用的な視線入力ができるなら、今後差額の払える家庭が選択することが考えられます。

iOS18は9月16日から配信されているため、検証してみました。

自分の背景

私は肢体不自由特別支援学校の教師です。

本校には以前から視線入力装置がありましたが、台数が少ないことや、対応するパソコンとソフトが購入できないことから、私は全く触れていませんでした。

ところが、GIGAスクール構想で入出力支援機器の予算があり、学部に1台ずつ、視線入力装置とソフトが来ました。

しかし、対応するパソコンがありませんでした。

さすがに国費で購入した備品扱い(10万円以上)の物品が使えないのはまずいので、いろいろ工作(?)して対応するパソコンを1台工面し、高等部でかかわった生徒に使ってきました。

なお、視線入力に関しては専門的な講習等は受けていません。

iPadの視線トラッキング

iOS18の視線トラッキングですが、対応機種についてはAppleからきちんとしたアナウンスが無いようです。

FaceID対応機種だけではないかと言っている人がいますが、私物のiPad Air(第5世代)と息子のiPad(第10世代)でも設定はできたので、関係ないようです。

学校でiPad Air(11インチ)に触っている時間が無かったので、この記事では私物の2機種で検証してみます。

設定

まず、iPadを顔から50cm離れた場所に固定します。

縦置きでも横置きでも大丈夫です。

50cmと聞くと、iPadで夢中になって遊んでいる息子の鼻先によく30cmの定規を突き付けて、

「近いよ!」

と注意しているので、離れすぎではないかと思いましたが、実際に置いてみると、確かに視線入力ならそのくらいの距離が必要だなぁという感じでした。

次に設定をします。

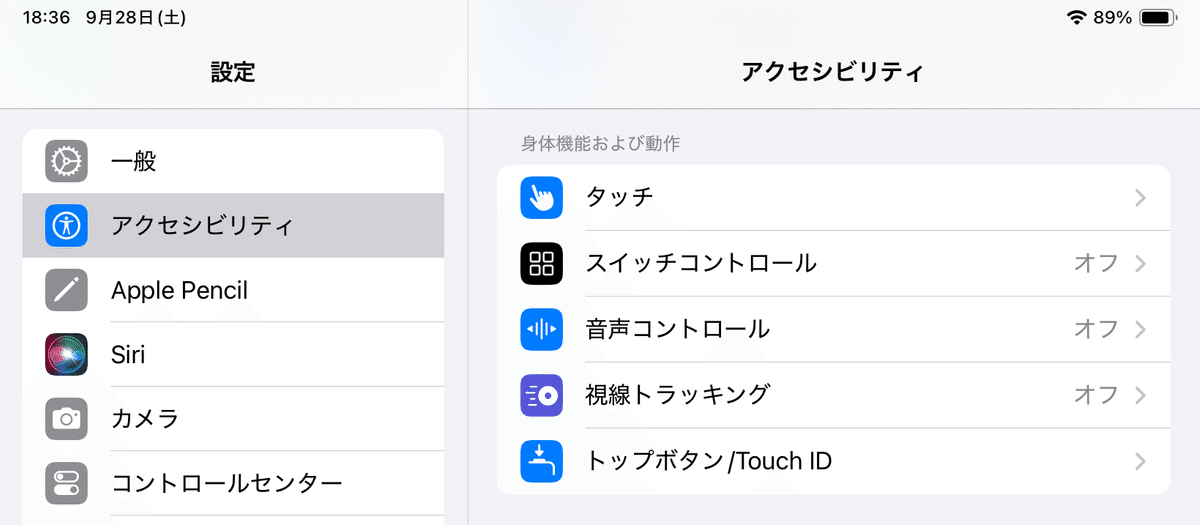

視線トラッキングは「設定」→「アクセシビリティ」で「身体機能および動作」の項目にあります。

「視線トラッキング」をオンにすると、キャリブレーションが始まります。

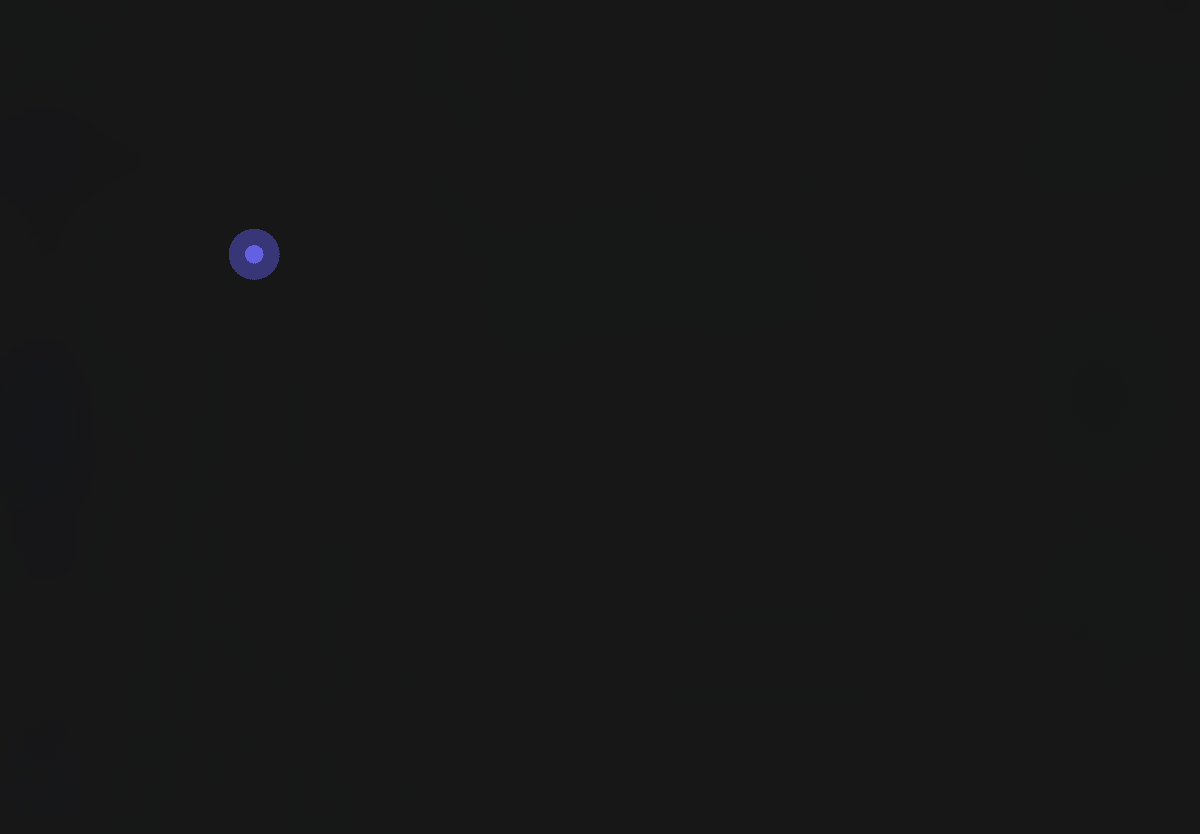

色の付いた点を見て追いかけます。

最後に中央にチェックマークが付くとキャリブレーション終了です。

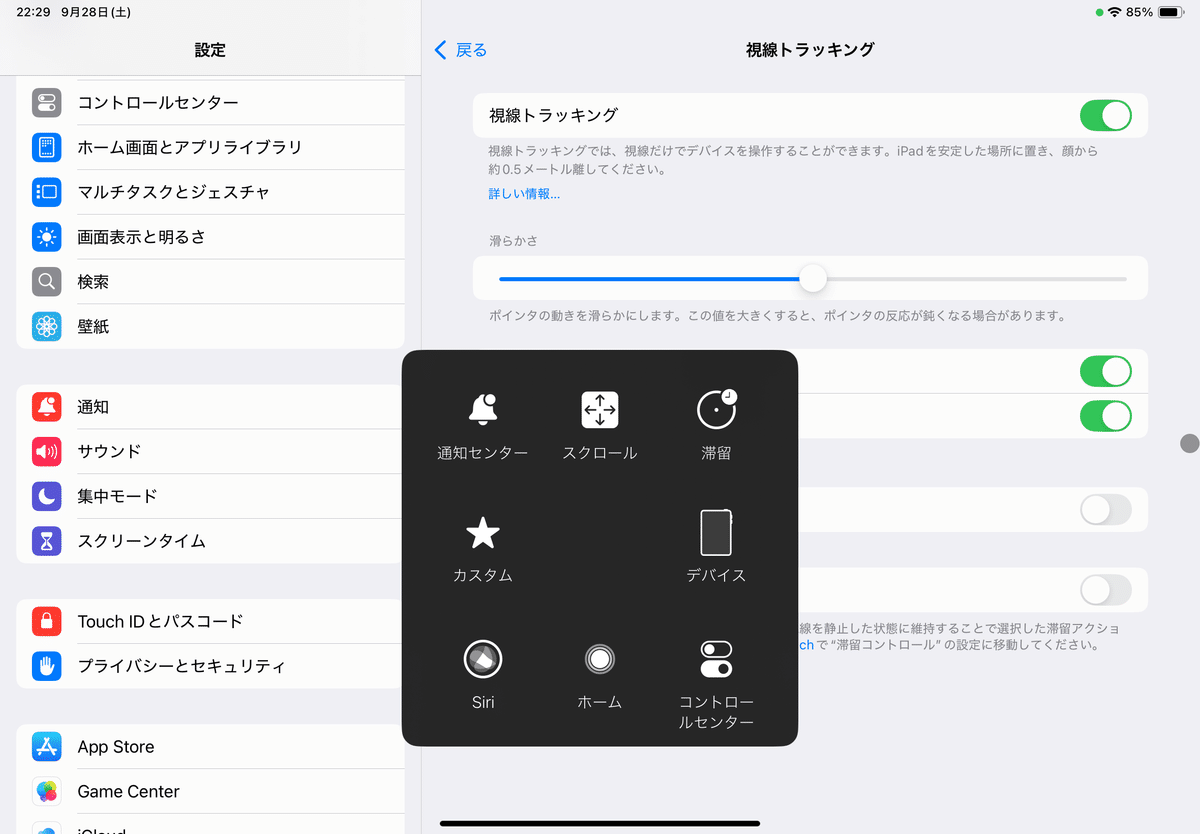

画面右下にAssistiveTouchの丸いボタンが表示されます。

視線での操作は、タップしたい部分を凝視して、マーカーが円を1周回るとタップの動作になります。

画面スクロールはAssistiveTouchのボタンをタップ(視線で可)するとあります。

ちなみに、画面の左上の角を凝視すると、再度キャリブレーションが始まります。

縦置き横置きを変えると、その都度キャリブレーションが必要です。

使ってみて

すごい技術だとは思いますが、iPad Air(第5世代)では実用になりませんでした。

視線をなかなか正確には読み取ってくれません。

最初は良いかなと思っても、マーカーが視点からずれてしまいます。

顔の向きや位置が少しでも変わってしまうと途端に精度が悪くなります。

縦置きでも横置きでも同様です。

iPad(第10世代)ではマーカーが震えてしまい、全く使い物になりませんでした(自分の目は近視ですが眼振はありません)。

学校で購入したiPad Airは第6世代(11インチ)なので、試してみたら追記したいと思います。

まとめ

視線トラッキングができるからという理由でiPadを購入するのは、まだお勧めできません。

Tobiiのアイトラッキング製品の方がストレスなく視線入力に使えます。

でも、しばらく経てば、おそらく実用に耐えられる性能になっていくのでしょうね。

この記事が気に入ったらサポートをしてみませんか?