#HuggingFace

Google Colab で SSD-1B を試す

「Google Colab」で「SSD-1B」を試したので、まとめました。

1. SSD-1B「SSD-1B」(Segmind Stable Diffusion Model) は、「SDXL」(Stable Diffusion XL) を50% 小型化したバージョンで、高品質のテキストから画像への生成機能を維持しながら60% の高速化を実現します。

2. Colabでの実行Colabでの実行手

LLMのファインチューニング で 何ができて 何ができないのか

LLMのファインチューニングで何ができて、何ができないのかまとめました。

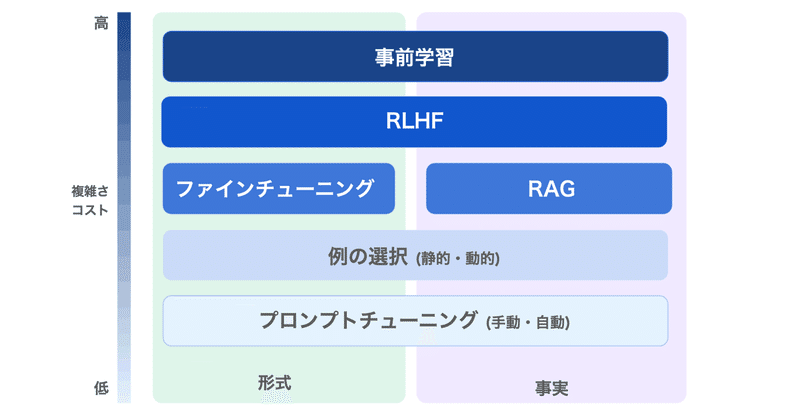

1. LLMのファインチューニングLLMのファインチューニングの目的は、「特定のアプリケーションのニーズとデータに基づいて、モデルの出力の品質を向上させること」にあります。

OpenAIのドキュメントには、次のように記述されています。

しかし実際には、それよりもかなり複雑です。

LLMには「大量のデータを投げれば自動

Stable DiffusionモデルカタログA面(更新終了)

新しい記事を公開したので、よろしくお願いします。

※Updates ceased as of 06-30-2023

※SDv1モデル、SDv2モデル、VAE、TI embeddingsの順に掲載しています。

※画像の設定は、サンプルからの拝借(修正する場合あり)または独自です。VAEは、必ずしも推奨のものではありません。

※画像のキャプションに「(fix)」があるモデルは、使用時にCLIPのp

- #AIイラスト

- #StableDiffusion

- #HuggingFace

- #Civitai

- #safetensors

- #BreakDomainAnime

- #ckpt

- #BreakDomain

- #BreakDomainRealistic

- #SukiAniMix

- #DefmixV3

- #endlessMix

- #ShiratakiMix

- #blue_pencil

- #meinamix

- #FlexWaifu

- #BreakDro

- #HimawariMixV2

- #ghostnotes

- #MORIMORImix

- #zzzmix

- #SukumizuMix

- #SE_V3_A

- #WD15b3

- #KaedeMix

- #ShuimohuaAnime

- #HimawariMix

- #SakuraMix

- #aliceDollMix

- #IrisMix

Rinna 3.6B の量子化とメモリ消費量

「Google Colabでの「Rinna 3.6B」の量子化とメモリ消費量を調べてみました。

1. 量子化とメモリ消費量「量子化」は、LLMのメモリ消費量を削減するための手法の1つです。通常、メモリ使用量が削減のトレードオフとして、LLMの精度が低下します。

AutoTokenizer.from_pretrained()の以下のパラメータを調整します。

2. Colabでの確認Colabで