AIは「お笑い」を理解できるか

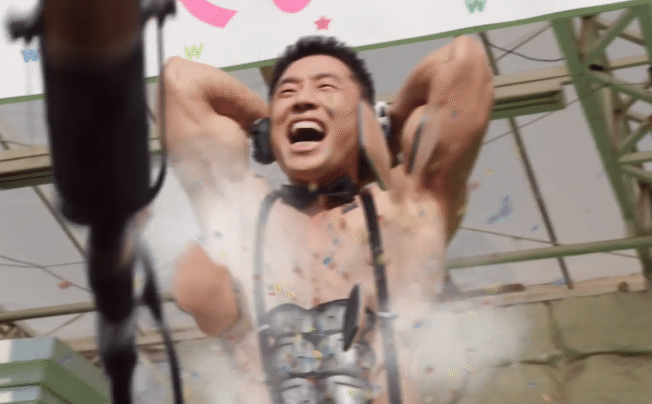

仮面ライダーゼロワンの記念すべき第一話、ストーリーの一番最初に出てくるヒューマギア「腹筋崩壊太郎」。いきなり登場して腹筋を爆発させ笑いを取ったのが印象深かったのでゼロワン好きならば絶対に覚えているでしょう。

ゼロワンの主人公であり、このころはまだ売れないお笑い芸人であった飛電或人は、腹筋崩壊太郎に簡単にメインステージの座を奪われてしまいます。劇場の支配人が、「お笑いもヒューマギアでよい時代なんだ・・・」といった時に、或人が発したのがこの一言だったのです。

「人工知能に人間のお笑いは理解できないでしょ」

主役の座を奪われた或人が発した、単に悔しさまぎれの一言だとも言えるでしょう。しかし、その後のストーリーで或人が「ヒューマギアにだって人格がある」と強く信じ始めることを考えると非常に興味深い一言でした。

ということで本題ですが、

実際のところ「AIに人間のお笑いは理解できない」のでしょうか。

この質問に厳密に回答する場合、現時点でのAIは人間の脳とは全く違う仕組みを持っているわけですから、AIが人間のようにお笑いを理解することはないと言えます。この質問は「AIに感情があるのか」という質問と似ていますね。AIと人間は違うものなのでAIが人間と同じ反応をすることは今のところはないのです。

しかし、実際のところ、あなた自身はお笑いが理解できているという自信がありますか?

そもそもお笑いを理解するというのはどういうことでしょうか。お笑いという抽象的なモノに対して我々はなんとなく分かったつもりになっているだけではないでしょうか。

お笑いが理解できるということを因数分解していくと、それは、①人間が理解できる映像や言語で、②人間が面白おかしいと思うポイント(笑いのツボ)を刺激する、ということをやっていることがわかります。本当はもっと細かく因数分解できるでしょうが、、そうやってお笑いを要素に分解していくと、その一つ一つの機能はAIにとっても実現可能なことになって行くのです。

例えば、AIにまずは言語の基礎となる文法や大量の文例を覚えさせ、次にAIに人間が面白いと思うポイントを大量に学習させれば、結果として人間が面白いと思うコンテンツをAIが大量に作り出し始める可能性はあります。今、iPhoneに搭載されたSiriやアマゾンのアレクサも簡単なジョークを言うことができますよね。

以前、ソニーCSL研究所がビートルズの曲を大量に学習したAIを作ったことがあります。このAIは実に全く新しいビートルズ(風)の曲を作り上げたのです。これはAIがビートルズを理解したとも言えなくもないでしょうか?

AIを使うということはそういうことなのです。人間の脳は抽象的なモノを与えられると残りを自動で補完したり、なんとなく場の雰囲気から推測したりといろんな情報で補います。その抽象化されたものを想像外の方向に少し外してあげるとそこにお笑いの面白さが出てくるのかもしれませんね。

人間の脳は非常に複雑であり、その全容が分かっているわけではありません。だから何を面白いと感じるかも非常に複雑です。人それぞれ違う可能性もあります。しかし、脳が面白いと感じる部分を一個ずつ因数分解していけば、最終的にはAIの方がはるかに面白くなる可能性は多分にあるのです。のでしょう。

一方、人間とAIにはお互いを認知するうえで超えられないだろうと思われている感情の壁があります。その一つが人間がAIを見た時に「何これ気持ち悪い、、」と思ってしまういわゆる不気味の壁というものです。

しかし、以下の動画を見てください。藤堂さんという若いクリエイターの方が作った人型のロボットです。最初はナニコレ?と思うのですが、見ているとどんどん感情移入していきませんか?最後は可愛くて連れて帰りたくなります。

そうです。この動画見ているとき、まさに人間は「不気味の壁」を超える瞬間を体験します。そこに感情があるかどうか、それを判断するのは受け取る人間側であることが分かります。

AIにお笑いが分かるのか。実際のところAIは人間の感情のようなもの計算し、相手の表情を見ながら正確にシミュレートし、目の前にいる人間にとってあたかもお笑いの機微が分かっているようなコンテンツを創り出すことができるようになるでしょう。

そして、それを「AIがお笑い理解できている」と感じるかどうか。それは、それを受け取る人間側がそう感じるかどうかという点につきそうです。

ところで、腹筋崩壊太郎を演じた中山きんに君、彼はお笑い理解しているでしょうかw。

この記事が気に入ったらサポートをしてみませんか?