AI リスクリポジトリ

はじめに

AIリスクリポジトリ(AIRR)というAIリスクのデータベースを見つけたので自分なりに調べたり触ってみました。

※個人の感想なので間違いなどあればご指摘ください。

どうやらAIRRはMIT(マサチューセッツ工科大学)FutureTechの方たちが中心となって作ったもののようです。

AIリスクリポジトリとは

AIに関連するリスクを体系的に整理し、公開されたデータベースのことでAIシステムがもたらすリスクに関する情報を収集・分類し、それを共有することで、リスクの評価や管理を効果的に行えるようにすることを目的としています。

このリポジトリは、リスクに対する共通の理解を促進し、政策立案者や研究者、AI開発者、監査人などがリスクに適切に対処するための基盤を提供するもののようです。

既存の43の分類から抽出した777のリスクを、因果関係に基づく分類法とドメインに基づく分類法の2つの視点で整理しています。

1.因果関係に基づく分類法

因果関係に基づく分類法(Causal Taxonomy)は、リスクがどのように発生するかを以下の3つの要因で分類しています。

主体(Entity): リスクを引き起こす主体が人間なのか、AIシステムなのか、それとも他の要因なのかを分類します。

意図(Intent): リスクが意図的に発生したものか、非意図的に発生したものかを分類します。

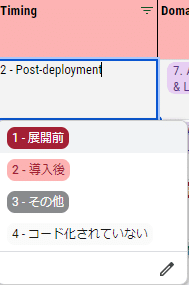

タイミング(Timing): リスクがAIの展開前に発生するのか、展開後に発生するのかを分類します。

2. ドメインに基づく分類法

ドメインに基づく分類法(Domain Taxonomy)は、リスクを7つの主要なリスク領域に分類しています。これらの領域はさらに23のサブドメインに分けられています。主要なリスク領域は以下の通りです。

差別と有害性(Discrimination & toxicity)

プライバシーとセキュリティ(Privacy & security)

誤情報(Misinformation)

悪意のある行為者と悪用(Malicious actors & misuse)

人間とコンピュータの相互作用(Human-computer interaction)

社会経済的および環境的な影響(Socioeconomic & environmental)

AIシステムの安全性、失敗、制限(AI system safety, failures & limitations)

AIリスクデータベースの使い方

AIリスクDBというものがるらしく、これがAIRRの核のようです。

DBは以下からスプレッドシートにコピーして使います。

まず公式のリファレンス(というより簡易的な手順)がありました。

具体的に以下のように使うみたいです

AI リスクデータベース v1というタブに上記のシートがあります。

上記の操作をすると、対処方法がでると思ったのですがそうではないようです(もしくは自分が上手く使えていないのか、、、)

→中の人に質問を投げておきました

ただ、ドキュメントやこのシートの分類の精緻さや作り込みはすごく良くできている感じがするので、上手く活用できたらAIリスク全般に役立てられものだと感じました。

この記事が気に入ったらサポートをしてみませんか?