「#未来のためにできること」に応募してみました⑩一定量以上の蜂蜜(Honey)が蜂達の物語の主役になり得る様に、一定量以上の資本(Money)は社員達の物語の主役になり得るのか?

以下の投稿についてのプロダクション・ノート的まとめ。

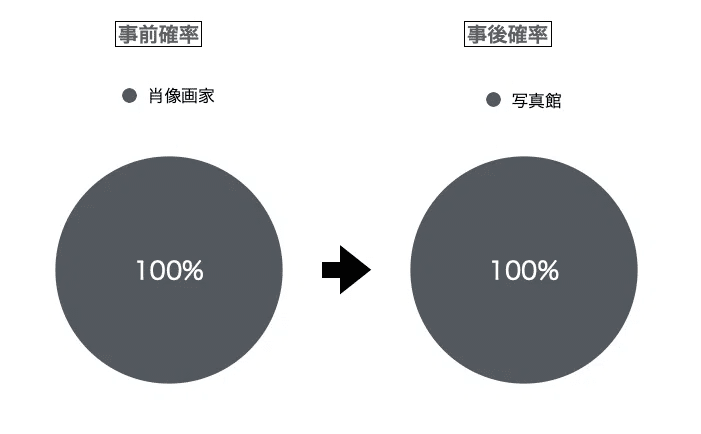

はてさて自然言語の進化は写真の登場が肖像画家を、トーキー映画がサイレント映画弁士を駆逐した様な悲劇を再び繰り返すのでしょうか?

その話に踏み込む前に「そもそも機械学習技術とは何か?」という話から始めたいと思います。

LLM(Large Language Model)登場前夜の機械学習界隈の風景

機械学習技術の大源流、すなわち「訓練用データとテスト用データを分けて考える機械学習」概念の嚆矢はニューラル・コンピューティングの最も原始的な形態と等価の数理的推定モデル、すなわちロジスティック回帰(1958年)となります。

深層学習アルゴリズムの大源流は、同年発表されたニューロン・コンピューティングにおける単細胞パーセプトロン理論と同内容のロジスティック回帰理論の登場(1958年)。情報理論の古典的教科書たるノーバート・ウィーナー「サイバネティクス(初版1948年)」の1961年増補箇所にもその爪痕を残していますが、世間一般が反応したのもまた「人間と対話しながら特定事例を分類する」Mycin登場(1970年代初頭)あたりからで、しかも「コンピュータ診断の結果は誰が保証する?」なる反人工知能論争勃発の契機に。

まぁこの段階では隠れ層もなければ、バックエンドで稼働してる数理モデルも最小二乗法に毛が生えた(というか、ほとんどそれそのものを利用した)線形分解タイプに過ぎなかった訳ですが、これ以降機械学習理論は「訓練用データとテスト用データを分けてそれぞれ別段階で与える」インターフェイス自体は全く変えないまま高度化の一途を辿り今日に至るのです。当事者は不満タラタラみたいですが、見た目がが同じ以上「人類の大源流は猿(より正確には「既に滅びた猿と人間の共通の祖先」)」というより確実な祖先性が現れているとしか言い様がないのですね。

ChatGPTに「あなたは最小二乗法やロジスティック回帰の末裔ですか?」なんて質問を投げると「あんな単純パーセプトロン野郎と一緒くたにするな!! せめてサポートベクターマシン(SVM)とか勉強しやがれ!!(意訳)」みたいな「感情的な」回答が得られます。人工知能側にとっては「あなたも猿の末裔でしょ?」と言われた様な侮辱的発言となる様だ?

この事を強く意識する様になったのは2010年代後半、Googleが2015年に機械学習ソフトウェア開発フレームワークTensorFlowをリリースした途端、人工知能界隈が一斉にこれに飛びついてブログにチュートリアルの進捗状況を書き連ねるのが流行するのを目の当たりにしてから。私が2017年以降数学再勉強に着手する契機の一つとなった出来事ですが、その内容がまさに「用意された訓練用とテスト用のデータセットに対して、ロジスティック回帰を嚆矢として次々とより高度なアルゴリズムを投入していき、誤差が次第に縮小していく様子を観察する」という内容だったのでした。

そう「訓練用データとテスト用データを分けて考えるインターフェース」成立以降は、「分布とパラメーターを指定するだけの」統計学ライブラリー同様「ライブラリー・ユーザー側からの見え方」は随分と一本化される様になったという話。

同時期にはKaggleにおける誤差縮小競争が加熱し「特定の既存データの学習について誤差を縮小させる事しか考えない研究者が増えた」「かかる不毛な競争が齎すのは単なる過学習結果に過ぎず、実用に結びつかない」といった批判が相次いでいたのです。同時にgoogleの開発フレームワークのみに人気が集まるのは独占を生むだけだ、なる主張も登場。イーロン・マスクが2017年にOpenAI社を設立したのも、同じ懸念を抱いたからとされています。

当時の機械学習界隈では深層学習よりランダムフォレスト法が発見された決定技の方が人気でしたが、この時代まで遡ればまぁ「機械学習とは何か?」について余計な思い込みを抱えるのは回避出来るという話ですね。その一方で「裏側がどうなっているか」については、もう手の負えない範囲に…

深層学習と決定木(特にランダムフォレストや勾配ブースティングのようなアンサンブル手法)を組み合わせることは、両方の長所を活かし、パフォーマンスを向上させるアプローチです。このような組み合わせは、以下のようにいくつかの形で実現されることがあります。

1. スタッキング (Stacking)

スタッキングは、アンサンブル学習の手法の一つで、異なるモデルの出力を別のメタモデルに入力して、最終的な予測を行う方法です。この場合、深層学習モデルと決定木ベースのアンサンブルモデル(ランダムフォレストやXGBoostなど)を組み合わせることができます。

ステップ1: 深層学習モデルと決定木アンサンブルを個別に訓練し、それぞれがデータに対して予測を行う。

ステップ2: これらのモデルの出力(確率や分類結果など)を新しい特徴量として使い、それを別のモデル(メタモデル)に入力します。メタモデルには、例えばロジスティック回帰や他の学習アルゴリズムを使うことが多いです。

この方法は、複数の異なるアプローチ(深層学習と決定木)が持つ強みを組み合わせることで、より高精度な予測を目指します。

2. ブースティング + 深層学習

深層学習のモデルと、勾配ブースティング(GBDT, XGBoost, LightGBMなど)を組み合わせる形です。具体的には、ブースティングを行う際に、深層学習の出力を特徴量の一部として使います。

ステップ1: まず、深層学習モデル(例えばニューラルネットワーク)を訓練し、その中間層の出力や最終的な確率を新しい特徴量として抽出します。

ステップ2: その後、ブースティングアルゴリズムを使って、この新しい特徴量に基づいて予測を行います。

これにより、深層学習が抽出した高次元な特徴を決定木ベースのモデルがさらに洗練させることができ、特に非線形性の高いデータセットに対して強力なパフォーマンスを発揮します。

3. 前処理と特徴量生成

決定木を使って、データセットの重要な特徴量を生成し、その後で深層学習モデルを使う方法です。このアプローチでは、決定木ベースのアンサンブルが特徴量選択や生成に使われ、選ばれた重要な特徴量を深層学習モデルに投入します。

ステップ1: ランダムフォレストやXGBoostなどで、データの重要な特徴量を発見します。

ステップ2: 決定木で生成した特徴量を使って、深層学習モデルを訓練し、最終的な予測を行います。

このアプローチは、深層学習が多次元の特徴を処理する際に、不要な特徴を減らし、効率的な学習が可能になります。

4. 深層学習による特徴抽出 + 決定木のアンサンブル

逆に、深層学習モデル(例えばCNNやRNNなど)を使ってデータの特徴を抽出し、その後で決定木アンサンブルを使って分類や回帰を行うこともあります。

ステップ1: 深層学習を使って画像やテキストのような複雑なデータから特徴を抽出。

ステップ2: 抽出された特徴を、ランダムフォレストやXGBoostのような決定木アンサンブルに渡して最終予測を行います。

このアプローチは、例えば画像処理や自然言語処理のようなタスクで、深層学習が得意とする特徴抽出能力を活かしながら、決定木の解釈可能な予測モデルを使用することができます。

まとめ

深層学習と決定木のアンサンブルを組み合わせることで、それぞれの長所を活かし、より強力で柔軟なモデルを構築することが可能です。スタッキングやブースティング、特徴量生成といった手法により、この組み合わせは、複雑な非線形問題や高次元データセットに対して特に有効です。

分布意味論的確率空間はベイズ推定と相性が悪い?

LLMも含め自然言語処理というのは「ある時間、ある空間範囲の」訓練データをベクトル化し、それぞれの出現頻度や条件付同時出現確率などから分布意味論的確率空間を構築するのを基本としています。

だから、ベイズ更新による「検索範囲絞り込み」はともかく「検索範囲拡大」への対応が理論上難しそうなのです(興味深い事に、完全に不可能ではない)。

例えば私がしばしば引用するノーバート・ウィナー「サイバネティクス(1948年初版、1961年増補)」についてChatGPTに要約させてみましょう。

ノーバート・ウィーナーの『サイバネティクス』は、1948年に出版されたもので、通信や制御の理論を生物学、機械工学、社会システムに適用し、複雑なシステムの理解を深める基礎を築いた作品です。現代でもその考え方は多くの分野に影響を与え続けていますが、時代の進展に伴い、通用しない部分も存在します。

現代でも通じる部分

1. フィードバックの重要性

ウィーナーのサイバネティクス理論の中心には、フィードバックが含まれています。現在でも、自動制御システムやAI、機械学習において、フィードバックループは不可欠な概念です。例えば、サーモスタットやロボティクスなど多くの自律的なシステムがこの原理に基づいています。

2. システムの相互作用

サイバネティクスでは、システムの相互作用やネットワーク効果に焦点を当てており、これは今日のインターネットや社会システム、さらには神経科学や経済モデルなどでもそのまま活用されています。複雑系の理解において、この視点は今も非常に有効です。

3. 情報理論の基盤

ウィーナーの理論は情報理論にも大きな影響を与え、特に通信やデータの処理においてその基本的な考え方は現代でも応用されています。今日のインターネットやデジタル通信システムでは、ウィーナーが示した情報とエネルギーの関連性が重要な役割を果たしています。

現代では通じない部分

1. 技術的な限界

ウィーナーの時代の計算機は、今日のコンピュータと比べると非常に限られた性能しか持っていませんでした。そのため、彼の理論は一部の複雑な問題に適用できないか、実用的ではなかった面があります。現代では、膨大なデータをリアルタイムで処理できる技術が進展し、サイバネティクスの枠組みを超える応用が可能です。

2. 生物学的システムの単純化

ウィーナーは生物学的なシステムをサイバネティクスの理論で説明しましたが、現代の分子生物学や神経科学では、生命システムが彼の時代に考えられていたよりもはるかに複雑であることが明らかになっています。生物学の詳細なメカニズムにおいて、彼の理論では対応しきれない部分が多くなっています。

3. 社会システムの解釈の限界

ウィーナーはサイバネティクスの原理を社会システムに適用しましたが、現代の社会科学は人間の行動や社会の複雑さをより深く理解するために、心理学や文化、経済など多くの要因を考慮する必要があることが明確になっています。サイバネティクスの機械的なモデルでは、こうした人間社会の複雑な側面を完全に捉えることは難しいです。

これらの点から、ウィーナーの『サイバネティクス』は今もなお多くの分野で重要な基礎を提供している一方で、技術や科学の進展により、通じない部分も浮き彫りになっています。

「サイバネティクス」原典を通読してるので、この要約が「ウィーナーはサイバネティクスの原理を社会システムに適用しました」という箇所で軽くハルシネーション(Hallucination)を起こしている点を除けば、ほぼ正しいと断言出来ます。

「ウィーナーはサイバネティクスの原理を社会システムに適用しました」という箇所で軽くハルシネーション(Hallucination)を起こしている…ノーバート・ウィナー自身は軍事技術から出発し、個体を構成する臓器間のホルモン分泌連鎖(生理学)や群を構成する個体のホルモン連鎖(生物行動学)をも援用する様になったサイバネティクス技術がそのまま人間社会そのものに射影可能とは考えておらず、適応可能と考える立場に反対し続けた。ただし、それにもかかわらず「KGI(Key Goal Indicator)やKPI(Key Performance Indicator)の適切設定」や「ERP(Enterprise Resources Planning)」といった経営概念にはその反映がみられるという意見もある。そう、まさにカート・ボガネット・Jr.「ローズウォーターさん、あなたに神のお恵みを(1965年)」冒頭にもある通り。一定量以上の蜂蜜(Honey)が蜂達の物語の主役になり得る様に、一定量以上の資本(Money)は社員達の物語の主役になり得るという次第なのである。

ここで「だけど、人間はその蜂蜜を…」というややこしい話が急浮上。

そして…

言語生成系AIは、言語モデルが適当と思われるテキストを生成しているだけですので、その真贋についてはインターネット検索(この結果にも一定の誤謬が含まれるものです)以上に問題があります。検索結果を鵜呑みにしてはならず、信憑性を自ら吟味できること、より信憑性の高い情報は一次情報源に向かって探索を深めなくては得られないことは、インターネット検索の場合と同様に変わりません。

言語生成系AIの登場に伴って、そのような調査の基本 — 情報源の信憑性の吟味や情報源の表示や確認など — を改めて教えることが重要になり、教育の機会でもあります。安易なインターネット検索・言語生成系AIだけによる問題解決の危険性についても、学生に向けて問題提起をして下さい。

その一方でこの内容は、「ベイズ更新」の概念を導入して以下の様に整理した方が実態に即しているとも感じる訳です。

1948年初版段階(事前確率空間)…軍事技術の延長線上に成立した情報理論は、当初あらゆる事象を線形フィードバックに分解可能と考えていた(FA(Factory Automation)やOA(Office Automation)くらいはこの理解で十分実装可能とも)。

1961年増補版段階(ベイズ推定1回目)…線形フィードバックに分解可能な事象が限られている事が明らかとなり、個体を構成する臓器間のホルモン分泌連鎖(生理学)や群を構成する個体のフェロモン(外部ホルモン)連鎖(生物行動学)の様な非線形フィードバックに関心を移すも当時のコンピューター性能の限界から、十分な研究が出来なかった(それでも「KGI(Key Goal Indicator)やKPI(Key Performance Indicator)の適切設定」や「ERP(Enterprise Resources Planning)」といった経営概念に影響を与える)。

それ以降の発展(ベイズ推定2回目以降)…それ以降の分子生物学や神経科学の発展とコンピューター科学の発展により「軍隊や生理学や生物行動学のアナロジーで考える」意義そのものが薄れ、今日に至る。

考えてみれば、以下で触れた「二つの方法論」のアンサンブル?

こういう場合の情報量回復の手段は2通り。アノマロカリスの生存手段を模倣して追い抜いた魚類の様に主要技術への知識を深めて出し抜き方を考えるか、あるいは(棘や殻や毒で自衛して捕食者の関心を下げる作戦の真逆に)、生成AIの学習が十分でなく、かつそれなりに需要がある領域を伸ばして自らの付加価値を高めて関心を引き戻すか。

分布意味論的確率空間がベイズ推定を扱える場合

例えば「イタリアン・ファシズムと未来派の関係(当初は共鳴するも、やがて関係が破綻)」など。

イタリアン・ファシズムと未来派(フューチャリズム)は、20世紀初頭のイタリアにおいて互いに影響を与え合った思想・文化運動です。特に、両者の間には暴力的な革新や技術進歩の礼賛、国家主義といった共通点がありましたが、それぞれ異なる目的や方向性を持っていました。

1. 未来派の特徴

未来派は、1909年にフィリッポ・トンマーゾ・マリネッティが発表した「未来派宣言」によって始まりました。この芸術運動は、工業化、機械、速度、暴力、技術革新を称賛し、古典的な伝統や過去の価値観を否定することを特徴としていました。

スピードと力の美学: 未来派は、自動車、飛行機、工場といった新しい技術や工業社会を芸術的に称賛しました。これには、人間の活動の加速化や機械の力に対する礼賛が含まれます。

戦争の賛美: 未来派の思想には、戦争を社会の革新やリセットとして捉える過激な側面があり、暴力を肯定する要素が強く含まれていました。

2. ファシズムとの接点

イタリアのファシズムは、ベニート・ムッソリーニによって1920年代に台頭した政治運動で、強力な国家主義と中央集権的な統制、社会の革新と秩序の維持を強調しました。未来派とファシズムは、初期の段階では共通の政治的・文化的目標を持ち、相互に影響を与えました。

国家主義と革新: 未来派が技術革新や機械文明を賞賛したように、ファシズムも「新しい国家」を構築するために革新と強力なリーダーシップを求めました。両者は「新しいイタリア」を築くために、古い伝統を破壊し、強い国家体制を志向しました。

暴力と力の賛美: ファシズムが暴力や戦争を社会を一新する手段として用いたように、未来派も破壊的な力を肯定しました。このため、未来派の芸術家たちの一部はファシスト運動に共鳴し、ムッソリーニの支持者となりました。

3. 未来派とファシズムの関わり

未来派のリーダーであるマリネッティは、初期のムッソリーニのファシスト運動を支持し、ファシズムと未来派は一時的に強く結びついていました。マリネッティ自身もファシスト党に参加し、ファシズムが掲げる強い国家の建設と未来派の革新思想が融合する形を志向しました。

政治的関与: マリネッティは、ファシズム政権初期の文化政策に関与し、未来派芸術家たちが国家のプロパガンダや公共事業に参加する機会を得ました。未来派のスタイルは、ファシスト政権下の建築やデザインに影響を与えました。

違いと衝突: しかし、未来派とファシズムの間には明確な違いもありました。未来派は技術革新や極端な個人主義を重視していたのに対し、ファシズムは秩序、伝統、国家統制を優先しました。このため、最終的には未来派とファシスト政権の間で意見の不一致が生じ、未来派はファシズムの統制下で次第に影響力を失っていきました。

まとめ

イタリアン・ファシズムと未来派は、共通の革新や暴力の礼賛という点で結びついていましたが、未来派の過激な技術礼賛や自由奔放な創造力と、ファシズムの秩序や国家主義との間には深い違いもありました。結果的に、未来派はファシズムの初期に影響を与えたものの、ファシズムが権力を掌握するとその影響力は減少していきました。

こういう形で分布意味論的確率空間が成立すると、「検索範囲を絞り込んだ(イタリアン・ファシズムと未来派が対立する以前の事象のみ集めた)」ベイズ更新結果を事前確率空間に設定する形で「途中でベイズ更新が起こる」文章を作成出来るっぽいですね。

「サイバネティクス」の場合、事後確率空間に事前確率空間に存在しない事象(非線形フィードバック)が登場してくるのが問題?

逆ポーランド記法の有用性と問題点

要するに人工知能は「AはBである」と先に結論を告げて「ここでいうAとは…」「ここでいうBとは…」と補足する論法を「出来ない」というより「許されてない」が、その制約を外してもまた別の問題が生じるだけだろう(あまりお勧めは出来ない)という話ですね。

逆ポーランド記法(RPN: Reverse Polish Notation)は、数式を表現する方法の一つで、数値や演算子の順序を工夫することで、計算の手順をシンプルにするという特徴があります。特に、括弧を使わずに演算の優先順位を明確にできる点で有用です。以下に、逆ポーランド記法の有用性と問題点を挙げます。

有用性

括弧が不要

逆ポーランド記法では、演算の優先順位を明確にするために括弧を使う必要がありません。これにより、式がシンプルになり、コンピュータでの処理が容易になります。

例: 標準的な式「(3 + 4) × 5」は、RPNでは「3 4 + 5 ×」となり、括弧が不要です。

計算の効率性

RPNは、スタックデータ構造を用いて効率的に処理できます。演算子が現れるたびに、スタックの上から値を取り出して計算を行い、その結果を再度スタックに戻すという簡単な手順で計算が進みます。

このシンプルな処理の流れは、古い計算機やコンピュータにとっても計算効率が高く、ハードウェアでの実装が容易です。

左から右への一貫した処理

RPNでは、演算の順序が一貫しており、数式を左から右に順に処理できます。これにより、式を解析する際のアルゴリズムがシンプルになります。

計算機での広範な使用

RPNは、特に電卓やコンピュータの初期計算機で広く使われました。例えば、HP製の計算機ではRPNが標準的な表記法として採用され、計算精度や入力効率の向上が図られました。

問題点

直感的でない

RPNは、通常の中置記法(数式の一般的な書き方、例: 3 + 4 × 5)に慣れている人にとっては直感的でなく、理解しにくいことがあります。演算子の順序が後置されるため、式を読み解くのに訓練が必要です。

例: 通常の式「(3 + 4) × 5」を「3 4 + 5 ×」と表現するRPNは、初学者には馴染みづらい。

長い式が読みにくい

RPNでは、複雑な式になるほど記述が冗長になり、読みづらくなることがあります。演算子が後に続くため、長い数式を一目で解釈するのが困難になる場合があります。

例: 通常の式「(5 - 3) × (6 + 2)」は「5 3 - 6 2 + ×」となり、やや解読が難しい。

計算の途中経過が不明瞭

RPNでは、演算が進むにつれてスタックに値が積み上げられるため、計算の途中経過がどのようになっているのかを理解するのが難しい場合があります。特に、大規模な計算では、途中のステップが不明確になりやすいです。

人間には非効率的

RPNは計算機にとっては効率的ですが、人間が手作業で計算を行う場合には、かえって非効率であることがあります。通常の中置記法に慣れている人にとって、RPN形式を手計算で処理することは煩雑です。

まとめ

逆ポーランド記法は、計算機やコンピュータにとって効率的であり、括弧のない明確な優先順位がメリットです。一方で、人間にとっては直感的でなく、特に長い式や複雑な計算を扱う際には理解しづらいという問題点があります。

とまぁ、こういう考え方さえ出来てればそう簡単には淘汰されないんじゃないかな、というのが私の立場な訳ですね。そんな感じで以下続報…

この記事が気に入ったらサポートをしてみませんか?