元法務部のCLM導入コンサルタントがChatGPT使ってみた(前編)

皆さんこんにちは、「すべての合意をフェアにする」MNTSQ(モンテスキュー)株式会社の佐藤でございます。

遅くなりましたが本年もよろしくお願いいたします。今年のこのnoteの目標としては、月1件必ず投稿し、年12件の記事を出すことです。頑張ります。

さて、巷で話題のアレ、私も触ってみました。

ChatGPT!!!

既に世間ではエンジニア、非エンジニアを問わず多くの皆さんが先行して体験しており、それぞれの感想や分析記事を出されていますね。

私も興味があったので遊んでみた、という次第です。

トップ絵は、せっかく文章生成AIの記事なので、画像生成AIであるStable Diffusionで「A robot that is manipulating a laptop」と入れて出てきた画像を使ってみました。

実際のレポートをする前に、ごく簡単におさらいと今回の目的です。

ChatGPTとは

OpenAIが開発した自然言語処理モデルです。

Transformerというニューラルネットワークアーキテクチャをベースにした大規模言語モデルGPT-3を利用しています(末尾のGPTはこれが由来)。

大量のテキストデータから言語の共通パターンを学習し、人間のような自然な文章を生成することができる、というのが売りです。

GPT-3についてはこちらの記事が簡潔かつ分かりやすいです

なにを試したかったか

専門的な回答には向いていない、ということを事前知識としては知りつつ、法文書や法律的な相談について、元企業法務部員としてどの程度許容できる、あるいは利用できるアウトプットが出るのかの確認をしてみたかったのです。

やってみた

まずは軽く、世間でも評価されている一般的な質問です。

質問の選定、回答内容の吟味については、私のほかにもう一人、法務経験者の阿部が同席・協力してくれました。

レシピを聞く

ふむふむ。

カタカタとワープロを打っているような感じでまさにチャットっぽいですね(まさにトップ絵のような)。

CEOの板谷に画面を見せてみたところ、「これ佐藤さんが手で打ってるんじゃないよね?(笑)」と冗談を飛ばしたくらいです。

結論・論拠と構造化して、論拠の要素に番号まで振って回答が返ってくるのはすごいですね。文章にも綻びが少なく、とても読みやすい。

ただ「みじん切り玉ねぎを炒めて、粗熱をとってから加える」「パン粉を入れる」はしないんですね。そういう意味では、王道を外れた回答。

従来型のチャットボットでは、こうした質問と回答のセットを人間があらかじめ想定して入力しておく必要があったかと思いますが、こうした突飛な質問に対しても(内容の正確性はともかくとして)質問の文脈に沿った回答生成をするのはすごいですね。

飛び入りで横から覗いていたエンジニアの舛岡は、「モデル作成に使用した数百テラバイトの学習データは、学術文献などの『堅い』文章をメインにしていたんじゃないか?」という感想も漏らしていました。

論文や報告書って結論が先で論拠が後、という構成は固まっていて、箇条書きなどのお作法もきっちりしていますからね。

スポーツの知識を聞く

もう少し細かいことを聞いてみることにしました

フルコートのサッカーはよく見ますがフットサルは詳しくない佐藤でもわかるくらい、それっぽいけど解像度がなく中身のない回答です。チームワークいつでも大事やで……。

フットサル愛好家の阿部によると、これは明確な対応戦術があって、特定の回答を期待して質問したそうです。残念。

だんだん性格や傾向・癖がわかってきたような気がしますね。

CLM

我々が提供しているサービス、CLMについても説明してもらいました。

お、いいですね。作成や実行、終了までの一連のフェーズをカバーする、とか、契約に関連する情報を統合して管理、といった要素をきちんと挙げているし、契約のライフサイクル全体の効率化、リスク軽減という効果の面にも触れられている。

これは学習していたようです。素晴らしい。

でも、少し用語が小難しくてわかりづらいですね。もっとかみ砕いて説明してもらえないもんでしょうか。

おおっ! Twitterで見かけた質問テクニックを活用してみましたが、単語が置き換わっていて説明の難易度・レベルが明確に落ちましたね!

珍しく、CLMは、契約は……と主語を二回繰り返す初歩的な文法誤りをやらかしていますが。

人間同士の会話でも「5歳児にもわかるように説明してよ」といわれることはありますけれども、実は「その説明は難しいからもっと簡単に話してくれ」ということを婉曲的に書いた、かつ文脈によっては「そういう配慮ができずに小難しいこと言ってるぞ」という嫌味や皮肉も含んだあいまいな表現です。

人対人ではさらにその前提として、「人間の5歳児は難しい単語を知らず知能もまだ発達しきっていないので、難解な文章を理解できない。そのため、説明のレベルを落とさなければならない」という共通認識も必要だったりするかと思います。

そのような認識を持っていたとまでは言えないでしょうが、少なくとも学習の結果、アルゴリズムが「説明のレベルを大幅に落とせ」という趣旨で質問の文脈を高度に解釈しているといえるのではないかと思います。これは単純にすごい。

いざ法クラ

さあ肩慣らしはここまで。これからが本番です。

法務部にするような相談をしてみましょう。

まず、いわゆる「よろず法律相談」(依頼者が比較的抽象的な法解釈を尋ねてくること)です

もうド典型の質問ですね。

が、回答は大外れ……実務的な回答をするうえでの基本ツールである「印紙税法」、「印紙税額一覧表」、「印紙税基本通達」とかを見ればわかるような知識が入ってないようです。

ちなみに、こういう質問を受けた瞬間に弁護士や法務部の頭の中ではビビビッと電気が走り、「契約類型によって左右されるものの、印紙が必要な場合4000円であるいわゆる7号文書か?」ということを知識として呼び出します。

そうした予感を脇に置きつつ、必要な情報を確認するために依頼者の方に色々ヒアリングを進めていくわけですね。

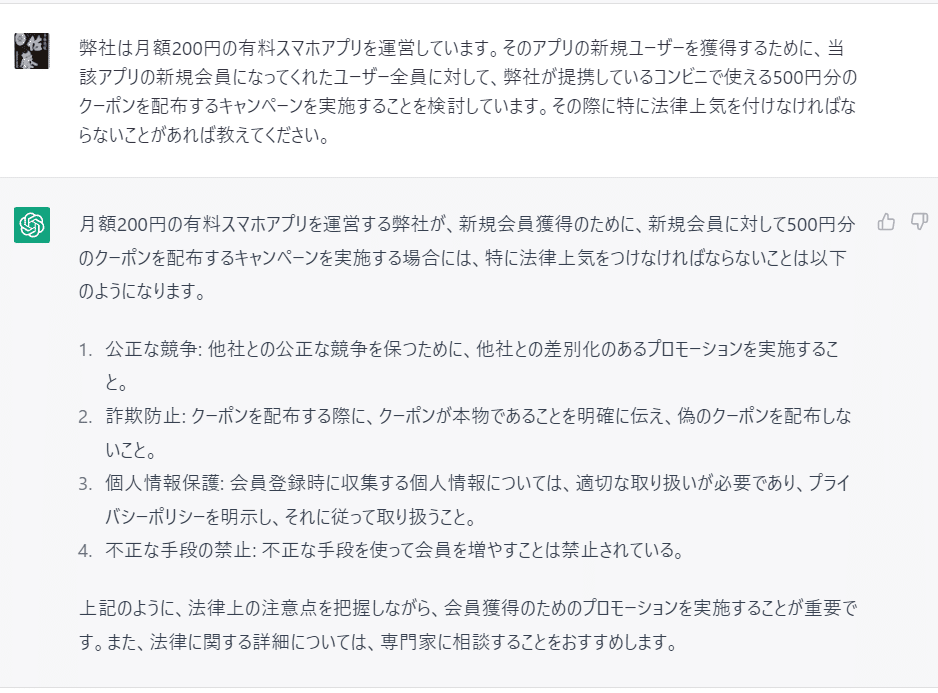

続いてこちら

これも、ある程度熟練した法務ならああメインはこれだなというのは一目で論点に気づくタイプの質問です。

しかし……うーん……これはちょっと、学習状況が実務で使うクオリティに到達していませんね。専門知識のない方がこれをうのみにして、法律上穴のある対応を推し進めたら危ないレベルです。

ちなみに上記の論点というのは、景品表示法上の「総付景品(そうづけけいひん)」です。詳しくは説明を省きますが、めちゃくちゃざっくりいえば対象者全員に提供するタイプの景品は景品の最高額が一定額を超えるとアウト、というルールです。

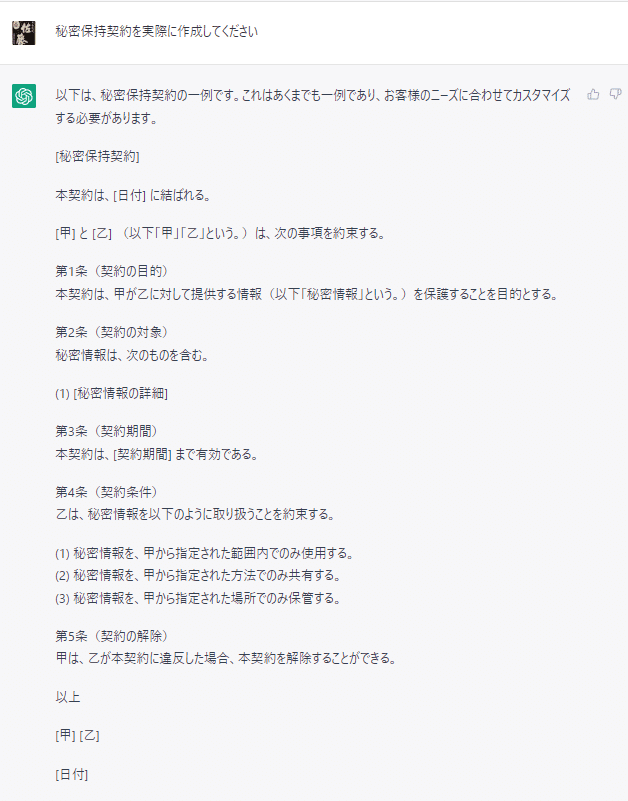

少し趣を変えて、具体な契約書の作成依頼をしてみましょう。

うーん、条文が寂しい。一般条項がないのはいいにしても。

秘密情報の定義条項(詳細)については、市販雛型ですら秘密情報の種別や伝達態様などを定義したものを用意していますし、中身を列記してほしかったところですね。これでは使いづらい。

当社ファウンダーの安野が昨年やってみたところによると、いくつか質問をして回答を出力させる=>その前提で契約書を作成して、という流れでやっていた模様。

ChatGPTに秘密保持契約を書かせてみるテスト pic.twitter.com/gTvNBLXhj3

— 安野貴博 (@takahiroanno) December 3, 2022

こうした「呪文詠唱」(依頼する文章を工夫して書くこと)のコツが必要そうですね。

依頼部門と法務部の間でも必要事項の伝達は必要ですしやり取りを繰り返すことは間々ありますのでそれ自体はおかしくないかもしれませんが、逆に言えばあんまり進歩した感じがないです。

契約の組み立てがなんとなく英文契約っぽいなぁと思ったところでひらめいた。英語の国のプロダクトなのだから英語でもやってみたらいいじゃないか。当社ファウンダーの安野も言っている。

これ英語で英米法の話聞いたらどうなるかみてほしい、たぶんデータセット的にあっちの方ができる子なのではないかという仮説

— 安野貴博 (@takahiroanno) December 18, 2022

はやい!!!(動画がなくて恐縮ですが、和文がルパン三世のタイトルコールだとすると、英文は機関銃で打っているかのよう)

内容もまだまだではありますが、和文と比べたらだいぶマシです。

やはり英語の学習データが基本だからでしょうね。特にアメリカの場合契約書についてはオープンデータが豊富にあるため、学習環境は整いやすい傾向にあります。

もちろん、これをそのまま使うわけにはいかず、巷の英文契約雛型集のNDAを利用したほうが必要な条文の検討漏れもなくクオリティを保てると思います。

和文・英文ともシンプルでとっつきやすいNDAでこういった結果なので、より突っ込んだ契約書の検討は無理だろうな……とこの辺で見切りをつけました(一応売買や業務委託なども試してみましたし、特定の条項についての有利不利の判定を試みたりしましたが、芳しい結果は得られなかったため割愛します)。

ただとにかく言語モデルが非常に自然で優秀なため、「それなりに読める文章が出力され、かつ学習が不十分で専門知識はそれほどでもない」状況でこれなら、きちんと学習したらどうなるのか、という点で言えば末恐ろしいなという感じですね。

最後に

上記のChatGPT操作は基本的に昨年12月22日に行い、記事のベースを執筆し始めたのも、同じころでした。

ただ、年明けの今年1月24日時点で再度試してみたところ……

回答を避けるようになっていました。

もともとChatGPTは犯罪につながるような質問の回答を拒絶しますので、それに加えて、「犯罪ではないが不正・不当な出力」についてもOpenAI社が制御しているということですね。

専門性の高いジャンルについて不正確な回答をすることによって発生する害について認識して、アルゴリズムを調整したんでしょうか。

いずれにせよ、法律で認められた専門職の存在するドメインでAIによる自動化を行おうとすると、日本の弁護士法のような規制法令と抵触する可能性は避けられないでしょう。

昨年時点の私自身の使用感でも、これを法律相談などに商用化するのは危なっかしくて使えない印象だったので、これはある意味必然な流れかもしれません。

ただ、繰り返しになりますが一般的な領域でのハイコンテクストな質問に対しても文脈を理解し構造化して出力される返答については非常に自然で、モデルの高度さに驚くことも多かったです。

次回は、ChatGPTをうまく活用して採用広報記事の執筆を効率化・省力化する試みにチャレンジしてみようと思います。

ご興味持たれた方は、カジュアル面談でお話しできればと思います。お待ちしております!

おまけ

法律クラスタにとっては定番のネタを聞いてみました。

違う!「故意責任の本質は規範に直面し反対動機を形成可能であったにもかかわらずそれを乗り越え、敢えて行為に至った反規範的人格態度に対する道義的非難である」だ!(早口)

この記事が参加している募集

この記事が気に入ったらサポートをしてみませんか?