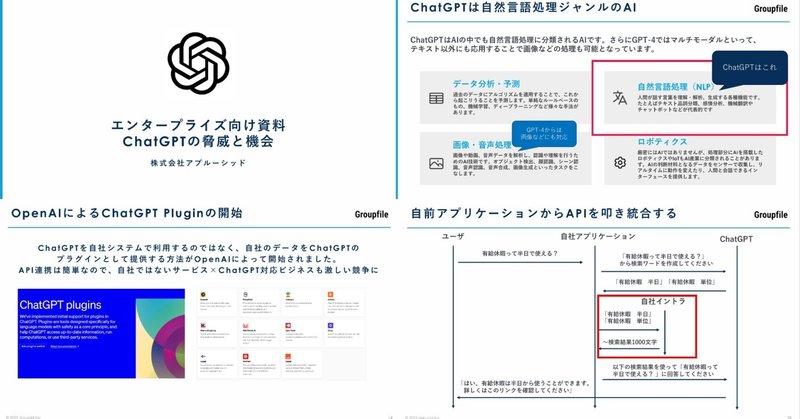

生成AIをどのように自社の環境に組み込むべきか~2023レポートから1年~

昨年、生成AIに関するスライド資料を公開しました。おかげさまでたくさんの人に読んでいただきました。

1年間たち、毎月のように新しいニュースが入ってきていますので、2024年になって「そろそろわが社も取り組みたい」という企業向けに振り返りとアップデートを書きたいと思います。

企業での実用に耐えうるのはまだテキスト処理が中心

GPT-4がマルチモーダルを発表して以降、画像の分析と生成、動画、音声など様々な応用例が生まれました。しかしながらその精度・速度などをみるとまだまだ企業の実用に耐えうる、もっといえば「使いやすい」ものはないように思います。

生成画像に関しては、Adobe Fireflyのクリエータ向け支援機能や、直接生成AIをつかって広告やブログヘッダへの利用などが進んでいますが、いまだ限定的と言えます。

これはテキストが「アシスタント」として中間成果物を提供してそこから人間が仕上げる、というバトンタッチが容易なのに比べ、画像や動画には欠けているからです。その点Fireflyは画像を編集するソフトウエア内に組み込まれているので、一歩進んでいますが、自社のシステムに組みこむのは難しいでしょう。

そこで本記事ではテキスト生成AIに絞って書きたいと思います

ChatGPT一強から性能を競い合う時代に

添付のレポートを書いた1年前は、LLMの性能は(特に日本語においては)ChatGPT一強でした。

しかしその後、GoogleがGemini Proを公開し、GPTに迫る性能を格安な料金で提供を始めました。また、今月リリースされたAnthropicのClaude 3が、GPT-4を超える性能をだしたとニュースになりました。

これらの開発には莫大な計算資源が必要なため、プレイヤーが数多く増えることはないかもしれませんが、ビッグテック各社はその投資をよりいっそう進めています。Microsoft-OpenAI陣営をはじめ、Google陣営にはGeminiをAppleが採用するかもしれないという噂もあります。AmazonはBedrockという生成AIの実行環境を提供するとともに、Anthropicに約4200億円の追加投資を行うというニュースが入ってきました。

利用する企業からすると、価格・速度・コンテキスト長などを含めて、選択肢が出ることになりました。実装においては、これらのAPIを混ぜて単一のエンドポイントで使えるようなサービスやオープンソースのプロキシも登場しています。

オンプレLLMにも省エネ・高性能の改善がすすむ

同じく昨年のレポートでは、オンプレLLMはまだ厳しいということを書きましたが、この1年でこちらも多くの発表がありました。

日本語の学習量を増やし性能を高めたLLMをはじめ、各社がOSSモデルを独自にチューニングしたもの、ベースから学習したものなど様々です。

現在はビッグテックが上述のようにしのぎを削っていますので、汎用的な性能を低コストで得るには既存のLLMをAPI経由で利用したほうが多くの場合有用ですが

センシティブなデータを社内に閉じたまま生成AIで活用したい

膨大な量の推論をやりたい

要約やタグ付け、FAQなど特化した用途でそこそこ性能が出ればよい

といったケースでは、十分実用に耐えうるレベルまで来ているのではないでしょうか。学術目的以外に商用でも使えるモデルもありますので、ぜひ手元で動作させてみるとよいでしょう。

実行(推論)効率に関しても大きな進歩があります。LLMを8 bitや4 bitの少ないビット数に量子化することで性能をあまり落とさず計算量を減らす性能データも多数公開され、ついには(まだ実証可能な環境はありませんが)GPUが不要になるかもしれないという1-BitのBitNetも論文が公開されました。

これは、いま不足している高価なGPUをあまり使わずに(究極は全く搭載していない普通のクラウドサーバで)LLMが動かせる可能性を秘めています。

実際のところ何に利用すればいいのか?

社員に生成AIを使わせて生産性向上!プロンプト研修します!テンプレートあります!というビジネスは初期段階大きく流行し、一定の成果を上げているようです。

しかし、自社のシステムに組み込むような活用は、まだまだ進んでいるとは言えない状況です。とくに、チャットボットでの利用においては、AIが間違った案内を公式回答してしまうというハルシネーションを100%抑え込むのが難しいこともあり、自由に文章でやり取りするのは難しいようです。

また、問い合わせるお客様側も「自分が困っていることを的確に言語化する能力」が求められるため、自然言語によるやり取りにとらわれない方がよいでしょう。

一方で、問い合わせ対応のオペレータを支援するといった目的や、社内資料の要約やタグ付け、あるいは想定されるFAQの事前生成といった用途では、実用事例が出始めています。

これらの特徴は

AIからの出力をエンドユーザに渡さず人間が目視確認できる

元ある情報を変換(要約・言い換え・質問に変換)しているだけ

という点が挙げられます。このようなテキストマイニング分野のシステムは以前からありましたが、LLMによってより精度高く柔軟な変換ができるようになっています。

より複雑な実装例

生成AIをシステムに組み込むうえで、より複雑な連携も事例がいくつかあります。ひとつ目は社内検索システムへの検索クエリ生成です。この例は昨年のレポートでも私が書いた通りですが、これを応用し検索クエリだけでなくフォーム入力を自動化するような例もでてきています。

要は、システムが持っている入力インターフェースをLLMに伝えることで、自然言語とシステム入力の「テキスト変換」を行っているわけですね。

例)粗大ごみはなにをだしますか?→「液晶テレビとこたつ」とユーザー回答

→ { input: [{ "item": "こたつ", "quantity": 1 }, {"item": "液晶テレビ", "quantity": 1, "error": "液晶テレビは粗大ごみで出せません"}]}

ほかにも、ChatGPTはコードを書くことができますので、PythonやVBAのコードを書かせて実行させた結果をシステムとして使うこともできるでしょう。1回の生成で正解をだすのではなく、事前にたくさん生成しておいて人間は選ぶだけという方法も有効でしょう。

弊社の資本提携先ではありますが、AIでスライドを生成する「イルシル」では、ChatGPTにスライドの内容を考えさせ、さらには適したスライドのレイアウトも選択させるといった高度な処理も行っています(公開情報より)。

テンプレートの多さ、日本人がよく使う文書の網羅度合いのおかげで、MicrosoftのCopilotよりも日本人にとってはかなり良い生成が可能となっています。

もちろんこのように高度な連携を行うには、受け側のシステムを充実させる必要があり、イルシルでは1000パターン以上のデザインテンプレートを用意することで、生成AIが比較的自由な回答をしてきても当てはまるテンプレートを出力することができるようです。

そして、冒頭で書いた「AIが生成した中間生成物を人間が仕上げられる」プラットフォームのため、おかげさまで非常に伸びています。

「生成AIを使ってみた」だけでは同じようなサービスが山ほど生まれてしまうので、このようにたくさんの「データ」や「アセット」を用意することが、差別化のポイントになるのではないでしょうか。

もちろんビジネスとしては、日本だと生成AIを活用して受託やBPOを頑張っている企業のほうが短期的には成果が出ているみたいですが。

RAGはどうなった

テキスト生成AIの入力プロンプトの長さの制限のために、外部のデータベースと組み合わせるRAG("retrieval-augmented generation")が数多く登場しました。

しかし、GoogleのGeminiが最大100万トークンに対応すると発表してからこの考えは一部変わるようになりました。100万トークンは小説10巻分にもなる情報量ですので、外部データベースをもたなくても必要なデータをすべてプロンプトに含めてしまうという方法が現実的になったのです。

実際のところは予算も速度もあるのですが、それでも32k、128k程度の能力があれば、必要なデータを数万文字程度わたしてその場で生成させるという力技が簡単に成り立つのです。

文字をベクトルに変換して検索するベクトルDBでいま一つ性能が出なかった場合は、雑な全文検索で似たようなワードもすべて検索したうえで、ひっかかった3万文字の検索結果のなかからLLMに回答を生成させることが現実解となっています。

トラブル事例も豊富に

実装において、前述のチャットボットにおけるハルシネーション問題をはじめ、トラブル事例も多く出てくるようになりました。IBMからはAIリスクの書籍も刊行されています。(Amazonアソシエイトリンク)

2024年はシステムに「深く」AIを組み込みましょう

生成AIはAPIを契約すればすぐに使える状況もあり、またユースケースや法的、倫理的な問題の事例も多数出てきました。さらには生成AIと向き合う人間の側も「うまく困っていることを言語化できない」というインターフェースの課題も見えてきました。

単に社員にチャットAIを配布するだけでなく、2024年はAIを自社のシステムに組み込んだり、コンテンツの作成に活用したりと、ビジネスに直結する活用を増やしていきましょう!

※面白い事例があればTwitterか会社Webよりぜひ教えてください!

この記事が気に入ったらサポートをしてみませんか?