岡田美智男先生に聞いた「弱いロボット」と「チキンラーメンのくぼみ」の関係【コモさんの「ロボっていいとも!」】

こんにちは、コモリでございます。

ロボティクス業界のキーパーソンの友達の輪を広げるインタビューコーナー「ロボっていいとも!」のお時間です。

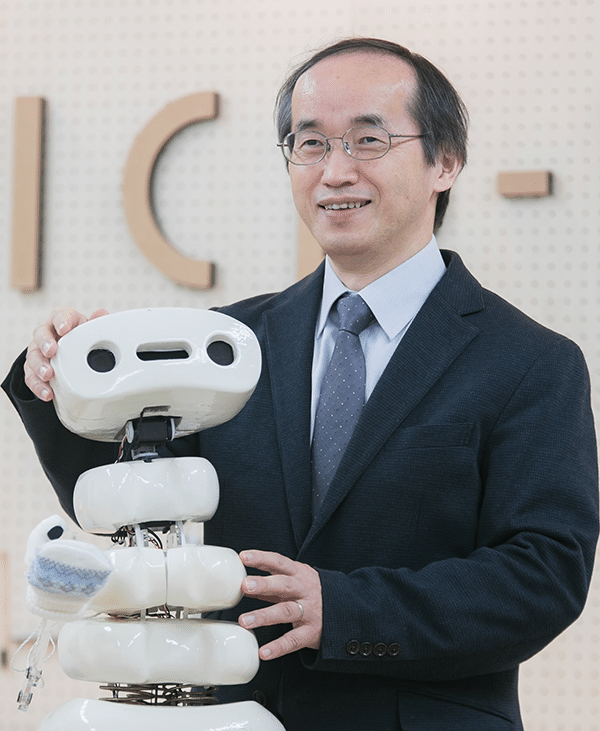

さて5回目となる今回は、「弱いロボット」の概念を提唱し、学生さんたちと数多くの「弱いロボット」を手掛けてきた岡田美智男先生をゲストにお呼びしています。

前回のゲストのGROOVE Xの林要さんも、ご自身が開発されたLOVOTの誕生の過程で、この「弱いロボット」のコンセプトに影響を受けたと語っておりました。

ご存じない方に「弱いロボット」を簡単に説明すると、人を手助けするなど「利便性を強調すること」がロボットには求められがちなところを、この「弱いロボット」はロボット自身の弱み、言い換えると苦手とする部分を隠さずに人前にさらけだすことで、まわりの人の手助けを得るとともに、逆に人の強みや幸福感を引き出してしまうロボットと言えます。

この「弱いロボット」シリーズで代表的なものが、こちらの動画にあるゴミ箱ロボットです。前者が初期の頃のバージョン、後者が比較的最近のバージョンのものになります。

どちらも、ゴミ箱ロボット自身は、手がついておらず、自らの力だけではゴミを拾うことができません。

しかし、ゴミを見つけると、まわりの人に対して視線を向けたり声を発することで注意を促し、人に「思わずゴミを拾ってあげよう」という気持ちを促すことで、このロボットは「ゴミを拾い集める」ということを達成してしまうわけです。また、ゴミを拾ってもらうと、ロボットは拾ってくれた人にお辞儀をします。こうすることで、人の方も「なんだか良いことをした」という気持ちになり、そこで達成感や有能感を味わうことができます。

子どもたちに手伝ってもらいゴミを拾い集める「ゴミ箱ロボット」

こうした新しいアプローチを15年以上も前に発表し、その後も研究を続けている岡田先生に、「弱いロボット」はどういう未来を目指しているかなどをコモリ流に今日は伺ってみたいと思います。

それではゲストをお招きしましょう。本日のゲスト、GROOVE Xの林要さんからのご紹介。豊橋技術科学大学 教授の岡田美智男先生です!

岡田 美智男

豊橋技術科学大学 情報・知能工学系 教授

岡田:こんにちは。よろしくお願いします。

「音声認識」から始まる研究者人生

――先生は大学生の頃からロボットや機械などに興味があったのですか?

どちらかと言えば、真空管やトランジスタ、LSIのような電子デバイスのほうが好きで、大学でも勉強していく中で量子力学や固体物理学の方面へ進もうと思っていました。

しかし、いざ研究室の配属を決める時にじゃんけんに負け、音声関係(認識)の研究室に入ることになったんです。

1980年代にも、「電話」や「電気通信」技術の名残があって、電子工学の分野で音声認識や音声合成などを手掛ける研究室がまだまだ存在していました。いまはデジタルですが、アナログフィルタって電子回路で作られていたわけですから。

そのような経緯で研究室に入り、東北大学大学院に進学してからも、音声認識と自然言語をつなぐような音声言語処理の研究に携わっていました。

今で言うところの「Siri」のような音声対話インターフェイスや、「Microsoft Word」でマイクに喋った言葉を書き起こしてくれる連続音声認識の研究を博士課程のとき、35~6年前にやっていました。

「弱いロボット」と「チキンラーメンのくぼみ」の関係

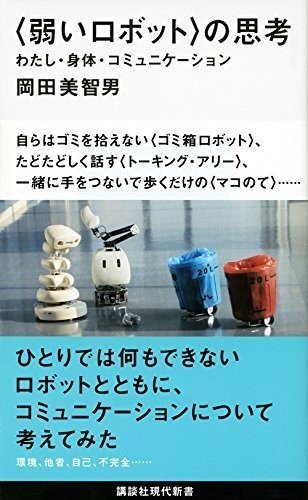

――今日、岡田先生からお話を伺えることをすごく楽しみにしていました。というのも、私はずっと、人間がより便利で効率的な生活をするための機械に興味を持ち、この方向を追及するような活動を続けてきました。しかし、先生の著書『〈弱いロボット〉の思考』を読んだところ、「人の側からロボットに寄り添っていく」ということが書かれており、それでハッと気づかされたというか、この先の人や社会とのかかわりについて深く考えてみようという切っ掛けになり、さらに人にそのような感情を抱かせるロボットについて工学的に研究し解明されている点に大変感銘を受けていました。

――「人の不便を解決するのがロボットだ」と思っていたのですが、最近になってエネルギー問題や社会の複雑さを考えると「先生がやられているような領域が未来に必要ではないか?」と思えるようになっているのですが、そのあたりはどうお考えですか?

人は常に利便性を追求してきました。けれども、そうした便利すぎる環境の中で生活を続けていても、なぜか「自分が生き生きしてこない」ということになんとなく気づきはじめた。「情報技術などのテクノロジーは本当に私たちを幸せにしているのか?」ということで、「ウェルビーイング(Well-being)を向上させるためのテクノロジー」ということを、いろいろな方々が考えはじめたわけです。

――今お話しされた「ウェルビーイング」について、もう少し説明してもらえますか?

ウェルビーイングは、いろいろな捉え方があると思いますが、端的にいえば「幸福感」とか、「自分が生かされ、生き生きとした幸せな状態」などを指しているのだと思います。

このウェルビーイングを向上させるためのインタラクションデザインを説明する時に、私は「チキンラーメンのくぼみ」を例にして説明することがあります。

あのくぼみは生卵を落とすために作られた「Wたまごポケット」と呼ばれるもののようなんですが、必ずしも人に卵を落とすことを強いているわけではありません。卵をのせるかどうかは自由であって、自己決定権担保されている。それは人に委ねられたものであり、工夫するための余地・余白を提供しているわけですね。

何をトッピングするかいろいろ考える、そのちょっとした手間や工夫によっておいしさもアップする。そのことで達成感や有能感などを覚えるわけです。それは、本来のチキンラーメンのしっかりした味付けとのコラボレーションのなせる技なのですが、そこでの関係性やつながり感なども生まれてくるかもしれません。

チキンラーメンには真ん中にくぼみがある

ポイントとなっているのは、「すべてを提供しているわけではない(Unfilled)」というところですよね。完全に調理されたものでも、すべてが提供されたものでもない。そこに人が手をくわえる余地や余白が残されていて、思わず関わってしまう、寄り添ってしまう。そこから「なんだか幸せ!」という幸福感、達成感、有能感、すなわち「ウェルビーイング」をアップするというわけです。

わたしたちの「弱いロボット」にも、この「チキンラーメンのくぼみ」のような働きがあるのではないかと考えています。

――興味深い話です。「チキンラーメンのくぼみ」にそういうデザインがあって、「弱いロボット」を理解するのにも分かりやすいモチーフですね。

ロボットにも「チキンラーメンのくぼみ」のような、不完全な部分はすでにあって、それを隠さなければ、それが人の関わる余地にもなるわけです。たとえばゴミ箱ロボットの例で言えば、自分ではゴミを拾えない不完全さが「くぼみ」なわけで、その「くぼみ」は、おもしろいことに人の強みや優しさなど、潜在的な能力を引き出してくれる。

このとき、ロボットを手助けすることが強いられているわけではない。思わず手伝ってしまうなかで、満足感や有能感、またロボットと一緒に目的を果たせたというわけで、関係性やつながり感なども生まれる。これらが幸福感をアップさせているのではないかと考えているわけです。

ロボットは「すごい、すごい!」と、その強みをアピールしようとするあまり、弱いところ不完全なところは見せたがらない。わたしたち人も同じですよね。ロボットも不完全なところ、あるいは弱いところを隠さずにさらけだすことで、ロボットと人の関係性がもっと豊かになる。その可能性は、まだまだ広がるのではないかと思うんです。

コミュニケーションのリアリティを追求した先にロボット作りがあった

――「弱いロボット」の研究を続けている先生が、これまでにどのような道を歩んでこられてきたかをもう少し伺いたいです。特に音声関連の研究をされてきた先生が、どのようにロボットの世界へ足を踏み入れたのか?には興味があります。

大学院を卒業後、NTT基礎研究所でも音声言語処理や対話理解の研究を続けていたわけですが、その後、関西の国際電気通信基礎技術研究所、通称・ATRという研究所に異動する機会があって、最初は「日常的な会話や雑談をどう認識・理解するか」というような議論や研究をしてました。

しかし、当時のATRは、人工生命研究のメッカでもあったんです。マルチエージェントシステムや創発システム、複雑適応系などの考え方に刺激を受けて、雑談や発話の非流暢性などの現象を一種の複雑適応系としてモデル化できないか・・・ということを考えていたんですね。

そうした流れの中で、最初はCGを使った仮想的なクリーチャー「Talking Eye」というものを制作し、そのクリーチャーたちで自律的に会話を生み出せないか、私たちとの間で会話を成立させることができるのか?ということを調べていました。

仮想的な世界で雑談を続ける 「Talking Eye」

しかし研究を続けていく中で、たとえばCGの中のクリーチャーたちが「助けてー!」と叫んだとしても、自分の中では「助けなければ!」という気持ちは起きなかった。それで、次第に、言葉のリアリティとか、コミュニケーションのリアリティということに興味を持つようになったんですね。

当時のCG技術には限界などもあったのですが、CG上のクリーチャーにはどうも共感しにくい。そこをどう補えばいいのかをずっと考えていました。そうした中で「仮想世界のCGではなく、実世界で身体性を追求していくことで、リアリティを生み出そう」ということになり、そのあたりからロボットを作りはじめるようになったのです。

2000年頃に開発した「Muu」

――そういう経緯だったんですね。仮想の物よりは実体を伴う方がリアリティを生み出せた・・・ということですか?

コミュニケーションというものは、世の中的にはいわゆる「会話」や「言葉」が重要であるように思われがちなのですが、実はそうでもないのです。

たとえば、今この瞬間にコモリさんと私がなんとなく上手く会話できているのも、私たち2人が同じような身体を持っているからで、相手のことをなんとなく理解できるわけなんです。

――そのお話は、先生の本を読んだ時にもあることで腑に落ちたことがありました。ある時にカミキリムシを捕まえて眺めていた時に「こいつが人間と同じ言葉を喋れたら面白いだろうなぁ」と思ったのですが、よくよく考えてみると実際に喋ってこっちに寄って来られたら、きっと怖く感じてしまうんだろうなぁと。先生が仰ったとおり、やはり身体的な基盤が共通していることで安心感を得ているのだと思いました。

当時も、そういう身体性をベースにコミュニケーションの研究をしてみたいと考えて、ロボットを作り始めたんです。

「弱いロボット」のしくみを自動運転システムに適用する

――話題が変わりますが、先生たちが作られた「NAMIDA」という自動車に付けられたインターフェイスにも実は興味があったのですが、これについても少し教えてもらえますか?

NAMIDAというのは、自動運転システムをソーシャルなロボットにするためのソーシャルなインターフェイスです。NAMIDAは自動運転システム内部の状態を人間に伝えようと、インターフェイスに備わった目の動きで伝えようとしてくれます。

自動運転システムは機械が勝手に状況判断して運転するわけですが、機械がどういう状態で何をどう判断して動いているかはドライバーである人間にはなかなか伝わりません。ドライバーからすると、いま機械が何を考えて運転しているのか分からないわけですから、それに自分の身体や命を預けてよいのか不安にもなります。

そこで「自動運転システム全体をソーシャルなロボットにすることで、システムが何を考えているのか伝わりやすくなるのではないか?」と考えたのです。

たとえば急ブレーキを掛けるにしても、何の前触れもなく急停止したのでは人はビックリしてしまいますが、NAMIDAの目が信号機を見ながらブレーキを掛けるなら、ドライバーは「システムは、赤信号に気づいたからブレーキを掛けたんだな」というふうに、システムの意図を捉えることができるようになるわけです。

徐行運転をしている時も、NAMIDAがキョロキョロしていれば「あ、近くに歩行者や障害物があることを注意しているんだな」と分かったり。自動運転システムの状態やいま考えていることが把握できると、自動運転システムに乗車していても安心できるのではないかと思うのです。

――なるほど。これも先ほどご説明いただいた「人が介在する余地を与える」ことで生まれる効果を狙っているというわけですね。

自動運転技術は進化を続けていますが、現状では、たとえば道路状況によってはセンサーの精度が低くなったりするなど、解決しないといけない課題もまだあります。

そうした自動運転の苦手な部分も、NAMIDAの場合はインターフェイス同士がキョロキョロと「どうしよう、どうしよう」みたいな挙動をするわけですが、そういう風に「システムの方は自信がなく、不安がっている」ということをドライバーに包み隠さずさらすことができると、ドライバーは「じゃあ、ここは自分が運転しようかな」と判断したりできるわけです。

弱いところを見せると人が入り込む余地・余白ができ、先ほど話した有能化、ウェルビーイングもアップさせながら、ドライビングを一緒に手伝ってあげるような感覚も提供できるようになる、というわけです。

――自動運転技術は当然事故を起こさないように改良が続けられている一方で、それでも技術や経済の面でも折り合いが付かず、どこかで人が関わらないといけない部分はどうしても出てくる・・・ということはたしかにあると思いますが、先生がおっしゃるように弱さの見せ方次第ではカバーできるのではないか・・・と思えるようになりますね。

「自動運転システムの考えていることが分からない」と、それ以上、関わることを放棄し、「運転のすべてをシステムに任せてしまう」ということになる。そうなると信頼度・安全度をいかに高めるかということを究極的に突き詰めないといけなくなるわけです。すると信頼度・安全度のために掛けるコストがドンドン高くなってしまうのです。

でも、適度に弱さを開示してあげる仕組みを作ってあげると、そこまで高コストにしなくても技術導入の折り合いが付くのではないかと思ってます。

――高齢化社会が進む昨今、自動車が生活に欠かせない地方、特に運転ができなくなる高齢者が多い過疎地域などでは、自動運転車の導入・実用化が早く進むことを願っていると聞きますが、社会は完璧な自動運転を目指しているので、社会への導入も遅くなりがちだと感じています。そのへんの折り合いはどうにかならないものかと思う部分もありますね。

今までのアプローチでは、一般道への適用はまだまだ先になると思います。そう考えると、NAMIDAのようにロボットによって、人の介在する余地を用意してあげれば、レベル3くらいの自動運転システムでも実用の折り合いがつくのではないかと考えております。

それを実証するために、自分たちもプロトタイプを作りデモンストレーションをしたいものだと思っています。

まだ準備中ですが、小さな「パーソナルビークル」のレベルで検証できるようなものを作ろうとしています。お見せしている写真は、そのプロトタイピングの過程で、学生さんが紙粘土で作ってくれた物です。

これにNAMIDAや自動運転に関与できるインタフェースを実装し、自分たちのアイディアを実証したいと考えています。

お友達紹介

コモ:それではお友達紹介のお時間になりましたので、お友達をご紹介いただけると。

岡田:Keeponなどを手がけられた、現在は東北大学にいらっしゃる小嶋秀樹先生をご紹介します。

コモ:ありがとうございます。小嶋先生に伝言はありますか?

岡田:伝言ということでもないですが、小嶋先生はロボット研究者・開発者としてピカイチなのはもちろんですが、最近は教育分野や療育分野に注力されているようなので、その辺のお話も伺えれば良いかと思います。

コモ:はい、今日はありがとうございましたー。