画像生成AIを初めて触った感想記録

【私の基本スタンス】

画像生成AIを使用する上での私のスタンスは下記の通りです。

・基本的に現在の仕事(ゲーム業界)で必要な知識を蓄えるための個人研究目的として使用する

・自分が著作権または使用許諾を持っていないイラストは食わせない(img2img、LoRA等に使用しない)

・使用許諾を持っている場合も予め著作者に了承を得た上で使用する

・使用モデルや一般公開LoRA等は確認できる範囲で明らかな他者の権利侵害がないか確認した上で使用する

・たまに(50%くらい)エッチな目的で使用する

権利関係は当たり前のことと思いますが一応記載しておきます。

【はじめに】

AIについての議論や著作権問題など一応認識した上で、私個人が2024年3月現在で抱いた所感を文章化して記録しておこうと思って書いたnoteです。

私はゲーム業界でフリーランスのディレクター(?)として働いているのですが、現場ではAIを活かす動きが活発になってきており、さすがに触れないわけにもいかなくなってきましたので、その備忘録的な内容になります。

これを元に何か議論するとか世の中に物申すとかしたいわけでは一切ないのであしからず……ここはチラ裏、私が神の世界。

あとPixAIを使って出力した画像なども載せるので見たくない方はブラウザバック(いにしえのことば)

AI生成物の投稿用Twitter(X)アカウントも作りました。

フォロワー全然いないので良かったらフォローしてね。

◆これまでの私の画像生成AIに対する印象

これまで私は、画像生成AIにはあまり触れないようにしてきました。

それは、色々な問題を孕む発展途上の技術で、私が尊敬するイラストレーターのみなさん(特定のではなく、絵を生業にしている人全員という意図)が抱いている印象も本当に賛否両論。

技術ツールとして捉えている人もいれば、権利侵害を強く懸念されている声もまた強く、下手に触れればめちゃくちゃ嫌われそうという恐怖もありました。

話題に触れたことがあるだけで、例えば好きな絵師さんにSkebを依頼しても受けてもらえないんじゃないかとか、ブロックされるのではとか、そういう恐怖感もありました。

ただ、当然、私は自分では絵が描けないわけですが、見ることは本当に好きで、絵に対して本当にたくさんお金を使ってきました。

それが、自分でも生成できるかもしれないという技術を見て、興味がわかないはずもなく……

とはいえおそらく、触り始めたら投稿したくなるのは目に見えていました。

そして前述の理由からも、結局は考えることから逃げて、ほぼ「触れない」を通してきました。

◆状況がかなり変わってきた

Midjourneyなどが有名になってきたのが数年前?でしたっけ?

それから爆速で技術発展し、もう2~3年?経ちましたね。

まず、直近だと文化庁のパブコメ回答が話題を集めたり、省庁が積極的に取り組んでいることをTwitterで流れてきて知り、国としても本格的にこのまま整備をせずに放置はできないと思っているような印象を受けたこと。

革新的な技術において、圧倒的に海外が進んでいる(と勝手に思っている)今では、少なくとも置いていかれるわけにはいかないという視点。

ネットで国の境界などないに等しい現代で、知識や法整備が追いつけなければ競争力もどんどん落ちます(特に仕事効率化の面で)。

競争力が落ちれば外貨も獲得できなくなり、JPYはどんどん紙クズになり、国力が落ち、いずれはブリタニアに支配されるエリア11になるのは目に見えています。日本人と名乗ることさえ許されなくなる。しらんけど。

dアニメストアはこちら

同時に、イラスト生成AIにおいては、特に著作権に関する深い理解が必要であることと、アニメーターやイラストレーター、漫画家など絵を生業とする方たちは努力によって絵の技術を身につけてこられたところに対しリスペクトを忘れず、かつ権利的に正しく守られなければならないという視点。

これらによって国としての見解がある程度見えてきて、ひとまず恐れずに少しずつ「ツールとして」触れる環境になってはきたのかな、と思いました。

とはいえ、使うツールがどういった過程で学習しており、それが文化庁の出した見解などと当てはめて権利的に良いのか悪いのかは現状自己判断するしかないので、まずAIの仕組み自体への理解も必要になってきます。

◆AIでイラスト生成ってどういう仕組みなん?

大規模言語モデル、イラスト生成AI自体の仕組みについてより理解を深めなければならないと思いました。

とはいえ、自分で調べたり、他の方がまとめてくださった資料を拝見したりしても、マジでわからん。

その中身は本当に学術的すぎる領域で、Fランクソゴミ大学情報学部卒の私などでは到底追いつけない内容です。

ただ、ふんわりとわかったのは、学習というのは絵を直接保持しているわけではなく、絵と文章を関連付けた「傾向」の情報を蓄積していって、なんの意味も持たないノイズデータから、入力された文字(プロンプト)によってノイズの点1つ1つを調整していき、最終的に人間が「イラストだ」と認識できるような画像データを出力している、というのがわかりました。

間違ってたらすまん。こ。

◆なんとなくイメージする、AIが絵を生成する流れ

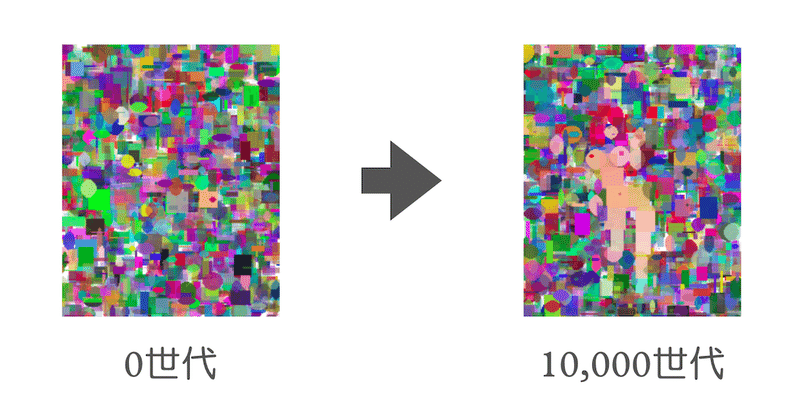

以前にこういう実験もありましたね。

「遺伝的アルゴリズムで最高にエッチな画像を作ろう!」というやつ。

2つのノイズを見比べて人間が「こっちがエッチ!」と言った内容を積み重ねていくことでだんだんそのノイズが動いていき、最終的に人間の裸体ようなものが生み出されたというもの。

厳密には大規模言語モデルにも様々な手法があるみたいで、これとはまた違うとは思います。

が、何もワカランAI初心者の自分からすると、こういう感じで人間が判断してたところをAIが深層学習を経て得た傾向を元に、人間では不可能な試行(思考)回数を経て絵を「生成」している、という理解で一旦は良いのかなと思っています。

つまりベースとなっているのは「なんの意味も持たないノイズ画像」と「学習した傾向データ」で、少なくともネットからイラストを集めてきて切り貼りしてフォトショで調整したみたいな、いわゆるコラ画像を作るような過程とは全く異なる、という理解はできました。

これを考慮すると、では学習の過程で無差別にイラストを使用するというのは、人間が絵を描くために他の人の絵をたくさん模写したりするのと類似した考え方で、学習段階で無差別にやるなら逆に問題がないような気がしてきました。個人的には。

ただ、調べてみると、学習段階で利用するデータセット自体が複製にあたるなど、学習段階でも著作権に違反しているという見方もありました。

それから、特定のイラストレーターやIPのテイストに寄せるために、意図的に学習傾向なりを調整して、似せた絵を出力するモデルも存在します。

それも実際のところ人間が模写して学ぶのと変わらないんじゃないか、とは思うんですが、ここは明確にマズイと思う部分が私にもあります。

それは文化庁の見解と同じかもですが、過程がどうあろうが(人間が描いたのかAIで出力したのか問わず)、著作者の権利を脅かす形で「利用/使用される」ところがマズイと思ってます。

そしてこういうモデルは、明確にそういう利用用途を目指して作られているのは明白です。

最初は個人利用のつもりでも、ネットに公開した時点でもう個人利用では済まない、というか公開した時点で個人利用ではない。

私が昔やっていた、ゲーム内でのチャット投稿などの監視・違反の削除対応なんかも、ユーザーの行動やチャットテキストがポリシーに違反するかどうかは、判断基準として「悪意をもってやっているかどうか」もかなり重要視するんですけど、その視点から見ても明確にアウト、と思います。

◆学習データはぶっちゃけもうわからない……

とはいえ、もう今は学習データの元を辿るのは不可能なんじゃないかと思います。

最初は当然、人間の書いたイラストと文字情報から学習していたとは思いますが、出力結果をちゃんとイラストとして認識できる精度にするにはちょっとやそっとのデータじゃ無理です。

そうなると、必然的にネット上にある画像と文字情報を無差別に収集するなどで学習データを構成せざるを得ないと思いますが、それにより生成されたAI画像が今はネット上にさらに溢れているような状況です。

要は、莫大な量のイラストから学習して画像をAI生成し、その画像を含めてさらに学習データに使用して……みたいな繰り返しになってきている印象です。

やはりネットに一度放たれたものはどうやっても回収しきれなくなる、というのは昔から変わらないですね。

更に別のAIサイトから持ってきている……?

そもそもAI生成サイトも大量にあってわけわからん……

◆私自身の仕事でもとうとう必要性が出てきた

この記事を書いている直接的な理由です。

私は10年弱くらいゲーム業界で働いてるわけですが、大きめな組織でのゲーム開発現場では既にAIについて有効利用に向けた試行錯誤や研究と法務見解が進んでおり、はっきり言って、AIについて知識をどんどん付けていかなければ置いていかれる状況になっています。

特に私のような、ディレクターとか統括するポジションだとより知識を付けておかなければいけない危機感を感じるレベルになりました。

極論、ゲーム開発においてAIを活かせない人材は価値が下がってくる。

プログラム領域でも、企画領域でも、CS領域でも、アート領域でも、まじでどの領域でもLLM=大規模言語モデル?とか、ChatGPTなど生成AI、画像生成AI周りなどしっかり知識をつける必要が出てきました。

これまでのように「危なそうなものには触らない」というスタンスではいられなくなる危機感が出ました。

◆とりあえず、触ろう

ちなみにChatGPT(無課金なので3.5)、Bardなどテキスト系のAIはこれまでにも触ってはいて、どうにか仕事の効率化やアイディア出しに使えないかやってみましたが、無課金のは平然と嘘をつくので正直私の仕事で直接役に立ちそうなことはありませんでした。

強いて言うなら翻訳くらい?翻訳もLQAができないんで結局わかんないからGPTで生成した英文をもっかいGoogle翻訳・DeepL・papagoなんかで再翻訳かけて合ってるかチェックするとかしないと安心できない。

じゃあ最初からDeepLでよくね?説はあります。

課金したら違うのか?この辺はそのうちまた試します。

実際にこれまで触ったことがなく、これから触っていくのは画像生成AIです。

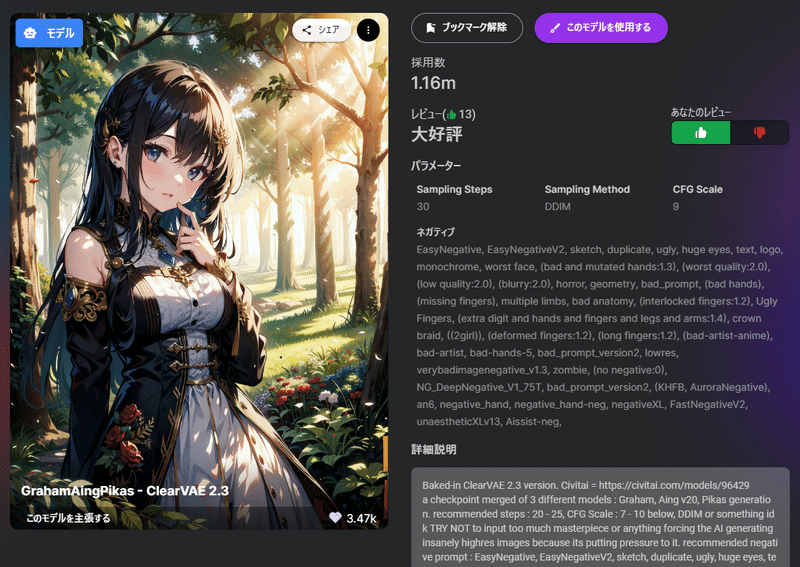

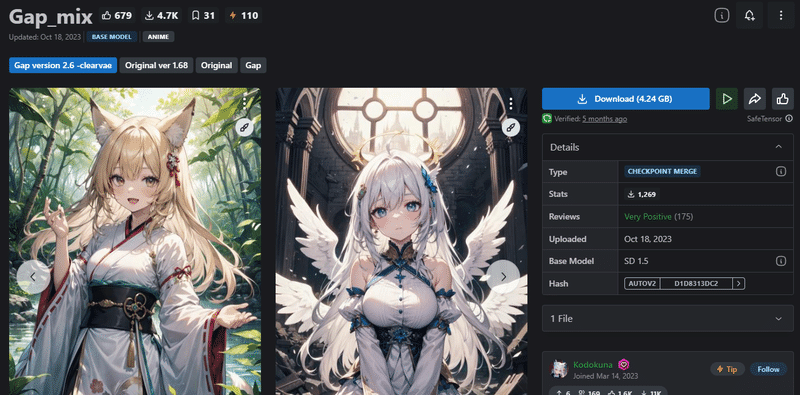

二大巨頭であるStable DiffusionとMidjourneyですが、なんとなくハードルを感じていて気軽に試そうと思えなかったので、いくつかWEBサービスで無料で気軽に試せそうなものから、PixAIというのを選びました。

◆試すことにしたPixAIについて

▼料金体系

PixAIは基本無料で、毎日ログインボーナスのような形で「クレジット」が10,000~20,000程度付与されます。

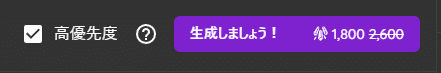

このクレジットを使用して画像生成するのですが、使用するモデルや解像度、サンプリングステップ(繰り返すほどクオリティが上がる)の数、それから生成優先度(画像が出来上がるまでの待ち時間を短縮するかどうか)によって必要なクレジットが変化します。

ただ、高優先度はほぼ1分以内にできるのに対しこちらは場合により数分~数十分かかることも

解像度も基本は512x512、768x512など低解像度で上記のようなクレジット数なので、1024x1024やそれ以上のような解像度にすると倍々で使用クレジットが増えます。

私は今回、画像生成AIというのがどういうものか学ぶ目的だったので、解像度は低くて問題ありませんでした。

できるだけ多く試せるように、優先度も適宜下げたり、ステップ数を下げたりして、基本的には1回あたり1,000クレジット前後で試行しています。

ただ、他の投稿者の出力画像を見ていると、解像度やステップ数をクレジット気にせず上げた場合の出力結果は結構世界が変わるような印象を受けているので、後々試してみたいと思っています。

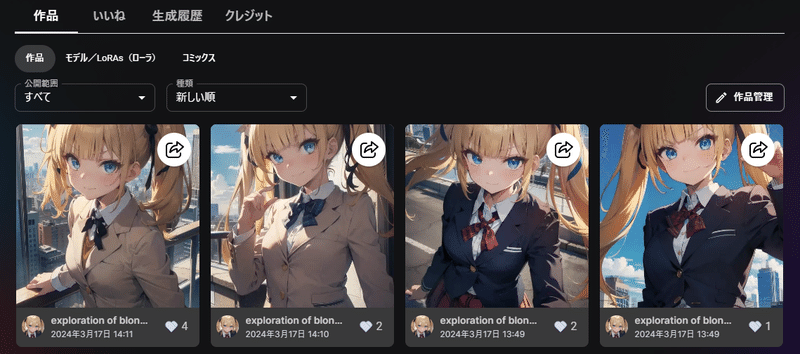

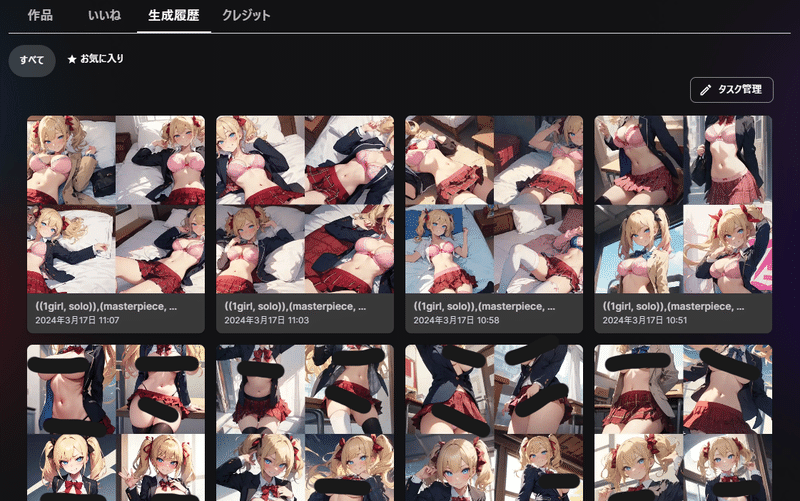

▼PixAIで生成したものの公開方法

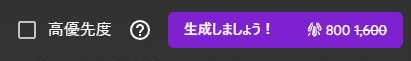

PixAIは、生成したものはまず自分の「生成履歴」としてストックされます。

この時点ではまだ公開等されていないと思います。

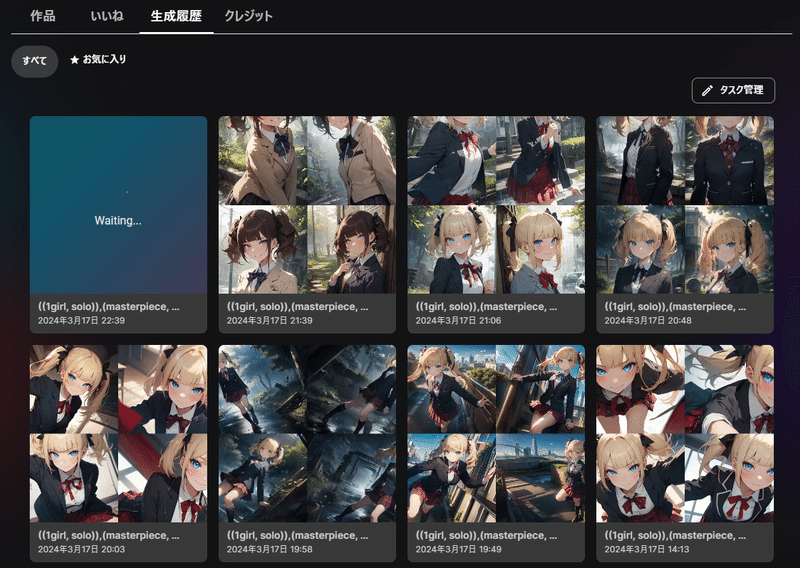

当時の選択モデルやプロンプトが出るので

それをベースに別の画像を生成をすることも容易

この生成したものから、PixAI内で他の人に公開する設定などができます。

公開することで1日に10回まで、1,000クレジットがもらえます。

生成物の公開を促進するシステムになっていますね。

タイトルを付けたり、プロンプトの公開可否も選択可能

他の人が公開したプロンプトを参考にすることも多い

公開1回ごとに1,000クレジット(10回まで)

公開したものに「いいね」が付くと100クレジット(20回まで)

それ以上はPixAI会員=月額課金になっている

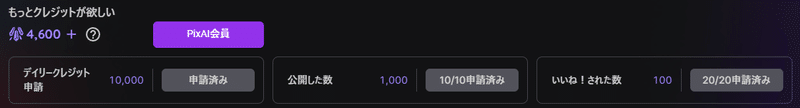

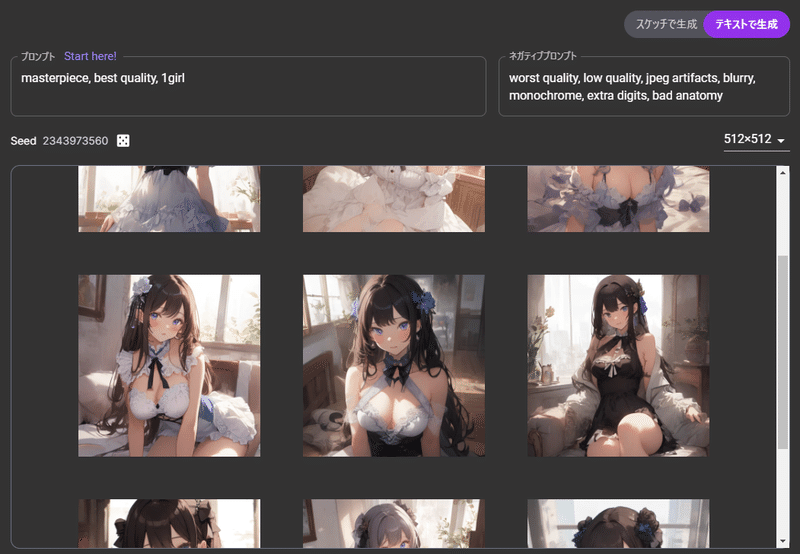

◆プロンプト遊び

プロンプトとは、テキストによりどんな画像を生成するか指示するものです。

前述した学習データを元に、プロンプトから逆算してノイズからイラストと呼べるものまで処理するための手がかりのようなものだと思います。

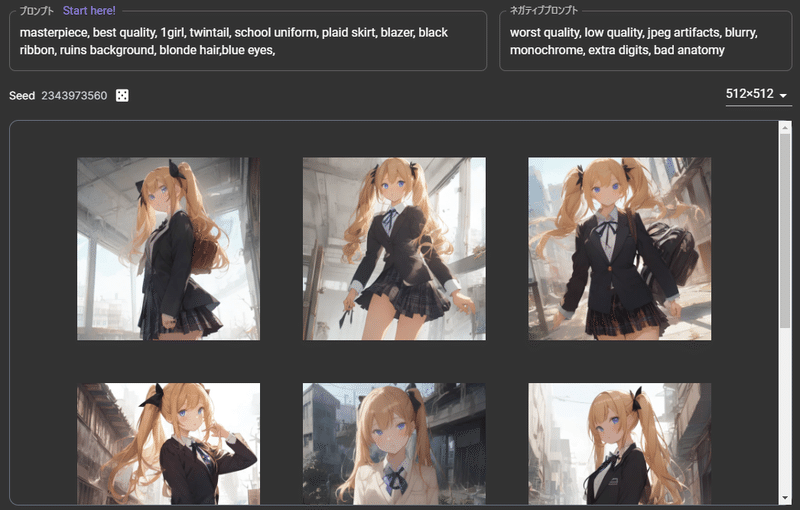

具体的には「女の子が一人いるイラストで」「髪型をツインテールにしたい」「髪色は金髪で」「目は青で」みたいな指示を、

1girl, twintails, blonde hair, blue eyes,

というようにプロンプト入力画面に入れます。

そうすると、それに傾向を寄せたイラストが出てきます。

PixAIデフォルトモデルのおかげでシンプルでも全然形にはなる

しかしこれだけだと、服装や背景などもバラつきが出ます。

なので、自分の作りたい内容に寄ってくるようにプロンプトを追加していきます。

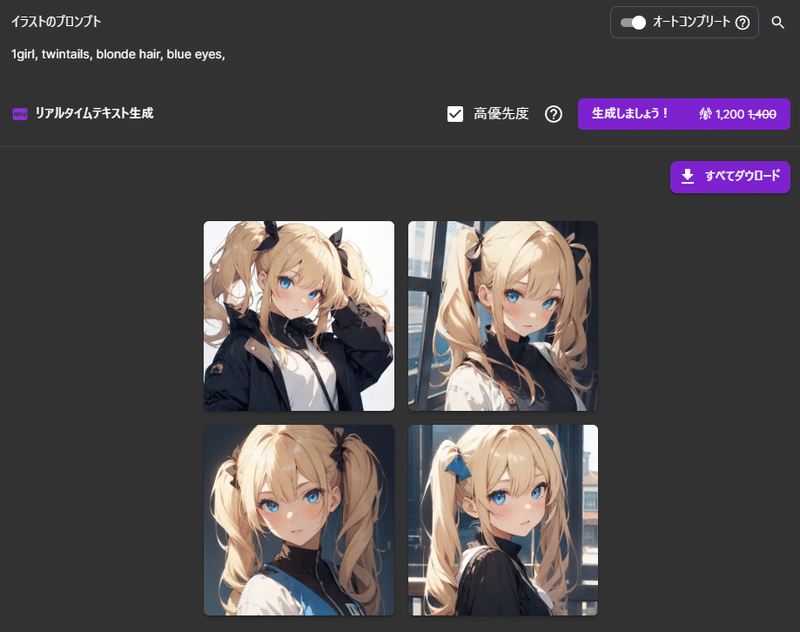

masterpiece:出力結果のクオリティを底上げする呪文のようなもの

evil eyes:小悪魔的な目(目の形の指示)

smile:笑顔(表情の指示)

school uniform:制服(服装の指示)

upper body:上半身メイン(構図やアングルの指示)

ruins:廃墟(背景の指示)

他にもプロンプトは様々な内容があるので、他の方のプロンプトも参考にしたりしながらどんどん追加していきます。

プロンプトは全てが忠実に守られるわけではなく、AIが勝手にブレンドする度合いを調整します。

その度合いについても、ある程度は調整ができます。

( )で囲むとそのプロンプトの重要度を上げるなど、これも様々な記述方法があるようです。

これがかなり面白い部分で、プロンプトを変えなくても様々な絵が出力される上、少し変えれば出力結果もかなり変わってきます。

その試行錯誤というか、要は何が出てくるかわからないガチャ的な面白さがあるんですね。

自分が求めていたものに近付けはそれはそれで面白いですし、全く予想しなかったものが出てきたりする点もまた面白いです。

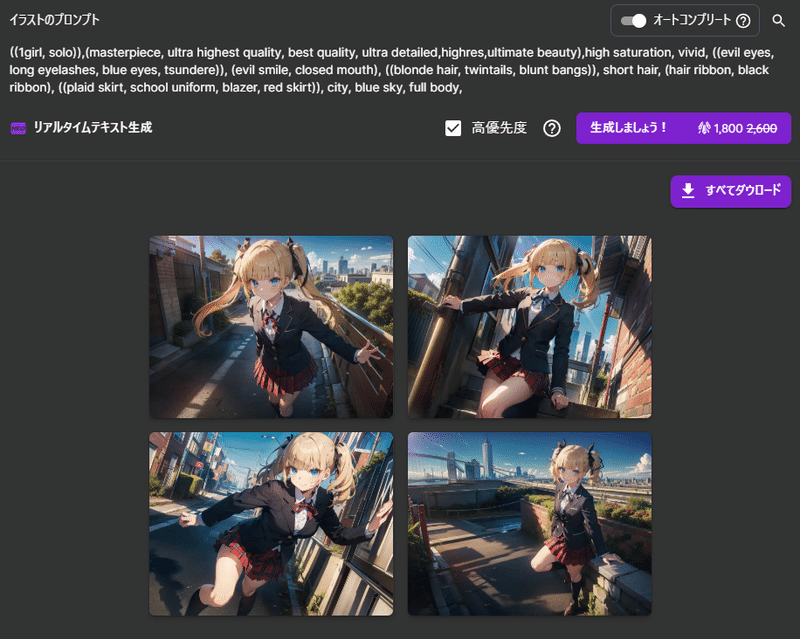

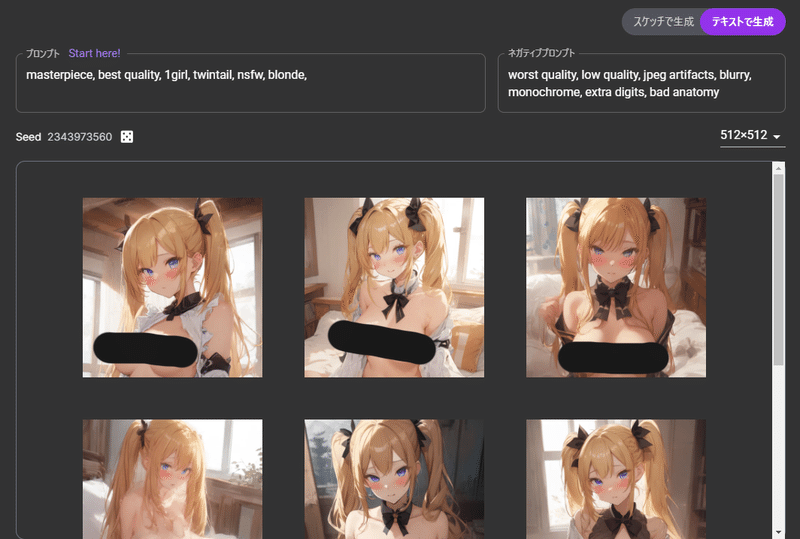

◆PixAIにある「リアルタイム」生成機能

ここまでに書いてきた通り、基本的にPixAIでの生成にはクレジットを消費しますが、リアルタイム生成では、プロンプトを入力するたびにほぼ即時に画像が9枚生成されます。

さらに同じプロンプトでも、Seed値の横のダイスアイコンをクリックすると恐らくベースになるノイズが変わるので、それだけで画像も変わってきます。

クレジットを消費せずにいくらでも試せるので、今回の目的である「イラスト生成AIを知る」という点ではかなり良い機能です。

ただ、リアルタイム生成ではモデルの選択などはできないので、あくまでプロンプトの軽いテストであったり、無料でガチャを楽しむような即興的な快楽が得られるのみです。

しばらく触って感じたのは、リアルタイム生成で調整したプロンプトを使っても、実際クレジットを消費してモデル選択してから出力する内容は大きく異なるので、プロンプトのテストには使えないなというのが最終的な感想でした。

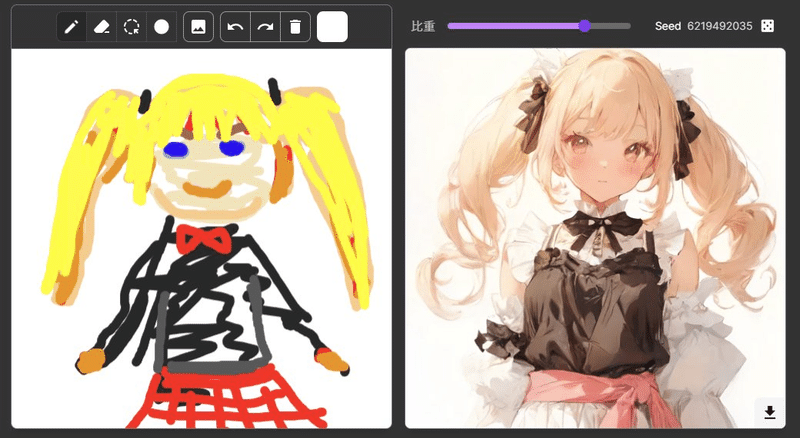

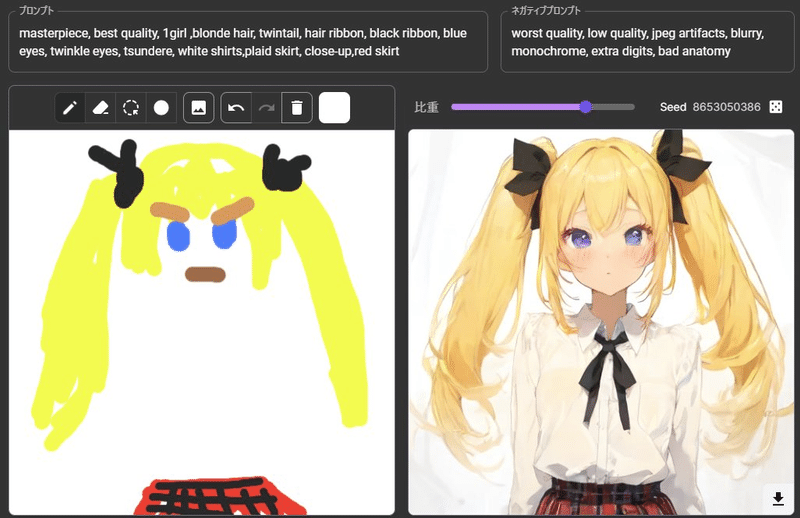

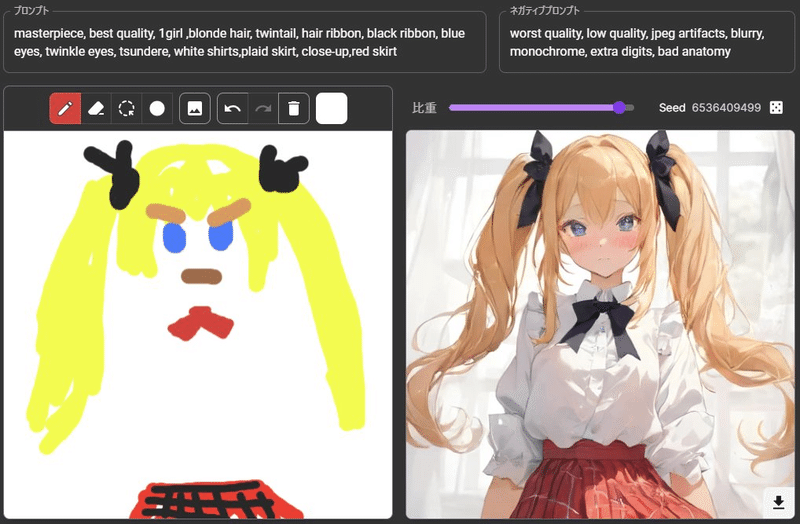

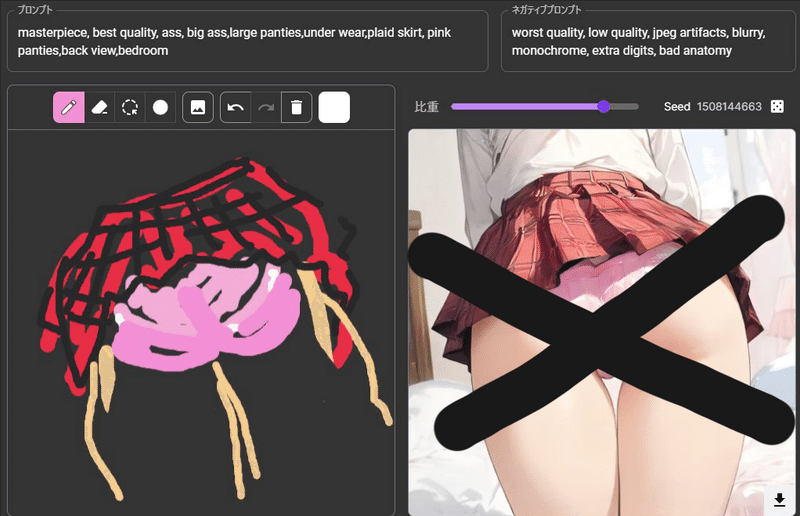

◆スケッチ(手描き)をベースにした生成

リアルタイム生成には、スケッチを元に生成する機能もありました。

これも、左の手描きにどのくらい寄せるかというのをシークバーで調整することができます。

さらにプロンプトでも指定をすることで、より自分のイメージに近付けることが可能になっていました。

これはプロンプトだけだと生成しづらい内容を作るのにかなり有効でしたが、予想外の結果を楽しむガチャ的な要素はないので、自分の頭の中にある程度欲しい内容が出来上がっている必要があります。

(みせられないよ!!)

◆余談:リアルタイムすけべイラスト生成による寝不足

ここまで来ると、オトコノコであれば当然入力したくなる、すけべワード。

nsfw, boob, ass, nipples

など入力すると、すーぐえっちな絵が出力される。

ここからはもうご想像通りですね。

オトコノコであればやることは決まっています。

思いつくままに入力し、一瞬で生成される9枚。

右手でキーボードとマウス。

左手は我が分身に。

それはそれは時間が溶けるのでございます。

(直接的な部分は後から黒塗りしていますが実画面では見えてます)

こうなると普通の生成でもすけべイラストを試したくなるというもの。

しかも心が逸っている状況です。

普段は我慢している生成待ち時間も我慢できません。

高優先度設定にして、クレジットをバカみたいに消費するわけです。

なおPixAIでえっちな絵を公開するのは規約違反みたいですが、どこまでがOKでどこからがNGなのかはいまいち掴みきれないところはあります。

一応コンテンツ規則というところで規定はされていますね。

◆実際ゲーム制作現場ではどう使うのか?

すけべに気を取られましたが、本来の目的に戻りましょう。

私が仕事上、まず触ってみて知識を得るという部分については、ある程度わかってきました。

あとはStable Diffusionなど自分のマシンを使うものなどを試したり、権利周りの知識を付けていくところかなと思っています。

実際触ってみて、プロンプトを頑張ればそれなりの出力結果を得られることはわかりましたが、やはりこの程度のプロンプトやモデル指定などでは、手だったり背景だったり服だったりかなりグチャることも多く、直接的に使用するのは難しい結論でした。

費用対効果の面で、プロンプトを必死に頑張ってもかなり試行回数を重ねないといけない上、出力にも費用がかかるので、利用するにしてもアイディア出しなどに適度に使用しながら、実際ゲームに直接使用するリソースはそれをトレース・レタッチした上で使ったり、別途イチから描き下ろす際の参考資料として利用するのが現実的です。少なくとも2024年3月現在は。

ただ、ゲーム内でも重要度の低い部分であれば、ぼかしや微調整して直接使用することも可能かもしれませんね。

このあたり、政府が実施した「AI時代の知的財産権検討会」で紹介されたレベルファイブの使用事例もかなり参考になります。

レベルファイブの提出したPDF資料も見れるのでゲーム業界の人間は要チェックです。

◆まとめ

画像生成AIについて、直接的に使用できるような画像を出力するためにはまだ手間がかかる上、権利的な問題もクリアにはなりきっていません。

そのため、ゲーム現場での用途としては主にアイディア出しに使ったりするのが2024年3月時点での現実的なところという認識です。

とはいえ、内部的にAIを活用するだけでも効率が相当に変わってくるのが事実で、その点でAIに対し知識を付けていくのはやはり必須になってくるでしょう。

今回の調査をとっかかりに、また色々調べていきたいと思います。

しかし、こんな技術にアラサーアラフォーくらいの年齢になってから触れられたことは逆に良かったような気もします。

今でこそイラストレーターの苦労だったり、様々な労力を知ったうえで触れているので慎重にもなれますが、これを中学生とかで触っていたらと思うと恐ろしいです。

恐らく絵に対する倫理観がぶっ壊れていたと思います。

一昔前に巷で騒ぎになっていた「AI絵師」名乗りであったり、私から見たら支離滅裂な主張など、その人が低年齢であったりクリエイティブな仕事と縁がなく想像が一切できないような方だと思えばある程度納得がいきます。

逆に、恐れずこういったツールを正しく上手く使い、今まででは想像できなかったものを生み出す人も出てくるかもしれません。

完全に今は混沌期、ビビリの私は陰から様子を見ることしかできそうにありません……

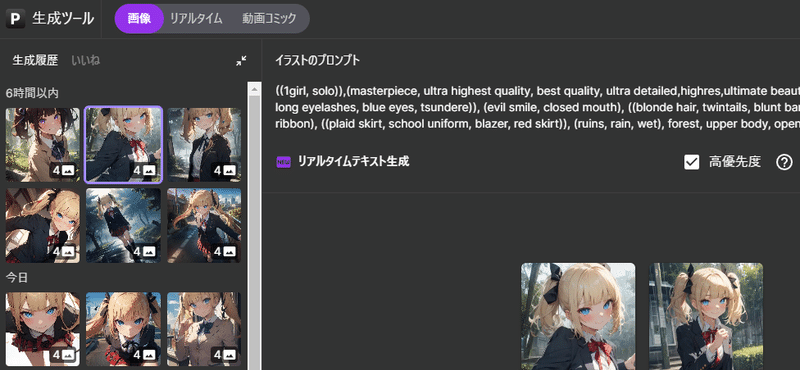

◆おまけ(生成画像たち)

好みの金髪ツインテールをわんさか生成していますが、顔アップにすると、よりディテールも細かくいい顔になりますね。

以下、比較的良い感じに出た顔アップ。

まつ毛バッシバシのツリ目青目の生意気金髪ツインテールが本当に好きなんだなとつくづく自覚する日々。

最近のマイブームは廃墟に雨

ブレザー制服の他に軍服っぽいものとかメイドなんかも作ってみると面白い

けど結局最後には青目ツリ目金髪ツインテールプリーツスカート制服ガールに戻るんですよね。

PixAIの私のアカウントページは下記です

おわり

この記事が気に入ったらサポートをしてみませんか?