2023年5月の記事一覧

今一番賢いオープンソースLLMのFalcon-40Bを試す

LLM Leaderboardというランキングで、初登場一位になったFalconを試します。

ちなみに動作には、A100 40GBが必要でした(V100 32GBはメモリオーバーで動作せず)。

40Bだからまあでかいわな。

ちなみにFalcon-7Bもある模様

とりあえずサンプルコードの出力をそのまま貼ります

入力として与える文章は下記のもの

Result: Girafatron is o

RedPajama-INCITE-7BをLoRAファインチューニングでハイパラ探索した結果

7Bのハイパラ探索をしてみたので結果を共有します。

ABCIを使用。エポックは全て6。rとalphaを変えただけの探索です

感想

以下、長い出力が続くので先に感想を書いておきます。

LoRAにおいて、rは次元数、alphaはスケーリングファクタということになっています。rが多いほどエポックが沢山必要になりそうな気がします(6エポックに対してr32は力不足か?)。スケーリングファクタも、デカすぎ

RedPajama-INCITE-BaseのLoRAファインチューニングでハイパラ探索した

の続き

日本語化したAlpaca_cleanedデータセットでRedPajama-INCITE-Base-3Bをいろんなハイパーパラメータでファインチューニングした結果です。

結論から言うとほとんどうまくいってません。

んで、元のコードをよく読むと、7B-v0.1しか対応してないということだったのでやり直します。

モデルの命名規則

lacj-3b-e<エポック数>-r<rの数>a<alphaの数

RedPajama-INCITE-BaseにAlpacaJaのLoRAファインチューニングでハイパラ探索する

AI研究とは農業だ!

エリート様がやらないなら自分でやるしかねえ!

ABCI、俺に力を貸してくれ!

というわけで、ABCIを使ってRedPajama-INCITE-Base3DにAlpaca-Cleaned-Japaneseをファインチューニングしながら、LoRAのハイパラ探索をしてみます。

そもそもLoRAのハイパラとは、lora_rとlora_alphaが代表的である。

`r`, th

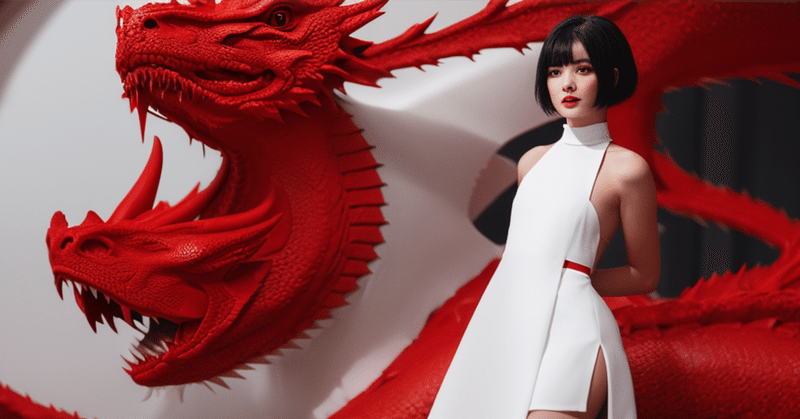

ファインチューニングなしで好きな画像が出せるFastComposer

8時間前、MITのハン研究室からFastComposerが発表された。

一枚だけ画像を用意するだけで特定の人物を登場させたり、複数人数を出すこともできる。

めちゃめちゃ簡単な上、めちゃめちゃ処理が速く、めちゃめちゃ面白いのでMemeplexにも入れようか考え中。

GPUある人は↓から

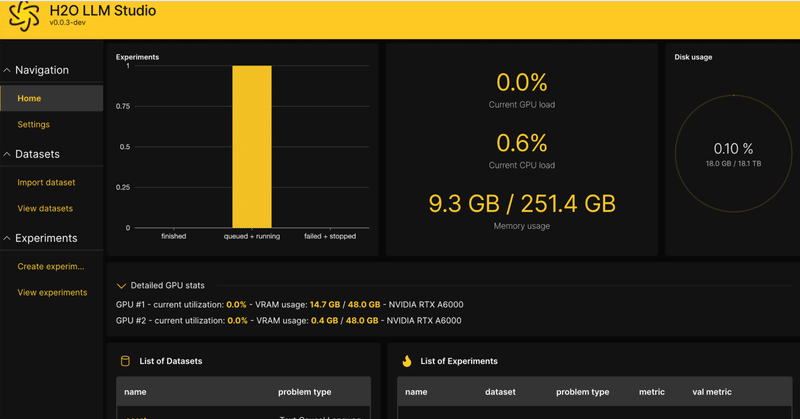

H20 LLM Studioを試す

H2O LLM Studioというのが、要するにLLM版Automatic1111みたいな、要はWebUIとして最高でございますという話だったので使ってみた。

インストールは超簡単。

ただ、CSV形式じゃないと学習データに使えないっぽいのでそこの使い勝手があまり良くないかな。最近の流行はJSONL形式だしね

あと、仕方ないのかもしれないが設定できる項目が多すぎて目が回りそうになる。

まあで

rinnaの30億パラメータ日本語会話モデルを試す

rinnaから日本語会話モデルがリリースされていたので試した。

import torch from transformers import AutoTokenizer, AutoModelForCausalLMtokenizer = AutoTokenizer.from_pretrained("rinna/japanese-gpt-neox-3.6b-instruction-sft", use_

何かと不便だったのでAlpaca_cleaned_ja.jsonをhuggingfaceに移す

ファインチューニングをいろいろ試すのに何かとgithubでは不便だったのでhuggingfaceに移しました。

これで簡単にファインチューニングできるか試すことができます。

https://huggingface.co/datasets/shi3z/alpaca_cleaned_ja_json