米国エネルギー省がAI導入を推進するために取り組んでいたこと

※このインタビューは2024年2月5日に収録されました

政府組織でもAIを利用した新しい取り組みが広がりつつあります。

今回は米国政府で広く要職に就き、AI関連の取り組みの推進にも尽力されたパメラさんに、米国政府のAI推進についての取り組みとガバナンスの重要性についてお伺いしました。

前回の記事より

ここからは具体的にどういった取り組みを米国エネルギー省で実施していたのか教えて頂けますか?

米国エネルギー省がAI導入を推進するために取り組んでいたこと

Pamela: 私がエネルギー省で仕事をしていた際に重要だと考えていたのは組織のガバナンスであり、私が倫理的なガバナンスと呼んでいる仕組みの必要性です。倫理的なガバナンスとは、私たちがアルゴリズムを導入したシステムを利用する際に検討すべき重要なテーマであり、AIを採用する前の分析がより重要になっていきます。

(動画:The Science of Data: Tackling Challenges, Informing Society w/Pamela Isom, Deputy CIO, U.S. DOE)

AIを導入する過程において私たちの権利を侵害したり、差別等を助長するような害をもたらすものになっていないかを十分に検討することが大切です。

AIに関する発展した会議体では、我々がAIを運営するためのガバナンスの設計に取り組んでいました。会議に参加する様々なステークホルダーの方々から、異なった視点でのフィードバックを頂きつつ、足りない視点を補うような活動を推進していました。

こういった取り組みを続けていくことによって、プライバシーとは何か、プライバシー侵害がAI時代にどのように引き起こされるのかを理解するように心がけていました。

そういった活動を通して、教育やトレーニングプログラムを提供したり、会議での議論を通して戦略的にAIを利用するための安全性やマナーについての議論を広く深めていきました。特にサプライチェーンやベンダー管理については、米国政府でも適切に実施できているのか広く議論することが多かったですね。

私が現在独立して取り組んでいるようなコーチングや組織を率いるための活動を当時も行っていたのですが、米国政府ではディレクターの立場でガバナンス設計に携わっていました。

政府がシステムを導入して、活動を推進するためのサプライチェーンとベンダー管理が主な業務でした。AIを採用する際にも、現状のシステム運用で改善点の有無やAIに関連する規制動向について問いかけるようにしていました。

AIに関する発展した会議体は独立した会議体や特定の人だけが参加するものではなく、会議で得た知見を広く普及させるための活動として運用したいと考えていました。

そういった背景もあり、各部門のトップの方々に会議への参加をお願いし、会議体で共有した知見を各部門に持って帰ってもらうようにしていました。こういった場を設けることによって、どういったチームで運用していくべきなのか、優先的な取り組みは一体何か、そして組織が提供する個人向けのプログラムはどういったものが良いか等の議題について話を進めていくことができました。

私たちが主に取り組んでいたのはここまで紹介した内容になります。こういった場を作る活動に加えて、会議の中で倫理的なガイドラインの標準化を進めたり、AIを導入する際の実践基準やケースを整理したりもしていました。AI戦略についても、各部門と連携しながら議論を進めていく役割を担っていました。

Kohei: 会議の場を通して、AIを導入する際の重要な議論がなされていたんですね。少し深掘りしてお伺いしてみたいのですが、エネルギー省で働かれてみて大変だったことについても聞いてみたいです。各部門から会議に参加することで、設計するプログラムを進めていく際のコミュニケーションや連携が非常に難しかったのではないかと想像します。

ぜひ政府内での取り組みを推進する際に難しかったと思うことがあれば共有をお願い致します。

政府組織でAI導入をリードするための課題と壁

Pamela: 既に米国政府の立場を離れているので全ての課題について話をすることは難しいですが、私が所属してきた組織内での経験をお伝えしましょう。

どの組織も自立的に仕組みの運用ができることが好ましいと思うのですがこれは非常に難しいことです。私は米国政府で働く前に民間企業でキャリアを始めたのですが、官民関係なく組織ごとに分断されてしまっている問題に直面するケースが良くありました。

各部門ごとに考え方が異なるのです。エネルギー省一つとってみても部門ごとに考え方や取り組み内容が異なるため、それぞれが協力してことを進めていくためにはお互いに繋がって連携する必要が出てきます。

部門間の連携に関する問題は経済的な側面からも解決策の検討を進めていくことが必要で、各部門が実施している研究成果をより高めていくためにも重要な要素の一つになります。

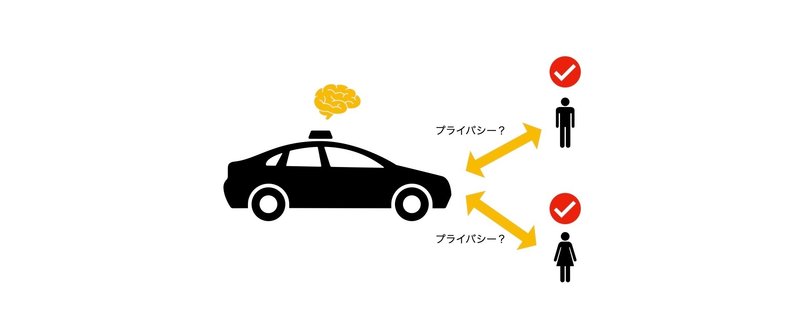

今の社会では全く新しい分野のテクノロジーに触れる機会が多いと思います。電気自動車のプライバシーに関する問題は際たる例の一つで、自動車が取得する情報についての取り扱いは非常に大きな問題になっています。

組織内の特定部門が理解を深めるだけでなく、組織全体が自分ごととして取り組んでいくことが重要です。ことプライバシーについては、情報を適切に保護するためにも広く包括的な解決策を検討することが必要です。

また、プライバシーについての議論を深めていく際にはサイバーセキュリティチームのような異なったステークホルダーの方々にも参加頂きながら情報保護とのバランスについても取り組む必要があります。

こういった経験から組織ごとに情報の非対称性が生まれてしまう考え方に対して、戦略的に情報共有を行うような仕組みを解決策として持っておくことが大切だと考えています。情報を共有することの積み重ねがより大きな形になっていくので、組織間での積極的な情報共有を推進していくことが難しかったポイントですね。

Kohei: 異なる部門で透明性を持った情報共有の場作りが非常に重要であるということについては、とても同意します。考え方が違う人たちが一緒になって活動するためには、強力な推進力が求められますね。では次の質問に移りたいと思います。

ここからは信頼できるAIについて、パメラさんが寄稿されていた記事から深掘りしていきたいと思います。信頼できるAIと公正性は非常に重要な観点であると私も感じています。では、実際に信頼できるAIを実現していくためにどのようなアプローチが求められ、プライバシーの観点からはどういった取り組みが有効になるのでしょうか?

信頼できるAIとプライバシーの交わりと全体デザイン

Pamela: わかりました。私が寄稿に関わった記事の内容は現代社会でも参考になるかと思います。記事を寄稿する際には、AIをどのように捉えるべきかをライフサイクルの観点から取りまとめ、AIに紐づいた業務がこれまでのサプライチェーンにおけるリスクマネジメントやサイバーセキュリティ上でのリスク管理とどう連携していくのかを整理しました。

私が説明したライフサイクルという言葉は、即ち信頼できるAIの本質的な要素になると考えています。

信頼できるAIの構築のためにまずやるべきことは、対象となるサプライチェーンとは一体何かを理解することです。具体的な例を出すと、AIモデル、データ、サイバーセキュリティの構成要素がどのソースをもとに設計されているのかということです。

サプライチェーン全体を理解した後に、データ取得の話に移ります。どういった手法を用いてデータを取得するのか。対象のデータは組織内のデータに限られるのか。対象のデータはLLM(大規模言語モデル)に利用するのか。利用する際は内部に限定するのか。

これまでのクラウドモデルと連携したものであるのか。クラウドについても単一クラウドなのか、それともハイブリッドモデルなのか。こういった質問を広く考えていくことが求められます。

今では大規模言語モデルか、小規模の言語モデルかで対象が異なってくるかと思います。さらに大規模言語モデルにしてもハイブリッドか、プライバシーかパブリックであるのか。等の関連した問いが色々と出てきます。

データをAIに読ませる工程について検討するだけで、パッとここに紹介したような問題を考えていく必要があります。なぜこういった問いかけを行う必要があるかというと、AIに読み込ませるデータは高解像度であることが大切だからです。

データは安全に処理されなければいけないので、データをAIに読み込ませようと考える際には、どのようにデータを取得するのかまで考えた上でデータの取り扱いを進めていく必要があります。

その後に全体のモデル開発とモデル展開の議論に移っていきます。実装に移る段階ではモデルそのものについて議論を行います。具体的にはどういった実装のフェーズに取り組んでいくべきかどうかという話ですね。まさにプライバシーバイデザインということです。私は公正なデザインとも呼んでいます。

このデザインの考え方を開発プロセスに取り入れることが必要です。どのようにモデルをテストするのか。どんな種類のアプローチがモデルを採用するためには必要なのか。

モデル開発を行うためには、どのような戦術が求められるのだろうか。そして、モデルを導入する際に必要な要素と、モデルを運用していく際に足枷となるものについても検討が必要です。全体の開発サイクルの中でモデルの確認と承認を行うために何度もテストを行い、試行錯誤することが必要です。

〈最後までご覧いただき、ありがとうございました。続きの後編は、次回お届けします。〉

データプライバシーに関するトレンドや今後の動きが気になる方は、Facebookで気軽にメッセージ頂ければお答えさせて頂きます!

プライバシーについて語るコミュニティを運営しています。

ご興味ある方はぜひご参加ください。

Interviewer, Translation and Edit 栗原宏平

Headline Image template author 山下夏姫

この記事が気に入ったらサポートをしてみませんか?