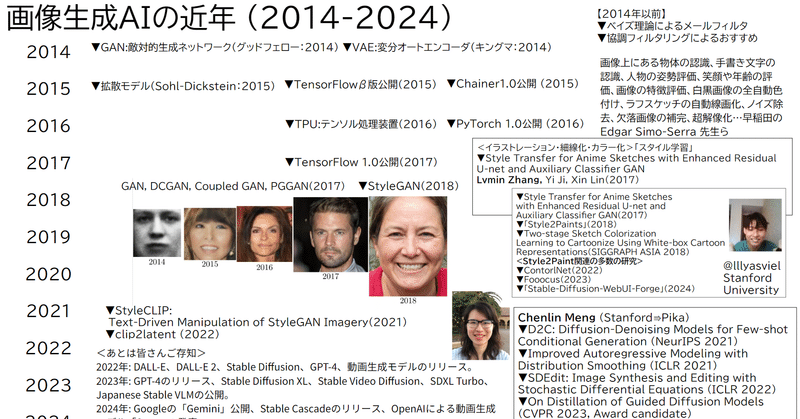

画像生成AIの誕生と変遷(4) 画像生成AIの2014-2024におきたパラダイムシフト

SD黄色本が好評でありがたいことです。

AI画像生成の歴史は、近年突然現れた技術ではなく、研究者とコンピュータによる画像つまりコンピュータグラフィックス(CG)の歴史とともにあります。まずは、大きなイベントや私たちの社会の変化を振り返ってその発展の流れを見てみましょう。ところどころに耳にしたことのある話題もあると思いますので、それらの知識と結び付けながら理解を深めて下さい。

1940年代に数学者や神経生理学者により人工ニューロンやセル・オートマトンといった生物を模倣する数学的モデルが提案されました。この時点ではまだこのモデルを計算するコンピュータはないため使われていたのはアナログ電子回路による計算機です。この頃の計算機としてのアプローチでは、画像を表示するためのディスプレイ技術も計算機(コンピューティング)技術の研究の一部でした。

1950年ごろになって、文字をプリンタに打ち出す技術と並列して、ブラウン管にドットやベクトルといった点や線を描画する技術に進化し、単純な図形やパターンの生成が可能になります。この技術が基盤となって、現代のTVやスマホのディスプレイにも使われている「ピクセル(画素)」があり、PNGファイルなどの画像ファイルにレッド/グリーン/ブルー(RGB)の輝度を保存することでインターネットや印刷物で画像をデータとして流通できるようになります。

【画像を構成するドット「ピクセル(pixel)」という言葉は、NASAのジェット推進研究所(JPL)の研究者が名付けました】

続く1950~1970年代は「第1次人工知能」の起こりの時代です。計算機による脳や神経の仕組み「人工ニューロン」のシミュレーションや、回路による実装が盛んに行われるようになります。中でも、大きなできごとは現在の機械学習のベースになる「パーセプトロン」を用いたパターン認識のシミュレーションが行われたことです。

また、このころには研究者が「人工知能」(Artificial Intelligence; AI)という言葉を定義します。さらにSF作家のアシモフによる「I, Robot」や手塚治虫による「鉄腕アトム」が発表され、世間一般にも人工知能という概念が広まっていきます。、研究者も映画「2001年宇宙の旅」を監修するような関係にありました。産業としてはトランジスタと集積回路の研究開発が盛んな時代で、テレビ放送が白黒からカラーになり、多様なディスプレイ装置が提案され、映像芸術やそのメディア技術も合わせて進化していきます。

1970年代になるとついにコンピュータがパーソナル化します。Xerox社「Alto」はグラフィカルなユーザインタフェース(GUI)とマウスを搭載し、その後のMacOSやWindowsのベースを作りました。街のゲームセンターにはタイトー「スペースインベーダー」が稼働し、家庭では「TVゲーム」としてブラウン管テレビと半導体が多様なグラフィックを描き始めます。

1980年代には Intel社が現在のCPUとほぼ同じ構造を持った第4世代コンピュータを開発し、これが爆発的に普及します。人工知能の研究ではロボットや画像処理、制御システムの専門家が中心に、ニューラルネットワークを発展させていき、多層パーセプトロン、誤差逆伝播法(バックプロパゲーション)が提案され、現在の深層学習(ディープラーニング)のベースが生まれます。産業面では「エキスパートシステム」という知識ベースのAIが「第2次人工知能」ブームを起こし、多額の投資が行われていました。文化面では映画「スターウォーズ」や「トロン」の公開、そして米国の映画業界に近い研究者が「Photoshop」を開発し、Adobe社がグラフィックス市場向けのアプリケーションツールとして販売を開始します。任天堂が「ファミリーコンピュータ」を発売し、ゲームグラフィックはコンテンツ、表現とともに大きな市場に成長しました。

1990年代はグラフィックスの研究と市場拡大が進んだ時代です。映画「ジュラシック・パーク」や「マトリックス」などCGをフル活用した大作映画の公開、MacやWindowsといったグラフィカルなOSの普及、そしてパソコンとソフトウェアツールの時代です。CLIP STUDIO PAINTの原型「RETAS」を東映アニメーションが採用し、スキャナやスタイラスペンをつかったデジタル作画がプロの中でも使われるようになります。また、1997年にIBMによるチェス専用のスーパーコンピューター「ディープブルー」がチェスの世界王者カスパロフ氏に勝利したことは、大きな注目を集めました。

さらに2000年代になると3DCGとインターネットの時代が到来します。PlayStation2の発売、GPUの普及などに並んで、ユーザがコンテンツを作る(UGC)サービスが一般化します。YouTube、ニコニコ動画、Pixivがサービス開始し、「初音ミク」や、3Dキャラクターモデルを踊らせる「MMD」(Miku Miku Dance)がリリースされます。続く2010年代はスマートフォンの普及拡大の時代です。驚くべきことに誰もが手元に1940年代とは比べ物にならない性能の計算機を持つようになります。そしてゲーム開発のためのUnityやUnreal Engineといったツールが大きく市場を拡大していき、ゲームグラフィックスをゼロからプログラミングにより開発することは限定的になってきました。

ゲーム技術は「遊びと美学に関する研究」としてまとめてきています。

https://note.com/o_ob/n/nc09e3aa98e5d

シラー以降も、スペンサー、そしてホイジンガ、カイヨワ、そして上述のミンスキーも遊びについての研究や考察を行っています。

このあたりと「令和のメタバース」との関連についてはこの論文を引用することをおすすめします。

画像生成AIの誕生と変遷(4) 画像生成AIの2014-2024におきたパラダイムシフト

より初心者向けにわかりやすい書籍としてまとめたのがこちらですが

📕AIとコラボして神絵師になる 論文から読み解くStable Diffusion

より最新の情報を幅広い方々に向けて圧縮して解説した書籍がこちら

📕画像生成AI Stable Diffusion スタートガイド (2024/3/29リリース)

現在主流になっているStable Diffusion よりも前に「実在しないリアルな顔」を自在に生成できる研究「GAN」が2014年に提案され、2018年には「StyleGAN」としてスタイル学習が提案されます。

これらはCLIPによってテキストと画像の関係を表にした巨大なテーブルで学習した潜在空間が2021年には「StyleCLIP」という論文で StyleGAN の潜在空間にCLIPによる文字入力を使った StyleGAN 画像操作のためのインターフェースが提案されます。まずCLIPに基づく損失を利用し、ユーザが提供するテキストプロンプトに応答して入力の潜在ベクトルを修正する方法が提案されます。2022年には「clip2latent」として、ノイズ除去拡散とCLIPを用いた事前学習済みStyleGANのテキスト駆動サンプリングが提案されます。その頃「ContorlNet」や「Fooocus」を開発したスタンフォード大学の Lvmin Zhang(@lllyasviel)「Style2Paint」というアニメスケッチのスタイル転送や、自動着色をU-netとGANを用いて提案していました。2022年に同じスタンフォード大学のChenlin Meng は 拡散ノイズ除去と画像合成と編集「SDEdit」で拡散モデルで成功した点が大きいと思います。

SDEditという研究があってここでGANと拡散が比較されるきっかけになっており、SDEditのSDとは「Stable Diffusion」ではありません。「Stochastic Differential Equations」でのノイズ除去を使ったDiffusionモデルによる画像合成、編集がGANと比較されています。Stable Diffusionが。MengさんはPika Labs、Soraの内部でも使われています。

SDEdit: Guided Image Synthesis and Editing with Stochastic Differential Equations

誘導画像合成は,日常ユーザが最小努力で光現実的画像を作成,編集することを可能にする。重要課題は,ユーザ入力(例えば,手引き色ストローク)と合成画像の現実感に忠実性のバランスをとることである。既存のGANベースの方法は,条件付きGANまたはGAN反転のいずれかを用いて,そのようなバランスを達成する試みを試み,それは挑戦的であり,しばしば,個々のアプリケーションのための追加の訓練データまたは損失関数を必要とする。これらの問題に取り組むために,著者らは,確率的微分方程式(SDE)を通して反復雑音除去によって現実的画像を合成する,拡散モデル生成の前に,新しい画像合成と編集法,確率的微分編集(SDEdit)を導入した。任意の型のユーザガイドによる入力画像を考えると,SDEditは最初に入力に雑音を付加し,次に,そのリアリズムを増加させる前にSDEを通して得られた画像を雑音除去する。SDEditはタスク固有の訓練や反転を必要とせず,現実感と忠実性の間のバランスを自然に達成することができる。SDEditは,ストロークベース画像合成と編集,ならびに画像合成を含む複数のタスクに関して,人間認識研究に従って,現実感と全体満足スコアの91.72%まで,最先端のGANベース法よりも大幅に優れていた。【JST・京大機械翻訳】

今一度調べてみましたが、SDEdit: Image Synthesis and Editing with Stochastic Differential Equations (ICLR 2022) Chenlin Meng, Yutong He, Yang Song, Jiaming Song, Jiajun Wu, Jun-Yan Zhu, and Stefano Ermonが発表された、ICLR2022は2022年4月25日 – 2022年4月29日、

SDEditは、効果的な画像編集とスタイル転送手法である。SDEditは、Stable Diffusion(こちらを参照)やGLIDEを含む最先端の生成AIフレームワークで広く使用されています。一般的には、Stable Diffusionの「Image2Image」として知られています。Stalbe Diffusion V1の発表「High-Resolution Image Synthesis With Latent Diffusion Models」@InProceedings{Rombach_2022_CVPR, Rombach, Robin and Blattmann, Andreas and Lorenz, Dominik and Esser, Patrick and Ommer, Bjornは Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR2022) 2022年6月19-24日にルイジアナで開催されています。

国際会議の査読なのでCVPR2022投稿の締切が November 18, 2021、SDEditの初稿「SDEdit: Image Synthesis and Editing with Stochastic Differential Equations」のarXivへの投稿が

Mon, 2 Aug 2021 17:59:47 UTC (12,405 KB)

となっていますので、Chenlin Meng先生のほうが先行研究と言えると考えます。もちろんこの時期にはStyleGANやStyleCLIP、そしてclip2latentの研究も近くで行われていたので、知る人ぞ知るではあるけれども大きな研究進捗がこの分野で進められていたという見解で間違っていないと考えます。

今後の Chenlin Meng @chenlin_meng の活躍が楽しみです。

この記事が気に入ったらサポートをしてみませんか?