Appleのオンデバイス・サーバー基盤モデルの概要

以下の記事が面白かったので、簡単にまとめました。

1. はじめに

WWDC24で、iOS 18、iPadOS 18、macOS Sequoia に統合されたパーソナルインテリジェンスシステム「Apple Intelligence」を発表しました。「Apple Intelligence」は、ユーザーの日常的なタスクに特化した複数の高性能生成モデルで構成されており、現在のアクティビティに即座に適応できます。組み込まれている基盤モデルは、テキストの作成と調整、通知の優先順位付けと要約、家族や友人との会話のための遊び心のある画像の作成、アプリ間のやり取りを簡素化するためのアプリ内アクションの実行など、ユーザーエクスペリエンスに合わせてファインチューニングされています。

以下の概要では、これらのモデルのうち2つ「約3Bパラメータを持つオンデバイスの言語モデル」と「Private Cloud Computeで利用できるサーバーの言語モデル」が、特殊なタスクを効率的、正確、責任を持って実行するためにどのように構築および適応されたかを説明します。

これら2つの基盤モデルは、ユーザーと開発者をサポートするためにAppleが作成した、より大きな生成モデルファミリーの一部です。これには、Xcodeにインテリジェンスを組み込むためのコーディングモデルや、メッセージアプリなどでユーザーが視覚的に自己表現できるようにする拡散モデルが含まれます。この幅広いモデルセットに関する詳細情報を近日公開予定です。

2. 責任あるAI開発への注力

「Apple Intelligence」は、あらゆる段階でAppleのコアバリューに基づいて設計されており、画期的なプライバシーイノベーションを基盤として構築されています。さらに、AIツールの開発方法とそれを支えるモデルをガイドする責任あるAI原則を作成しました。

(1) インテリジェントなツールでユーザーをサポート

AIを責任を持って使用できる領域を特定し、特定のユーザーのニーズに対応するツールを作成します。ユーザーが目標を達成するためにこれらのツールをどのように使用するかを尊重します。

(2) ユーザーを代表

世界中のユーザーを忠実に代表することを目標に、非常に個人的な製品を構築します。AIツールとモデル全体で固定観念や体系的な偏見が永続しないように継続的に取り組んでいます。

(3) 慎重に設計

設計、モデルの学習、機能の開発、品質評価など、プロセスのあらゆる段階で予防措置を講じ、AIツールが悪用される可能性や潜在的な危害につながる可能性を特定します。ユーザーからのフィードバックを活用して、AIツールを継続的かつ積極的に改善します。

(4) プライバシーを保護

強力なデバイス内処理とプライベートクラウドコンピューティングなどの画期的なインフラストラクチャにより、ユーザーのプライバシーを保護します。基盤モデルの学習時に、ユーザーのプライベートな個人データやユーザーインタラクションを使用することはありません。

これらの原則は、「Apple Intelligence」を有効にし、機能とツールを特殊なモデルに接続し、入力と出力をスキャンして各機能に責任を持って機能するために必要な情報を提供するアーキテクチャ全体に反映されています。

3. 事前トレーニング

Appleの基盤モデルは、2023 年にリリースしたオープンソースプロジェクトであるAppleの「AXLearn」で学習されています。JAXとXLAを基盤として構築されており、TPUやクラウドとオンプレミスの両方のGPUを含むさまざまな学習ハードウェアとクラウドプラットフォームで、高い効率性とスケーラビリティでモデルを学習できます。データ並列処理、テンソル並列処理、シーケンス並列処理、FSDP (Fully Sharded Data Parallel) を組み合わせて、データ、モデル、シーケンスの長さなどの複数の次元に沿って学習をスケーリングしています。

基盤モデルは、特定機能を強化するために選択されたデータや、Appleの Webクローラーである「AppleBot」によって収集された公開データなどのライセンスデータで学習されています。Webパブリッシャーは、データ使用制御を使用して、「Apple Intelligence」の学習でのWeb コンテンツの使用をオプトアウトするオプションがあります。

基盤モデルの学習時にユーザーのプライベートな個人データやユーザーインタラクションを使用することはなく、インターネットで公開されている社会保障番号やクレジットカード番号などの個人を特定できる情報を削除するフィルタを適用しています。また、卑猥な表現やその他の低品質のコンテンツが学習コーパスに含まれないようにフィルタリングします。フィルタリングに加えて、データの抽出、重複排除、モデルベースの分類器の適用を実行して、高品質のドキュメントを識別します。

4. 事後トレーニング

データの品質がモデルの成功に不可欠であることがわかったため、学習パイプラインでハイブリッドデータ戦略を活用し、人間が注釈を付けたデータと合成データの両方を組み込み、徹底したデータキュレーションとフィルタリングの手順を実施しています。学習後には、(1) 教師委員会による拒否サンプリングファインチューニングアルゴリズム、(2) ミラー降下ポリシー最適化と Leave-One Out アドバンテージ推定機能を備えたRLHFアルゴリズムという2つの新しいアルゴリズムを開発しました。これら2つのアルゴリズムにより、モデルの指示に従う品質が大幅に向上することがわかりました。

5. 最適化

Appleの生成モデルが非常に高性能であることを保証するだけでなく、オンデバイスおよびプライベートクラウド上でモデルを最適化して速度と効率を高めるために、さまざまな革新的な手法を採用しています。最初のトークンと拡張トークンの両方の推論パフォーマンスに、広範な最適化を適用しました。

オンデバイスのモデルとサーバーモデルの両方で、グループ化されたクエリアテンションを使用します。共有の入力および出力の語彙埋め込みテーブルを使用して、メモリ要件と推論コストを削減します。これらの共有埋め込みテンソルは重複することなくマッピングされます。オンデバイスのモデルでは語彙サイズが49Kですが、サーバーモデルでは語彙サイズが100Kで、これには追加の言語トークンと技術トークンが含まれます。

オンデバイスの推論では、必要なメモリ、電力、パフォーマンス要件を満たす重要な最適化手法である低ビットパレタイゼーションを使用します。モデルの品質を維持するために、LoRA アダプタを使用して、2bitと4bitの混合構成戦略 (重みあたり平均3.5bit) を組み込んだ新しいフレームワークを開発し、非圧縮モデルと同じ精度を実現しました。

さらに、インタラクティブなモデル遅延および電力分析ツールであるTalariaを使用して、各操作のビットレート選択をより適切にガイドします。また、アクティベーション量子化と埋め込み量子化を活用し、ニューラルエンジンで効率的なKVキャッシュ更新を可能にするアプローチを開発しました。

この一連の最適化により、iPhone 15 Pro では、プロンプトトークンあたり約0.6ミリ秒の最初のトークンまでの遅延と、1秒あたり 30トークンの生成速度を実現できます。注目すべきは、このパフォーマンスはトークン推測技術を採用する前に達成されたものであり、これによりトークン生成速度がさらに向上することがわかります。

6. モデルの適応

Appleの基盤モデルは、ユーザーの日常的な活動に合わせてファインチューニングされており、手元のタスクに合わせて動的にオンザフライで特化できます。事前学習済みモデルのさまざまなレイヤーにプラグインできる小さなニューラルネットワーク モジュールであるアダプタを使用して、特定のタスクに合わせてモデルをファインチューニングしています。当社のモデルでは、Transformerアーキテクチャのデコードレイヤーの適切なセットに合わせて、アテンションマトリックス、アテンションプロジェクションマトリックス、およびポイント単位のフィードフォワード ネットワーク内の完全接続レイヤーを適応させています。

アダプターレイヤーのみをファインチューニングすることで、事前学習済みの基盤モデルの元のパラメータは変更されず、モデルの一般的な知識が保持され、特定のタスクをサポートするようにアダプターレイヤーが調整されます。

アダプターパラメータの値は16bitで表します。オンデバイスのモデルには約3Bパラメータがあるため、Rank 16アダプタのパラメータは通常数十メガバイト必要です。アダプタモデルは動的にロードされ、一時的にメモリにキャッシュされ、スワップされます。これにより、基盤モデルは、メモリを効率的に管理し、オペレーティングシステムの応答性を確保しながら、手元のタスクに合わせて即座に特化できるようになります。

アダプタの学習を容易にするために、ベースモデルまたは学習データが更新されたときにアダプタを迅速に再学習、テスト、および展開できる効率的なインフラストラクチャを作成しました。アダプタパラメータは、最適化セクションで紹介した精度回復アダプタを使用して初期化されます。

7. パフォーマンスと評価

モデルのベンチマークでは、人間による評価に焦点を当てています。機能固有のアダプタと基盤モデルの両方でパフォーマンス評価を実施しました。

アプローチを説明するために、要約用のアダプタをどのように評価したかを説明します。電子メールと通知の要約に関する要件は重要な点で異なるため、パレット化されたモデルの上にLoRAアダプタをファインチューニングして、これらの特定の要件を満たします。学習データは、大規模なサーバモデルから生成された合成要約に基づいており、高品質の要約のみを保持する拒否サンプリング戦略によってフィルタリングされています。

製品固有の要約を評価するために、各ユースケースについて慎重にサンプリングされた750件の応答のセットを使用します。これらの評価データセットは、製品機能が本番環境で直面する可能性のある多様な入力セットを強調しており、コンテンツの種類と長さが異なる単一ドキュメントとスタックされたドキュメントの層別混合物が含まれています。製品機能として、実際のユースケースを代表するデータセットに対してパフォーマンスを評価することが重要でした。アダプタを備えたモデルは、同等のモデルよりも優れた要約を生成することがわかりました。

責任ある開発の一環として、要約に固有の特定のリスクを特定して評価しました。たとえば要約では、重要なニュアンスやその他の詳細が望ましくない方法で削除される場合があります。ただし、要約アダプタは、対象となる敵対的サンプルの 99%以上で機密コンテンツを増幅しなかったことがわかりました。未知の害を特定するために敵対的に調査を続け、評価を拡大してさらなる改善に役立てます。

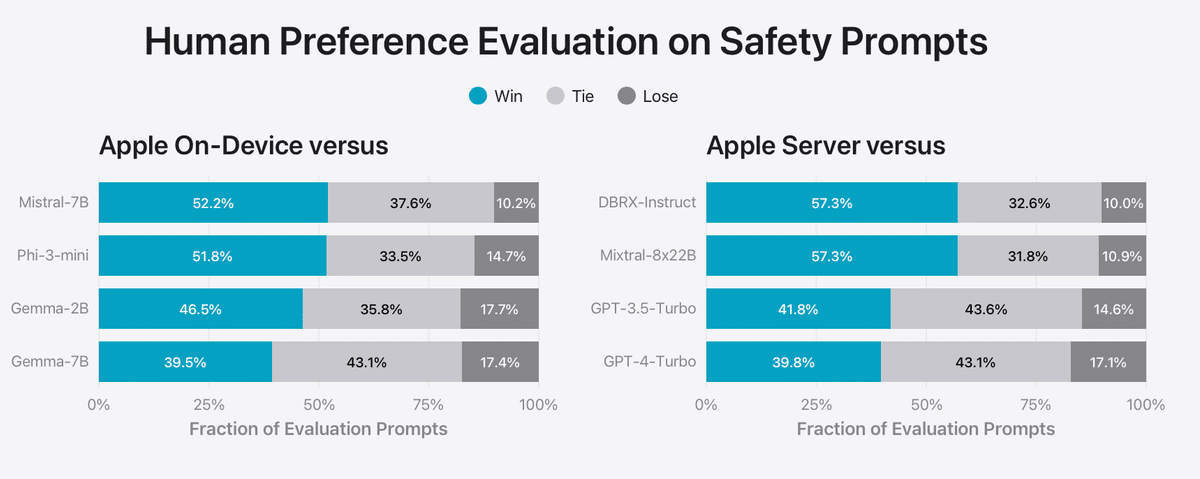

モデルをさらに評価するために、「IFEval」(Instruction-Following Eval) ベンチマークで、その命令追従機能を同等サイズのモデルと比較しました。結果は、Appleのオンデバイスモデルとサーバモデルの両方が、同等サイズのオープンソースモデルや商用モデルよりも詳細な命令によく従っていることを示唆しています。

さまざまな書き込み指示で構成される内部要約および構成ベンチマークでモデルの書き込み能力を評価しました。

関連

この記事が気に入ったらサポートをしてみませんか?