覚え書き:Hugging face 上でモデルの量子化が実行できそうです

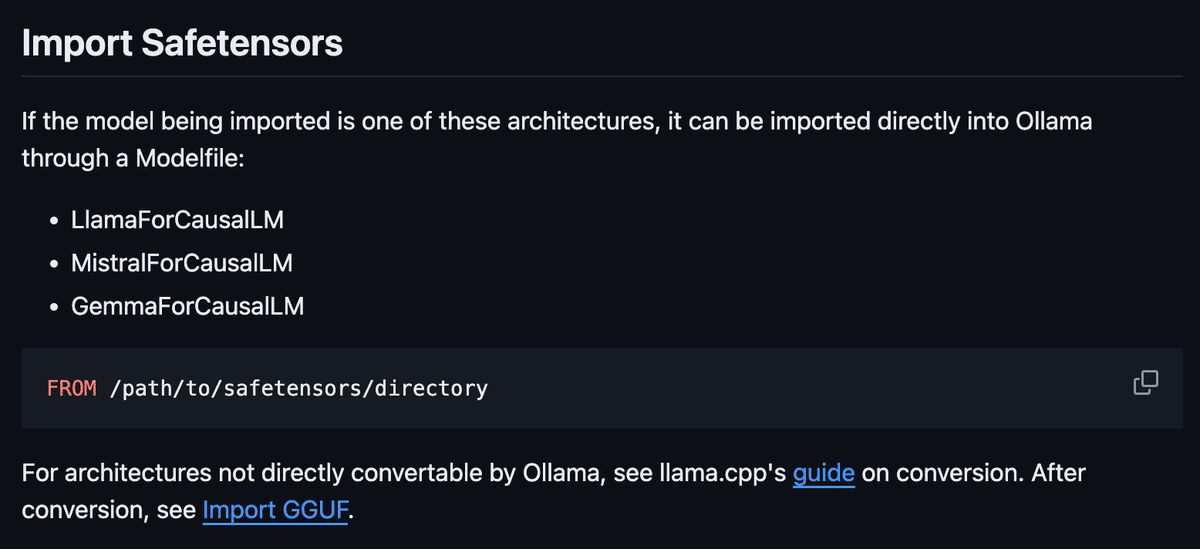

昨日、Ollamaの説明を下記の見てました。

リンク先のGuideをさらに見てみたら、こんなノートがありました。

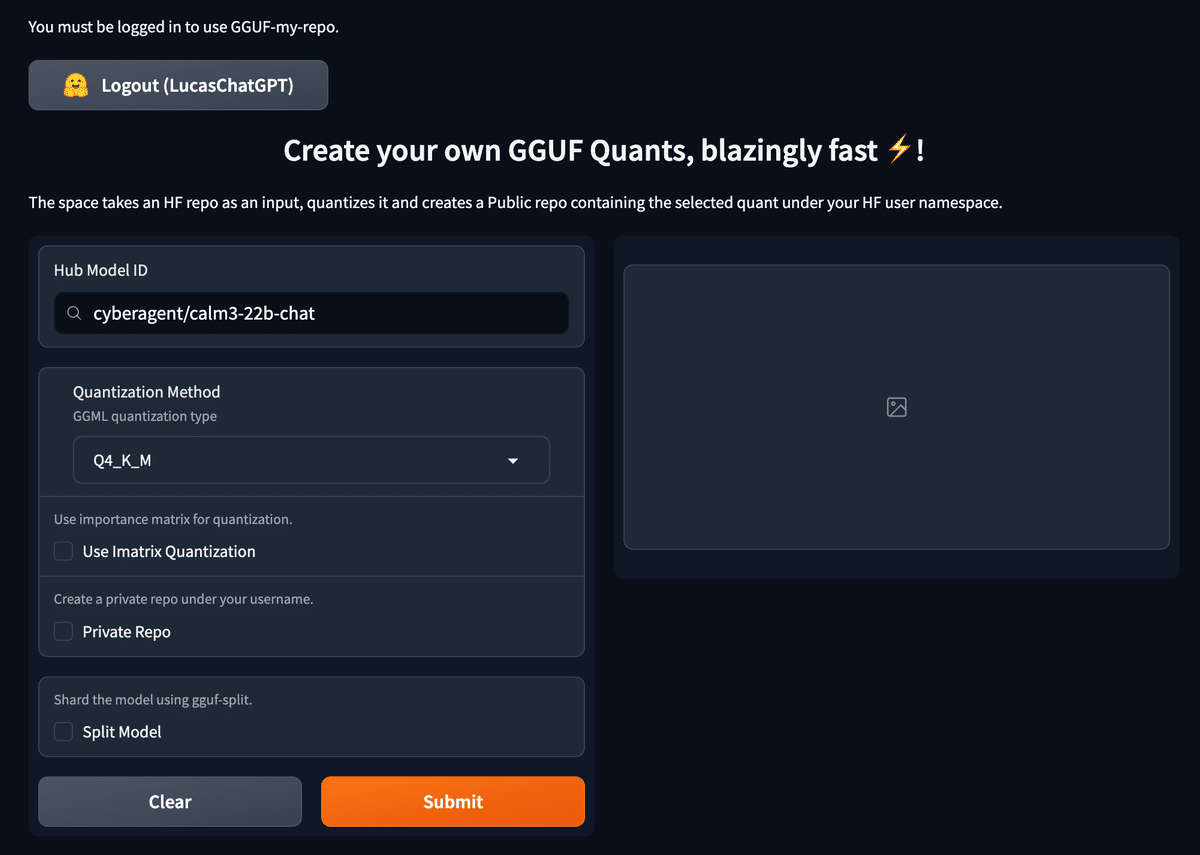

なんとHugging face 上で量子化ができるとのことです!

Create your own GGUF Quants, blazingly fast ⚡!

ログインして許可を与えると、こんなページです。

簡単な英語ですが、訳すると「このスペースは HF リポジトリを入力として受け取り、それをクオンタイズし、選択したクオントを含むパブリック リポジトリを HF ユーザー名前空間の下に作成します。」とのことです。

この画面では、Calm3-22b-chatを試してみたいと思って、そのモデルを貼り付けてます。

デフォではQ4_K_M がでてました。

とりあえず触ってみるということで、あとはどこにもチェックをいれずにSubmitしてみましたが・・・なにかごちゃごちゃ"Error: Error converting to fp16: b'INFO:hf-to-gguf:Loading model: calm3-22b-chat"から始まる文でエラーがでて上手く変換できませんでした😢

そして今、特に自分でGGUFにしたいと思うモデルが思いつかないので、これ以上していません。という状況なので、上手く量子化がここで行われるのかの確認まではできてません。

ぜひ興味がある人は試してみてください。

この記事を最後までご覧いただき、ありがとうございます!もしも私の活動を応援していただけるなら、大変嬉しく思います。