香織の「ControlNet」活用術【Stable Diffusion】

前回はStable Diffusion Web UI(以後、SDWU)の導入手順を紹介しましたが、今日は、その用途を色々広げることができる「Controlnet」の使い方を整理します。

※この記事では、Windows(64bit)のパソコンにインストールしていく手順を紹介していきます。

ControlNetとは

画像生成をする時、思い描いた構図をPROMPTだけで出力するのはとても難しいのですが、ControlNet機能を使うと簡単に思い描いた構図やポーズを生成することが出来ます。手順は以下の通りです。

(1)参考となる画像を用意する

(2)ControlNetの用途に応じて適切なモデルを選択する

(3)参考画像をベースに思い描いた画像を生成する。

1.ControlNetの導入

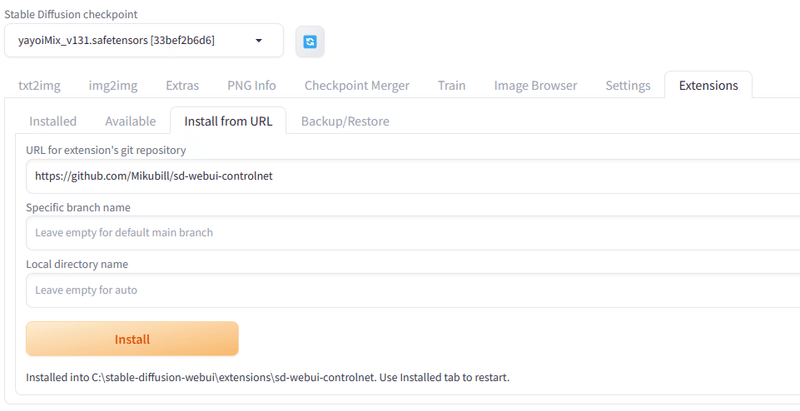

(1)「Extensions」タブを開き、「Install from URL」の「URL for extension’s git repository」に下記のURLを入力しInstallをクリックします。

https://github.com/Mikubill/sd-webui-controlnet

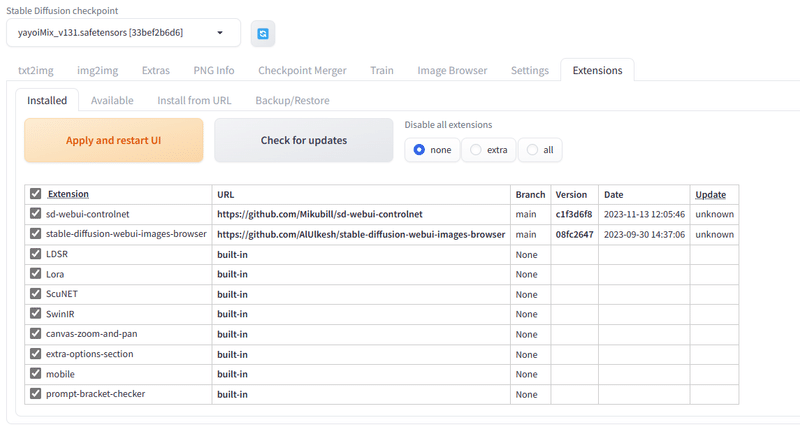

2.「Installed」タブの「Apply and restart UI」をクリックします。

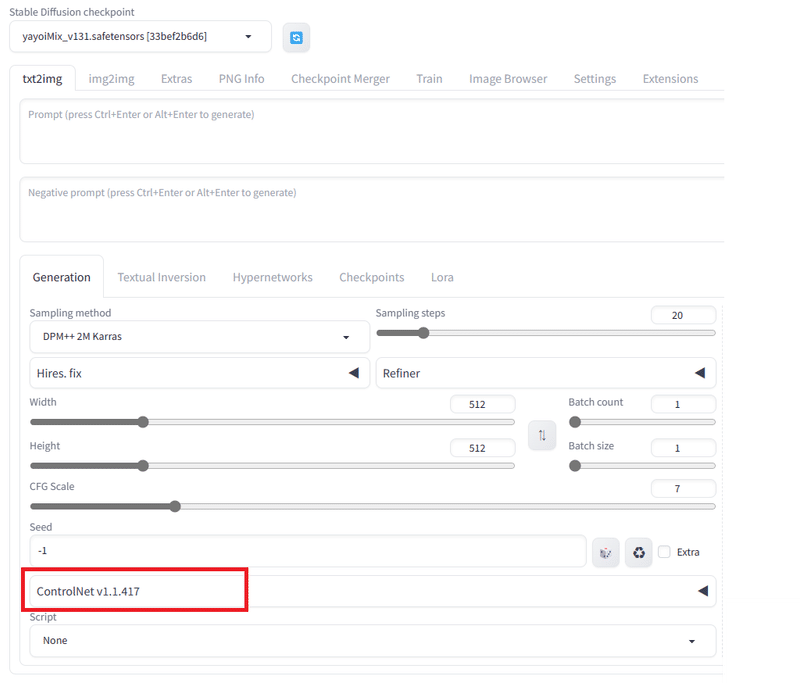

3.「ControlNet」が追加されれば成功です。

2.モデルについて

ControlNetには、用途に応じて様々なモデルが用意されています。

詳しい情報は、下記のサイトで丁寧に解説されていますのでそちらも参照ください。

各モデルの機能は以下の通りです(上記サイトから引用させていただきました)。

openpose: 元画像から棒人間を生成し、画像を生成します

depth:深度情報を元に、画像を生成します

canny:画像から線画を抽出し、画像を生成します

scribble:ラフな線画から、画像を生成します

inpaint:画像の一部を修正することができます

mlsd:直線を抽出して画像を生成します(主に建物等の画像生成)

tile:高解像度画像を生成します

lineart:線画を作成し、画像を生成します

lineart_anime :lineartのイラスト向けバージョン

normalbae:法線マップを使って画像を生成します

seg:セマンティックセグメンテーションの手法を使って画像を生成します

softedge:ソフトな輪郭を使って画像を生成します

shuffle:画像をシャッフルし再構成することで画像を生成します

ip2p:Instruct Pix2Pixを使用して、プロンプトにより画像を修正します

3.モデルのダウンロード

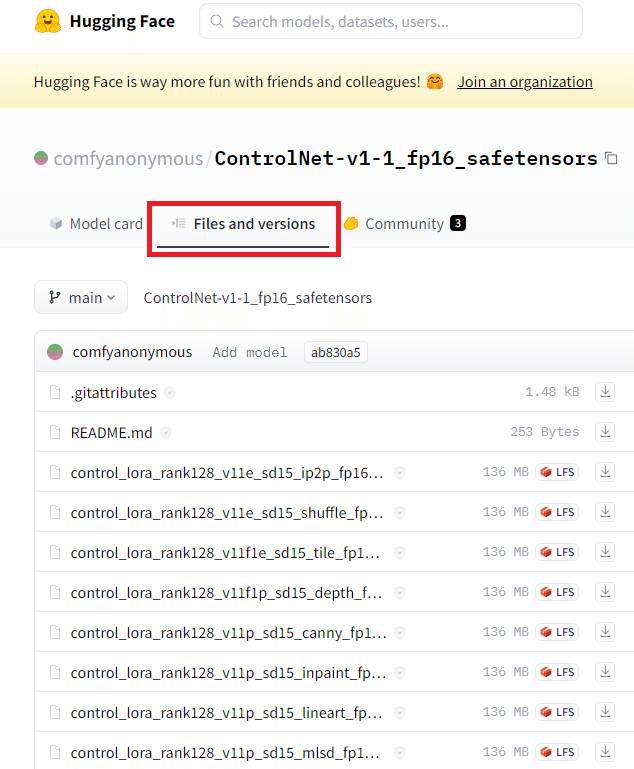

下記のサイトに上記の機能を持つモデルのファイルがありますので、まずは使用するものだけをダウンロードします。

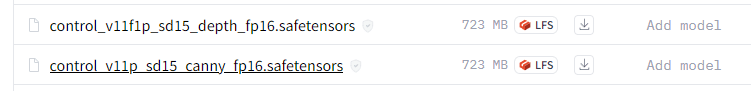

ここでは、とりあえずcanny/depth/lineart/openposeをダウンロードして解説していきます。「**.safetensors」という拡張子のファイルです。

ファイルをダウンロードしたら、以下のmodelsフォルダにコピーします。

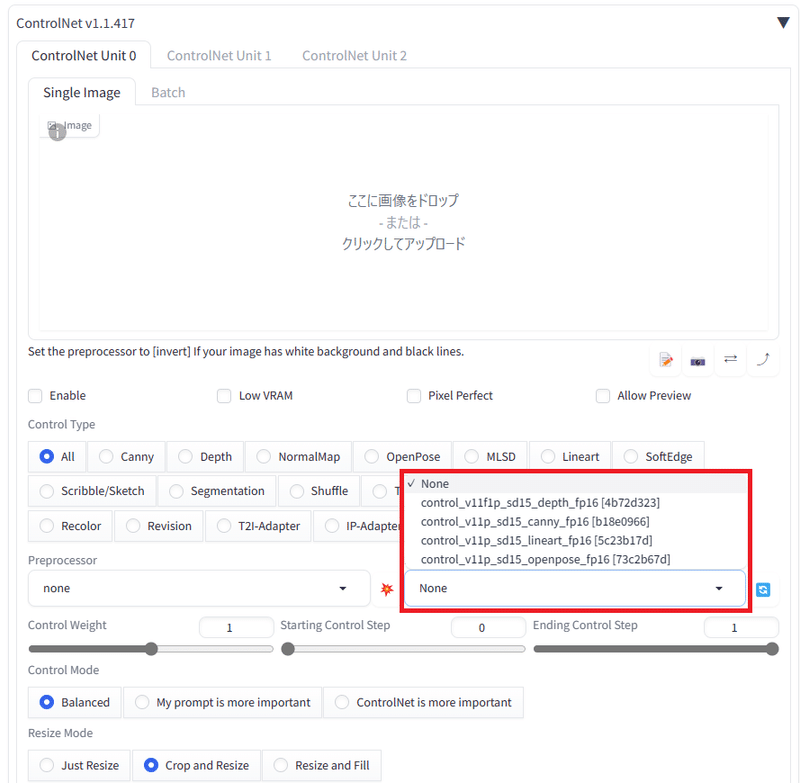

stable-diffusion-webui\extensions\sd-webui-controlnet\modelsControlNetを開くとmodelsのところに4つのファイルが表示されています。

表示されていない場合は、横の青いマークを押して再読み込みさせてください。

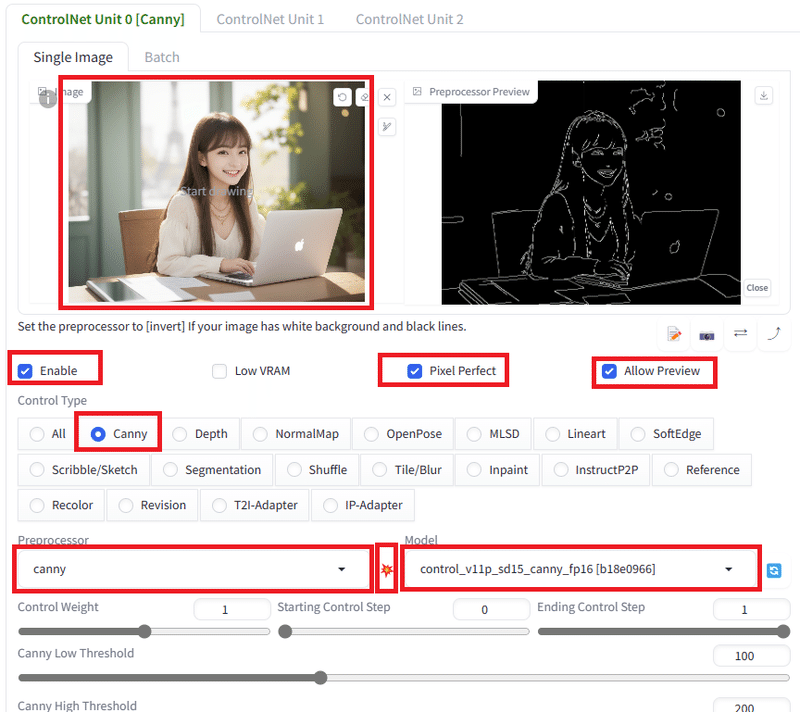

4.canny:画像から線画を抽出し、画像を生成

1.まず、以下の赤い部分にチェックを入れて、PreprocessorとModelを選びます。ここではcannyを選びました。

2.PreprocessorとModelの間の爆発マークを押すと線画が抽出されます。

3.その他の項目はデフォルトのままで、PROMPTを入力して出力します。

元の画像

PROMPTに「図書館とライト」を追加した画像

構図を維持したまま、別の画像を生成することが出来ました。

なお、ControlNetの使い方は、下記のページで、かたらぎさんが詳しく解説されています。僕の説明よりわかりやすそうなので、ぜひこちらも参考にしてみてください。

MODEL:yayoiMix_v131

AIモデル:加藤香織

この記事が気に入ったらサポートをしてみませんか?