ジェスチャーコントローラを作ろう!(ML2Scratch)

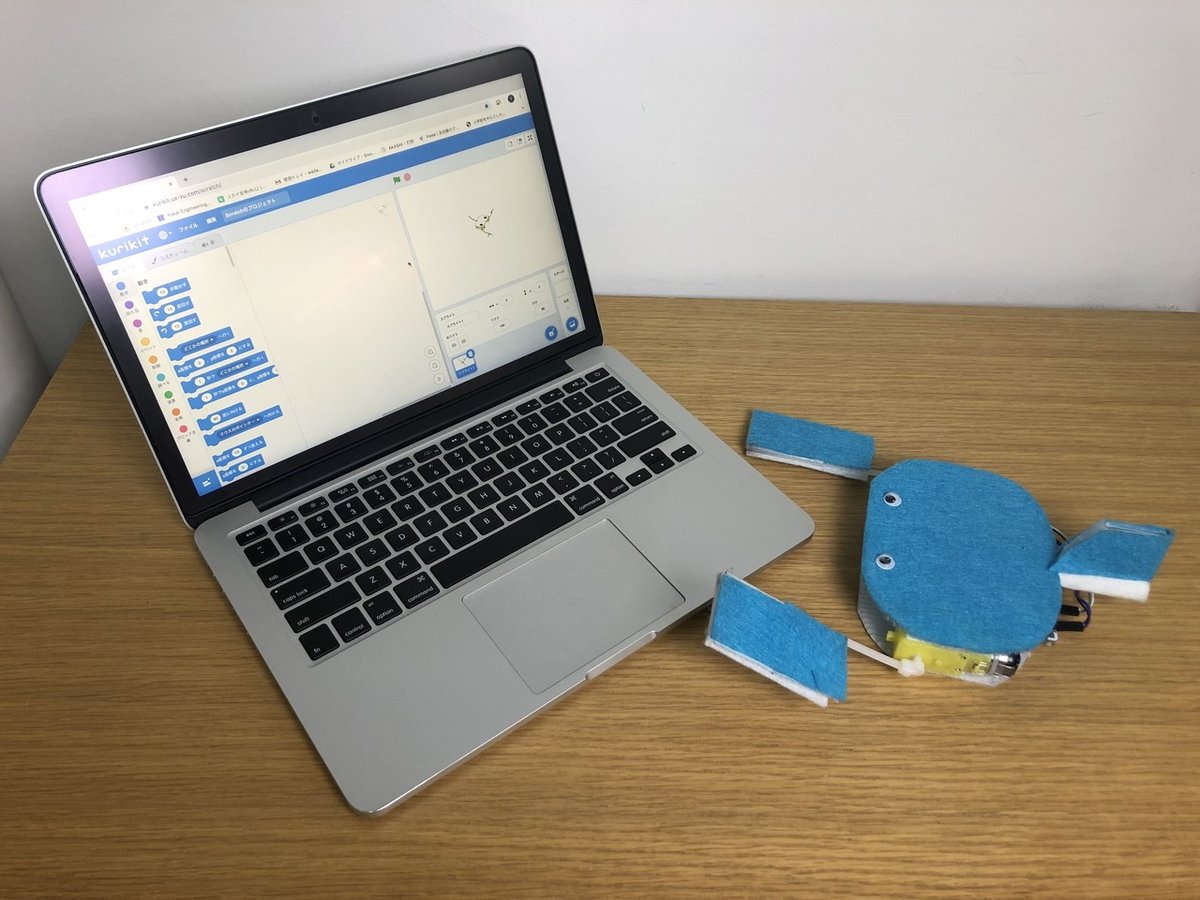

今回の記事では、機械学習が体験できる拡張機能「ML2Scratch」を利用してハンドジェスチャーで生きものロボットを動かすコントローラを作ります。

ML2Scratchの詳しい紹介については、こちらの記事もご参照ください。

イルカショーのようにジェスチャーを使って作例のクジラちゃんロボットを動かしてみましょう!この記事では、こんなことができます。

iOSは、この記事に対応しておりません。

iOSのWebBLEアプリではカメラを使うことができないため、他の端末をご利用いただくようお願いいたします。

用意するもの

・生きものロボットキット(ココロキット内蔵)

・カメラが搭載されている端末

拡張機能をロードしよう

「ココロキット」と「ML2Scratch」をロードします。

操作に使うジェスチャーを決める

作例ロボットのクジラちゃんを、ハンドジェスチャーで動かしてみましょう。操作するには、前進・後退・右旋回・左旋回・停止の5つの命令をジェスチャーによって指示します。

5種類のジェスチャーを決めましょう。今回の例では、下記のようにしてみます。

・前進:人差し指を上に

・後退:人差し指を下に

・右旋回:人差し指を右に

・左旋回:人差し指を左に

・停止:グーのジェスチャー

それぞれのジェスチャーにラベルづけをする

ML2Scratchの機能を使って、カメラの画像に映ったジェスチャーにラベルをつけていきましょう。ラベルの付け方については、こちらの記事を参考にしてください。

今回は、以下のようにラベルをつけます。

・人差し指を上に→ラベル1

・人差し指を下に→ラベル2

・人差し指を右に→ラベル3

・人差し指を左に→ラベル4

・グーのジェスチャ→ラベル5

[注意]

背景や、腕の映り具合なども認識の精度に関わってきます。なるべく実際に操作するときと近い状態で撮影を行いましょう。

ロボットの動きのプログラムをつくる

カメラに映っているジェスチャーを判断し、ロボットのモータを動かすプログラムを作りましょう。プログラムはシンプルで、下記の画像のようになります。

さあ、動かしてみよう

いかがでしたか?今回は、機械学習の技術を使ってジェスチャーをつかって生きものロボットを操作する方法を、学びました。さまざまな体の動きをつかって生きものロボットを自由に動かしていきましょう!

自分の体の動きと組み合わせて、生きものロボットショーが実現できるかもしれません!

これを作ってくれたら、ハッシュタグ#kurikitをつけて見せてもらえると嬉しいです!