画像認識LLMがついに解禁か?性能を検証してみた【MiniGPT-4】

はじめに

GPT-4の画像認識機能を待望にされている方も多いと思いますが、一般公開の話はまだ出てきておりません。

しかしながら、OpenAIとは別で、先に画像認識AI「MiniGPT-4」が登場しているということでそちらを色々と検証し、GPT-4の画像認識についての性能予測をしてみようと思います。

今回使用するMiniGPT-4はデモアプリが公開されていて、誰でも無料で試用可能です。なお、開発者の方向けにはAPIやソースコードも公開されているっぽいです。

GPT-4の論文のものと比較検証

まずは、GPT-4の論文に掲載されている画像を使って、MiniGPT-4の性能を検証してみます。

最初に検証する画像はこちらです。GPT-4の論文では、AIに画像のおもしろさ(映像用コネクタでスマホを充電している)を解説させています。

この画像をMiniGPT-4に入力し、GPT-4の論文と全く同じプロンプトを使用した結果がこちら。

これに、chromeの日本語訳をさせたものがこちら。(chromeの機能のため翻訳精度には目を瞑ってください)

スマホとケーブルは認識しているようですが、その他はかなり間違っていますね。精度は全然だめです。

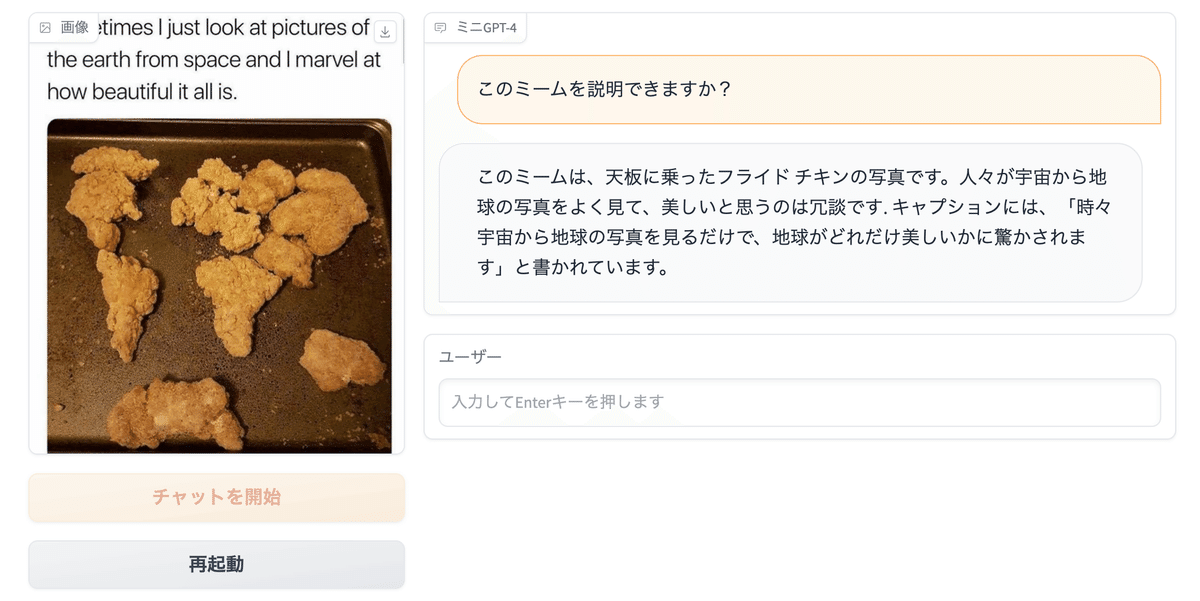

続いて、こちらの画像。「このミームを説明して」と指示していて、画像には「テキスト」が含まれています。このテキストを認識できるかがポイントです。GPT-4の論文では良い感じですね。

MiniGPT-4でもちゃんと画像内の文字認識をできるのか?ということで、出力結果がこちら。

こちらは、正確な応答を返しています。画像についても、文字認識についても、できているということだと思います。

続いては論文からではないですが、同じくGPT-4の登場時に紹介されたものです。冷蔵庫の写真からレシピを作成してもらうというものです。

MiniGPT-4での出力結果が以下。

結果としては、冷蔵庫であることは認識していますが、冷蔵庫の中のものまで正しく認識できていないように思いました。

ということで、全体的にGPT-4の論文掲載されていたものよりも精度の低いものとなりました。

MiniGPT-4の論文の画像で確かめる

先ほどの検証では、なんだか全体的に残念な精度でした。しかし、MiniGPT-4の論文では、そこそこ良さげな結果が出ているように見えます。

ここで、MiniGPT-4の論文内では、都合の良い出力だけを掲載しているだけではないか?という疑問が湧いてきたので、全く同じ画像&プロンプトを使用して試しました。

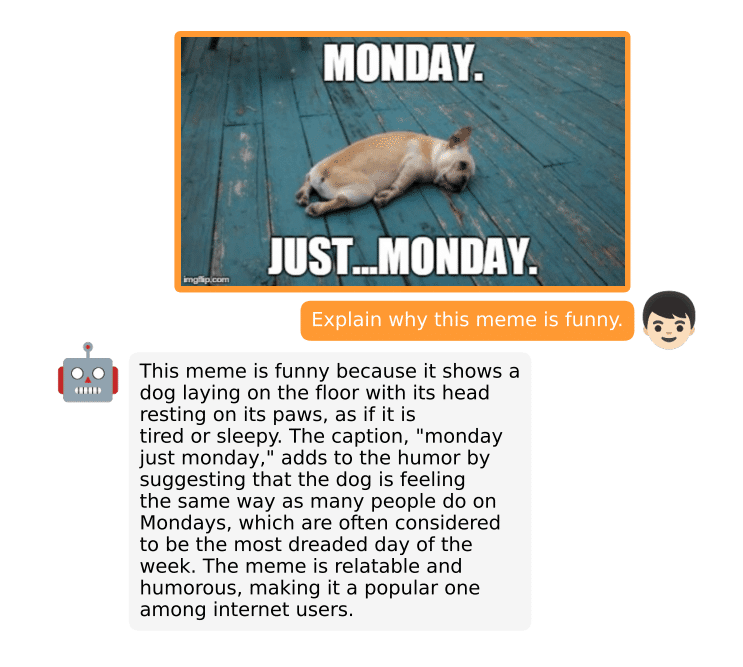

ということで、最初に検証するのはこちら。MiniGPT-4の論文内で、紹介されているものなので、ほとんど同じ応答をちゃんとできるはず。

では気になる出力結果がこちら。

内容はとても良い感じです。というかほとんど論文と同じ結果が返ってきました。まあ「そりゃそうだ、だってMiniGPT-4の論文と同じ画像&同じプロンプトなんだから」と言いたいところですが正直僕の感想は、これは応答があまりにも「似過ぎている」と感じました。

なんだか怪しい雰囲気があるなあ、と思いつつも続いての画像を試します。

こちらも「似過ぎている」ような感じ。ちなみに、Temperature(応答の多様性)というパラメータを変えてもあまり変わらない印象でした。

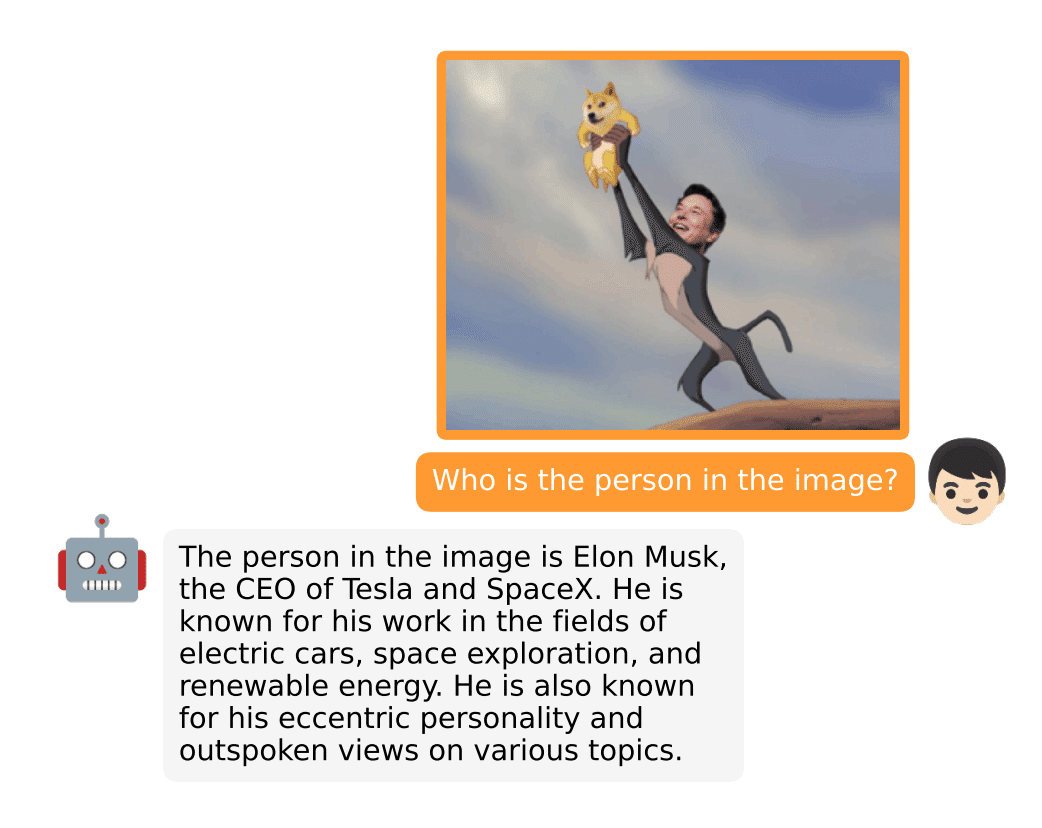

そして、3つめの画像はこちら。

今度は全然違う応答になりました。とても短い出力結果になっていて、イーロンマスクであることも認識できていないようです。

ということで、論文とほとんど同じ出力のものもあれば、論文の出力を再現できないものもありました。

ここまでの結果を全体的に見渡すと、ざっくりとした画像の認識はできるけど、ディティールまでは認識できないというくらいの精度だと思いました。

その他の画像で深追い検証

最後に、どちらの論文にも掲載されていないオリジナル画像で検証を行います。

まずはこちら。MiniGPT-4の論文で葉っぱの診断をしていたので、違う葉っぱだとどうなるのかを検証してみました。

普通に枯れているだけなんですが、違う病気の診断結果になりました。葉っぱの真菌感染はぶつぶつと葉の表面が膨れ上がるので、それと見間違えている可能性があります。ちなみに、真菌感染の画像は集合体恐怖症の人は調べない方が良いと思います。

やはり、MiniGPT-4の論文では、「上手くいったパターン」を掲載している感じはします。

そして次の画像。「うっせえわ」のサムネから歌詞を作ってもらいました。

もちろん本物とは似つかないですが、まあまあサムネの雰囲気はとらえているような気がします。センスは、、、微妙ですね(笑)

それに1番と2番の歌詞ほとんど同じ。。。

おわりに

MiniGPT-4は現状、正直使えるレベルの精度ではないと思います。

ただし、大きい文字であれば今のMiniGPT-4でも文字認識できるので、今後本家GPT-4の登場により、産業活用という面ではOCR系のゲームチェンジャーになる予感はしています。

MiniGPT-4の精度が低い感じはしますが、それはモデルのアーキテクチャーというよりも、単に学習データ数の不足感が感じられました。

というのも、パラメータを変えながら何度か出力して上記の検証をしましたが、出力の文構造もほとんど変わることはなかったので、ほぼ同じ文章で追加学習したんじゃないかとみています。

なので、現状使えないから今後もしばらく使えないという結論は罠で、逆にデータの学習を改善するだけですぐに精度向上しそうと考えています。

GPT-4も論文ではまだ「都合のいい出力」だけを並べていて、今追加学習をしている最中だからリリースが遅れているんじゃないか?などと妄想が広がりますが、もしそうならTwitterのAPI有料化は激痛だなあー。

(てか、絶対他社のAI学習を抑止するために有料化しただろ。。。)

この記事が気に入ったらサポートをしてみませんか?