RNN(リカレントニューラルネットワーク)とはなにか?わかりやすく解説!

この記事は、主にAIとその技術的概念、特にリカレントニューラルネットワーク(RNN)の仕組みとその具体的な内容について解説しています。RNNの基本的な定義、仕組み、およびその欠点について詳しく説明しています

自己紹介

こんにちは!かっつーです テクノロジーと人間との共進化し、なめらかな社会を目指していして、様々なテクノロジーについての勉強や政治、経済、社会や身体についてなどを勉強しています。 このブログでは自分の活動についてや勉強した内容についてアウトプットしていきたいと思います。 このカテゴリーではAIの技術的な概念についてやその具体的な内容などについてわかりやすく解説していきたいと思います。

この記事の読者ターゲット

この記事は、主にAIとその技術的概念、特にリカレントニューラルネットワーク(RNN)の仕組みとその具体的な内容について解説しています。RNNの基本的な定義、仕組み、およびその欠点について詳しく説明しています。

自己紹介

こんにちは!かっつーです

テクノロジーと人間との共進化し、なめらかな社会を目指していして、様々なテクノロジーについての勉強や政治、経済、社会や身体についてなどを勉強しています。

このブログでは自分の活動についてや勉強した内容についてアウトプットしていきたいと思います。

このカテゴリーではAIの技術的な概念についてやその具体的な内容などについてわかりやすく解説していきたいと思います。

この記事の想定する読者

AI技術やディープラーニングに興味がある学習者。

RNNやその他のニューラルネットワークモデルの基本を理解したい技術者。

機械学習の欠点や課題について深く理解したい研究者。

RNNとは?

RNNは**Recurrent Neural Network(リカレントニューラルネットワーク)**の略で、過去の情報を利用して現在及び、将来の入力に対する性能を向上させることができるニューラルネットワークの一種です。

RNNは文章などの連続的な情報を解析、利用することができることから注目を集めていました。

それまでのニューラルネットワークは、文章や天候などの連続的な情報を利用するという考え方がありませんでした。それは、入力されたデータは互いに独立しており、影響していないと考えるのが一般的だったためです。

しかし、データが互いに独立していると考えてしまうと文章などの単語の関係が連続しているものや文脈があるものに対してはまったく学習することができなくなってしまいます。

というのも、文章の中で次の言葉を予測する必要がある場合、前の言葉が何だったかを記憶して処理することができなければ予測を立てるのが難しくなってしまいますよね?

例えば、人間でいうと

「今日は風が強いので洗濯物を乾かすときには気をつけないといけないなあ。午後からは風が強い上に雨も降りそうなのでお出かけするときには傘が必要です。」

という文章があったときに

前の言葉が分からなかった場合、風が強いのでという単語がわからないまま洗濯物を乾かすという文脈は分かりづらいと思います。

そこで、RNNは「前に計算された情報を覚える記憶力」を保持しているということです。

RNNは前後の言葉に影響されることなく、言葉をある程度覚えながら作業を行うことができます。

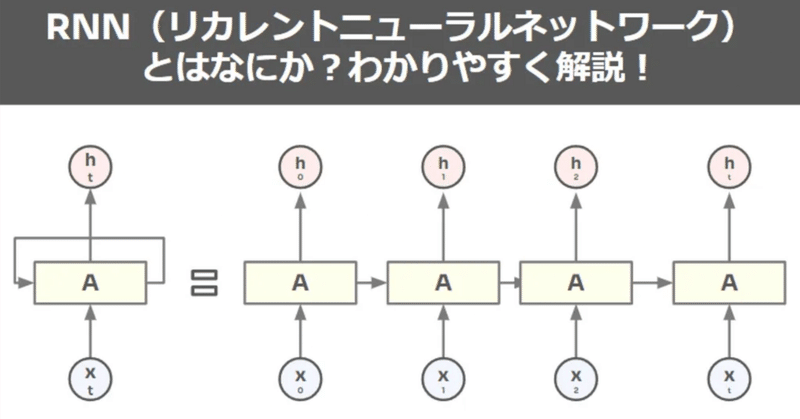

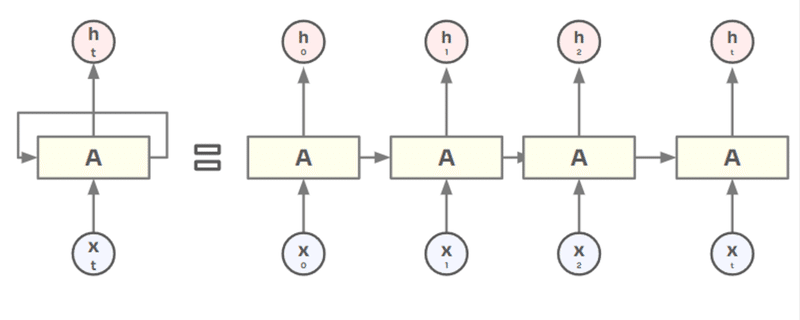

具体的なRNN仕組みについて

ディープラーニングで用いられる深層ニューラルネットワークは、入力層から入力された情報を、中間層1,2,3,というように多くの層に順番に入れて言ってデータが層を伝搬していきますよね。

この処理の途中に中間層1のデータをまた中間層2に入れる、中間層2のデータを中間層3に入れるというように再帰(Recurrent)することは無いです。

DNNは順番にデータを処理していく一方でRNNは再帰的に演算していきます。

具体的には、「入力層」「1層の中間層」「出力層」の3層だけでRNNは成り立っています。

これは中間層で処理された情報を再度自分の中間層に入れ直します。自分自身の中間層に演算結果をまた代入し、再演算するのです。

そして、これを繰り返し続けていくことによって同じ中間層が何度も使用されることになります。

これが続いていくと複数の中間層から成り立つニューラルネットワークに見えるということです。

RNNの由来でもあるReccurentは自分自身に再帰的に演算結果を演算し続けることからRNNと呼ばれているのです。

RNNの欠点について

RNN(Recurrent Neural Networks)は時系列データやシーケンシャルデータの処理に有効ですが、いくつかの欠点もあります。以下に主な欠点を箇条書きで挙げ、それぞれについて説明します。

RNNの欠点

勾配消失問題 (Vanishing Gradient Problem)

長期依存性の問題 (Long-Term Dependencies Problem)

計算効率の問題

並列処理の困難

勾配消失問題 (Vanishing Gradient Problem)

RNNは時系列データを扱う際に、過去の情報を時点を遡って伝播させますが、この過程で勾配が急速に小さくなり、ほとんどゼロに近くなることがあります。このため、ネットワークが深い場合、初期の層に影響を与えるべき重要な情報が失われ、学習がうまく進まなくなります。

RNNは層を重ねて時系列データや自然言語処理の文脈の意図を把握していく構造のため、多層になっていく問題があります。多層になること自体が問題というよりかは、パラメータを最適化していく過程で重みの更新をしていくと、勾配がゼロに近づいてしまい、更新幅が小さくなってしまうことで最適解にたどり着かなくなってしまいます。

この勾配消失問題のせいで時系列データの長期記憶を保持しづらい状態になってしまいます。

長期依存性の問題 (Long-Term Dependencies Problem)

RNNは理論上は長期的な依存関係を学習する能力を持っていますが、実際には勾配消失問題や勾配爆発問題により、長いシーケンスの初期の部分とその影響を受けるべき後の部分との間の学習が困難になります。これは特に、シーケンスの長さが非常に長い場合に顕著になります。

計算効率の問題

RNNは過去の情報を順番に処理するため、新しい情報を処理する前に前のステップが完了している必要があります。これは、特に長いシーケンスを扱う場合に計算効率を低下させ、学習時間が非常に長くなる原因となります。

並列処理の困難

RNNのシーケンシャルな特性は、現代の多くのディープラーニングアーキテクチャが享受しているGPUによる並列処理のメリットを十分に活かすことができません。各時点の計算が前の時点の結果に依存しているため、バッチ処理中にデータポイント間で計算を効率的に分散することが困難です。

上記の問題を解決するために現れた方法がLSTMという「Long Short Term Memory(長・短期記憶)」ニューラルネットワークです。

こちらについてはまた別の記事で解説します。

まとめ

この記事では、RNN(Recurrent Neural Network)に焦点を当て、その定義、動作原理、および特定の欠点を詳細に説明しています。RNNは過去のデータを利用して現在及び将来の予測を改善する能力を持つニューラルネットワークの一種であり、特に連続的なデータやシーケンスデータの処理に適しています。しかし、勾配消失問題などの欠点も持ち合わせています。この記事を通じて、RNNの基本的な理解と、それが直面するいくつかの課題についての洞察を得ることができます。

まとめ箇条書き

RNNは過去の情報を活用して現在および将来のデータの処理を改善するニューラルネットワークです。

連続的なデータやシーケンスデータの処理に適しており、言語処理などに利用されます。

RNNは自己参照を通じて情報を継続的に処理することができますが、

勾配消失問題などの欠点も存在し、長期依存性の捉え方に制限があります。

この記事が気に入ったらサポートをしてみませんか?