#422 テクノロジーネタ~Command R+はトークナイザーもすごかった

おはようございます!本日もよろしくお願いします。ちょっと前から花粉症の疑いを持っていたんですけど、ようやくここにきて原因が分かってきたような気がします。私、黄砂に対するアレルギーを持っているような気がします。昨日から急に鼻水が出始めて、結構、苦しくなったんですけど、それまでは全く大丈夫だったんですよね。昨日から黄砂が飛んでいるということを聞いてピンと来ました。たぶん間違いないですね。薬を飲むと症状が緩和されるので、今後は天気予報を見ながら、薬を飲むタイミングを見極めていこうと思います。さてさて本日は「テクノロジーネタ~Command R+はトークナイザーもすごかった」です。

Command R+のヒミツ

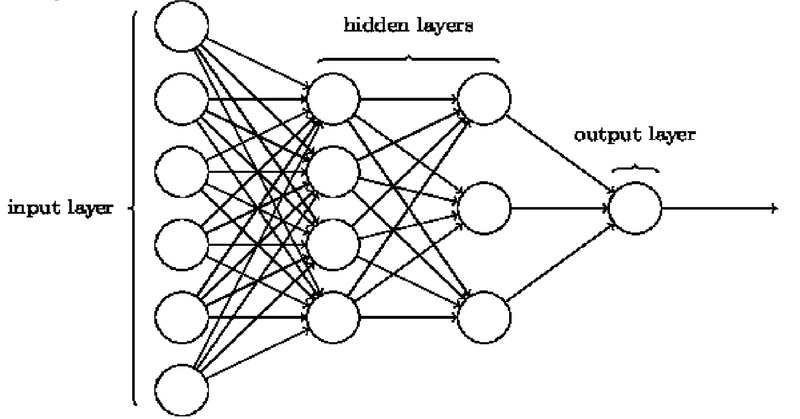

本日もテクノロジー関連のネタです。オープンソースで一番、良さそうなLLMがCommand R+です。ちょっと使い方がネットに出てきたら触ってみようかなと思いました。以下、記事からの抜粋です。最近Command R+が界隈を賑わせています。その賑わいの中でも「Command R+の日本語の応答速度が速い。」という声を良く聞きます。そこで今回はCommand R+の日本語の応答速度が本当に速いのか、なぜ速いのかについてトークナイザー観点で述べたいと思います。まず前提として、入力あたりのトークン数が少なければ少ないほど応答時間が短くなります。よってトークナイザーは応答速度に大いに関係します。日本語における必要なトークン数(Tokens Required)はOpenAIのトークナイザーの約6割(1/1.67)であることがわかります。これよりトークナイザーの観点からOpenAIのモデルよりもCommand R+は高速なことがわかります。

もしかするとGPT-4日本語カスタムモデルでも・・・

なるほど、確かにGPTって日本語のトークン数がやたら多くなるなと思っていたんですけど、そのあたりを工夫すると確かに処理する情報がそもそも減るので、間違いなく計算は速くなるでしょうね。日本語LLMもこの辺が工夫ポイントだったんだなと改めて気がつきました。となると気になるのは、最近、記事にした日本語カスタムモデルのGPT-4って、この辺はどうなるんでしょうね。もしかするとトークン化をいじっているのかもしれないなと思いました。いずれにしてもCommand R+はオープンソースなので、一回、いじってみたいなと思いました。

まとめ

いかがでしたでしょうか?オープンソースでもこれだけの精度を出せるようになってきたんだと思って感動しました。3ヵ月前にオープンソースLLMとGPT-3.5の比較をやったことがあるんですけど、圧倒的にGPT-3.5が良かったんですよね。それと比較するとずいぶん進歩したなと思いました。そろそろオープンソースでも出来ることがたくさんありそうだなと思ってきたので、一回、再挑戦してみようかなと思います。日本語にも強そうなので、意外といいんじゃないかなと思いました。ではでは、また!

この記事が気に入ったらサポートをしてみませんか?