LLM の仕組みを押さえればさらに生成 AI を活用できる

こんにちは、Google が開発・提供している AI「Gemini(ジェミニ)」の公式 note 編集部です。

今の生成 AI を支えているのが、大規模言語モデル(Large Language Models=LLM)という仕組みです。もちろん LLM のことを知らなくても、問題なく Gemini を使えます。それでも少し仕組みを知っておくことで、さらに Gemini を使いこなせるようになります。LLM の仕組み、そしてマルチモーダルについて簡単に説明します。

生成 AI って何?

生成 AI は、新しいコンテンツの生成を目的にした AI です。

現在の AI を構築する上での基礎となっているのが、機械学習と呼ばれる技術です。機械学習とは、明示的にコンピュータに指示をしなくても、コンピュータが入力されたデータを学習し、規則性を発見し、そこから予測や判断をする技術のことです。

さらに、機械学習にもさまざまな手法があり、そのひとつにディープラーニング(深層学習)という手法があります。ディープラーニングとは、人間の神経細胞のようなニューラルネットワークを使用する機械学習の一種であり、より複雑なパターンを処理することができます。

生成 AI を支える、大規模言語モデルのはじまり「Transformer」

今の生成 AI を支えているのが、LLM という機械学習モデルです。そして LLM は 2017 年、Google の研究者だった 8 名が「Transformer」という新しいディープラーニングのモデルを提唱したことに始まります。

Transformer は単語と単語の関係(もしくは単語同士の距離感)にだけ注目します。

この技術のおかげで、翻訳や文章生成などのタスクが高いレベルでこなせるようになりました。例えば Google 翻訳でも Transformer を採用しています。さらに、2018 年には Google が「BERT(Bidirectional Encoder Representations from Transformers)」という言語モデルを発表しました。これも Transformer 技術を採用し、自然言語理解の性能はとても高いものでした。

ここから、世界中で AI 研究が加速していくことになります。2023 年、Google の生成 AI「Bard」がリリースされました。さらに 2024 年には「Bard」の名称は「Gemini」と変更され、現在に至ります。

言語モデルが行なっていることは「文脈を踏まえて文の続きを予測」すること

入力されたプロンプトに対して出力を返す際、LLM は単純化すると、文脈を踏まえて文の続きを予測しています。例えば「犬も歩けば」の後に続く言葉の中で、「棒に当たる」という言葉が来る確率が高いだろう、と予測しているのです。

このように文の続きを予測することは、文脈を理解していないとできません。その文脈を言語モデルが理解するために、文章全体の中の注目するポイントを示すのがアテンションという技術です。

LLM の仕組みを踏まえると、生成 AI の特徴がより理解できる

「計算問題」のように見えるタスクに対しても、行っていることは同じです。「1+1=」の後に続く言葉の中で、「2」という言葉が来る確率が高いだろう、と予測しているのであって、裏側で電卓を叩いて四則演算を行っているわけではありません。

そのため、1 桁や 2 桁の計算であれば、学習データも少なくなく、正しい答えに行きつく確率も高くなりそうですが、3 桁、4 桁…と増えていくに従って、出力のクオリティは下がるだろうといわれています。実際はこの点も進化していて、それには、後から登場するロング コンテキスト ウィンドウも大きく影響してきます。

こうした LLM の仕組みを踏まえることで、生成 AI が得意なこと、不得意だとされていること、なぜできないのかなど、その特徴を深く知ることできます。

例えば、「ハルシネーション(幻覚)」という言葉が話題になることもあります。生成 AI が間違った内容を出力してしまう現象のことです。ここで言語モデルが行っていることを思い出すと、「犬も歩けば」の後に続く言葉の中で、「棒に当たる」という言葉が来る確率が高いだろう、と予測しているだけでした。つまり、ファクトとなる情報を検索して言葉を生成しているわけではないのです。生成 AI の出力結果はあくまで「確率の高い言葉の組み合わせ」だということを知っておくと、なぜ一定の確率で誤った答えが出る(ハルシネーションが起こる)のかが理解しやすいのではないでしょうか。そのため、生成 AI には厳密な回答を求めない業務が向いています。

こうした生成 AI の仕組み上、ハルシネーションを避けて通ることはできませんが、抑えるための研究も進んでおり、正確性はどんどん高まっています。

より長い文脈を踏まえて「文の続きを予測」できることで、より進化していく

タスクを生成 AI に指示する際、コンテキスト ウィンドウが出力のクオリティに影響を与えます。

コンテキスト ウィンドウとは、単純化して言えば、人の短期記憶のようなものです。テキストを区切る「トークン」という単位で表現します。もしコンテキスト ウィンドウが小さいと、最初の方で話していた内容をそのうちに忘れ、回答が重複したり、見当違いの回答をしてくるようになったりしてしまうのです。

例えば、10 万トークンであれば単行本 1 冊くらいの記憶力があります。書籍データを読み込ませて要約したり、内容に関して質問したりできます。会議の音声データをテキスト化すると何万文字にもなりますが、それもパッと読み込ませて議事録を作成してもらうことができます。

さらに 2024 年に Google が発表した「Gemini 1.5 Pro」は、100 万トークンというロング コンテキスト ウィンドウを備えており、2024 年 5 月に、API を使用する開発者および Google Cloud ユーザー向けには、ウェイティング リスト順に 200 万トークンまで拡張しました。

10 万トークンであれば単行本 1 冊の内容を覚えておくことが可能でした。 100 万トークンになることで、単行本なら 10 冊分の情報を扱うことができます。これは、たくさんの情報を知って、より長い文脈を踏まえたうえで、「次の言葉の確率」を予測できるということです。コンテキスト ウィンドウの大きさが歓迎されること、大きくなればなるほど生成 AI の回答のクオリティが上がるのにはこうした理由があります。

テキストから画像、音声、動画、そしてマルチモーダルへ

主にテキストを扱っていた LLM の技術は進化し、画像や音声、そして動画まで扱えるようになりました。

さまざまな形式のデータ(モダリティと呼びます)に対応することで、より多彩なタスクを処理できます。このようにさまざまなモダリティの組み合わせに対応できる生成 AI のことを、マルチモーダル モデルと呼びます。Google の Gemini もそのひとつです。

マルチモーダル モデルのユースケースはテキストのみのときと比べ、大きく広がります。

画像や動画、テキストなどを一緒に処理できるので、クッキーの皿の写真と共に「このクッキーのレシピを教えてください」とプロンプトを入力して、レシピを出力させるようなことが可能になるのです。

ほかにも、音声ファイルを入力し、テキストに変換したり、要約したり、改善点を指摘してもらったりできます。動画を入力し、何が映っているのか分析したり、タイムスタンプ付きのチャプターを作成してもらったりできます。

マルチモーダル モデルを使いこなす!

Google Cloud で、マルチモーダルのプロンプトを設計するコツをご紹介しています。

単一画像のプロンプトではまず画像を配置する

指示を具体的にする

小さいステップに分ける

プロンプトにいくつかの例を加える

出力形式を指定する

一見するとテキストを生成するテクニックと似ていますが、マルチモーダルだからこそ気をつけるポイントもあります。まず「単一画像のプロンプトではまず画像を配置する」というテクニックの例を見てみましょう。

Gemini モデルは、画像とテキストをどのような順番でも処理できますが、画像をテキストのプロンプトよりも前に配置することでパフォーマンスが向上する可能性があります。

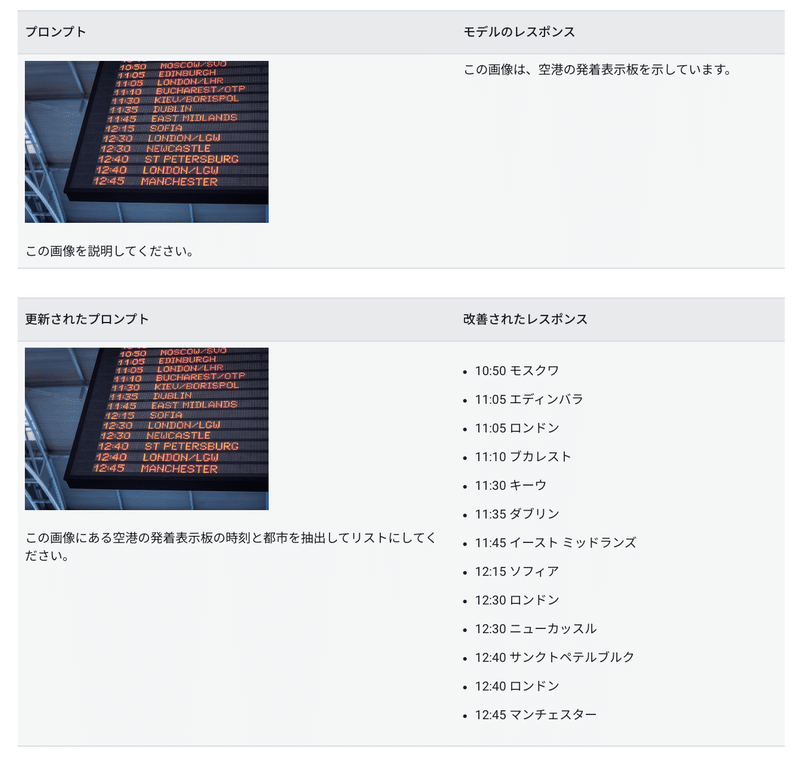

もうひとつ、「指示を具体的にする」というテクニックでは空港の発着表示板の画像を例にすると、画像のどの部分から情報を引き出してほしいか、画像からどんな情報を教えてほしいか、画像と紐づけて入力する必要があります。「この画像を説明してください」と入力すると、「この画像は、空港の発着表示板を示しています」と返ってきてしまいます。これを、時刻と都市が抽出されるようにするためには、「この画像にある空港の発着表示板の時刻と都市を抽出してリストにしてください」と入力する必要があるのです。

Google の取り組む生成 AI

生成 AI だけでなく、そもそも AI 全般に対するアプローチは、大胆でありつつも責任あるものでなければならないと、Google は考えています。

そこで 2018 年、すべての人にとって世界をより良いものにするために AI の原則を策定しました。その原点は AI をすべての人にとって役立つものにする、というビジョンです。

今では実際に、Google 検索や Google マップ、Google フォトなど日常的に使用されるさまざまなサービスで AI が使われています。また現在、150 万人以上の開発者が Google のツールを通して、AI を使っています。

さらに、AI は次のような社会課題にも役立つことができるものです。

●気候変動を抑制する取り組みを支援する(車両の二酸化炭素排出量を抑えるために交通渋滞を減らすなど)

●自然災害を予測、監視する(20 か国以上で洪水を予測する、山火事の範囲をリアルタイムで追跡するなど)

●医療に関するイノベーションをサポートする(結核検査を利用しやすくする、乳がんの早期発見を支援するなど)

生成 AI 領域は日々進化していて、どんどん役に立つ存在になっています。そして Google の高性能な AI モデル Gemini を誰でも無料で利用できるよう、チャット UI の Gemini(gemini.google.com)を用意しています。こうした生成 AI の仕組みや、AI に対する Google の取り組みを思い出しながら、ぜひ Gemini を使ってみてください!

また、note でも今後も、Gemini の使い方のアイデア、コツ、ユースケースなどたくさん紹介していきます。そこからみなさんそれぞれの、より効果的な活用法が見つかったらうれしいです。