十年経っても愛されるタートルトーク! "心が動く"対話の仕組みを紐解く(前編)

皆さん、東京ディズニーシーの人気アトラクション「タートル・トーク」はご存じですか?

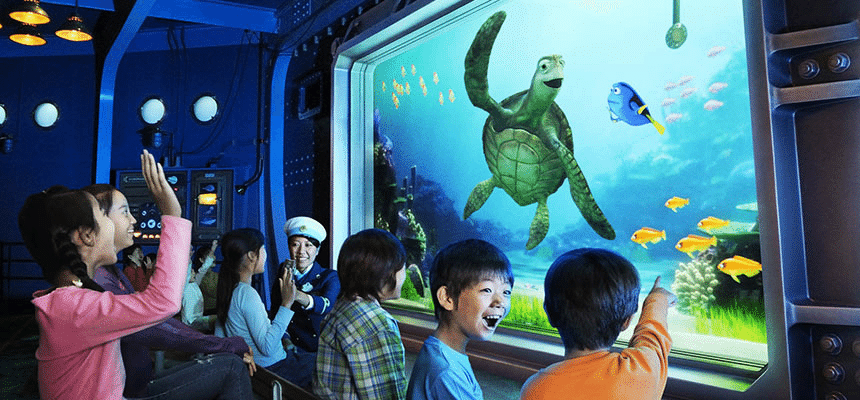

「タートル・トーク」は、2013年に東京ディズニーシーにできたアトラクションで、来場者がスクリーンに映し出されたウミガメのクラッシュとお話ができます。なぜ今頃と思うかもしれませんが、なんと今タートル・トークがSNS上で話題なんです。

昨今はChatGPTを始めとした大規模言語モデルの登場により、キャラクタの対話自動生成に関する取り組みが急激に増えてきていますが、そのいずれも人の心を動かすような対話までは実現できていません。どうしたら人の心を動かす対話が実現できるのでしょうか。

そこで、十年経っても愛され続けるキャラクタの対話型アトラクションであるタートル・トークからそのヒントを探ってみようと思います。本記事ではまず前編でタートル・トークを支える技術について理解を深めます。後編ではタートル・トークを支える設計と共に、人の心を動かす対話には何が必要なのかを考えていこうと思います。

タートル・トークを支える技術

タートル・トークの仕組みについては、ディズニー公式が正確な情報を公開していないため、極力信頼できるソースに基づいて推測していきます。

1. 声について。

大前提として、タートル・トークに出演するウミガメのクラッシュは実在する役者さんが演じています。元クラッシュ役の声優さんによると、声優さんがクラッシュの声マネをしながら観客と話しているそうで、ボイスチェンジャーは使用されていないそうです。

余談) 元クラッシュ役の声優は、声マネと受け答えのオーディションの後、半年の研修期間を経てデビュー。一日三、四人の声優が交代でクラッシュを演じ、時間帯によって声が変わることもある模様。冷たい態度をとるクラッシュ(声優)もおり、SNS上では#ハズレクラッシュのタグがつくことも。アドリブ力が必要なお仕事ですが(芸人さんではなく)声優さんが多いようです。

2. 映像の表情や口の動き、目線について。

クラッシュの表情や口の動きは、リアルタイムCGを活用しており、口の動きはリップシンク技術で声と同期しています。また、表情は別途ボタンで制御されており、フェイシャルトラッキングは使用されていないとのこと。キャラクタが話し相手と目を見て話す仕組みは、声優さんが設置されたカメラ映像を別室でモニタリングし、その方向をキャラクタに正確に反映させている結果だと思われます。

モニタリングの仕組みに関しては、DigitalEmotionsという会社が近しい技術を開発しており(図1)、ディズニーに技術提供をしている可能性が高いです。キャラクタの視線制御はゲームでもよく用いられており、実画像でも適用できるよう調整作業(キャリブレーション)を徹底しているように思います。

3. 体の動きについて。

人とウミガメの体の構造の大きな違いから、人の動きを亀の動きに反映するのは困難です。そこで、アニメーターが作成したウミガメの動作をボタンで選ぶMotion Retrievalが採用されています。この手法は一貫して高品質な動きを実現するために広く利用されており、この体験では多様な動作から瞬時に適切な動作を選ぶためのタブレットアプリが存在するようです(図2)。

Motion Retriebalとは) 一つ一つの短い動作のデータベースからその場に応じた動作を逐次を選んでくる手法です。前に選んだ動作とのつなぎ目前後の骨の回転を滑らかに補間することで、異なる動作を自然に繋げることができます。また、動作の始めと終わりが同じ姿勢になっているようなデータベースであれば、動作同士を補間なしで滑らかに繋ぐこともできます。

余談) アニメーション技術の観点から、観客との対話するキャラクタとして水中生物を選んだ点は非常に秀逸だったなと思います。というのも、二足歩行のキャラクタの場合、足が地面に設置している必要があり、リアルタイムでキャラクタの歩行に併せて正しく接地させることが難しいためです。水中のキャラクタであれば浮きながら移動ができるため、この接地問題を回避することができます。

>>> 次回の記事ではタートル・トークの演出について考察します。